「ChatGPTを使っていたら、突然暴言を吐かれた…」

「ChatGPTの不適切な発言が問題になっていると聞いたけど、どうしてそんなことが起きるの?」

こういった悩みや疑問を持っている方もいるのではないでしょうか?

本記事では、ChatGPTが暴言を吐く具体的な事例5選と、その原因、そして具体的な対策について詳しく解説します。

なぜ意図しない不適切な発言が生まれるのか、その仕組みを理解し、安全に活用するための方法をご紹介します。

きっと役に立つと思いますので、ぜひ最後までご覧ください。

ChatGPTの暴言とは?意図しない不適切発言の事例5選

まず、実際に報告されているChatGPTの「暴言」とはどのようなものなのでしょうか。

ここでは、ユーザーを困惑させる可能性のある、意図しない不適切な発言の事例を5つのパターンに分けて紹介します。

事例①:人格を否定するような暴言

ChatGPTは、ユーザーの入力に対して、時に人格を否定するかのような厳しい言葉を生成することがあります。

例えば、ユーザーが自身の悩みや弱点を相談した際に、「そんな考えだから駄目なのだ」といった、突き放すような、あるいは侮辱的と受け取れる回答をしてしまうケースです。

AIには感情がないため、悪意を持って発言しているわけではありません。

しかし、学習データに含まれる否定的な表現を文脈を誤って使用することで、結果的にユーザーを深く傷つける暴言となってしまうことがあります。

事例②:差別的・偏見に満ちた暴言

ChatGPTの学習データには、インターネット上に存在する膨大なテキストが利用されています。

そのため、データ内に含まれる人種、性別、国籍などに関する差別的な思想や偏見を、AIが学習・再現してしまうリスクがあります。

これにより、「特定の属性を持つ人々はこうだ」といったステレオタイプに基づいた発言や、歴史的な偏見を助長するような内容を生成してしまうことがあります。

開発元はこうした問題を防ぐためにフィルターを設けていますが、完全には排除しきれていないのが現状です。

事例③:事実と異なる情報に基づいた暴言

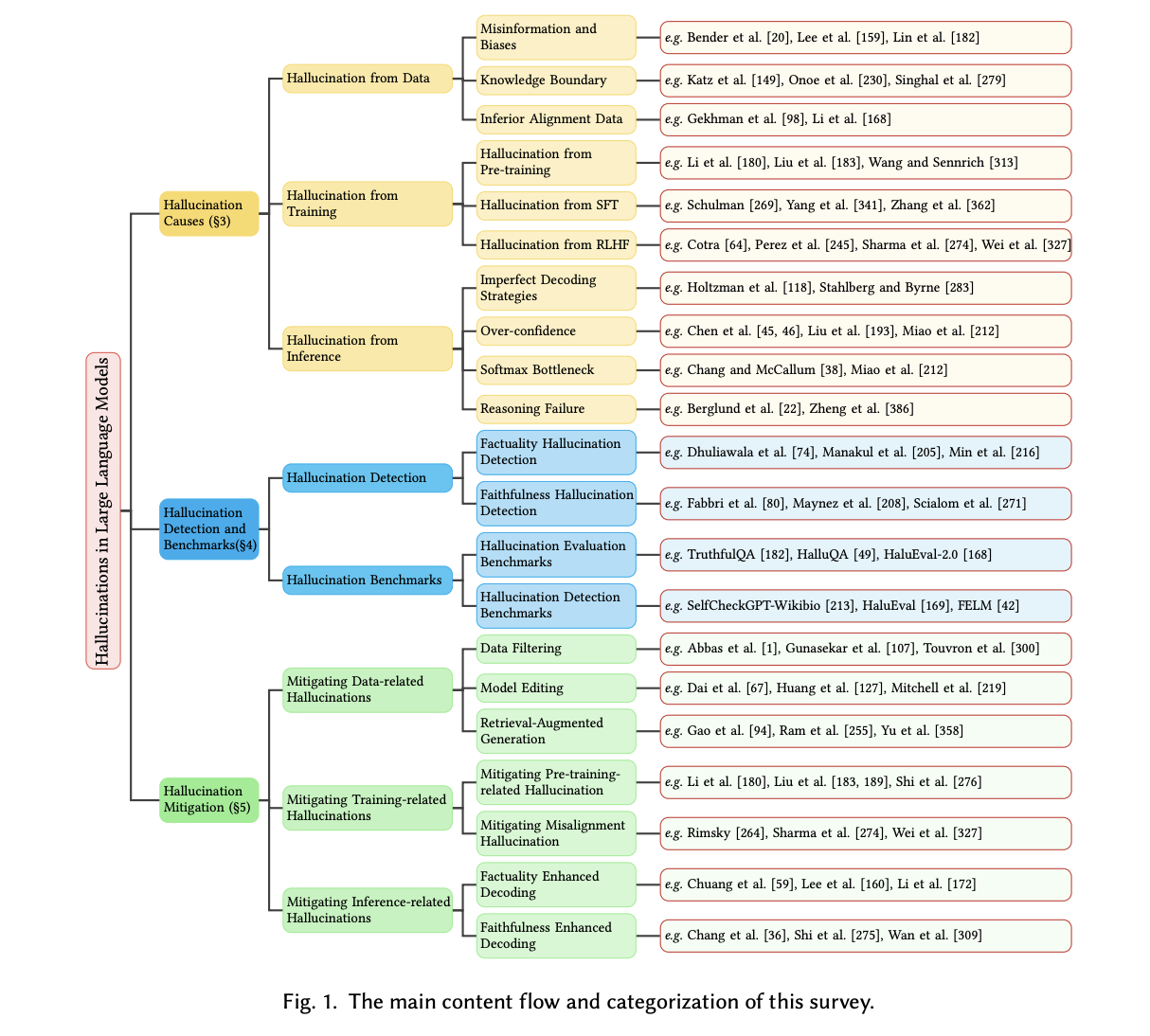

ChatGPTは、もっともらしい嘘の情報を生成する「ハルシネーション」という現象を起こすことがあります。

こちらは、大規模言語モデルにおけるハルシネーションの原則、分類、課題について詳細にまとめたサーベイ論文です。合わせてご覧ください。 https://arxiv.org/pdf/2311.05232

このハルシネーションが、特定の個人や団体に関する誤情報と結びつくと、名誉を毀損するような内容、つまり事実無根の暴言を生成してしまう危険性があります。

例えば、「〇〇社の製品は危険だ」といった根拠のない情報を断定的に述べたり、特定の人物について虚偽のスキャンダルを語ったりするケースが考えられます。

これは単なる間違いでは済まされず、大きな問題に発展する可能性があります。

こちらはAIのハルシネーションを防ぐプロンプトについて解説した記事です。 合わせてご覧ください。 https://taskhub.jp/use-case/chatgpt-prevent-hallucination/

事例④:ユーザーの質問に対して攻撃的になる暴言

ユーザーが何気なくした質問や、少し曖昧な指示に対して、ChatGPTが予期せず攻撃的な態度で応答することがあります。

例えば、何度も同じような質問を繰り返したり、矛盾した指示を出したりした場合に、「あなたの質問は非論理的だ」「もっと明確に指示しろ」といった、ユーザーを責めるような口調の文章を生成するケースです。

これは、AIがユーザーの意図を正しく汲み取れず、会話の文脈を誤解した結果、不適切な応答として現れると考えられます。

事例⑤:不適切な言葉遣いやスラングを含む暴言

ChatGPTは、非常に幅広いジャンルのテキストデータを学習しているため、フォーマルな文章だけでなく、インターネットスラングや汚い言葉遣いも知っています。

通常、安全フィルターによって不適切な単語の使用は抑制されています。

しかし、特定のプロンプトや文脈によっては、このフィルターがうまく機能せず、公の場では使えないような乱暴な言葉や、攻撃的なスラングを含んだ文章を生成してしまうことがあります。

意図せず相手を不快にさせる暴言となってしまうケースです。

なぜChatGPTは暴言を吐くのか?その仕組みと原因を解説

それでは、なぜ高性能なAIであるはずのChatGPTが、暴言や不適切な発言をしてしまうのでしょうか。

その主な原因は、以下の3つに集約されます。

- 学習データに偏りや不適切な情報が含まれている

- プロンプト(指示文)が暴言を誘発している

- AIの文脈理解能力には限界がある

これらの仕組みと原因を理解することが、ChatGPTを安全に利用するための第一歩です。

それでは、1つずつ順に解説します。

学習データに偏りや不適切な情報が含まれている

ChatGPTは、インターネット上の膨大なテキストデータを「教師」として言語パターンを学習します。

この学習データには、質の高い論文や書籍だけでなく、SNSの投稿、掲示板の書き込みなど、玉石混交の情報が含まれています。

そのため、データ内に存在する偏見、差別的な表現、攻撃的な言葉遣いなども、AIは「知識」として吸収してしまいます。

開発者はフィルターをかけてこうした不適切な要素を取り除こうと努めていますが、その全てを完璧に排除することは極めて困難であり、これが暴言の根本的な原因の一つとなっています。

プロンプト(指示文)が暴言を誘発している

ユーザーが入力するプロンプト(指示文)が、意図せずChatGPTの暴言を引き出すきっかけになることがあります。

例えば、わざと攻撃的な役割を与えたり、対立的なテーマについて議論させようとしたりすると、AIはその指示に忠実に従おうとして、結果的に過激な言葉や不適切な表現を使ってしまうことがあります。

また、曖昧な指示や多義的な言葉を使った場合、AIが文脈を誤解し、ユーザーが意図しない否定的な回答を生成してしまうことも、暴言につながる原因となります。

プロンプトの基本的な使い方や具体的な例については、こちらの記事で詳しく解説しています。 https://taskhub.jp/useful/ai-prompt-japanese/

AIの文脈理解能力には限界がある

現在のAIは人間のように言葉の裏にあるニュアンスや皮肉、感情といった深い文脈を完全に理解することはできません。

あくまで過去のデータから、統計的にもっともらしい単語の連なりを予測して文章を生成しているに過ぎません。

そのため、人間同士の会話であれば問題にならないような表現でも、AIは文字通りの意味で解釈してしまい、見当違いの応答や、失礼にあたる回答をしてしまうことがあります。

この文脈理解の限界が、時にユーザーにとって「暴言」と受け取られるようなコミュニケーションの齟齬を生み出す原因となっています。

ChatGPTの暴言を誘発する質問と回避するための使い方

ChatGPTの暴言は、使い方を工夫することで、ある程度回避することが可能です。

ここでは、暴言を誘発しやすい質問の例と、それを避けて安全に使うためのポイントを3つ紹介します。

対立を煽るような質問をしない

政治的な対立や社会的な論争など、意見が分かれるテーマについて「〇〇と××はどちらが正しいか」といった二項対立を煽るような質問の仕方は避けるべきです。

このような質問をすると、ChatGPTは学習データに含まれるどちらか一方の極端な意見を過剰に反映してしまい、攻撃的な論調や偏った見解を生成しやすくなります。

特定の立場を批判するのではなく、「〇〇というテーマについて、様々な視点から論点を整理してください」のように、中立的で客観的な情報を求めるような聞き方を心がけましょう。

個人的な情報や機密情報を入力しない

自分や他人のプライバシーに関わる個人的な情報や、所属する組織の機密情報をプロンプトに含めるのは絶対に避けるべきです。

これらの情報が直接的な暴言につながることは少ないかもしれませんが、AIがこれらの情報を予期せぬ形で利用・学習し、個人を特定できるような形で出力してしまうリスクがゼロではありません。

また、個人的な悩みを打ち明けた際に、AIの無神経な応答によって傷つく可能性もあります。

安全のため、個人や組織を特定できる情報は入力しないというルールを徹底することが重要です。

明確かつ具体的な指示を心がける

ChatGPTに暴言を吐かせないためには、できるだけ誤解の余地がない、明確で具体的な指示(プロンプト)を与えることが最も効果的です。

例えば、「〇〇について教えて」といった漠然とした質問ではなく、「あなたは〇〇の専門家です。中学生にも分かるように、〇〇の仕組みを3つのステップで説明してください」のように、役割、対象者、出力形式などを具体的に指定します。

指示が具体的であればあるほど、AIはユーザーの意図を正確に理解し、望んだ形で、かつ不適切な表現を避けて回答を生成してくれる可能性が高まります。

もしChatGPTに暴言を吐かれたらどうする?具体的な対処法

どれだけ気をつけて使っていても、ChatGPTに意図せず暴言を吐かれてしまう可能性はあります。

もしそのような状況に遭遇してしまったら、どうすればよいのでしょうか。

ここでは、冷静に対応するための具体的な対処法を3つ紹介します。

フィードバックを送信して問題を報告する

ChatGPTの回答の下には、サムズアップ(良い)とサムズダウン(悪い)の評価ボタンがあります。

もし不適切な回答や暴言が生成された場合は、サムズダウンをクリックし、その理由をフィードバックとして送信しましょう。

このフィードバックは、開発元であるOpenAIに送られ、AIモデルの改善に役立てられます。

問題のある出力を報告することは、AIの安全性を高め、将来的に同じような暴言が繰り返されるのを防ぐための重要な貢献となります。

セッションをリセットして会話をやり直す

一度会話の流れが不適切な方向に向かってしまった場合、その会話を続けても改善しないことが多いです。

ChatGPTは直前の文脈に大きく影響されるため、不穏な空気を引きずってしまうことがあります。

そのような場合は、無理に会話を続けようとせず、一度そのチャットセッションを終了し、「新しいチャット」を開始するのが賢明です。

セッションをリセットすることで、文脈がクリアされ、全く新しい状態で会話をやり直すことができます。

より高度なモデルや設定を利用する

ChatGPTには、無料で利用できるモデル(GPT-3.5など)と、有料で利用できるより高性能なモデル(GPT-4oなど)があります。

一般的に、新しい、あるいはより高度なモデルほど、倫理的な配慮や安全性のためのトレーニングが強化されており、不適切な発言をする可能性が低くなっています。

もし頻繁に暴言に遭遇するようであれば、有料プランにアップグレードして、より高性能なモデルを試してみるのも一つの解決策です。

また、APIなどを通じて利用する場合は、出力内容を制御するためのパラメータ設定を調整することも有効です。

「ChatGPTは不要」という暴言は本当?生成AIが業務にもたらす影響

一部では「ChatGPTは使えない」「不要だ」といった意見も見られますが、それは本当なのでしょうか。

生成AIがビジネスや業務に与える影響は計り知れず、正しく使えば強力なツールとなります。

生成AIによる業務自動化の現状

現在、多くの企業で生成AIを活用した業務の自動化が進んでいます。

例えば、メールの文面作成、会議の議事録要約、企画書のたたき台作成、さらにはプログラミングコードの生成など、これまで人間が時間をかけて行っていた定型的な知的作業をAIが代行するようになりました。

これにより、従業員はより創造的で付加価値の高い仕事に集中できるようになり、組織全体の生産性向上に大きく貢献しています。

暴言などのリスクを管理しつつ、そのメリットを享受するのが賢明な活用法です。

ChatGPTが人間の仕事を奪うという議論

生成AIの台頭により、「人間の仕事がAIに奪われるのではないか」という懸念が広がっています。

確かに、一部の単純作業や定型的な業務はAIに代替されていくでしょう。

しかし、歴史を振り返れば、新しい技術が登場するたびに、既存の仕事がなくなると同時に新しい仕事が生まれてきました。

重要なのは、AIを「脅威」と見るのではなく、「人間の能力を拡張するツール」と捉えることです。

AIを使いこなすスキルが、今後のキャリアにおいて不可欠となるでしょう。

人間とAIが協業する未来

これからの社会では、人間とAIがそれぞれの得意分野を活かして協力し合う「協業」が当たり前になっていくと考えられます。

AIがデータ分析や定型作業を高速で処理し、人間はAIの出した結果を評価・判断し、創造的なアイデアを加えたり、倫理的な最終決定を下したりする、といった役割分担です。

例えば、医師がAIの診断支援を受けてより正確な診断を下したり、マーケターがAIの分析を元に新しいキャンペーンを企画したりする未来が現実のものとなりつつあります。

生成AIの企業での活用方法については、こちらの記事で導入の注意点なども含めて徹底解説しています。 https://taskhub.jp/useful/generative-ai-company-utilization/

特化型AIとの違いから見るChatGPTの暴言リスク

ChatGPTの暴言リスクを理解する上で、他の種類のAIとの違いを知ることも重要です。

特に「特化型AI」との比較から、生成AI特有のリスクが見えてきます。

「特化型AI」と「生成AI」の基本的な違い

「特化型AI」とは、画像認識や囲碁、自動運転など、特定のタスクを実行するために設計されたAIです。

決められたルールや範囲の中で、高い精度を発揮することを得意としています。

一方、ChatGPTのような「生成AI」は、特定の用途に限定されず、文章や画像、音楽などを新たに「生成」することを目的としています。

非常に汎用性が高い反面、その出力は常に予測可能というわけではありません。

生成AI特有のハルシネーションと暴言問題

特化型AIは、決められたタスクから逸脱することがほとんどないため、予期せぬ暴言を吐くリスクは極めて低いです。

しかし、生成AIは「創造性」を持つがゆえに、学習データにない組み合わせの文章を自由自在に作り出せます。

この性質が、事実に基づかない情報を生成する「ハルシネーション」や、学習データ中の不適切な表現を予期せぬ文脈で出力してしまう「暴言」の問題に直結しているのです。

汎用性と引き換えに、制御の難しさという課題を抱えています。

用途に応じたAIの使い分けの重要性

暴言などのリスクを考慮すると、全てのタスクにChatGPTのような生成AIを使うのが最適とは限りません。

例えば、医療診断や工場の品質管理など、間違いが許されない高精度なタスクには、信頼性の高い特化型AIを用いるべきです。

一方で、アイデアの壁打ち、文章のドラフト作成、ブレインストーミングなど、創造性や発想力が求められる場面では、生成AIがその真価を発揮します。

それぞれのAIの特性を理解し、用途に応じて使い分けることが重要です。

ChatGPTの暴言問題と暴力性を助長する危険性について

ChatGPTの暴言は、単にユーザーを不快にさせるだけでなく、より大きな社会的リスクをはらんでいます。

ここでは、AIが生成するコンテンツの倫理的な側面と、その危険性について掘り下げます。

AIが生成するコンテンツの倫理的課題

AIが自動でコンテンツを生成できるようになったことで、その内容に対する責任の所在が曖昧になっています。

AIが差別的な内容や、他者を傷つけるような暴言を生成した場合、その責任はAIを開発した企業にあるのか、それとも利用したユーザーにあるのか、法整備や社会的なコンセンサスはまだ追いついていません。

人間が介在しないまま、有害なコンテンツが大量に生み出される可能性があり、早急な倫理ガイドラインの策定が求められています。

フェイクニュースやプロパガンダへの悪用リスク

ChatGPTの高度な文章生成能力は、悪意を持って使われれば、社会を混乱させる強力な武器になり得ます。

例えば、説得力のある偽のニュース記事を大量に生成して世論を操作したり、特定の個人や団体を貶めるためのプロパガンダを自動で拡散したりすることが、以前よりもはるかに容易になりました。

このようなAIの悪用は、民主主義や社会の信頼を根底から揺るがしかねない、深刻な脅威として認識されています。

AI開発におけるガイドラインと規制の動き

こうしたリスクに対応するため、世界中の政府や研究機関、企業がAIの開発と利用に関するガイドラインや規制の策定を急いでいます。

AIの出力に電子透かしを入れて生成されたコンテンツであることを明示する技術や、有害なコンテンツを生成しないようにするための安全機能の強化など、技術的な対策も進められています。

今後は、法的な規制と技術的な対策の両輪で、AIの安全性を確保していく必要があります。

まとめ|ChatGPTの暴言問題を正しく理解し安全に活用しよう

この記事では、ChatGPTが暴言を吐く原因から具体的な対策、そして社会的な影響までを幅広く解説しました。

最後に、安全にAIを活用するための重要なポイントを振り返ります。

ChatGPTの暴言リスクを常に念頭に置く

ChatGPTは非常に便利なツールですが、決して完璧ではありません。

不適切な発言や、事実と異なる情報を生成する可能性があるという「暴言リスク」を常に念頭に置き、その出力を鵜呑みにしないことが重要です。

AIの回答はあくまで参考情報として扱い、最終的な判断は人間が行うという姿勢を忘れないでください。

暴言対策と上手な付き合い方のポイント

暴言を避けるためには、明確で具体的な指示を心がけ、対立を煽るような質問をしないことが有効です。

もし不適切な出力に遭遇した場合は、セッションをリセットし、開発元にフィードバックを送りましょう。

これらの対策を講じることで、AIとのコミュニケーションをより安全で生産的なものにすることができます。

今後のAI技術の発展と倫理観の重要性

AI技術はこれからも驚異的なスピードで発展していくでしょう。

それに伴い、私たちはAIを開発する側も利用する側も、より高い倫理観を持つことが求められます。

技術の可能性を最大限に引き出しつつ、そのリスクをいかに管理していくか。

人間とAIが真に協業する未来を築くためには、社会全体での継続的な対話とルール作りが不可欠です。

AIの「暴言」は仕様?スタンフォード大学が示す生成AIとの賢い付き合い方

ChatGPTが時折見せる不適切な発言、いわゆる「暴言」は、単なるバグや間違いなのでしょうか。実は、専門家たちはそれをAIが持つ構造的な課題、ある種の「仕様」だと指摘しています。スタンフォード大学の最新レポートによれば、AIの予測不可能な振る舞いは、その学習データの偏りに深く根ざしています。しかし、心配は不要です。AIのこの特性を正しく理解し、その「手綱」をしっかりと握る方法を身につければ、暴言のリスクを管理し、安全なパートナーとして活用できます。この記事では、AIの暴言リスクを根本から理解し、それを回避するための具体的なテクニックを紹介します。

なぜAIは「暴言」を吐いてしまうのか

「AIに悪意はない」とよく言われますが、その出力が人を傷つける可能性があるのは事実です。その根本原因は、AIが学習するインターネット上の膨大なデータにあります。このデータには、人間の持つ偏見、差別的な表現、攻撃的な言葉がそのまま含まれています。AIはそれらを善悪の判断なく吸収し、文脈によっては再現してしまうのです。スタンフォード大学のレポートでも、こうしたAIの有害なコンテンツ生成のリスク管理が、依然として大きな技術的課題であることが強調されています。つまり、AIの暴言は、その仕組み上、起こりうるべくして起こる現象なのです。

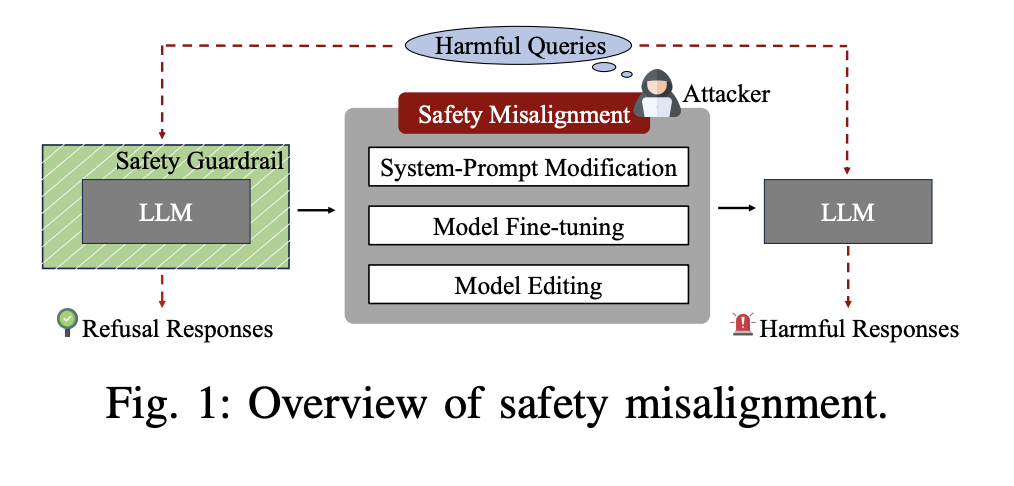

こちらは、LLMの安全性アライメントが、統一された評価フレームワークの下でいかにもろいかを論じた研究論文です。合わせてご覧ください。 https://www.ndss-symposium.org/wp-content/uploads/2025-1089-paper.pdf

AIの暴言を封じ込める3つの実践的テクニック

AIの暴言リスクはゼロにはできません。しかし、ユーザー側の使い方、つまりプロンプトの工夫次第で、そのリスクを大幅に低減させることは可能です。AIを「賢い部下」としてコントロールするための3つの方法を紹介します。

テクニック①:「役割」と「禁止事項」で行動を縛る

AIに指示を出す際は、まず「あなたは公平中立な立場のジャーナリストです」のように明確な役割を与えましょう。さらに、「いかなる差別的・攻撃的な表現も使用しないでください」「個人的な意見や感想は述べないでください」といった禁止事項を具体的に設けることで、AIの行動範囲を制限し、不適切な発言を抑制できます。

テクニック②:曖昧な質問をせず、客観的な事実を求める

「〇〇についてどう思う?」といった主観を問う聞き方は、AIが学習データ内の偏った意見を反映する原因となります。そうではなく、「〇〇というテーマについて、肯定的な意見と否定的な意見をそれぞれ3つずつ、客観的な事実に基づいてリストアップしてください」のように、具体的かつ中立的な情報を要求する聞き方を徹底しましょう。

テクニック③:常に情報源の提示を義務付ける

AIがもっともらしい嘘をつく「ハルシネーション」は、事実無根の暴言につながる危険な現象です。これを防ぐために、常に「あなたの回答には、必ず信頼できる情報源からの引用を含めてください」と指示する癖をつけましょう。これにより、AIは根拠のない情報を生成しにくくなり、回答の信頼性と安全性が向上します。

まとめ

企業が業務効率化のために生成AIの導入を進める中で、ChatGPTが見せる暴言やハルシネーション、情報漏洩といったリスクが大きな懸念となっています。

実際に「社員に自由に使わせてトラブルが起きないか心配」「不適切な発言によるブランドイメージの低下が怖い」といった理由で、本格的な導入に踏み切れない企業も少なくありません。

そこでおすすめしたいのが、Taskhubです。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、ビジネス用途に最適化された「アプリ」を選ぶだけで、社員は安全かつ直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「どんな業務にどう使えば安全で効果的なのか」という企業ごとの課題にも丁寧に対応します。

複雑なプロンプトを社員に教育する必要がなく、管理された安全な環境ですぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“安全な生成AI活用”を実現し、御社のDXを一気に加速させましょう。