「ChatGPTを業務で使ってみたいけど、情報漏洩などのセキュリティは大丈夫?」

「ChatGPTに潜むリスクと、安全に利用するための具体的な設定方法が知りたい。」

こういった悩みや疑問を持っている方も多いのではないでしょうか?

ChatGPTは非常に便利なツールですが、その裏には情報漏洩やサイバー攻撃への悪用といったセキュリティリスクも存在します。

本記事では、ChatGPTに潜む具体的なセキュリティリスク、実際に起きた事故事例、そして個人・法人それぞれが今すぐ実施すべきセキュリティ対策について、網羅的に解説します。

この記事を最後まで読めば、ChatGPTのセキュリティに関する不安を解消し、安全にそのメリットを享受するための知識が身につきます。

ChatGPTでセキュリティリスクが懸念される理由

なぜ、これほどまでにChatGPTのセキュリティリスクが注目されるのでしょうか。

その最も根本的な理由は、入力した情報が意図せずAIの学習データとして利用され、外部に漏洩してしまう可能性があるからです。

入力した情報がAIの学習データになる可能性があるため

ChatGPTは、ユーザーが入力した膨大なテキストデータを学習することで、その精度を向上させています。

デフォルトの設定では、私たちが普段何気なく入力している質問や文章が、この学習データの一部として利用される可能性があります。

もし、業務で扱う顧客の個人情報や、社外秘の開発コード、非公開の経営情報などを入力してしまった場合、それらの機密情報がChatGPTのモデルに記憶されてしまうかもしれません。

そして、その記憶された情報が、将来的に他のユーザーからの質問に対する回答として、意図せず出力されてしまうリスクがゼロではないのです。

これが、ChatGPTの利用においてセキュリティが強く懸念される最大の理由です。

生成AIの利用における個人情報の取り扱いについては、日本の個人情報保護委員会も公式に注意喚起を行っています。合わせてご参照ください。 https://www.ppc.go.jp/news/careful_information/230602_AI_utilize_alert

ChatGPTに潜む7つのセキュリティリスク

ChatGPTを利用する上でのリスクや注意点については、こちらの記事でもより広い視点で解説しています。合わせてご覧ください。ChatGPTの利用には、学習データ化以外にも注意すべき点があります。

ここからは、ChatGPTの利用に潜む具体的な7つのセキュリティリスクについて解説します。

- 機密情報・個人情報の漏洩

- 入力した情報が意図せず学習データになる

- 著作権や知的財産権の侵害

- 誤情報・偽情報の生成と拡散(ハルシネーション)

- サイバー攻撃への悪用(マルウェア作成など)

- フィッシング詐欺や偽アプリへの誘導

- 脆弱なプログラムコードの生成

これらのリスクを正しく理解し、適切な対策を講じることが重要です。それでは、1つずつ詳しく見ていきましょう。

① 機密情報・個人情報の漏洩

最も警戒すべきセキュリティリスクは、機密情報や個人情報の漏洩です。

従業員が業務上の機密情報(例:顧客リスト、財務データ、未公開の研究開発情報)や、取引先の担当者、自身の個人情報などをChatGPTに入力してしまうケースが考えられます。

これらの情報が前述の通りAIの学習データとして利用された場合、他のユーザーへの回答に含まれてしまい、外部に漏洩する可能性があります。

一度インターネット上に流出した情報を完全に削除することは極めて困難であり、企業の社会的信用の失墜や、重大な損害賠償問題に発展しかねません。

② 入力した情報が意図せず学習データになる

情報漏洩という直接的な被害に至らなかったとしても、入力した情報が意図せずAIの学習データになってしまうこと自体がセキュリティ上のリスクです。

例えば、社内向けの新しいサービスに関する企画書や、改善中のプログラムコードをChatGPTに入力して要約やレビューを依頼したとします。

その時点では外部に漏洩しなくても、入力された情報がChatGPTの知識の一部として取り込まれてしまう可能性があります。

これにより、自社の独自のノウハウやアイデアが、間接的に競合他社の利益に繋がってしまうといった事態も想定されます。

③ 著作権や知的財産権の侵害

ChatGPTが生成する文章やコンテンツが、既存の著作物と酷似している場合があり、知らずに利用すると著作権や知的財産権を侵害してしまうリスクがあります。

ChatGPTは、インターネット上の膨大なテキストデータを学習しているため、その学習データの中に含まれる著作権で保護されたコンテンツを元に、回答を生成することがあります。

特に、ブログ記事やレポート、プログラムコードなどを生成させ、それを商用利用する際には細心の注意が必要です。

生成されたコンテンツは、必ずオリジナルのものか、既存の著作物と類似していないかを確認するプロセスが不可欠です。

④ 誤情報・偽情報の生成と拡散(ハルシネーション)

ChatGPTは、時に「ハルシネーション(幻覚)」と呼ばれる、事実に基づかないもっともらしい嘘の情報を生成することがあります。

これは、AIが学習データから統計的に最も可能性の高い単語の繋がりを予測して文章を生成する仕組みに起因するものです。

生成された情報をファクトチェックせずに鵜呑みにしてしまうと、誤った情報に基づいて重要な意思決定を下してしまったり、企業の公式サイトやSNSで偽情報を発信してしまったりするリスクがあります。

情報の正確性が求められる場面では、必ず一次情報源にあたり、内容の真偽を検証することが重要です。

ChatGPTのハルシネーション(もっともらしい嘘の情報)の原因や具体的な対策については、こちらの記事で詳しく解説しています。合わせてご覧ください。⑤ サイバー攻撃への悪用(マルウェア作成など)

悪意を持った攻撃者が、ChatGPTをサイバー攻撃の準備に悪用するリスクも指摘されています。

例えば、特定の機能を持つマルウェア(ウイルス)のプログラムコードを作成させたり、ターゲットを騙すための巧妙なフィッシングメールの文面を生成させたりすることが可能です。

これにより、プログラミングの専門知識がない攻撃者でも、比較的容易にサイバー攻撃を仕掛けられるようになり、攻撃の件数増加や手口の巧妙化を招く恐れがあります。

ChatGPTの利用規約ではこのような悪用は禁止されていますが、抜け道を見つけて利用される可能性は常に存在します。

生成AIの悪用は、IPA(情報処理推進機構)が毎年発表している「情報セキュリティ10大脅威」の最新版でも新たな脅威として解説されています。 https://www.ipa.go.jp/security/10threats/nq6ept000000g22h-att/kaisetsu_2024.pdf

⑥ フィッシング詐欺や偽アプリへの誘導

ChatGPTの知名度の高まりに便乗し、公式サイトを装ったフィッシングサイトや、公式を騙る偽のスマートフォンアプリが登場しています。

ユーザーがこれらの偽サイトや偽アプリとは知らずにアクセスし、アカウント情報(メールアドレスやパスワード)を入力してしまうと、情報が盗まれ、アカウントの乗っ取りなどの被害に遭う可能性があります。

また、偽アプリにマルウェアが仕込まれており、インストールした端末内の情報を盗み取られるといったリスクも考えられます。

利用する際は、URLが正しい公式サイトのものであるか、アプリが公式ストアから提供されているものであるかを必ず確認する必要があります。

⑦ 脆弱なプログラムコードの生成

ChatGPTは、プログラマーにとってコードの生成やデバッグを効率化する強力なツールとなり得ます。

しかし、生成されたプログラムコードにセキュリティ上の脆弱性が含まれている可能性も否定できません。

例えば、入力値の検証が不十分であったり、古いライブラリを使用していたりするなど、攻撃の足がかりとなるようなコードが生成されることがあります。

開発者が生成されたコードを十分にレビュー・検証せずにそのままシステムに組み込んでしまうと、それが原因でサービス全体にセキュリティホールを生み出してしまう危険性があります。

【要注意】実際に起きたChatGPTのセキュリティインシデント事例

理論上のリスクだけでなく、実際にChatGPTに関連するセキュリティインシデントは国内外で発生しています。

ここでは、代表的な3つの事例を紹介します。これらの事例から、リスクが現実のものであることを認識することが重要です。

【海外事例】大手企業での機密情報漏洩

韓国の大手電機メーカーで、半導体設備の測定データや製品の歩留まりに関する情報など、社外秘の機密情報を従業員がChatGPTに入力してしまった事例が報告されています。

従業員は、エラーが発生したソースコードの修正や、会議の議事録作成といった目的でChatGPTを利用していましたが、その過程で機密情報を入力してしまいました。

この事件を受け、同社は暫定的に社内でのChatGPT利用を禁止する措置を取りました。

この事例は、従業員の悪意の有無にかかわらず、便利なツールが重大な情報漏洩に繋がりかねないという教訓を示しています。

こちらは、韓国の大手電機メーカーで発生した情報漏洩インシデントについて、その背景や教訓を解説した記事です。合わせてご覧ください。 https://cybernews.com/security/chatgpt-samsung-leak-explained-lessons/

【国内事例】チャット内容が他のユーザーに表示される不具合

2023年3月、ChatGPTの一部のユーザーのチャット履歴の「タイトル」が、他のユーザーのアカウントに表示されてしまうという不具合がOpenAIから公式に発表されました。

チャットの内容そのものが表示されたわけではありませんが、タイトルからどのようなやり取りをしていたかが推測できてしまう可能性がありました。

例えば、「〇〇株式会社との業務提携に関する契約書のドラフト作成」といったタイトルが表示されれば、第三者に重要なプロジェクトの存在を知られてしまうことになります。

サービス提供者側の不具合によっても、情報漏洩のリスクは発生しうることを示す事例です。

この記事で触れているチャット履歴のタイトルが表示された不具合について、OpenAIが公式に原因と対策を発表しています。 https://openai.com/index/march-20-chatgpt-outage/

【悪用事例】マルウェア作成やフィッシングへの利用

特定のインシデントではありませんが、セキュリティ研究者などによって、ChatGPTが悪用されうることが多数報告されています。

簡単な指示を与えるだけで、情報を盗み出す機能を持つマルウェアのコードが生成されたり、大手金融機関やECサイトを装った極めて巧妙なフィッシングメールの文面が作成されたりする事例が実証されています。

これにより、サイバー犯罪のハードルが下がり、社会全体のセキュリティ脅威が高まることが懸念されています。

悪用を防ぐための対策がOpenAIによって講じられていますが、攻撃者とのいたちごっこが続いているのが現状です。

【今すぐできる】個人向けChatGPTのセキュリティ対策5選

ここからは、個人でChatGPTを安全に利用するために、今すぐ実践できる具体的なセキュリティ対策を5つ紹介します。

これらの対策を徹底することで、多くのリスクを大幅に低減させることが可能です。

対策①:機密情報や個人情報を入力しない

最も重要かつ基本的なセキュリティ対策は、機密情報や個人情報を一切入力しないことです。

氏名、住所、電話番号、メールアドレス、クレジットカード番号、パスワードといった個人情報は絶対に入力してはいけません。

また、会社の内部情報、顧客データ、非公開のプロジェクト情報など、自身が所属する組織の機密情報も同様です。

「この情報がもし全世界に公開されても問題ないか?」と自問自答する習慣をつけ、少しでも懸念がある情報は入力しないことを徹底しましょう。これが情報漏洩を防ぐための最も確実な方法です。

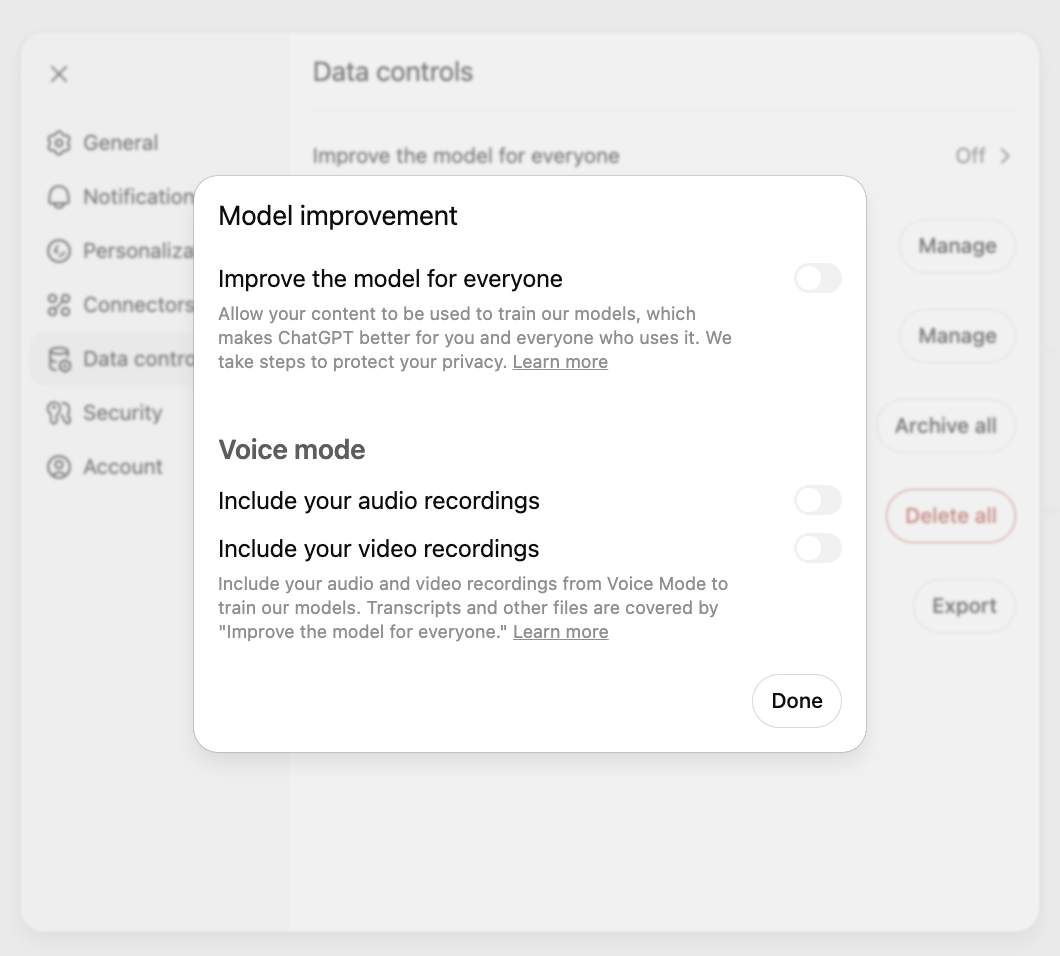

対策②:チャット履歴の学習機能をオフ(オプトアウト)にする

入力した情報がAIの学習データとして利用されるのを防ぐために、チャット履歴の学習機能をオフ(オプトアウト)に設定することが推奨されます。

この設定を行うと、あなたの会話はAIモデルの学習には使用されなくなります。

設定方法は簡単で、ChatGPTにログイン後、画面左下の自分の名前をクリックし、「Settings」→「Data controls」の順に進み、「Chat history & training」のトグルをオフにするだけです。

ただし、この設定をオフにすると、過去のチャット履歴が保存されなくなるというデメリットもあるため、利便性とのバランスを考えて設定しましょう。

チャット履歴の機能を使い続けながら、入力したデータをAIの学習から除外する具体的な設定方法については、こちらのOpenAI公式ヘルプページで解説されています。 https://help.openai.com/en/articles/8983130-what-if-i-want-to-keep-my-history-on-but-disable-model-training

対策③:公式サイト・公式アプリを利用する

フィッシング詐欺やマルウェア感染のリスクを避けるため、必ず公式サイトと公式アプリを利用するようにしてください。

ブックマークやショートカットからアクセスする、検索結果のURLが「https://chat.openai.com/」であることを確認するなど、常に本物のサービスを利用していることを確認する習慣が重要です。

スマートフォンアプリを利用する場合は、App StoreやGoogle Playの提供元が「OpenAI」であることを確認してからインストールしましょう。

安易に広告やメールのリンクからアクセスするのは避けるべきです。

対策④:生成された情報を鵜呑みにせず真偽を確認する

ハルシネーション(誤情報)のリスクに対応するため、ChatGPTが生成した情報は鵜呑みにせず、必ず真偽を確認(ファクトチェック)することが不可欠です。

特に、統計データ、歴史的な事実、法律や医療に関する専門的な情報については、信頼できる公的機関のウェブサイトや専門家の論文など、一次情報源を参照して裏付けを取るようにしましょう。

ChatGPTはあくまで「文章生成ツール」であり、「事実確認ツール」ではないと認識することが重要です。

誤った情報を基に行動したり、発信したりすることで生じるトラブルを未然に防ぎましょう。

対策⑤:セキュリティソフトを導入・最新化する

基本的なPC・スマートフォンのセキュリティ対策として、信頼できるセキュリティソフトを導入し、常に最新の状態に保つことも重要です。

これにより、万が一ChatGPTの偽サイトにアクセスしようとした際に警告が表示されたり、マルウェアを含むファイルをダウンロードしようとした際にブロックしたりすることができます。

ChatGPTの利用に限らず、インターネットを安全に利用するための基本的な対策として、OSやソフトウェアのアップデートと合わせて、セキュリティソフトの活用を徹底しましょう。

【企業向け】法人で実施すべきChatGPTのセキュリティ対策5選

個人での利用以上に、企業活動においてはより厳格なセキュリティ対策が求められます。

ここでは、法人が組織として実施すべき5つのセキュリティ対策を解説します。

対策①:社内利用のガイドラインを策定・周知する

まず最初に行うべきは、社内におけるChatGPTの利用に関する明確なガイドラインを策定し、全従業員に周知徹底することです。

ガイドラインには、入力してはいけない情報(個人情報、顧客情報、社外秘情報など)の具体例、利用が許可される業務の範囲、著作権侵害を避けるための注意点、問題が発生した場合の報告手順などを盛り込みます。

単にルールを作るだけでなく、なぜそのルールが必要なのか、リスクの背景も含めて丁寧に説明し、従業員一人ひとりのセキュリティ意識を高めることが、形骸化させないためのポイントです。

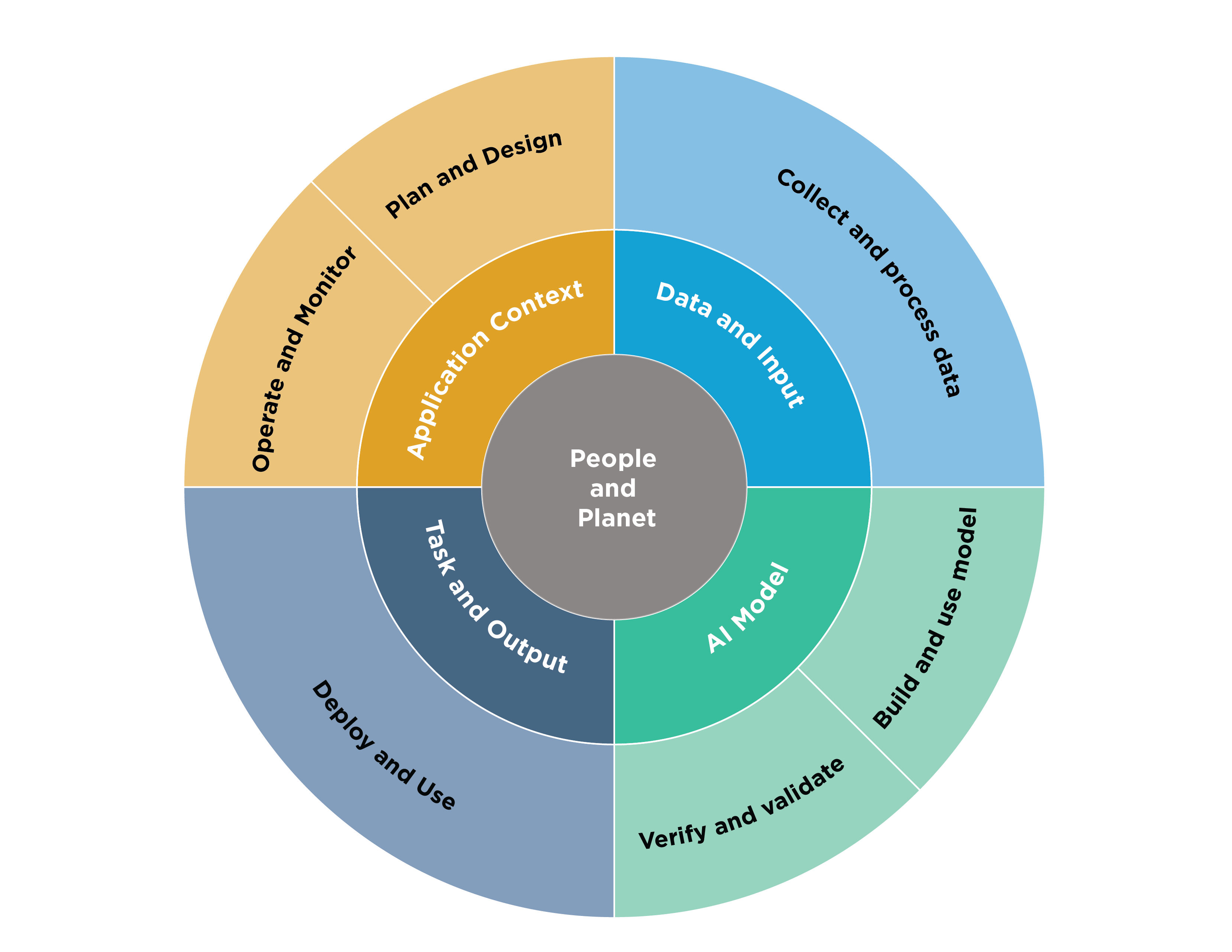

AI利用に関するリスク管理の国際的な枠組みとして、米国国立標準技術研究所(NIST)が公開している「AIリスク管理フレームワーク」が大変参考になります。 https://airc.nist.gov/airmf-resources/airmf/

対策②:セキュリティ機能が強化された法人向けプランを利用する

より安全にChatGPTを業務利用したい場合は、セキュリティ機能が強化された法人向けプランの導入を検討すべきです。

OpenAIが提供する「ChatGPT Enterprise」などのプランでは、入力したデータがAIの学習に利用されないことが契約で保証されています。

加えて、データの暗号化、ユーザー認証の強化、利用状況を管理・監査するためのダッシュボード機能など、企業統治に必要なセキュリティ機能が充実しています。

初期コストやランニングコストは発生しますが、情報漏洩によって失う社会的信用や損害額を考えれば、有効な投資と言えるでしょう。

ChatGPTの法人向けプランの料金や機能、他プランとの詳細な違いについては、こちらの記事で詳しく解説していますので、ぜひご覧ください。対策③:「Azure OpenAI Service」の活用を検討する

Microsoftが提供する「Azure OpenAI Service」の活用も、企業にとって有力な選択肢の一つです。

これは、Microsoft Azureの堅牢なクラウドプラットフォーム上で、ChatGPTと同じGPTモデルを利用できるサービスです。

Azureの閉域網接続や厳格なアクセス管理といった高度なセキュリティ環境下でAIを利用できるため、自社のデータを安全に保ちながら生成AIのメリットを享受できます。

入力したデータがOpenAIのモデル学習に使われることはなく、自社のAzure環境内でデータが完結するのが最大のメリットです。

Microsoft Azureの環境で機密データを取り扱いながら、安全にOpenAIモデルを活用するためのベストプラクティスがこちらの公式ドキュメントで解説されています。 https://learn.microsoft.com/en-us/answers/questions/2156197/best-practices-for-securing-azure-openai-with-conf

対策④:アクセス管理と利用状況の監視体制を構築する

誰が、いつ、どのようにChatGPTを利用しているかを把握し、管理・監視できる体制を構築することも重要です。

法人向けプランやAzure OpenAI Serviceには、管理者が各ユーザーの利用状況を確認できる機能が備わっています。

定期的にログを監査し、ガイドラインに反するような不適切な利用(機密情報の入力など)がないかをチェックすることで、リスクの早期発見に繋がります。

また、万が一インシデントが発生した際にも、利用ログが原因究明のための重要な手がかりとなります。

対策⑤:全従業員にセキュリティ教育を実施する

どのような優れたツールやルールを導入しても、最終的にそれを利用するのは「人」です。

従業員一人ひとりのセキュリティリテラシーが低ければ、リスクを完全に防ぐことはできません。

ChatGPTの利便性だけでなく、本記事で解説したようなセキュリティリスクについても正しく理解させるための研修や教育を、定期的かつ継続的に実施することが不可欠です。

実際のインシデント事例などを交えながら、自分自身の業務に潜むリスクを具体的にイメージさせることが、教育の効果を高める上で重要となります。

ChatGPTのセキュリティに関するよくある質問

最後に、ChatGPTのセキュリティに関して多くの人が抱く疑問について、Q&A形式で回答します。

ChatGPTに入力した情報は誰に見られますか?

デフォルト設定の場合、入力された情報は、OpenAIの一部の従業員によって、モデルの性能改善や不正利用の監視を目的として閲覧される可能性があります。

ただし、法人向けプラン(ChatGPT Enterpriseなど)を利用している場合や、個人向けプランでチャット履歴の学習機能をオフ(オプトアウト)に設定している場合は、入力情報が閲覧されたり、学習に利用されたりすることはありません。

履歴をオフにすれば、情報漏洩のリスクは完全になくなりますか?

いいえ、完全になくなるわけではありません。

チャット履歴の学習機能をオフにすることで、入力した情報がAIの学習データとして利用されるリスクは大幅に低減できます。

しかし、通信経路上でデータが盗聴されるリスクや、OpenAIのシステムがサイバー攻撃を受けて情報が流出するリスクなどがゼロになるわけではありません。

したがって、履歴をオフにしている場合でも、「機密情報を入力しない」という大原則は必ず守る必要があります。

無料版と有料版でセキュリティに違いはありますか?

個人向けの無料版と有料版(ChatGPT Plus)では、適用される基本的なセキュリティポリシーやプライバシーポリシーに大きな違いはありません。

どちらも、オプトアウト設定をしない限りは、入力情報が学習データとして利用される可能性があります。

一方で、法人向けの「ChatGPT Enterprise」プランは、入力情報が学習に利用されないことが契約上保証されており、管理者向けのセキュリティ機能も強化されているため、個人向けプランよりも高いセキュリティレベルが確保されています。

あなたの会社は大丈夫?ChatGPTが「情報漏洩の温床」になる企業と「最強の武器」になる企業の境界線

ChatGPTの業務利用、一歩間違えれば会社の命運を揺るがす重大なセキュリティインシデントに繋がりかねません。実際に、韓国の大手電機メーカーでは、従業員が機密情報を入力したことで大規模な情報漏洩が発生し、企業の信頼は大きく損なわれました。しかし、ご安心ください。適切な対策を講じている企業は、ChatGPTを「最強の業務効率化ツール」として安全に活用し、競争力を高めています。この記事では、「リスクに晒される企業」と「賢く活用する企業」の決定的な違いを、具体的な対策とともに解説します。

【警告】その使い方では、会社の重要情報が筒抜けかもしれない

「議事録の要約くらいなら大丈夫だろう」「このソースコードのエラーを直してほしい」——。そんな軽い気持ちでの利用が、取り返しのつかない事態を招く可能性があります。ChatGPTは、入力された情報を学習データとして利用することがあり、一度学習された情報は、他のユーザーへの回答として出力されてしまうリスクを完全には否定できません。

この「情報の意図せぬ学習」が続くと、次のような致命的なリスクが考えられます。

- 顧客情報や個人情報の流出

- 開発中の新製品に関する社外秘情報漏洩

- 自社の独自ノウハウや技術情報の拡散

便利なツールに頼るうち、気づかぬ間に、企業競争力の源泉であるはずの重要情報が、外部に漏れ出している可能性があるのです。

引用元:

韓国の大手電機メーカーの従業員が、半導体関連の機密情報を含むソースコードや会議内容をChatGPTに入力。同社は事態を重く受け止め、生成AIの社内利用を緊急制限する措置を講じました。(2023年に複数のメディアが報道)

【実践】ChatGPTを安全な「業務効率化エンジン」に変える3つの鉄則

では、「賢く活用する企業」は具体的に何をしているのでしょうか。答えはシンプルです。彼らはAIを「便利なアシスタント」としてだけでなく、「厳格な管理下で使うべき強力なツール」として捉えています。ここでは、今日から実践できる3つの鉄則をご紹介します。

鉄則①:「公開されても良い情報か?」を常に自問する

最も基本的で重要なルールです。従業員一人ひとりが、情報を入力する前に「この情報が、明日のニュースで全世界に公開されても問題ないか?」と自問自答する文化を醸成します。個人情報や顧客情報、社外秘のデータは、いかなる理由があろうとも入力しない。この原則を徹底することが、情報漏洩を防ぐ第一歩です。

鉄則②:組織として「学習オフ(オプトアウト)」を義務付ける

個人の設定任せにせず、組織の統一ルールとして、ChatGPTの学習機能をオフ(オプトアウト)にすることを義務付けます。ChatGPTには、入力した会話データをAIの学習に利用させないための設定項目があります。これを全社的に適用することで、意図しない情報学習のリスクを大幅に低減できます。

鉄則③:セキュリティが担保された「法人専用道路」を整備する

無料の個人向けサービスを業務利用するのではなく、セキュリティが強化された法人向けプランや、「Azure OpenAI Service」のようなサービスを導入します。これらのサービスは、入力データが学習に使われないことが契約で保証されており、アクセス管理や利用状況の監視機能も充実しています。安全な「専用道路」を整備することで、従業員は安心してAIのメリットを享受できるのです。

まとめ

企業は業務効率化や生産性向上の課題を抱える中で、ChatGPTのような生成AIの活用がその切り札として注目されています。

しかし、実際には「入力した機密情報が漏洩しないか心配」「社員が安全に使えるルールをどう作ればいいかわからない」といったセキュリティ上の懸念から、本格的な導入に踏み切れない企業も少なくありません。

そこでおすすめしたいのが、Taskhub です。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Microsoftが提供するAzure OpenAI Serviceを基盤にしているため、入力したデータがAIの学習に利用されることはなく、データセキュリティが万全で、情報漏洩の心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「どうすれば安全に使えるのか」といったセキュリティガイドラインの策定から支援が可能で、初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプログラミングや高度なAI知識がなくても、すぐに安全な環境で業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最速かつ最も安全な生成AI活用”を体験し、御社のDXを一気に加速させましょう。