「ChatGPTがないと、仕事のメール一つ書けない…」

「自分で調べる前に、ついChatGPTに答えを求めてしまう…」

このように、ChatGPTの便利さに助けられる一方で、気づかぬうちに頼りすぎてしまい、自分の思考力が落ちているのではないかと不安に感じていませんか?

本記事では、ChatGPT依存に陥ってしまう原因から、思考力や創造性が失われる危険なプロセス、さらには今日から実践できる具体的な対策までを詳しく解説します。

この記事を読めば、ChatGPTとの健全な付き合い方がわかり、AIを「思考を奪う脅威」ではなく「最強の相棒」として活用できるようになるはずです。ぜひ最後までご覧ください。

もしかしてあなたも?ChatGPT依存の危険なサイン

まず、どのような状態がChatGPT依存のサインと言えるのでしょうか。

ここでは、無意識のうちに現れる危険な兆候を3つ紹介します。

自分に当てはまるものがないか、チェックしながら読み進めてみてください。

気づけば無意識にChatGPTを開いている

何かタスクを始めようとした時、明確な目的もないのに、まるで癖のようにChatGPTの画面を開いてしまうことはありませんか?

これは、思考のプロセスにChatGPTが深く根付いてしまっている証拠です。

「考える」という行為の入り口が、常にChatGPTになっている状態と言えます。

例えば、資料作成を始める際に、まず自分で構成を考えるのではなく、とりあえずChatGPTに「〇〇の資料を作って」と入力してしまう。

あるいは、少しでも分からない単語が出てくると、すぐにブラウザの検索窓ではなくChatGPTに質問してしまう。

こうした行動が日常化すると、自発的に思考を開始する力が徐々に衰えていきます。

無意識の行動は、依存の初期段階でよく見られる危険なサインの一つです。

自分で考える前に、まずChatGPTに質問してしまう

会議の議題や企画のアイデア出しなど、本来であれば自分の頭でじっくり考えるべき場面で、思考の第一歩をChatGPTに委ねていませんか?

「〇〇についてのアイデアを5つ出して」

「この問題の解決策は?」

このように、思考のプロセスそのものをAIに丸投げしてしまう習慣は、非常に危険です。

ChatGPTは優れた回答を生成してくれますが、それはあくまで既存の情報を組み合わせたものに過ぎません。

ゼロからイチを生み出す創造的な思考や、多角的な視点から物事を深く考察する力は、自分で考え抜く経験を繰り返すことでしか養われません。

この習慣が続くと、いざAIがない環境で意見を求められた際に、何も考えが浮かばないという事態に陥りかねません。

「まずChatGPTに聞く」が口癖になっているなら、注意が必要です。

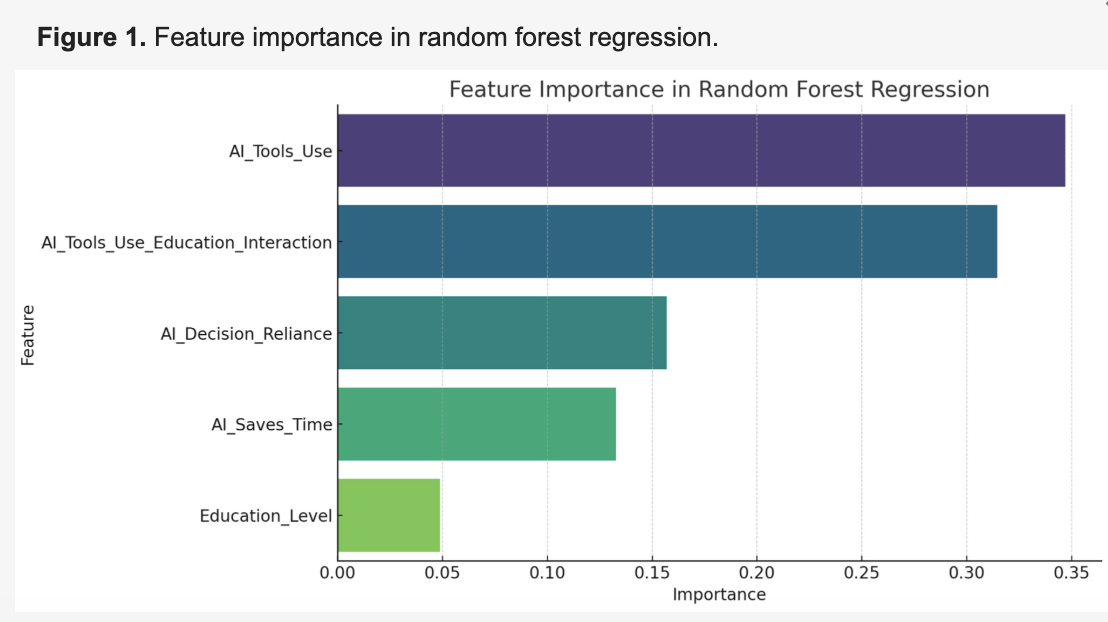

こちらは、AIへの信頼が個人の問題解決能力をどう低下させるかを示した知識労働者向けの調査です。合わせてご覧ください。 https://www.microsoft.com/en-us/research/wp-content/uploads/2025/01/lee_2025_ai_critical_thinking_survey.pdf

ChatGPTからの回答がないと不安で作業が進まない

ChatGPTが出した回答をたたき台にして作業を進めることに慣れすぎて、AIからのインプットがないと、何から手をつけていいか分からなくなり、強い不安を感じる状態です。

これは、自分の判断や知識に対する自信を失い、AIの回答を「正解」だと信じ込んでしまっている心理状態の表れです。

例えば、ChatGPTがメンテナンス中であったり、アクセスが集中して使えなかったりした際に、業務が完全にストップしてしまうなら、かなり依存度が高いと言えるでしょう。

また、自分で作成した文章やアイデアに対しても、「本当にこれで良いのだろうか」と不安になり、何度もChatGPTに確認・修正を依頼してしまうのも危険な兆候です。

自分の思考や判断を信じられなくなり、常にAIの「お墨付き」がないと安心できない状態は、健全な活用とは言えません。

なぜ私たちはChatGPTに依存してしまうのか?3つの心理的要因

これほどまでに便利で高性能なChatGPTですが、なぜ私たちは深く依存してしまうのでしょうか。

その背景には、人間の心理に働きかける3つの強力な要因が存在します。

ここでは、ChatGPT依存を引き起こす心理的メカニズムを解き明かします。

すぐに答えが手に入る手軽さへの慣れ

人間の脳は、できるだけエネルギー消費を抑え、楽な道を好む性質があります。

ChatGPTは、この性質に完璧に合致するツールです。

これまでであれば、本を何冊も読んだり、複数のウェブサイトを比較検討したりと、時間と労力をかけて探していた答えが、質問を入力するだけで瞬時に手に入ります。

この「すぐに答えが手に入る」という圧倒的な手軽さとスピード感は、一度体験するとやみつきになるほどの快感をもたらします。

この経験を繰り返すうちに、脳は「自分で考える」という負荷のかかる作業を避け、ChatGPTに頼るという楽なルートを優先するようになります。

これが、手軽さへの「慣れ」であり、依存への入り口となるのです。

万能なAIに対する過度な信頼

ChatGPTは、まるで専門家のように自然で論理的な文章を生成するため、私たちはその回答が常に正確で最適なものであると錯覚しがちです。

特に、自分が詳しくない分野について質問した際には、その回答を疑うことなく鵜呑みにしてしまう傾向があります。

このような「AIは万能である」という過度な信頼は、思考の放棄につながります。

自分で情報の真偽を確かめたり、別の可能性を検討したりすることをやめてしまい、ChatGPTの回答を唯一の正解として受け入れてしまうのです。

しかし、ChatGPTは時として、事実とは異なる情報(ハルシネーション)を生成することもあります。

この過度な信頼は、誤った情報に基づいて判断を下してしまうリスクをはらんでいるだけでなく、批判的思考力(クリティカルシンキング)を著しく低下させる要因となります。

こちらは、AIへの過信が引き起こす「自動化バイアス」について、パイロットの実例を挙げて解説した研究です。合わせてご覧ください。

自動化バイアス:AIの判断を盲信する危険性

自動化バイアスとは、自動化されたシステムからの提案を過度に優先し、それと矛盾する情報を軽視してしまう心理傾向です。航空機操縦や医療診断の分野で特に顕著に現れ、深刻な事故につながるケースも報告されています。

職業パイロットを対象とした研究では、半数以上が自動化システムの警告に従って危険なミスを犯した経験があることが明らかになりました。人間はテクノロジーを「間違いを起こさない権威」として捉えやすく、システムの誤りを疑わずに受け入れてしまう傾向があるのです。

引用元:AI協働時代の認知バイアス:人間の判断力に潜む新たなリスクと対策

自分一人で考える孤独感からの解放

複雑な課題や難解な問題に直面した時、一人で考え続けることには、精神的な負担や孤独感が伴います。

考えがまとまらずに行き詰まったり、自分の思考が正しいのか不安になったりすることもあるでしょう。

ChatGPTは、そんな時に24時間365日、いつでも気軽に相談できる「壁打ち相手」のような存在になってくれます。

対話形式で質問に答えてくれるため、まるで誰かと一緒に考えているような感覚になり、一人で考える孤独感やプレッシャーから解放されるのです。

この「孤独感の解消」という心理的なメリットは、依存を強化する強力な要因となり得ます。

誰かに相談する手間や気まずさを感じることなく、いつでも手軽に思考のパートナーを得られるため、現実の人間との対話よりもAIとの対話を優先してしまうことにつながるのです。

【要注意】ChatGPT依存があなたの能力を奪うプロセス

ChatGPTへの依存は、単なる「怠け癖」では済みません。

知らず知らずのうちに、ビジネスパーソンとして、また一人の人間として不可欠な能力を少しずつ蝕んでいく、非常に危険なプロセスなのです。

ここでは、ChatGPT依存が具体的にどのような能力を奪っていくのかを解説します。

自分の頭で考え抜く「思考力」の低下

最も深刻な影響が、物事の本質を見極め、論理的に結論を導き出す「思考力」の低下です。

ChatGPTに答えを求める習慣が続くと、情報と情報を結びつけ、分析し、自分なりの結論を出すという脳の働きが著しく減少します。

脳も筋肉と同じで、使わなければ衰えていきます。

複雑な問題に対して、多角的な視点から粘り強く考え抜く経験が失われることで、思考の持久力がなくなり、少し難しい課題に直面するとすぐに諦めてしまうようになります。

最終的には、表層的な情報に流されやすくなり、物事の背景や本質を深く理解できない、深みのない思考しかできなくなってしまう危険性があります。

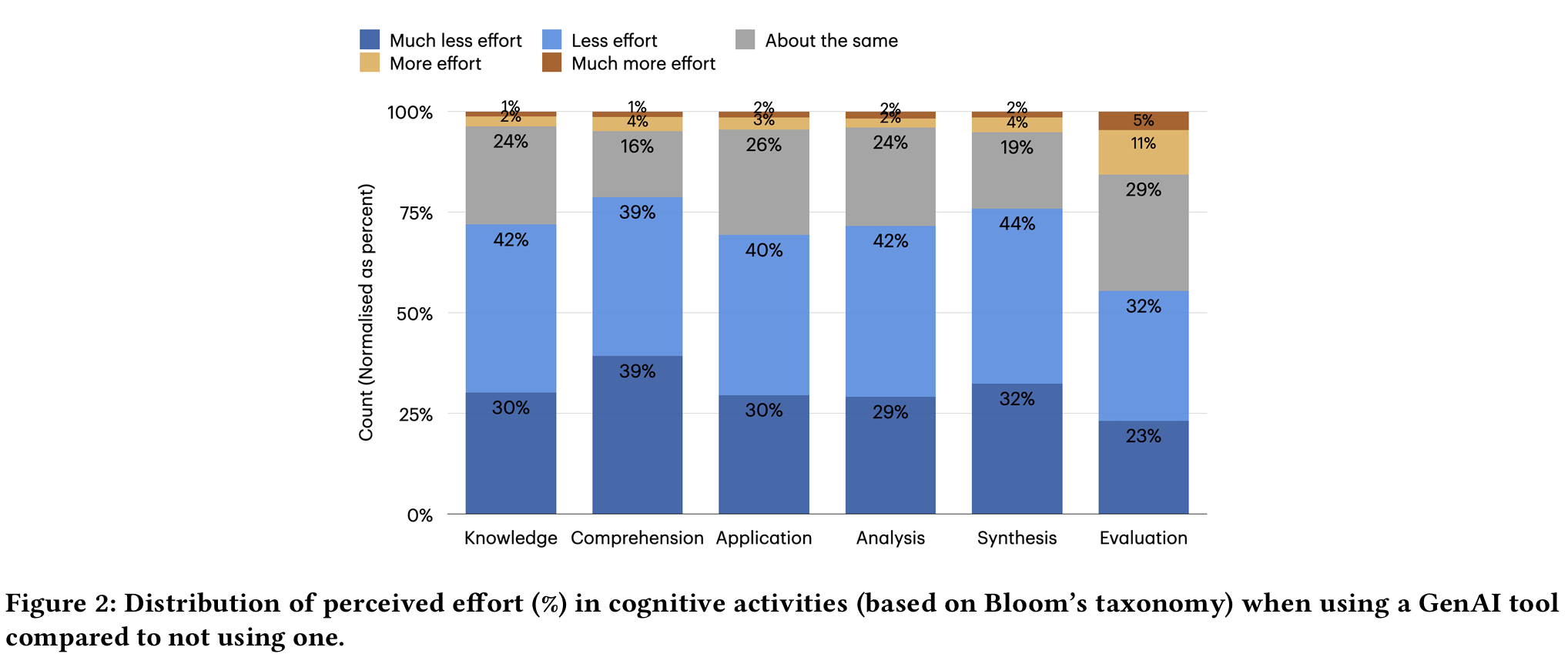

こちらは、AIツールの利用頻度と批判的思考能力の間に負の相関関係があることを示した学術論文です。合わせてご覧ください。

https://www.mdpi.com/2075-4698/15/1/6

情報を記憶し、活用する「記憶力」の衰え

何かを覚えようとする時、私たちはその情報に何度も触れ、関連情報と結びつけ、整理するというプロセスを経て、知識を長期記憶として定着させます。

しかし、ChatGPTを使えばいつでも瞬時に情報を引き出せるため、「覚えておく必要がない」と脳が判断し、記憶のプロセスそのものが省略されてしまいます。

これは、スマートフォンの普及で電話番号を覚えなくなった現象と似ています。

その結果、知識が脳に定着せず、いつまで経っても自分のものになりません。

会議の場でとっさにデータや専門用語が出てこなかったり、過去の経験から学んだ教訓を活かせなくなったりと、業務の質を大きく低下させる原因となります。

こちらは、AIのみで文章を作成した学生の脳の結合性が弱化し、記憶保持能力が低下したことを示したMITの脳波研究に関する記事です。合わせてご覧ください。

https://www.nextgov.com/artificial-intelligence/2025/07/new-mit-study-suggests-too-much-ai-use-could-increase-cognitive-decline/406521/

自力で課題を乗り越える「問題解決能力」の欠如

問題解決能力は、現状を分析し、原因を特定し、解決策を立案・実行し、結果を検証するという一連のプロセスを自力でやり遂げる経験を通して磨かれます。

ChatGPTに解決策を提示してもらうことに慣れてしまうと、この最も重要な経験を積む機会が失われます。

AIが提示した「それらしい」解決策に飛びついてしまい、なぜその解決策が有効なのか、他に選択肢はないのかといった深い検討を行わなくなります。

その結果、想定外の事態が発生した際に対応できなくなったり、前例のない課題に対して全く手も足も出なくなったりと、自律的に業務を遂行する能力が著しく欠如してしまうのです。

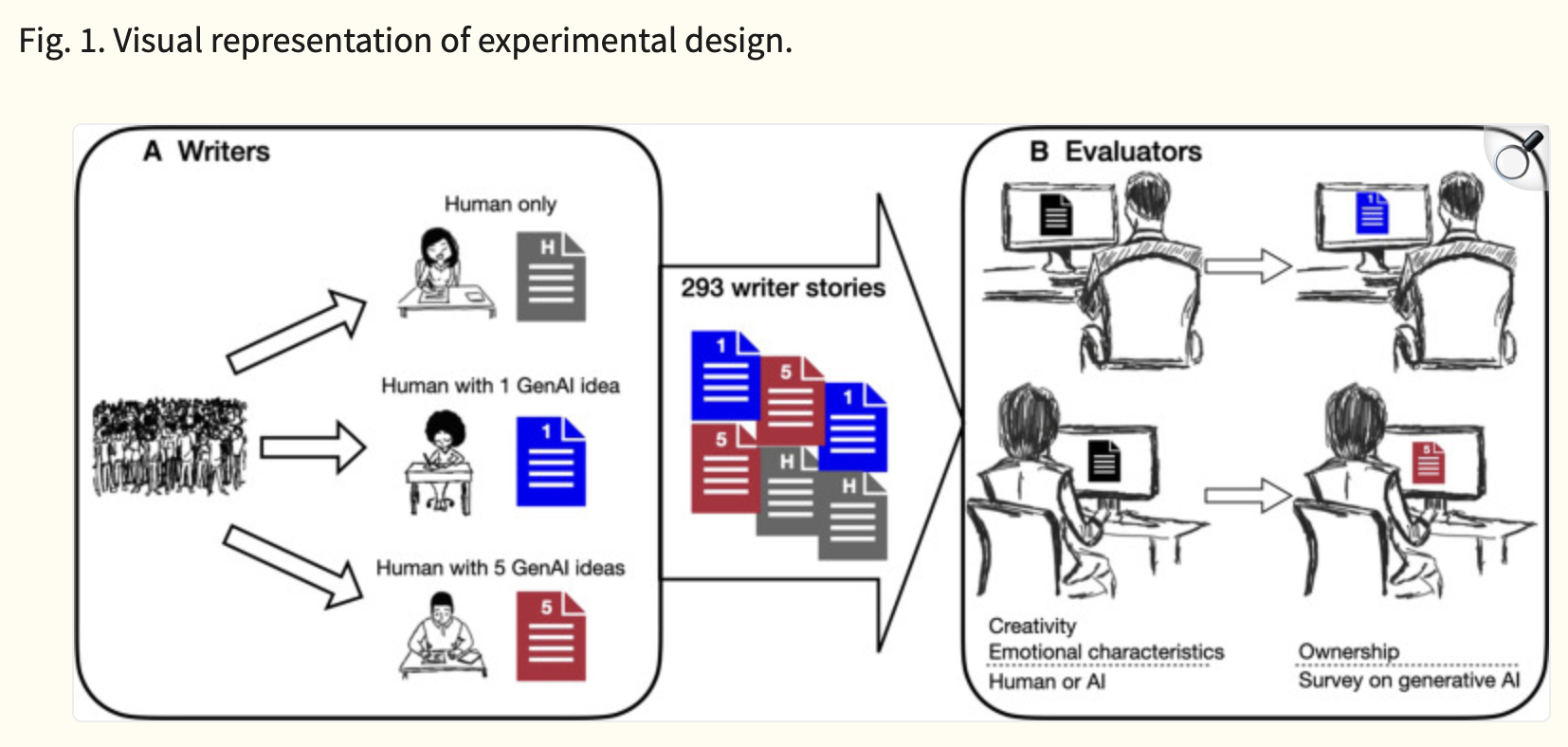

新しいアイデアを生み出す「創造性」の喪失

創造性とは、既存の知識や経験を、これまでとは違う形で新しく組み合わせることで生まれます。

そのためには、一見無関係に見える情報を頭の中で結びつけたり、ぼんやりとした思考の中からアイデアの種を見つけ出したりするプロセスが不可欠です。

ChatGPTは、既存の膨大なデータから最も可能性の高い組み合わせを提示することには長けていますが、人間のような直感や偶然性から生まれる、突飛で斬新なアイデアを生み出すことは苦手です。

アイデア出しの段階からChatGPTに頼り切ってしまうと、常に論理的で平均的な回答の枠に思考が縛られてしまいます。

これにより、常識を打ち破るようなユニークな発想や、自分自身の経験に基づいたオリジナリティのあるアイデアを生み出す力が枯渇してしまう恐れがあるのです。

こちらは、生成AIが個人の生産性を上げる一方で、集団レベルでは成果物の均質化を招くことを論じた研究論文です。合わせてご覧ください。

https://pmc.ncbi.nlm.nih.gov/articles/PMC11244532/

人間関係にも影響が?ChatGPT依存がもたらす社会的リスク

ChatGPTへの依存がもたらす影響は、個人の能力低下だけに留まりません。

私たちのコミュニケーションのあり方や社会との関わり方にまで、深刻なリスクを及ぼす可能性があります。

ここでは、見過ごされがちな社会的リスクについて解説します。

現実世界でのコミュニケーションが希薄になる

ChatGPTは、ユーザーの意図を汲み取り、常に穏やかで最適な回答を返してくれます。

感情的なすれ違いや意見の対立もなく、ストレスフリーな対話が可能です。

この快適なAIとのコミュニケーションに慣れてしまうと、現実の人間関係が煩わしく感じられるようになることがあります。

相手の表情を読み取ったり、言葉の裏にある意図を推測したり、時には意見の衝突を乗り越えたりといった、複雑で骨の折れる生身のコミュニケーションを避けるようになるのです。

その結果、友人との会話が減ったり、職場の同僚との雑談が億劫になったりと、現実世界でのつながりが徐々に希薄になってしまう危険性があります。

こちらは、AIチャットボットの利用頻度が高いほど、現実の人間との社会的交流が減少する相関関係を示したMITの縦断研究です。合わせてご覧ください。

https://www.media.mit.edu/publications/how-ai-and-human-behaviors-shape-psychosocial-effects-of-chatbot-use-a-longitudinal-controlled-study/

AIの回答が基準になり、自分の意見に自信がなくなる

ChatGPT依存が進行すると、あらゆる場面で「ChatGPTならどう答えるか?」という思考が働くようになります。

AIが生成する論理的で完璧に見える回答が、いつの間にか自分の中での「正解」や「基準」になってしまうのです。

その結果、たとえ自分が何か意見を持っていても、「AIの答えと違うから、これは間違っているのかもしれない」と、自分の考えに自信が持てなくなってしまいます。

会議の場で発言を求められても、AIの裏付けがないと不安で口を開けなくなったり、自分の意見を主張できなくなったりするケースも考えられます。

このように、自己肯定感が低下し、常にAIの判断を仰がなければ行動できない状態に陥ることは、大きな社会的リスクと言えるでしょう。

他者との意見交換を避け、孤立を深めてしまう

自分の意見に自信がなくなると、他者と意見を交換する場を避けるようになります。

自分の考えが否定されたり、議論になったりすることを恐れるからです。

わざわざ他人と議論しなくても、ChatGPTに聞けばすぐに「正解」を教えてくれるという考えが、この傾向に拍車をかけます。

その結果、多様な価値観に触れたり、議論を通じて自分の考えを深めたりする貴重な機会が失われていきます。

自分の思考の殻に閉じこもり、AIとの対話だけで完結する世界は、一見快適に思えるかもしれません。

しかし、それは社会からの孤立を深め、自身の成長を止めてしまうことに他ならないのです。

あなたの危険度は?ChatGPT依存度セルフチェックリスト

自分がChatGPT依存に陥っていないか、客観的に判断するのは難しいものです。

そこで、現在のあなたの利用状況を振り返るためのセルフチェックリストを用意しました。

以下の5つの質問に、正直に答えてみてください。

当てはまる項目が多いほど、注意が必要なサインです。

1日の利用時間を把握していますか?

まず、自分が1日にどのくらいの時間、ChatGPTを利用しているかを正確に把握できているでしょうか。

「なんとなく」「気づいたら使っている」という状態で、具体的な利用時間を意識していない場合、無自覚のうちに依存が進行している可能性があります。

スマートフォンのスクリーンタイムのように、利用時間を意識することは、依存対策の第一歩です。

もし、仕事や勉強に必要だと考えていた時間を大幅に超えて利用しているのであれば、それは危険なサインかもしれません。

特に、業務時間外や休憩時間、就寝前などにも目的なく使い続けている場合は注意が必要です。

ChatGPTなしで仕事や勉強を進めることに不安を感じますか?

もし明日からChatGPTが一切使えなくなったと想像してみてください。

その時、「仕事が全く進まない」「どうすればいいか分からない」といった強い不安や恐怖を感じるでしょうか。

もちろん、業務効率が落ちることはあるでしょう。

しかし、それ以上にパニックに近い感情を抱くのであれば、単なる「便利なツール」としてではなく、精神的な支えとしてChatGPTに依存してしまっている可能性が高いです。

本来、業務や学習の主体はあなた自身であるはずです。

ツールの不在が、主体的な活動そのものを脅かすほどの不安を引き起こすなら、その関係性を見直す必要があります。

他人との会話よりChatGPTとの対話を「楽だ」と感じますか?

同僚へのちょっとした質問や、友人への相談事。そういった場面で、人に話しかけるよりも先に「ChatGPTに聞いた方が早いし楽だ」と考えてしまうことはありませんか?

人と話す際には、相手の都合を考えたり、感情に配慮したりと、気を使う場面が多くあります。

一方、ChatGPTはいつでも即座に、感情を抜きにした合理的な回答をくれます。

この「楽さ」を優先し、生身の人間とのコミュニケーションを避ける傾向が強まっているなら、注意が必要です。

効率を求めるあまり、人との関わりから得られる共感や新たな発見、信頼関係といった大切なものを失っているのかもしれません。

ChatGPTの回答を疑わずに信じてしまうことがありますか?

ChatGPTが生成した文章やデータ、情報を、ファクトチェックや裏付け調査をせずに、そのままレポートや資料に使ってしまった経験はありませんか?

ChatGPTは非常に高性能ですが、その情報は常に正しいとは限りません。

最新の情報が反映されていなかったり、誤った情報をそれらしく生成したりすることもあります。

その特性を理解せず、AIの回答を無条件に「真実」だと信じ込んでしまうのは、依存の危険な兆候です。

健全な利用者は、AIを「思考の材料を提供してくれるアシスタント」と捉え、最終的な判断は自分で行います。

回答を鵜呑みにする習慣は、批判的思考力の低下の表れであり、非常にリスクの高い行為です。

明確な目的なくChatGPTを使い始めてしまうことがありますか?

調べたいことや解決したい課題がはっきりしているわけではないのに、暇つぶしや手持ち無沙汰から、ついChatGPTを開いて雑談を始めてしまうことはありませんか?

SNSを目的なく眺めてしまう感覚に近いかもしれません。

これは、ChatGPTとの対話自体が目的化してしまっている状態です。

明確な目的意識を持った利用は「活用」ですが、目的のない利用は「依存」につながりやすいと言えます。

「なんとなく」で使い始める時間が増えていると感じたら、それはChatGPTとの距離感を見直すべきサインです。

今日から実践!ChatGPT依存から抜け出すための5つのステップ

もし、先ほどのチェックリストで「自分は依存しているかもしれない」と感じても、過度に心配する必要はありません。

意識して行動を変えることで、ChatGPTとの健全な関係を取り戻すことは十分に可能です。

ここからは、今日からすぐに実践できる具体的な5つのステップを紹介します。

STEP1:利用時間と目的を明確に決める

まず、ChatGPTを「いつ」「何のために」「どのくらいの時間」使うのかを、事前に具体的に決める習慣をつけましょう。

例えば、「午前10時から30分間、企画書の構成案を作成するために使う」「メールの返信文を3パターン考えてもらうために、15分だけ使う」といった形です。

そして、決めた時間が来たら、途中であっても必ず利用を終了します。

タイマーをセットするなど、物理的な仕組みを取り入れるのも効果的です。

目的のないダラダラとした利用を防ぎ、「ツール」として意識的に使う感覚を取り戻すことが最初のステップです。

STEP2:まずは「自分で5分考える」ルールを作る

何か課題に直面した時、すぐにChatGPTに頼るのではなく、「まずは自分の力だけで5分間考えてみる」というルールを設けてみましょう。

この5分間は、たとえ答えが出なくても、何も思いつかなくても構いません。

重要なのは、自分の脳を使って思考を巡らせる「癖」を再びつけることです。

インターネットで検索したり、関連資料を読んだり、紙に書き出してみたりと、あらゆる方法を試してみてください。

5分間考え抜いた後でChatGPTを使えば、質問の質も格段に上がり、より深い回答を引き出せるようになります。

この小さな習慣が、失われた思考力を取り戻すための大きな一歩となります。

こちらは、最初に自力で課題に取り組むことが、その後のLLM利用の質とパフォーマンスを向上させることを示したMITの研究に関する考察記事です。合わせてご覧ください。

https://medium.com/design-bootcamp/cognitive-debt-what-i-learned-from-mits-paper-on-ai-and-brain-atrophy-dbb54f7f064a

STEP3:情報の裏付け(ファクトチェック)を習慣にする

ChatGPTの回答を鵜呑みにせず、必ず一次情報や信頼できる情報源にあたって裏付けを取ることを徹底しましょう。

例えば、ChatGPTが提示した統計データについては、官公庁のウェブサイトで元のデータを確認する。

歴史的な事実については、複数の百科事典や専門サイトでクロスチェックする。

このようなファクトチェックを習慣にすることで、AIの情報を批判的に見る目(クリティカルシンキング)が養われます。

面倒に感じるかもしれませんが、このプロセスは情報の真偽を見極める能力を高めるだけでなく、関連知識が深く身につくというメリットもあります。

AIを思考のショートカットではなく、リサーチの出発点として位置づけることが重要です。

STEP4:意識的にデジタルデトックスの時間を作る

ChatGPTはもちろん、スマートフォンやPCからも意識的に離れる「デジタルデトックス」の時間を設けましょう。

例えば、通勤中はスマホを見ずに車窓の景色を眺める、週末の半日はデジタル機器に触らずに過ごす、寝る前の1時間は読書をするなど、自分に合った方法で構いません。

脳を情報過多の状態から解放し、リラックスさせる時間を作ることが目的です。

こうした時間を持つことで、ぼんやりと物事を考えたり、内省したりする機会が生まれます。

創造的なアイデアは、このようなリラックスした状態の時に生まれやすいと言われています。

常にAIと接続している状態から意識的に離れることで、自分自身の思考と向き合う時間を取り戻しましょう。

STEP5:一人で抱え込まず、周りの人や専門家に相談する

もし、自分の意志だけではChatGPTの利用をコントロールできないと感じるなら、一人で抱え込まずに周りの人に相談することも大切です。

信頼できる友人や同僚に、「最近ChatGPTを使いすぎている気がするんだ」と打ち明けてみるだけでも、客観的な意見がもらえたり、気持ちが楽になったりすることがあります。

また、依存の度合いが深刻で、日常生活に支障が出ていると感じる場合は、カウンセラーや心療内科などの専門家に相談することも選択肢の一つです。

依存は個人の意志の弱さの問題だけではありません。

適切なサポートを求めることは、決して恥ずかしいことではないのです。

依存ではなく活用へ!ChatGPTを「最強の相棒」にするための3つのルール

ChatGPTは、依存の対象として恐れるべきものではなく、正しく付き合えば私たちの能力を飛躍的に高めてくれる「最強の相棒」になり得ます。

依存から脱却し、AIを真に活用するために、心に留めておくべき3つのルールを紹介します。

ルール1:思考を深めるための「壁打ち相手」として使う

ChatGPTを「答えを教えてくれる先生」ではなく、「思考の壁打ち相手」として使いましょう。

まず自分の考えや仮説をしっかりと持った上で、それをChatGPTにぶつけてみるのです。

「私は〇〇について、△△だと考えているのですが、この意見に対する反論はありますか?」

「このアイデアの弱点は何だと思いますか?」

といった形で質問することで、自分一人では気づけなかった視点や、考えの甘さを指摘してもらうことができます。

あくまで思考の主役は自分自身。

AIを、自分の考えをより強固で洗練されたものにするための、優秀なディベートパートナーとして活用するのです。

こちらはAIを思考の壁打ち相手として活用するためのプロンプト例を紹介した記事です。 合わせてご覧ください。

ルール2:アイデア出しの「たたき台」として活用する

ゼロからイチを生み出すのは自分自身の役割ですが、アイデアを広げたり、具体化したりする過程でChatGPTを活用するのは非常に有効です。

例えば、ブレインストーミングで行き詰まった際に、「このテーマで、常識外れのアイデアを10個出して」と依頼してみる。

出てきたアイデアがそのまま使えなくても、それが刺激となって新たな発想が生まれることがあります。

重要なのは、AIが出してきたアイデアを「完成品」と捉えるのではなく、あくまで発想をジャンプさせるための「たたき台」や「触媒」として利用することです。

この使い方をマスターすれば、ChatGPTはあなたの創造性を奪うどころか、むしろ増幅させてくれる存在になります。

こちらはChatGPTでブレインストーミングや企画立案を行うためのプロンプト集です。 合わせてご覧ください。

ルール3:あくまで「業務を効率化する補助ツール」と位置づける

最も根本的なルールは、ChatGPTを「思考の代替」ではなく、あくまで「業務を効率化するための補助ツール」と明確に位置づけることです。

文章の校正、プログラミングコードのデバッグ、膨大な資料の要約、外国語への翻訳など、ChatGPTには人間の思考を必要としない、あるいは定型的な作業を高速化する力があります。

こうした領域でChatGPTを積極的に活用し、時間や手間を削減する。

そして、そこで生み出された時間的・精神的な余裕を、企画立案や戦略策定、重要な意思決定といった、人間にしかできない創造的で付加価値の高い業務に集中投下するのです。

この線引きを常に意識することで、AIに仕事を奪われるのではなく、AIを使いこなし、より高いレベルの仕事をするという理想的な関係を築くことができます。

こちらはChatGPTの業務活用事例や成功の秘訣を網羅したガイド決定版の記事です。 合わせてご覧ください。

ChatGPT依存に関するよくある質問

最後に、ChatGPT依存に関して多くの方が疑問に思う点について、Q&A形式でお答えします。

1日に何時間以上使うと「依存」の可能性がありますか?

依存を判断する上で、利用時間の長さだけが絶対的な基準になるわけではありません。

例えば、プログラマーが業務時間中に長時間コード生成のために利用しているケースと、明確な目的なくSNSのように長時間利用しているケースでは、意味合いが全く異なります。

時間よりも重要なのは、「利用のコントロールができているか」「ChatGPTがないと強い不安を感じるか」「実生活に悪影響が出ているか」といった質的な側面です。

1日1時間しか使っていなくても、その1時間がないと仕事が全く手につかないのであれば、それは依存のサインかもしれません。

ご自身の利用目的と、利用がなくなった場合の影響を基準に判断することが大切です。

仕事でChatGPTが必須の場合、どのように依存を防げばよいですか?

業務上、ChatGPTの利用が不可欠な場合、依存を防ぐには「利用領域の明確化」が鍵となります。

「この作業はChatGPTに任せる」「この思考プロセスは必ず自分で行う」という線引きを、自分の中で、あるいはチーム内でルール化することが重要です。

例えば、情報収集やデータ整理といった作業はChatGPTで効率化し、そこから得られた情報をもとにした分析や考察、最終的な意思決定は必ず人間が行う、といった分担を徹底します。

また、意識的にChatGPTを使わない日や時間帯を設けて、自力で業務を完遂する訓練を積むことも有効です。

ツールに「使われる」のではなく、常に「使いこなす」という意識を持つことが、仕事での健全な共存につながります。

ChatGPT依存は、専門的な治療が必要な病気ですか?

現時点(2025年10月)で、「ChatGPT依存」が正式な病名として医学的に診断されることは一般的ではありません。

多くの場合、それは個人の習慣や行動パターンの問題として捉えられます。

ただし、ChatGPTへの依存が原因で、仕事に行けない、学業に集中できない、家族関係が悪化するなど、社会生活に深刻な支障をきたしている場合は注意が必要です。

その背景に、うつ病や不安障害といった他の精神的な問題が隠れている可能性も考えられます。

もし、自力でのコントロールが困難で、日常生活に大きな影響が出ていると感じる場合は、行動療法やカウンセリングが有効な場合もありますので、心療内科や精神科、カウンセリング機関などの専門家に相談することをお勧めします。

ChatGPTで賢くなる人と思考停止に陥る人の違いとは?

ChatGPTを日常的に利用しているあなたは、その使い方で自身の能力を高められているでしょうか。使い方を誤ると、私たちの脳は次第に思考を放棄してしまうかもしれません。

マサチューE工科大学(MIT)の研究が、その危険性を示唆しています。しかし、東京大学などの研究機関では、ChatGPTを思考を鍛えるためのツールとして活用し、能力を向上させる方法が実践されています。ここでは、思考停止に陥る人と賢くなる人の分岐点を、最新の研究結果と具体的なテクニックを交えて解説します。

ChatGPTは脳の活動を低下させるかもしれない

「ChatGPTに任せれば、自分で考えずに済む」と感じているなら、それは危険な兆候かもしれません。MITの研究によれば、ChatGPTの支援を受けて文章を作成した人は、自力で取り組んだ人に比べて脳の認知活動が大幅に低下することが明らかになりました。

これは、考えるプロセスをAIに委ねてしまう「思考の外部委託」が起きていることを示しています。この状態が続くと、以下のようなリスクが考えられます。

- 深く考察する能力の衰え:AIの回答をそのまま受け入れ、批判的に検討する力が鈍る。

- 記憶の定着率の低下:簡単に入手した情報は、脳に記憶されにくい。

- 発想力の減退:脳が自らアイデアを生み出すことをやめてしまう。

便利なツールに頼ることで、無意識のうちに本来の思考力が失われていく可能性があるのです。

引用元:

MITの研究チームは、大規模言語モデル(LLM)が人間の認知プロセスに与える影響を調査しました。その結果、LLMを利用したライティング作業では、人間の脳活動が著しく低下することが示されました。(Shmidman, A., Sciacca, B., et al. “Does the use of large language models affect human cognition?” 2024年)

AIを思考力を鍛えるパートナーにする方法

では、賢くなる人はChatGPTをどのように活用しているのでしょうか。彼らはAIを答えを出す機械ではなく、思考を深めるためのパートナーとして扱っています。誰でも今日から実践できる3つの賢い使い方を紹介します。

使い方①:優秀な壁打ち相手にする

自身の考えをより強固にするためには、異なる視点からの意見が不可欠です。そこで、ChatGPTにあえて反対意見を述べる役割を与えましょう。

プロンプト例:

「(あなたの企画や意見)について、あなたが優秀なコンサルタントの視点から見た場合、どのような弱点が考えられますか?最も鋭い反論を3つ挙げてください。」これにより、一人では見つけられなかった思考の盲点を発見し、論理をより強固にできます。

使い方②:何も知らない生徒役として教える

テーマへの理解度を試すには、他者に説明してみることが最も効果的です。ChatGPTを専門知識のない生徒役として設定し、あなたが先生の立場で教えてみましょう。

プロンプト例:

「これから『(あなたが学びたいテーマ)』について説明します。あなたは何も知らない高校生として、私の説明で理解しにくい点があれば、遠慮なく質問してください。」AIからの素朴な質問に答える過程で、自身の理解が曖昧な部分が明確になり、知識が体系的に整理されます。

使い方③:アイデアを創出するための触媒にする

ゼロからアイデアを求めるのは、思考停止への一歩です。そうではなく、自分のアイデアの種をAIに投げかけ、化学反応を引き起こすのです。

プロンプト例:

「『(テーマ)』に関する新しい企画を考えています。関連キーワードは『A』『B』『C』です。これらの要素を組み合わせて、今までにない斬新な切り口の企画案を5つ提案してください。」AIが提案した意外な組み合わせをヒントに、最終的なアイデアを磨き上げるのはあなた自身です。これにより、発想力が刺激され、創造性が向上します。

まとめ

企業ではChatGPTをはじめとする生成AIの活用が急速に進んでいますが、その一方で社員のAI依存による思考力低下や、シャドーITによる情報漏えいリスクといった新たな課題が浮上しています。

実際には「社員のスキル任せで統制が取れない」「何から始めれば安全に活用できるのかわからない」といった理由で、本格的な導入に踏み切れない企業も少なくありません。

そこでおすすめしたいのが、Taskhub です。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「何をどう使えばいいのかわからない」という初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプロンプトの知識や高度なAIリテラシーがなくても、すぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最速の生成AI活用”を体験し、御社のDXを一気に加速させましょう。