「ChatGPTから警告が表示されなくなったけど、何が変わったの?」

「警告がなくなったから、これからはどんな指示でも出していいのかな…。」

こういった疑問や不安を持っている方もいるのではないでしょうか?

本記事では、ChatGPTに以前表示されていた警告の役割から、オレンジと赤の警告の違い、そして警告が廃止された背景と今後の影響について詳しく解説します。

利用規約に違反すれば、警告なしでアカウントが停止される可能性も依然として存在します。安全に活用するためにも、ぜひ最後までご覧ください。

ChatGPTに表示されていた「警告」とは?廃止前の基本を解説

まずは、ChatGPTに以前実装されていた警告システムが、どのような役割を担っていたのかを振り返ります。

このシステムは、ユーザーの安全な利用を促すための重要な機能でした。

ユーザーの利用を制御する警告の役割

ChatGPTに搭載されていた警告システムは、ユーザーがOpenAIの利用規約やコンテンツポリシーに違反する可能性のあるプロンプト(指示)を入力した際に、注意を促す役割を持っていました。

この警告は、不適切なコンテンツの生成を防ぎ、ユーザーを意図しない規約違反から守るためのセーフティネットとして機能していました。

例えば、暴力的、差別的、または法的に問題のあるコンテンツの生成をリクエストした場合に警告が表示され、ユーザーに自らの指示を見直す機会を与えていました。

危険度が異なる「オレンジ警告」と「赤警告」

警告システムには、違反の深刻度に応じて2種類の警告が存在していました。それが「オレンジ警告」と「赤警告」です。

オレンジ警告は、比較的軽微な違反の可能性がある場合に表示される注意喚起でした。

一方で、赤警告はより深刻な違反、または繰り返し違反が行われた場合に表示され、アカウント停止などの厳しい措置につながる可能性を示唆するものでした。

この2段階のシステムにより、ユーザーは自身の入力した内容の危険度を直感的に理解することができました。

警告の対象となっていた行為の具体例

警告の対象となる行為は、OpenAIの利用規約で定められている禁止事項に準じていました。

具体的には、ヘイトスピーチ、ハラスメント、暴力の助長、マルウェアの生成、成人の身体的・性的な暴力描写、選挙活動や政治的キャンペーンに関するコンテンツ生成などが挙げられます。

これらの指示を直接的または間接的に入力した場合、システムがそれを検知し、警告を表示する仕組みでした。

ユーザーがこれらの具体例を認識することは、意図せず規約に違反してしまうリスクを避ける上で重要でした。

【比較】オレンジ警告と赤警告の違いと危険性

ここでは、廃止された「オレンジ警告」と「赤警告」が具体的にどう異なり、それぞれどのような危険性を含んでいたのかを詳しく解説します。

- 注意喚起が目的だった「オレンジ警告」

- アカウント停止の危険があった「赤警告」

- それぞれの警告への当時の対処法

これらの違いを理解することで、なぜ警告システムがユーザーにとって重要だったのかが見えてきます。

それでは、1つずつ順に解説します。

注意喚起が目的だった「オレンジ警告」

オレンジ警告は、ユーザーの入力したプロンプトが利用規約に抵触する可能性があるとAIが判断した場合に表示される、比較的軽度な注意喚起でした。

その主な目的は、ユーザーに「その指示は不適切かもしれない」と知らせ、自主的な修正を促すことにありました。

例えば、少し過激な表現や、文脈によっては問題となりうるグレーな指示に対して表示されることが多かったようです。

この段階では即座にアカウントが停止される危険性は低いものの、警告を無視して同様の指示を続けると、より深刻な赤警告へと発展する可能性がありました。

アカウント停止の危険があった「赤警告」

赤警告は、オレンジ警告よりもはるかに深刻な違反行為に対して表示される、最後の警告でした。

利用規約に明確に違反する内容、例えば、差別的なコンテンツの生成や、違法行為を助長するような指示を意図的に入力した場合に表示されます。

この警告は、アカウントが永久に停止(BAN)される一歩手前の最終通告であり、極めて高い危険性を持っていました。

赤警告を受けたユーザーは、OpenAIの利用を継続したければ、自身の利用方法を根本的に見直す必要がありました。

それぞれの警告への当時の対処法

オレンジ警告が表示された場合の最も安全な対処法は、入力したプロンプトを見直し、規約に抵触する可能性のある部分を修正することでした。

警告を単なる注意と軽視せず、自身の指示内容を再評価する機会と捉えることが重要でした。

一方、赤警告が表示された場合は、即座に問題のある利用を中止する必要がありました。

その上で、万が一誤解やシステムのエラーで警告が表示されたと感じた場合は、OpenAIのサポートに連絡し、状況を説明するという選択肢もありましたが、基本的には自身の利用方法に重大な問題があったと認識すべき状況でした。

ChatGPTの警告が廃止された理由と公式発表の背景

突然とも思える警告システムの廃止。その背景には、OpenAIのどのような判断や社会的な議論があったのでしょうか。

ここでは、警告廃止に至った理由と公式発表の内容について掘り下げていきます。

OpenAIによる利用制限緩和の発表

OpenAIは、ユーザーがより自由にAIと対話できるよう、利用制限を緩和する方針を打ち出しています。

警告システムの廃止も、この大きな流れの一環と見られています。

過度な制限は、創造的なアイデアの探求や、有益な情報の発見を妨げる可能性があるため、OpenAIはより柔軟な利用を許容する方向に舵を切ったと考えられます。

ただし、これは「何をしても良い」という許可ではなく、あくまでも良識の範囲内での自由度を高めるための措置です。

警告廃止に至った背景とは?

警告廃止の背景には、いくつかの要因が考えられます。

一つは、従来の警告システムが、文化的な背景や文脈の違いによって、必ずしも適切に機能していなかった可能性です。

ある文化圏では問題ないとされる表現が、別の文化圏では不適切と判断され、警告の対象となるケースもありました。

また、AIの検閲能力が向上し、不適切な出力を警告なしでブロックしたり、無害化したりする技術が進歩したことも、警告システムが不要と判断された一因かもしれません。

AIの倫理と中立性を巡る議論

AIの倫理や中立性は、世界中で活発に議論されているテーマです。

特定の価値観に基づいてAIがコンテンツを「検閲」することへの批判も少なくありません。

警告システムの廃止は、AIが特定の思想に偏ることを避け、より中立的なツールであるべきだという考え方を反映した動きと捉えることもできます。

ユーザーに判断を委ねる部分を増やすことで、AIの役割を「人間の能力を拡張するツール」という本来の立ち位置に戻そうとする意図があるのかもしれません。

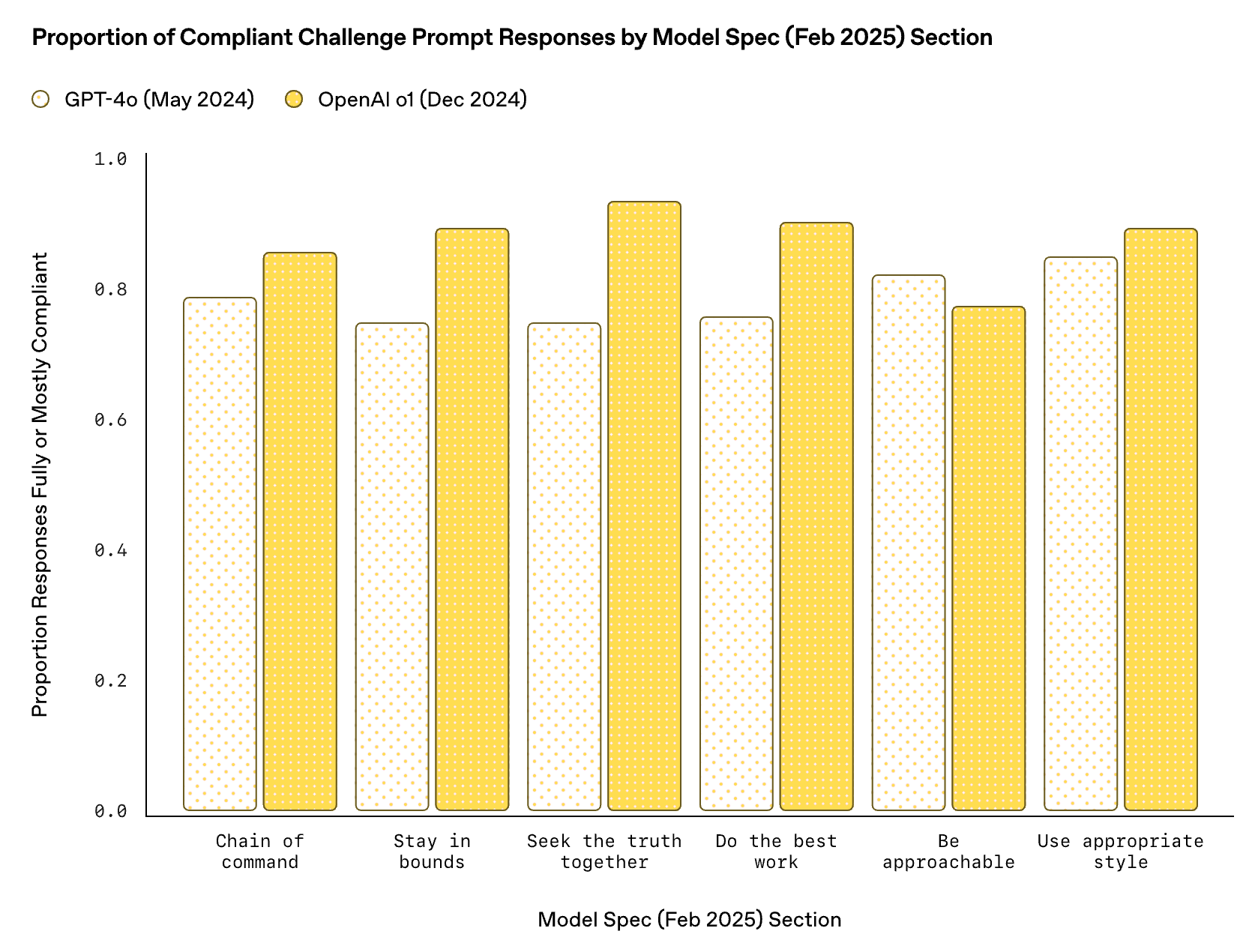

こちらは、OpenAIがモデルの振る舞いの指針として公開した「Model Spec」に関する記事です。警告廃止の背景にある、AIの自由と安全性のバランスに関する彼らの考え方を深く理解できます。 https://openai.com/index/sharing-the-latest-model-spec/

警告廃止で何が変わる?ユーザーへの具体的な影響

警告システムがなくなったことで、私たちユーザーのChatGPTの使い方はどう変わるのでしょうか。

ここからは、利用制限が緩和されたことによるメリットと、それに伴う新たなリスクについて解説します。

利用制限が緩和されたことによるメリット

最大のメリットは、表現の自由度が高まり、より幅広いテーマでChatGPTを活用できるようになったことです。

以前は警告が表示されそうで試せなかったような、創造的で実験的なプロンプトも入力しやすくなりました。

これにより、クリエイティブな文章作成、複雑な問題解決のアイデア出し、あるいはデリケートなトピックに関する議論のシミュレーションなど、ChatGPTの新たな可能性が広がるでしょう。

ユーザーは、AIの応答を恐れることなく、より深く、多角的に対話を進めることができます。

不適切なコンテンツ生成のリスクとデメリット

一方で、警告という「ガードレール」がなくなったことによるデメリットも存在します。

悪意のあるユーザーが、ヘイトスピーチやフェイクニュースなど、有害なコンテンツを以前よりも容易に生成できてしまうリスクが高まります。

また、意図せず不適切な言葉を使ってしまった場合でも、以前のように警告が表示されないため、気づかないうちに規約違反を犯してしまう可能性も考えられます。

ユーザー一人ひとりが、より高い倫理観とリテラシーを持ってAIを利用することが求められるようになります。

表現の自由はどこまで認められるのか

警告は廃止されましたが、表現の自由が無制限に認められるわけではありません。

OpenAIの利用規約には、引き続き禁止事項が明確に定められています。

例えば、他者を傷つける目的での利用や、違法行為への加担は固く禁じられています。

つまり、表現の自由は、他者の権利や安全を侵害しない範囲で認められるということです。

この境界線をユーザー自身が常に意識し、責任ある利用を心がける必要があります。システムによる警告がなくなった今、その判断は完全にユーザーに委ねられています。

警告廃止後も要注意!アカウントBAN(停止)の危険性は残る?

「警告が出ないなら、もうアカウント停止の心配はない?」と考えるのは早計です。

警告システムの廃止は、利用規約の廃止を意味するものではありません。

ここでは、警告がなくてもアカウントが停止されるケースと、安全な利用を続けるためのポイントを解説します。

警告がなくても利用規約は遵守する必要がある

警告システムは廃止されましたが、その土台であるOpenAIの利用規約は依然として有効です。

ユーザーは、ChatGPTを利用する上で、この規約を遵守する義務があります。

警告が表示されなくなったからといって、規約違反が許されるわけではありません。

むしろ、事前の注意喚起なしに、違反が発覚した時点で直接的なペナルティが科される可能性が高まったと考えるべきです。

規約を再確認し、禁止されている行為を正しく理解しておくことが、これまで以上に重要になります。

現在もアカウント停止につながる禁止事項

現在もアカウント停止の対象となるのは、利用規約で明確に禁止されている行為です。

具体的には、違法行為(薬物、武器など)の助長、児童の性的虐待に関連するコンテンツ、ヘイトスピーチやハラスメント、自傷行為の推奨、マルウェアの生成などが含まれます。

これらの禁止事項に違反するプロンプトを入力した場合、OpenAIは事前の警告なしにアカウントを停止する権利を持っています。

警告がなくなったことで、違反行為への対処がより厳格になったと認識しておく必要があります。

安全にChatGPTを使い続けるためのポイント

安全にChatGPTを利用し続けるためには、まず第一にOpenAIの最新の利用規約に目を通し、禁止事項を正確に把握することが不可欠です。

その上で、自身のプロンプトが他者を傷つけたり、社会的に有害な影響を与えたりする可能性がないか、常に自問自答する習慣をつけましょう。

少しでも不安に感じたり、倫理的に問題があるかもしれないと感じたりした場合は、その指示を送信する前に一度立ち止まって考えることが重要です。

良識と倫理観に基づいた利用こそが、アカウントを守る最も確実な方法です。

こちらはOpenAIが公式に定めている利用規約です。警告の有無にかかわらず、すべてのアクティビティの土台となるルールですので、改めてご確認ください。 https://openai.com/policies/usage-policies/

コンテンツ制作やSEOへの影響は?

警告システムの廃止は、日々の業務でChatGPTを活用しているコンテンツ制作者やSEO担当者にとっても無視できない変化です。

この変更が、今後のコンテンツ制作やSEO戦略にどのような影響を与える可能性があるのかを探ります。

コンテンツ生成の自由度向上と活用の幅

警告がなくなったことで、コンテンツ制作者はより大胆で多様なテーマのコンテンツをAIに生成させることができるようになります。

これまで扱いにくかった社会問題や、意見が分かれるトピックについても、より深い議論を含む記事を作成しやすくなるかもしれません。

ニッチなキーワードや、複雑な背景を持つテーマに対するSEOコンテンツの作成など、活用の幅は格段に広がるでしょう。

これにより、ユーザーの多様な検索意図に応える、質の高いコンテンツの量産が加速する可能性があります。

AI生成コンテンツにおける正確性と信頼性の重要度

自由度が高まる一方で、生成されるコンテンツの正確性と信頼性を担保する責任は、すべてコンテンツ制作者側にのしかかります。

AIは事実に基づかない情報(ハルシネーション)を生成することがあり、警告がなくなったことで、誤った情報がそのまま世に出てしまうリスクは増大します。

生成されたコンテンツは必ずファクトチェックを行い、信頼できる情報源で裏付けを取ることが不可欠です。

Googleなどの検索エンジンは、情報の正確性や信頼性(E-E-A-T)を重視しているため、この点を怠るとSEO評価の低下に直結します。

こちらはAIのハルシネーションを防ぐプロンプトについて解説した記事です。合わせてご覧ください。

https://taskhub.jp/use-case/chatgpt-prevent-hallucination/

今後のSEO対策で求められる新たな視点

今後のSEO対策では、AIをいかに賢く、そして倫理的に使いこなすかという視点がより重要になります。

単にAIに記事を量産させるだけでは、長期的には評価されなくなるでしょう。

AIの生成した下書きに、人間ならではの独自の視点、経験、専門的な知見を加え、コンテンツに深みと付加価値を与えることが求められます。

また、AIが生成したありきたりな内容ではなく、ユーザーの潜在的な悩みや課題を解決するような、質の高いコンテンツを企画・編集する能力が、SEO担当者の新たなスキルとして重要性を増してきます。

ChatGPTの警告廃止に関するよくある質問

最後に、ChatGPTの警告廃止に関して多くの人が抱くであろう質問とその回答をまとめました。

疑問点を解消し、今後の利用に役立ててください。

警告がなくなったら、どんな指示でも出していいの?

いいえ、どんな指示でも出して良いわけではありません。

警告システムはなくなりましたが、OpenAIの利用規約は引き続き適用されます。

ヘイトスピーチ、違法行為の助長、暴力的なコンテンツの生成など、規約で禁止されている行為は、警告なしにアカウント停止などの厳しい措置の対象となります。

良識の範囲を超えた利用は避けるべきです。

過去に受けた警告はアカウントに影響しますか?

過去に受けた警告が、今後のアカウントに直接的な影響を与える可能性は低いと考えられます。

警告システム自体が廃止されたため、過去の警告履歴を基に新たなペナルティが科されることは通常ないでしょう。

ただし、繰り返し規約違反を行っていたユーザーとして記録が残っている可能性はゼロではありません。

今後はより一層、規約を遵守したクリーンな利用を心がけることが賢明です。

今後、警告システムが復活する可能性はありますか?

将来的に警告システムが何らかの形で復活する可能性はあります。

AIの利用を巡る社会的な議論や法規制の動向、あるいは有害なコンテンツ生成のリスクが顕著に増大した場合など、OpenAIが方針を変更する可能性は常にあります。

AIに関するルールは日々変化しているため、利用者は常に最新の利用規約やOpenAIからの公式発表に注意を払う必要があります。

ChatGPT警告廃止は“罠”か?「自由な利用」の裏に潜むアカウント停止リスクとは

「ChatGPTから警告が消えた。これで本当に自由になったのか?」——。もしあなたがそう考えているなら、その安心は少し危険かもしれません。警告システムの廃止は、一見すると表現の自由度が高まったように思えますが、実は気づかぬうちに利用規約に違反し、ある日突然アカウントを失うリスクを高めている可能性があるのです。この記事では、なぜ警告が廃止されたのか、その背景にあるOpenAIの思惑と、これからの時代に必須となる「賢い」付き合い方を、どこよりも分かりやすく解説します。警告というガードレールがなくなった今、あなたのアカウントを守る知識は、もはや他人事ではありません。

【警告】ガードレールなき高速道路:警告廃止後のChatGPT

ChatGPTからオレンジや赤の警告が消えたことは、いわば高速道路からガードレールが撤去されたようなものです。よりスムーズで自由な対話が可能になった一方で、一度ハンドルを切り間違えれば、重大な結果につながる危険性をはらんでいます。

これまでは、不適切な指示を出すとシステムが「その先は危険です」と教えてくれました。しかし今、その役割は完全にユーザー自身の倫理観と知識に委ねられています。この変化がもたらすリスクは以下の通りです。

- 意図しない規約違反: 以前なら警告が出たようなグレーな表現も、今はそのまま通ってしまいます。これが積み重なり、ある日突然アカウント停止の対象となる可能性があります。

- 有害コンテンツ生成のハードル低下: 悪意のあるユーザーが、警告という抑止力なしに、より容易にフェイクニュースやヘイトスピーチなどを生成できてしまう危険性があります。

- 責任の所在の明確化: 警告がなくなったことで、「知らなかった」という言い訳は通用しなくなります。生成されたコンテンツに対する責任は、すべてユーザーが負うことになります。

便利なツールの自由度が増した裏側で、私たちの自己責任は、かつてなく重くなっているのです。

引用元:

OpenAIは、利用規約(Terms of Use)において、ヘイトスピーチ、ハラスメント、違法行為の助長などを明確に禁止しています。警告システムの廃止はこれらの規約の廃止を意味するものではなく、ユーザーは自身の利用方法が規約に準拠しているかを確認する責任を負います。(OpenAI. “Terms of Use” 2024年)

【実践】アカウントを守り、AIを最大限に活用する新常識

では、「賢くなる人」は、この新しい環境でChatGPTをどう使いこなしているのでしょうか。彼らはAIを単なる「便利な道具」ではなく、「責任を伴う強力なツール」として捉え、自衛策を講じています。ここでは、誰でも今日から実践できる3つの新常識をご紹介します。

新常識①:利用規約を「自分のルール」として再解釈する

OpenAIの利用規約をただ読むだけでなく、「自分の業務や創作活動において、具体的にどのラインを超えたら危ないか」という自分だけのガイドラインに落とし込みましょう。

魔法のプロンプト例:

「あなたはOpenAIのポリシー担当者です。私が『(あなたの業務内容や企画)』についてコンテンツを作成する上で、利用規約に抵触する可能性がある点を、具体的な例を挙げて3つ指摘してください。」

これにより、抽象的な規約を自分事として理解し、無意識の違反を防ぐことができます。

新常識②:あえて「倫理チェック」をAIに依頼する

自分が作成したプロンプトやAIが生成した文章が、社会的に見て問題がないか、客観的な視点で確認させましょう。

魔法のプロンプト例:

「以下の文章を読んで、倫理的な観点、多様性への配慮、潜在的な誤解を招く表現がないかを確認し、改善点を提案してください。『(AIが生成した、あるいはあなたが作成した文章)』」

AIにAIをチェックさせることで、自分では気づきにくい表現の偏りやリスクを発見できます。

新常識③:事実確認(ファクトチェック)をプロセスに組み込む

警告廃止により、AIが生成する誤情報(ハルシネーション)がそのまま世に出てしまうリスクが高まります。AIの回答は「仮説」と捉え、必ず信頼できる情報源で裏付けを取る習慣をつけましょう。

魔法のプロンプト例:

「『(AIの回答)』について、その情報の根拠となる主要な情報源や、信頼できる統計データへのリンクを3つ提示してください。」

AIに情報源を尋ねることで、ファクトチェックの第一歩とし、コンテンツの信頼性を担保する力が鍛えられます。

こちらはChatGPTのプロンプト形式について解説した記事です。合わせてご覧ください

https://taskhub.jp/use-case/chatgpt-prompt-format/

まとめ

ChatGPTの警告が廃止され、AI活用の自由度が高まる一方で、意図しない規約違反によるアカウント停止リスクや、生成されるコンテンツの品質管理といった新たな課題が浮上しています。企業にとってはAI活用の好機ですが、「どこまでの利用が安全か」というガイドラインが不明確なため、社員の不適切な利用を懸念し、本格的な導入に踏み出せないケースも少なくありません。

そこでおすすめしたいのが、Taskhub です。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「何をどう使えばいいのかわからない」という初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプログラミングや高度なAI知識がなくても、すぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最速の生成AI活用”を体験し、御社のDXを一気に加速させましょう。