「ChatGPTは便利だけど、入力した内容が他人に見られることはないの?」

「会社でChatGPTを使いたいけれど、情報漏洩のリスクが怖くて導入に踏み切れない…。」

こういった悩みや不安を抱えている方も多いのではないでしょうか?

本記事では、ChatGPTで入力した内容が見られる可能性やその具体的なケース、そして情報漏洩を未然に防ぐための具体的な対策について、網羅的に解説します。

個人での利用はもちろん、企業で安全に活用するためのポイントまで、誰にでも分かりやすく説明していきます。

この記事を最後まで読めば、ChatGPTの情報漏洩リスクを正しく理解し、安心して活用するための具体的な知識が身につきます。

結論:ChatGPTの内容が見られる可能性と情報漏洩リスク

まず結論からお伝えすると、特別な対策を講じない限り、ChatGPTに入力した内容が見られたり、情報漏洩に繋がったりするリスクは存在します。

このリスクは、主に「AIの学習データとしての利用」と「第三者による不正アクセス」の2つの側面から考える必要があります。

これらのリスクを正しく理解することが、安全な利用への第一歩です。

入力した内容はAIの学習に使われる可能性がある

ChatGPTを運営するOpenAIは、ユーザーが入力したデータを、AIモデルの性能向上や品質改善のための学習データとして利用する可能性があることを公表しています。

つまり、あなたが入力した会話の内容が、ChatGPTの知識の一部として取り込まれるかもしれないということです。

もし、業務上の機密情報や個人のプライバシーに関わる情報を入力してしまった場合、それが意図せずAIに学習され、将来的に他のユーザーへの回答として出力されてしまう可能性はゼロではありません。

なぜAIが入力データを学習に利用するのか、その仕組みや言語モデルについては、こちらの記事でさらに詳しく解説しています。合わせてご覧ください。

第三者にチャット履歴が見られる危険性

ChatGPTとのやり取りは、OpenAIのサーバーに保存されています。

通常、この履歴はあなたのアカウントからしか閲覧できませんが、悪意のある第三者によるサイバー攻撃や不正アクセスによって、サーバーから情報が盗み出される危険性があります。

また、後述する事例のように、システムのバグが原因で、全く関係のない他人のチャGット履歴が閲覧可能になってしまったという事件も過去に発生しています。

このように、自分自身に落ち度がなくても、外部の要因によって情報が漏洩するリスクも考慮しなければなりません。

ChatGPTを企業で安全に導入し、情報漏洩リスクを回避するための方法については、こちらの企業向け導入ガイドで詳しく解説しています。合わせてご覧ください。

ChatGPTの内容が見られる3つのケースとは?

それでは、具体的にどのような状況でChatGPTの内容が見られてしまうのでしょうか。

ここでは、情報漏洩に繋がる代表的な3つのケースについて解説します。

- 入力した個人情報・機密情報が流出する

- チャット履歴の情報が流出する

- アカウント情報が流出する

これらのケースをあらかじめ知っておくことで、事前に対策を立てることができます。

一つずつ見ていきましょう。

ケース①:入力した個人情報・機密情報が流出する

最も注意すべきなのが、入力した情報そのものが流出するケースです。

例えば、顧客リストや新製品の開発情報、社外秘の資料などをChatGPTに要約させたり、分析させたりしたとします。

これらの情報は、前述の通りAIの学習データとして利用される可能性があります。

学習データとして取り込まれた情報が、どのような形で他のユーザーへの回答に影響するかは完全には予測できません。

断片的な情報であっても、他の情報と組み合わせることで機密情報が推測されてしまうリスクがあり、ビジネスに深刻なダメージを与える可能性があります。

ケース②:チャット履歴の情報が流出する

OpenAIのサーバーに保存されているチャット履歴が、外部に流出するケースも考えられます。

過去には、システムの不具合により、一部のユーザーが他のユーザーのチャット履歴のタイトルを閲覧できてしまうという問題が発生しました。

この時はタイトルのみの表示でしたが、もし本文まで閲覧できるようなバグが発生していたら、より深刻な情報漏洩に繋がっていたでしょう。

また、外部からのサイバー攻撃によってサーバー内のデータが盗まれ、チャット履歴が丸ごと流出するというシナリオも十分に考えられます。

ケース③:アカウント情報が流出する

ChatGPTのアカウント情報(メールアドレスやパスワード)が流出し、アカウント自体が乗っ取られてしまうケースです。

原因としては、他のサービスからのパスワードの使い回しや、フィッシング詐欺、マルウェアへの感染などが挙げられます。

アカウントが乗っ取られると、過去の全てのチャット履歴を自由に見られてしまいます。

もし、そこに個人情報や会社の機密情報に関するやり取りが含まれていれば、その全てが第三者の手に渡ってしまうことになり、非常に危険です。

ChatGPTで内容を見られるのを防ぐ!履歴オフの鉄壁設定

ChatGPTの内容が見られるリスクを手軽かつ効果的に下げる方法が、「チャット履歴と学習」機能をオフにすることです。

この設定を行うと、あなたの会話はAIの学習に使われなくなり、履歴にも保存されなくなります。

ここでは、PCブラウザ版とスマホアプリ版、それぞれの設定手順を画像付きで分かりやすく解説します。

【PCブラウザ版】履歴をオフにする設定手順

PCのブラウザでChatGPTを利用している場合、以下の手順で設定を変更できます。

- 画面左下のアカウント名をクリックし、「Settings」を選択します。

- 設定画面が開いたら、左側のメニューから「Data controls」を選びます。

- 「Chat history & training」という項目のトグルスイッチをクリックしてオフ(灰色)にします。

この設定を一度行えば、それ以降の会話は履歴に残らず、AIの学習にも利用されません。

非常に簡単な設定なので、情報漏洩が心配な方は必ず行っておきましょう。

【スマホアプリ版】履歴をオフにする設定手順

スマートフォンアプリ版のChatGPTでも、同様の設定が可能です。

- 画面左上のメニューアイコン(三本線)をタップし、画面下部のアカウント名をタップします。

- アカウント設定画面から「Data Controls」を選択します。

- 「Chat History & Training」のトグルスイッチをタップしてオフにします。

移動中や外出先でChatGPTを利用することが多い方は、アプリ版の設定も忘れずに確認しておくことをおすすめします。

PC版とアプリ版の設定は連動していないため、それぞれで設定が必要です。

ChatGPTで内容を見られるのを防ぐ設定のデメリットは?

チャット履歴をオフにする設定は、セキュリティを高める上で非常に有効ですが、いくつかのデメリットも存在します。

便利な機能が一部使えなくなるため、メリットとデメリットを理解した上で設定を判断することが大切です。

ここでは、主な2つのデメリットについて解説します。

履歴をオフにすると過去の会話が記録されない

最も大きなデメリットは、過去の会話履歴が一切保存されなくなることです。

履歴がオフになっている間の会話は、ブラウザを閉じたり、アプリを再起動したりすると消えてしまいます。

そのため、「前の指示を修正して、もう一度回答を生成してほしい」「数日前のあの会話を参考に、新しいアイデアを出したい」といった使い方ができなくなります。

過去の文脈を引き継いで連続した作業を行いたい場合には、不便に感じるでしょう。

生成された回答を後で使いたい場合は、別途メモ帳などにコピーしておく必要があります。

履歴なしでも質問への回答精度は変わらないのか?

履歴をオフにすることが、ChatGPTの基本的な回答精度そのものを直接低下させるわけではありません。

しかし、過去の会話の流れ(文脈)を踏まえた回答生成ができなくなるため、結果的に精度が落ちたと感じられる場面が出てきます。

例えば、最初に「マーケティングについて教えて」と質問し、次に「それを小学生にも分かるように説明して」と追加の指示を出す場合、履歴がオンであれば文脈を理解して回答してくれます。

しかし、履歴がオフの状態では、それぞれの質問が独立したものとして扱われるため、意図した回答を得るのが難しくなる可能性があります。

ChatGPTで内容を見られるのを防ぐためのセキュリティ対策9選

チャット履歴のオフ設定以外にも、ChatGPTを安全に利用するためには、多角的なセキュリティ対策が重要です。

ここでは、個人から法人まで、誰でも実践できる9つの具体的な対策を紹介します。

- 機密情報や個人情報を入力しない

- チャット履歴をOFFにする(オプトアウト)

- パスワードを定期的に更新する

- 二段階認証を設定する

- 不審なメールやリンクを開かない

- 従業員向けの利用ルールを作成する

- ChatGPT API版やEnterpriseプランを利用する

- ChatGPT搭載の別サービスを利用する

- Azure OpenAI Serviceを利用する

これらの対策を組み合わせることで、情報漏洩のリスクを大幅に低減できます。

対策①:機密情報や個人情報を入力しない

最も基本的かつ重要な対策は、そもそも機密情報や個人情報をChatGPTに入力しないことです。

氏名、住所、電話番号、クレジットカード番号、マイナンバーなどの個人情報や、会社の財務データ、顧客情報、技術情報といった機密情報は、絶対に入力しないように徹底しましょう。

どんなにセキュリティ対策を施しても、リスクを完全にゼロにすることはできません。

「漏洩したら困る情報は入力しない」という原則を常に意識することが、自分自身や会社を守る上で最も確実な方法です。

対策②:チャット履歴をOFFにする(オプトアウト)

先ほど詳しく解説した「チャット履歴と学習」機能をオフにする設定です。

これにより、入力したデータがOpenAIのAIモデル学習に利用されることを防げます(オプトアウト)。

会話の履歴も保存されなくなるため、万が一アカウントが不正アクセスされた場合でも、過去のやり取りを見られる心配がありません。

情報漏洩のリスクを最小限に抑えたいのであれば、この設定は必須と言えるでしょう。

ただし、過去の会話を振り返れないというデメリットも理解しておく必要があります。

対策③:パスワードを定期的に更新する

ChatGPTのアカウントを保護するために、パスワードを定期的(例えば3ヶ月に1回など)に更新することが推奨されます。

また、パスワードは他のサービスで使っているものとは異なる、ユニークで複雑なものを設定しましょう。

英大文字、小文字、数字、記号を組み合わせ、12文字以上の長さにすると、セキュリティ強度が高まります。

これにより、万が一他のサービスからパスワードが漏洩した場合でも、ChatGPTのアカウントが不正利用されるリスクを低減できます。

対策④:二段階認証を設定する

二段階認証は、パスワードに加えて、スマートフォンアプリなどで生成される一時的な確認コードの入力を求めることで、セキュリティを大幅に強化する仕組みです。

これを設定しておけば、万が一パスワードが第三者に知られてしまったとしても、本人以外はアカウントにログインすることができなくなります。

ChatGPTでも二段階認証の設定が可能です。

Google AuthenticatorやMicrosoft Authenticatorなどの認証アプリを利用して設定できますので、必ず有効にしておきましょう。

対策⑤:不審なメールやリンクを開かない

OpenAIやChatGPTを装ったフィッシング詐欺にも注意が必要です。

「アカウントがロックされました」「セキュリティ警告」といった件名で偽のメールを送りつけ、偽サイトに誘導してパスワードなどの情報を盗み取ろうとする手口です。

身に覚えのないメールや、少しでも怪しいと感じるリンクは絶対に開かないようにしましょう。

公式サイトにアクセスする際は、メールのリンクからではなく、ブックマークや検索エンジンからアクセスする習慣をつけることが大切です。

対策⑥:従業員向けの利用ルールを作成する

企業でChatGPTを利用する場合は、従業員全員が安全に使えるように、明確なガイドラインや利用ルールを策定することが不可欠です。

ルールには、入力してはいけない情報(個人情報、顧客情報、機密情報など)の具体例を明記しましょう。

また、利用目的の範囲を定めたり、定期的にセキュリティに関する研修を実施したりすることも重要です。

ルールを定めることで、従業員のセキュリティ意識を高め、不用意な情報漏洩のリスクを防ぐことができます。

対策⑦:ChatGPT API版やEnterpriseプランを利用する

よりセキュリティレベルの高い環境でChatGPTを利用したい法人向けには、API版やEnterpriseプランという選択肢があります。

これらのサービスでは、入力したデータがAIの学習に利用されることはないと明言されています。

特にEnterpriseプランでは、企業のセキュリティ基準に合わせた高度な管理機能やデータ暗号化が提供されており、安心して業務に活用できます。

通常の無料版やPlusプランとは異なり、組織単位での利用を前提とした設計になっているため、ガバナンスを効かせやすいのが特徴です。

ChatGPTの企業向けプラン(Enterpriseなど)の料金やセキュリティ、他のプランとの違いについては、こちらの記事で徹底解説しています。合わせてご覧ください。

対策⑧:ChatGPT搭載の別サービスを利用する

最近では、ChatGPTの技術を組み込みつつ、独自のセキュリティ対策を施した様々なサービスが登場しています。

これらのサービスは、特定の業務(例えば、議事録作成、メール文面作成など)に特化していることが多く、入力したデータが二次利用されないことを明確に謳っている場合があります。

自社の利用目的に合ったサービスを選定することで、利便性と安全性を両立させることが可能です。

導入を検討する際は、サービスのプライバシーポリシーやデータ取り扱いに関する規約をしっかりと確認しましょう。

対策⑨:Azure OpenAI Serviceを利用する

Microsoftが提供するAzure OpenAI Serviceは、最高レベルのセキュリティ環境でChatGPTなどのOpenAIモデルを利用できる法人向けクラウドサービスです。

Microsoft Azureの堅牢なセキュリティ基盤上で運用されており、入力データは完全にプライベートな環境で保護され、AIの学習に利用されることはありません。

金融機関や医療機関など、特に高いセキュリティ要件が求められる業界でも採用実績が豊富です。

企業として本格的に生成AIの活用を進める上で、情報漏洩のリスクを極限まで抑えたい場合に最も有力な選択肢となります。

【実例】ChatGPTの内容が見られることで起きた情報漏洩事例3選

ChatGPTの利用に伴う情報漏洩は、決して他人事ではありません。

実際に、世界中の企業や個人が関わるインシデントがいくつか発生しています。

ここでは、代表的な3つの事例を紹介し、リスクの現実性を具体的に見ていきましょう。

事例①:サムスン電子での社内機密情報流出

韓国の大手電機メーカーであるサムスン電子で、従業員が業務でChatGPTを利用した際に、社内の機密情報が流出するという事件が発生しました。

報道によると、ある従業員は半導体設備の測定データを、別の従業員は製品の歩留まりに関するプログラムコードをChatGPTに入力してしまったとされています。

これらの情報はOpenAIのサーバーに送信され、AIの学習データとして利用された可能性があります。

この事件を受け、同社は社内でのChatGPT利用を原則禁止するなどの対策を講じました。

事例②:日本のアカウント情報の闇市場での売買

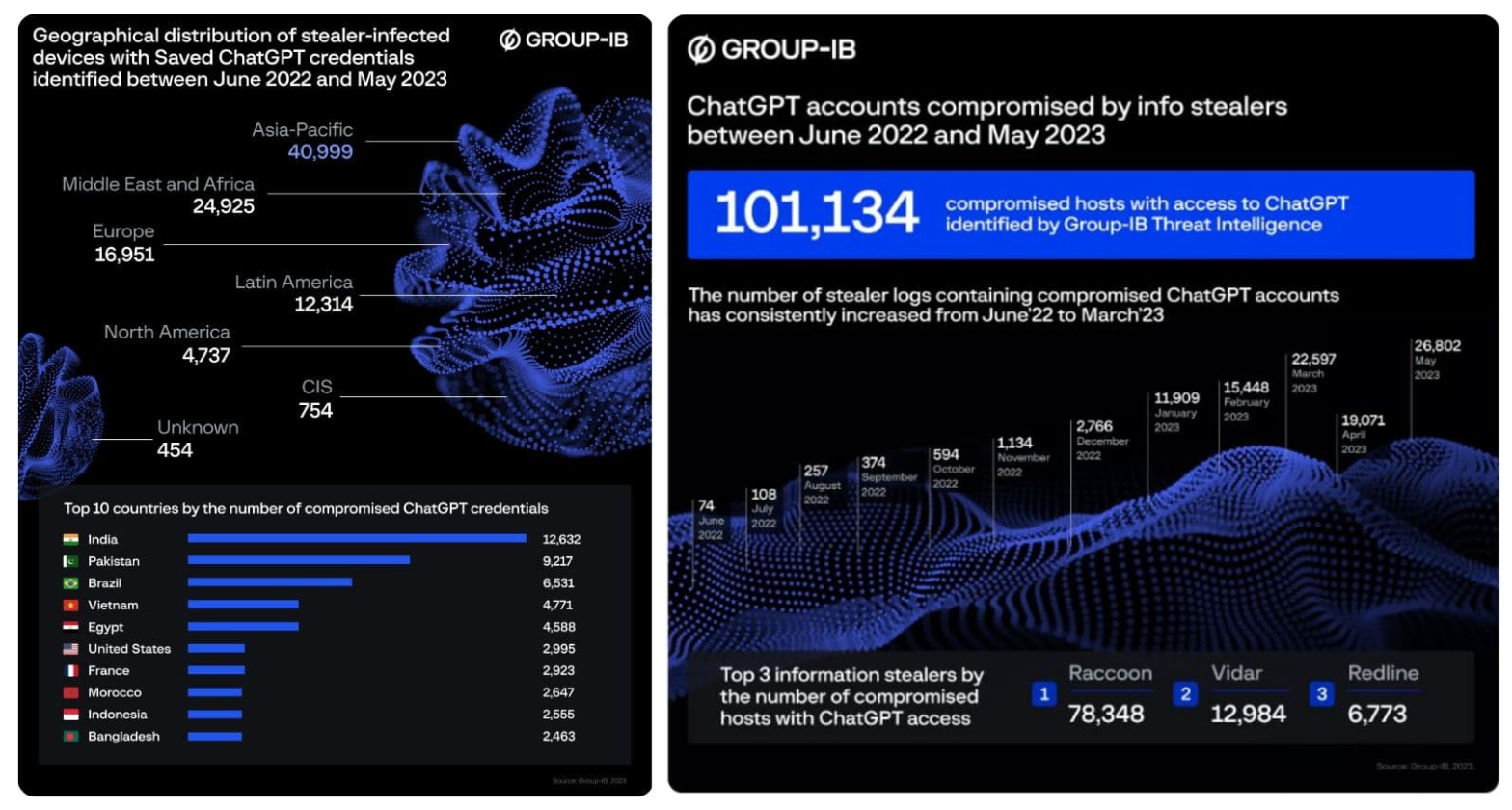

サイバーセキュリティ企業の調査により、マルウェアに感染したPCから盗み出された情報の中に、日本国内のユーザーを含む多数のChatGPTアカウント情報が含まれており、それらが闇市場(ダークウェブ)で売買されていたことが判明しました。

これはChatGPT自体の脆弱性ではなく、ユーザーのPCがウイルスに感染したことが原因です。

この事例は、パスワード管理や二段階認証の設定だけでなく、使用するデバイス自体のセキュリティ対策がいかに重要であるかを示しています。

こちらはセキュリティ企業Group-IBが調査した、10万件以上のChatGPTログイン情報がダークウェブで暴露された件に関するレポートです。合わせてご覧ください。 https://intigrow.com/dark-web-exposes-over-100000-chatgpt-login-credentials-cybersecurity-firm-reveals-disturbing-trend/

事例③:他ユーザーのチャット履歴が閲覧可能になったバグ

2023年3月、ChatGPTのシステムにバグが発生し、一部のユーザーのダッシュボードに、自分のものではない他人のチャット履歴のタイトルが表示されてしまうというインシデントがありました。

さらに、このバグの影響で、一部の有料プランユーザーの氏名やメールアドレス、クレジットカード番号の一部などの個人情報が閲覧可能になっていたことも後に判明しました。

OpenAIは迅速にシステムを一時停止し、バグを修正しましたが、サービス提供者側の問題によっても情報漏洩が起こりうることを示す象徴的な事例となりました。

会社でChatGPTの内容を見られるリスクと守るべきルール

これまで見てきたように、ChatGPTの業務利用には大きなメリットがある一方で、情報漏洩という重大なリスクが伴います。

特に企業においては、一度情報が漏洩すると、金銭的な損害だけでなく、社会的信用の失墜にも繋がりかねません。

ここでは、企業が安全にChatGPTを活用するために守るべきルールについて解説します。

業務利用における具体的な危険性

会社でChatGPTを利用する場合、従業員が誤って入力してしまう可能性のある情報には、以下のようなものが考えられます。

- 顧客情報:氏名、連絡先、購買履歴など

- 技術情報:設計図、ソースコード、未公開の特許情報など

- 財務情報:売上データ、経営戦略、M&A情報など

- 人事情報:従業員の個人情報、評価データなど

これらの機密情報がAIに学習されたり、アカウントの不正アクセスによって漏洩したりした場合、競合他社に知られて事業上の優位性を失う、顧客から損害賠償を請求されるなど、経営に深刻な打撃を与える可能性があります。

情報漏洩を防ぐための社内ガイドライン策定

企業として情報漏洩リスクを管理し、従業員を守るためには、明確な社内ガイドラインの策定が不可欠です。

ガイドラインには、少なくとも以下の項目を盛り込むべきでしょう。

- 利用目的の明確化:どのような業務に利用を許可するのかを具体的に定める。

- 入力禁止情報の定義:個人情報、顧客情報、社外秘情報など、入力してはいけない情報を具体的にリストアップする。

- アカウント管理規定:パスワードの強度や更新頻度、二段階認証の必須化などをルール化する。

- セキュリティ教育の実施:全従業員を対象に、情報漏洩リスクやガイドラインに関する研修を定期的に行う。

- 利用環境の指定:セキュリティが確保された法人向けプラン(EnterpriseプランやAzure OpenAI Serviceなど)の利用を義務付ける。

これらのルールを策定し、全社で徹底することで、ChatGPTをリスクを抑えながら有効な業務効率化ツールとして活用することが可能になります。

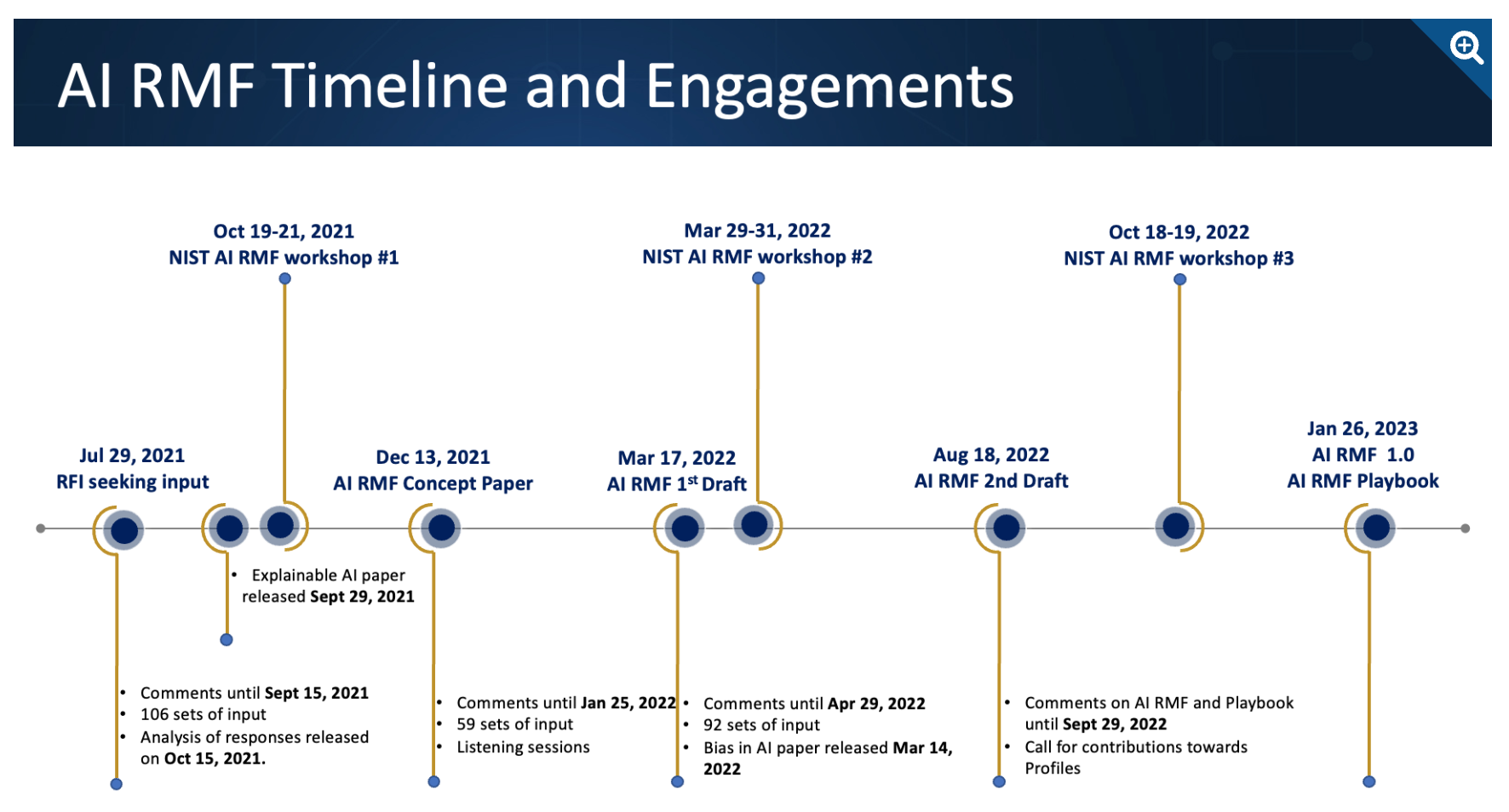

こちらは米国国立標準技術研究所(NIST)が公開している、AIのリスク管理に関するフレームワークです。国際的なガイドライン策定の参考になりますので、合わせてご覧ください。 https://www.nist.gov/itl/ai-risk-management-framework

あなたの会社の機密情報、ChatGPT経由でライバルに筒抜けになる未来

「業務効率化のためにChatGPTを導入しよう」——。その考えは正しいですが、一歩間違えれば、会社の未来を揺るがす大惨事を引き起こしかねません。実際に、世界的な大企業であるサムスン電子では、従業員が機密情報を含むソースコードをChatGPTに入力してしまい、外部に流出する事件が発生しました。これは決して他人事ではありません。あなたの会社の社員が、良かれと思って入力した新製品の情報や顧客リストが、AIの学習データとなり、意図せずライバルの手に渡ってしまう可能性があるのです。この記事では、そうした悪夢を現実のものとしないために、企業が直面する生成AIのリスクと、それを乗り越えるための具体的な道筋を提示します。

なぜ、便利なはずのツールが「情報漏洩の温床」に変わるのか?

問題の根源は、ChatGPTをはじめとする多くの生成AIサービスが、入力されたデータをサービス向上のための「学習データ」として利用する点にあります。つまり、あなたが入力した社外秘のデータは、OpenAI社のサーバーに送信され、AIの知識の一部として吸収されてしまう可能性があるのです。

この状態は、企業の情報をザルのようなセキュリティの箱に入れることに等しく、以下のような深刻なリスクをはらんでいます。

機密情報の意図せぬ流出: AIが学習した情報が、他のユーザーへの回答という形で断片的に出力され、競合他社に機密情報が推測される。

サイバー攻撃の標的に: OpenAIのサーバー自体が攻撃を受け、保存されたチャット履歴やアカウント情報がごっそり盗まれる。

従業員の過失による漏洩: 社員が悪意なく、顧客情報や開発中のコードについてChatGPTに相談し、それが流出の引き金となる。

こうしたリスクを理解せず、ただ「便利だから」という理由だけで全社的に利用を解禁するのは、時限爆弾を抱え込むようなものです。

引用元:

サムスン電子は2023年5月、従業員がChatGPTに機密情報を含むソースコードを誤ってアップロードした事例が複数発生したことを受け、企業所有のデバイスでの生成AIツールの使用を全面的に禁止したとブルームバーグが報じました。(Bloomberg. “Samsung Bans ChatGPT, Other Generative AI on Company Devices.” 2023年5月2日)

まとめ

企業は業務効率化やDX推進の切り札として生成AIに注目していますが、「ChatGPTに入力した情報が学習に使われてしまうのでは」「情報漏洩のリスクが怖くて本格導入に踏み切れない」といったセキュリティ上の懸念が大きな導入障壁となっています。

そこでおすすめしたいのが、Taskhub です。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

そして何より、Azure OpenAI Serviceを基盤にしているため、入力したデータがAIの学習に利用されることはなく、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「どんなルールで運用すれば安全かわからない」という企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプログラミングや高度なAI知識がなくても、セキュリティを確保しながらすぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最も安全な生成AI活用”を体験し、御社のDXを一気に加速させましょう。