「自社でもChatGPTを導入したいが、何から手をつければ良いかわからない…。」

「ChatGPTのガイドラインが必要だと聞いたけど、どうやって作ればいいんだろう?」

こういった悩みを持っている方もいるのではないでしょうか?

本記事では、企業がChatGPTを安全かつ効果的に活用するために不可欠な、ガイドラインの策定手順を7つのステップで詳しく解説します。

さらに、すぐに使えるガイドラインの雛形や、策定時に確認すべき法律、国内外の企業事例まで網羅的にご紹介します。

生成AIの導入支援を行う弊社が、多くの企業で培った知見を基に解説しますので、ぜひ最後までご覧ください。

そもそもChatGPTガイドラインとは?企業に必要な理由

ここからは、ChatGPTガイドラインの基本的な定義や、企業で必要とされる理由について解説します。

- 生成AIの企業利用における動向とChatGPTガイドラインの定義

- ChatGPTガイドラインがなぜ重要なのか

- ガイドラインがない場合の潜在的リスク

ChatGPTを導入する前に、まずはガイドラインの重要性を正しく理解することが、安全な利用への第一歩となります。

それでは、1つずつ見ていきましょう。

生成AIの企業利用における動向とChatGPTガイドラインの定義

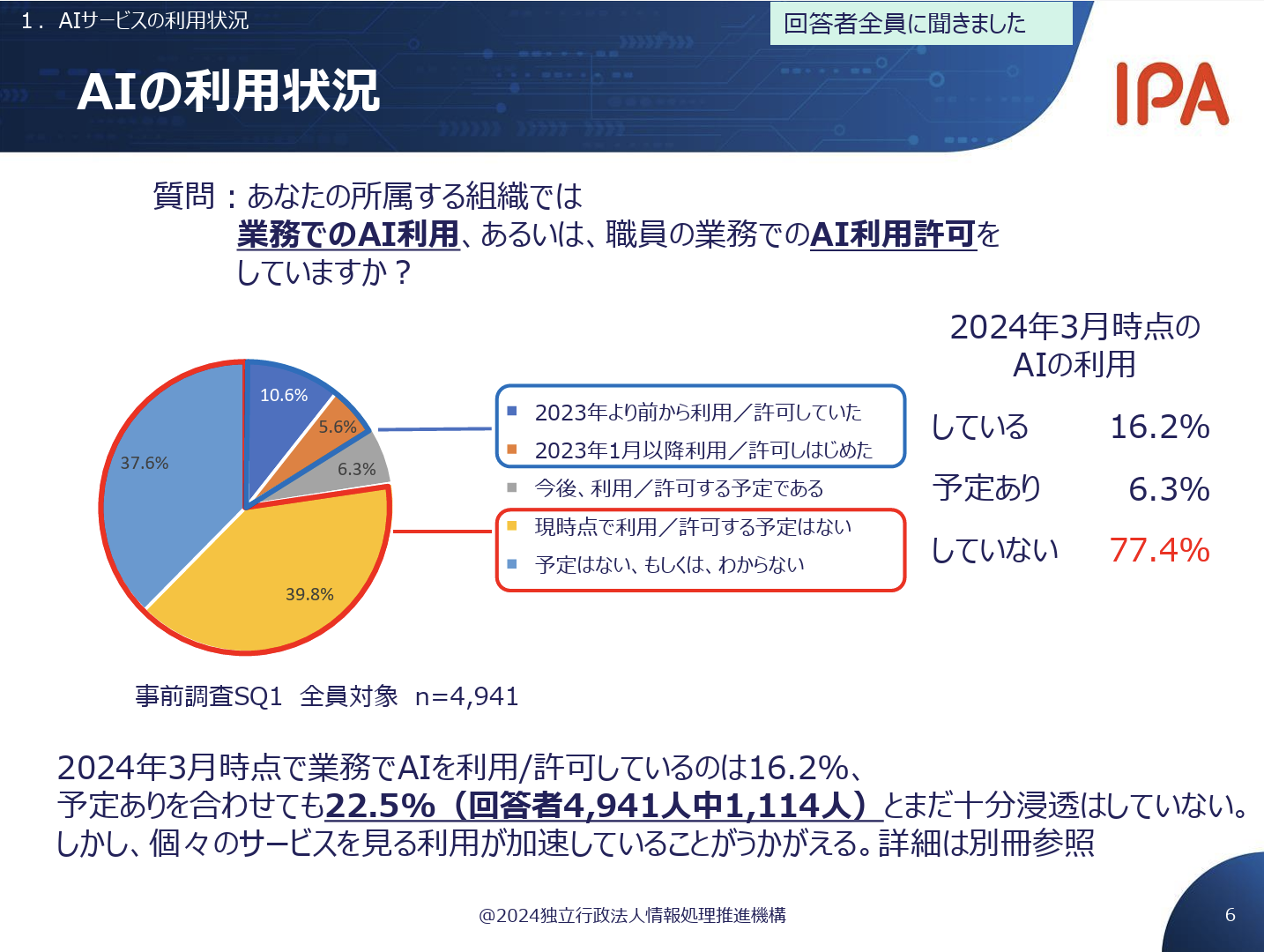

近年、業務効率化や新たな価値創造を目的として、多くの企業でChatGPTをはじめとする生成AIの導入が進んでいます。

こちらは生成AIの基本的な仕組みや種類、企業への導入事例について解説した記事です。合わせてご覧ください。

しかし、その一方で、便利なツールである生成AIには情報漏洩や著作権侵害といった様々なリスクも潜んでいます。

ChatGPTガイドラインとは、こうしたリスクを管理し、従業員が安全かつ統一されたルールのもとでChatGPTを利用するために企業が定める指針のことです。

具体的には、利用目的や範囲、入力してはならない情報、生成物の取り扱い方法などを明文化したもので、企業の資産と信用を守るための重要な役割を担います。

ChatGPTガイドラインがなぜ重要なのか

ChatGPTガイドラインが重要である理由は、主に「セキュリティの確保」「コンプライアンスの遵守」「利用の促進」の3点にあります。

まず、セキュリティ面では、従業員が誤って機密情報や個人情報を入力してしまうことによる情報漏洩を防ぎます。

次に、コンプライアンス面では、著作権や個人情報保護法などの法令を遵守し、法的なトラブルを未然に防ぐことができます。

そして、明確なルールを設けることで、従業員は「何をしてはいけないか」だけでなく「何をして良いか」を理解できます。

これにより、従業員は安心してChatGPTを業務に活用できるようになり、結果として生産性の向上やイノベーションの創出に繋がるのです。

ガイドラインがない場合の潜在的リスク

もしChatGPTのガイドラインがない状態で従業員が自由に使用した場合、企業は深刻なリスクに晒される可能性があります。

例えば、ある従業員が顧客の個人情報を含む会議の議事録を要約させたとします。

この情報がChatGPTの学習データとして利用され、外部に漏洩するリスクはゼロではありません。

また、別の従業員が生成した文章をそのままマーケティングコンテンツとして使用し、それが他社の著作物を侵害していた場合、企業が損害賠償請求をされる可能性もあります。

このように、ガイドラインの欠如は、情報漏洩、著作権侵害、ブランドイメージの低下など、企業の存続を揺るがしかねない重大な問題を引き起こす可能性があるのです。

企業が定めるべきChatGPTガイドラインと生成AIのリスク

ChatGPTを安全に利用するためには、そのリスクを正しく理解し、ガイドラインに反映させることが不可欠です。

ここでは、企業が特に注意すべき生成AIのリスクについて解説します。

- 機密情報や個人情報の漏洩リスク

- 著作権侵害や不正確な情報のリスク

- 法令・プライバシー違反のリスク

- 実際に発生したセキュリティ事故事例

これらのリスクを把握し、自社に合ったChatGPTガイドラインを策定しましょう。

機密情報や個人情報の漏洩リスク

ChatGPTガイドラインで最も注意すべき点の一つが、機密情報や個人情報の漏洩リスクです。

従業員が業務の効率化を求めるあまり、会社の未公開情報、顧客データ、個人情報などをプロンプトとして入力してしまうケースが考えられます。

OpenAIは、入力されたデータをモデルの学習に使用しないと表明していますが(API経由の場合)、設定ミスや従業員の誤解によって情報が外部に送信される可能性は否定できません。

一度漏洩した情報は完全に取り戻すことが困難であり、企業の信用失墜や経済的な損失に直結するため、ガイドラインで厳しく制限する必要があります。

こちらは生成AIの導入にあたっての企業リスクと、今すぐできる対策も解説した記事です。合わせてご覧ください。

著作権侵害や不正確な情報のリスク

ChatGPTが生成するコンテンツには、著作権侵害や不正確な情報を含むリスクが伴います。

ChatGPTはインターネット上の膨大なデータを学習しているため、その生成物には既存の著作物が意図せず含まれてしまう可能性があります。

これを会社のブログや報告書などで使用した場合、著作権侵害を問われる恐れがあります。

また、ChatGPTはもっともらしい嘘の情報を生成する「ハルシネーション」という現象を起こすことがあります。

こちらはAIのハルシネーションについて、その原因から具体的な対策まで詳しく解説した記事です。合わせてご覧ください。

生成された情報をファクトチェックせずに利用すると、誤った情報に基づいて重要な経営判断を下してしまったり、顧客に不正確な情報を提供してしまったりするリスクがあるため、注意が必要です。

法令・プライバシー違反のリスク

ChatGPTの利用は、個人情報保護法やGDPR(EU一般データ保護規則)などの法令、さらにはプライバシーの侵害に繋がるリスクもはらんでいます。

例えば、顧客とのやり取りをChatGPTに入力して要約を作成する際、その中に含まれる個人情報を適切に扱わなければ、個人情報保護法に抵触する可能性があります。

また、特定の個人に関する情報を収集・分析するためにChatGPTを利用した場合、プライバシー権の侵害となることも考えられます。

企業は、国内外の関連法規を遵守し、個人のプライバシーを尊重する利用方法をChatGPTガイドラインで明確に定める責任があります。

実際に発生したセキュリティ事故事例

生成AIの利用に起因するセキュリティ事故は、すでに国内外で報告されています。

海外の有名企業では、従業員が社内の機密情報を含むソースコードをChatGPTに入力してデバッグを依頼した結果、その情報が外部に漏洩したとされる事例が発生しました。

この事件は、従業員の何気ない行動が、いかに重大なセキュリティインシデントに繋がりうるかを示しています。

このような実例を社内で共有することも、従業員のセキュリティ意識を高め、ChatGPTガイドラインの重要性を理解してもらう上で非常に効果的です。

ガイドライン策定と併せて、具体的な事例を用いた研修の実施も検討しましょう。

こちらはIPA(情報処理推進機構)が公開した、AI利用時のセキュリティ脅威やリスクに関する詳細な調査報告書です。 合わせてご覧ください。https://www.ipa.go.jp/security/reports/technicalwatch/eid2eo00000022sn-att/report.pdf

参考にしたい企業のChatGPTガイドライン公開事例

自社でChatGPTガイドラインを作成する際には、すでにガイドラインを策定し、公開している他社の事例を参考にすることが非常に有効です。

- 国内企業のChatGPTガイドライン事例

- 海外企業のChatGPTガイドライン事例

ここでは、国内外の先進的な企業の取り組みを紹介します。

これらの事例から、自社の状況に合わせて応用できる点を見つけていきましょう。

国内企業のChatGPTガイドライン事例

国内では、多くの先進企業が生成AIの利用に関するガイドラインを策定・公開し始めています。

例えば、パナソニックコネクト株式会社は、全従業員向けに「生成AI利用ガイドライン」を公開しており、利用目的の明確化や機密情報の取り扱いについて厳格なルールを定めています。

こちらはパナソニックグループが策定したAI倫理原則に関する公式プレスリリースです。 合わせてご覧ください。https://news.panasonic.com/jp/press/jn220829-1

また、富士通株式会社も「AI倫理」に関する考え方を公表し、その中でAIの透明性や説明責任の重要性を強調しています。

こちらは富士通が公式に発表している「AI倫理」に関する考え方です。 合わせてご覧ください。https://global.fujitsu/ja-jp/technology/key-technologies/ai/aiethics

これらの企業の事例は、日本国内の法規制やビジネス慣習を考慮した上で作成されており、自社のガイドラインを策定する際の具体的な参考となるでしょう。

海外企業のChatGPTガイドライン事例

海外では、日本以上に生成AIの活用が進んでおり、それに伴いガイドラインの整備も進んでいます。

例えば、世界的なコンサルティングファームであるアクセンチュアは、従業員に対して「責任あるAI」の原則を掲げ、AIの設計、開発、展開における倫理的な指針を明確に示しています。

また、大手金融機関の中には、顧客データの取り扱いや、AIによる意思決定プロセスの透明性確保について、非常に詳細なガイドラインを設けているところもあります。

グローバルに事業を展開している企業にとっては、こうした海外企業の事例を参考にし、国際的な基準に準拠したガイドラインを作成することが重要になります。

こちらは海外の動向として注目される「EU AI Act」の概要について分かりやすく解説した記事です。 合わせてご覧ください。 https://www.simmons-simmons.com/en/publications/ck03kv75g2m2a0b35wv52g32d/the-eu-ai-act-a-quick-guide

ChatGPTガイドライン策定の具体的な7ステップ

ここからは、実際に企業でChatGPTガイドラインを策定するための具体的な手順を7つのステップに分けて解説します。

- ステップ1:利用目的・範囲の定義

- ステップ2:関連部署との連携と責任者の任命

- ステップ3:禁止事項・注意事項の明文化

- ステップ4:入力してはいけない情報のルール策定

- ステップ5:生成されたコンテンツの取り扱いルール策定

- ステップ6:罰則規定の検討

- ステップ7:社内への周知と定期的な見直し

このステップに沿って進めることで、網羅的で実用的なガイドラインを作成することができます。

ステップ1:利用目的・範囲の定義

最初のステップは、社内でChatGPTを「何のために」「誰が」「どの業務で」利用するのかを明確に定義することです。

例えば、利用目的を「社内資料の作成補助」「アイデア出しの壁打ち」などに限定し、利用範囲を「特定の部署のみ」または「全従業員」とするかを決定します。

目的と範囲を最初に定義することで、ガイドライン全体の方向性が定まり、後のステップで定めるべき具体的なルールが明確になります。

また、スモールスタートで一部の部署から導入し、効果を検証しながら段階的に範囲を拡大していくというアプローチも有効です。

ステップ2:関連部署との連携と責任者の任命

ChatGPTガイドラインの策定は、法務、情報システム、人事、そして実際に業務で利用する事業部門など、関連する複数の部署と連携して進めることが不可欠です。

法務部門は法規制の観点から、情報システム部門はセキュリティの観点から、それぞれ専門的な知見を提供します。

また、ガイドラインの策定と運用を円滑に進めるために、プロジェクトの責任者を任命することも重要です。

責任者は、各部署の意見を取りまとめ、ガイドラインが実態に即した実用的なものになるよう調整する役割を担います。

ステップ3:禁止事項・注意事項の明文化

ガイドラインの中核となるのが、禁止事項と注意事項です。

従業員が判断に迷うことなく、安全にChatGPTを利用できるように、具体的かつ明確な言葉でルールを記載する必要があります。

禁止事項としては、「機密情報・個人情報の入力」「差別的・暴力的なコンテンツの生成」「法令に違反する目的での利用」などが挙げられます。

注意事項としては、「生成された情報のファクトチェックを必ず行うこと」「AIが生成した文章であることを必要に応じて明記すること」などを盛り込みましょう。

ステップ4:入力してはいけない情報のルール策定

情報漏洩リスクを回避するため、ChatGPTに入力してはいけない情報を具体的にリストアップし、ルールとして策定することが極めて重要です。

このリストには、最低限以下の情報を含めるべきです。

- 個人情報(氏名、住所、電話番号、マイナンバーなど)

- 顧客情報(取引内容、連絡先など)

- 自社の機密情報(未公開の財務情報、技術情報、人事情報など)

- 他社の非公開情報

これらの情報例を具体的に示すことで、従業員は何を入力してはいけないのかを正確に理解することができます。

ステップ5:生成されたコンテンツの取り扱いルール策定

ChatGPTが生成した文章やアイデアなどを、どのように取り扱うかについてのルールも定める必要があります。

まず、生成された情報は不正確な場合があるため、必ず人間が内容を精査し、ファクトチェックを行うことを義務付けます。

また、生成物をそのままコピー&ペーストして使用するのではなく、自らの言葉で修正・加筆することを推奨します。

さらに、著作権侵害のリスクを避けるため、特に外部に公開するコンテンツについては、専用のツールでコピーコンテンツでないかを確認するプロセスを設けることも有効です。

ステップ6:罰則規定の検討

ガイドラインの実効性を担保するために、違反した場合の罰則規定を検討することも重要です。

罰則の内容は、企業の就業規則などと整合性を取る必要があり、違反の程度に応じて、「厳重注意」「減給」「懲戒解雇」といった段階的な処分を定めます。

ただし、罰則規定の目的は従業員を罰することではなく、あくまでルールを遵守してもらうことにあります。

ガイドラインの重要性と違反した場合のリスクを丁寧に説明し、従業員の理解を得ることが前提となります。

罰則規定については、人事部門や法務部門と慎重に協議して決定しましょう。

ステップ7:社内への周知と定期的な見直し

ガイドラインが完成したら、最後のステップとして全従業員に周知し、その内容を浸透させることが重要です。

単にメールで通知するだけでなく、説明会や研修会を実施し、ガイドライン策定の背景や目的、具体的なルールについて詳しく説明する機会を設けましょう。

また、生成AIの技術は日々進化し、新たなリスクが出現する可能性もあります。

そのため、策定したガイドラインは一度作って終わりではなく、少なくとも半年に一度、あるいは必要に応じて見直しを行い、常に最新の状況に合わせてアップデートしていく体制を整えることが不可欠です。

ChatGPTガイドライン作成時に確認すべき法律・規約

ChatGPTガイドラインを作成する上では、関連する法律や利用規約を正しく理解し、遵守することが大前提となります。

- 著作権法との関連性

- 個人情報保護法との関連性

- 不正競争防止法との関連性

- ChatGPT自体の利用規約

これらの法律・規約に違反した場合、企業は法的な責任を問われる可能性があります。

それぞれのポイントをしっかりと確認しましょう。

著作権法との関連性

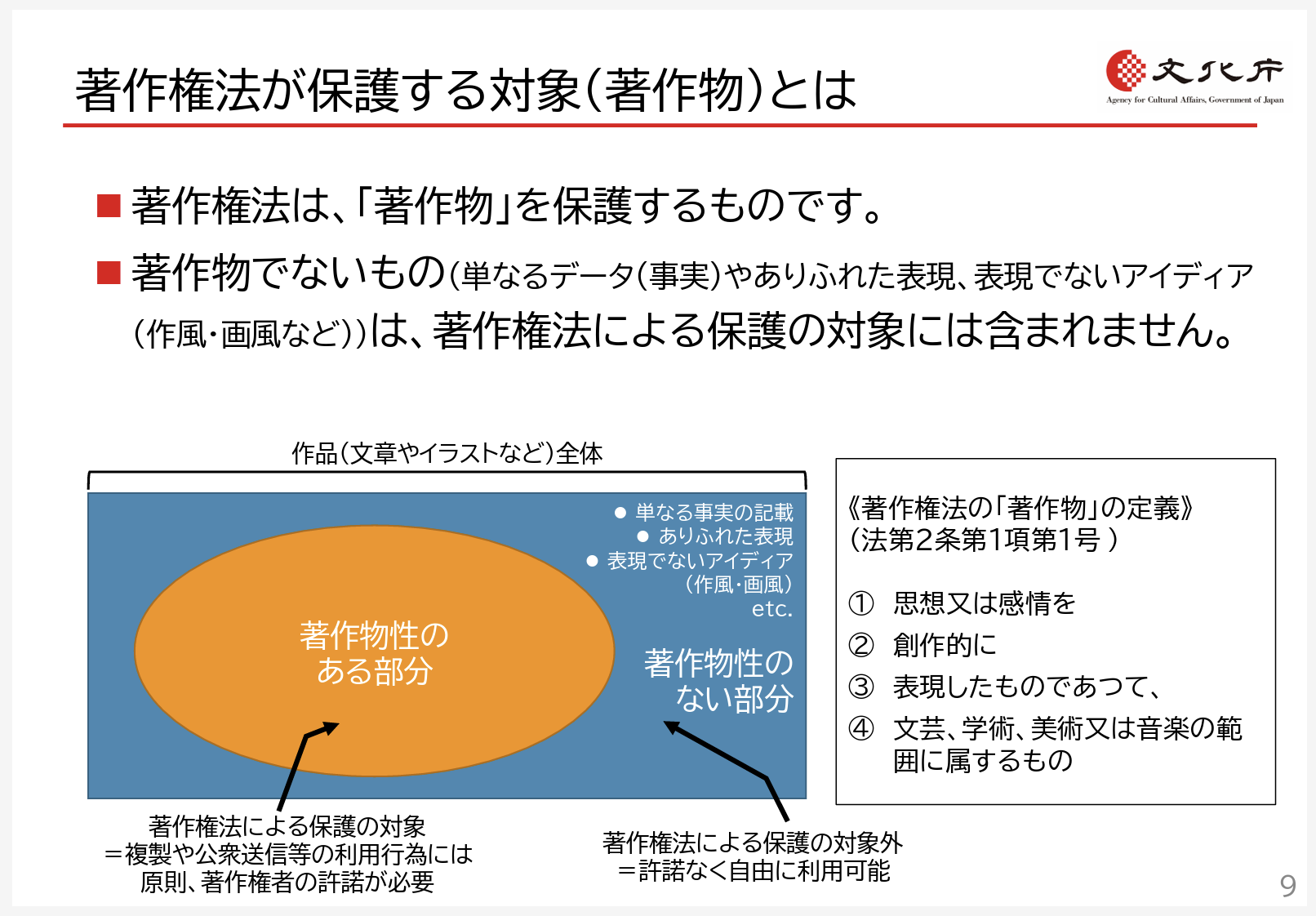

ChatGPTの利用において、著作権法は「入力」と「出力」の両面で関わってきます。

まず、著作権で保護されている文章などを許諾なく入力する行為は、著作権法上の「複製」にあたる可能性があります。

一方、ChatGPTが生成したコンテンツが、既存の著作物と類似していた場合、その利用が著作権侵害となるリスクがあります。

ガイドラインでは、著作物を無断で入力しないこと、生成物の利用前には必ず独自性を確認することなどを定め、著作権侵害のリスクを管理する必要があります。

こちらは文化庁が発表した、AIと著作権の関係についての考え方をまとめた公式資料です。 合わせてご覧ください。 https://www.bunka.go.jp/seisaku/chosakuken/pdf/93903601_01.pdf

個人情報保護法との関連性

個人情報保護法は、個人の権利利益を保護することを目的とした法律です。

氏名や住所、メールアドレスなどの個人情報をChatGPTに入力する行為は、目的外利用や第三者提供とみなされ、同法に抵触する恐れがあります。

特に、本人の同意なく個人情報を入力することは絶対に避けなければなりません。

ChatGPTガイドラインでは、個人情報の入力を原則禁止とし、万が一業務上必要な場合でも、必ず匿名化処理を施すなどの厳格なルールを設けることが求められます。

企業の社会的信用を維持するためにも、個人情報の適切な取り扱いは最優先事項です。

こちらは個人情報保護委員会による、生成AIサービスの利用に関する公式な注意喚起です。 合わせてご覧ください。 https://www.ppc.go.jp/news/press/230602_release/

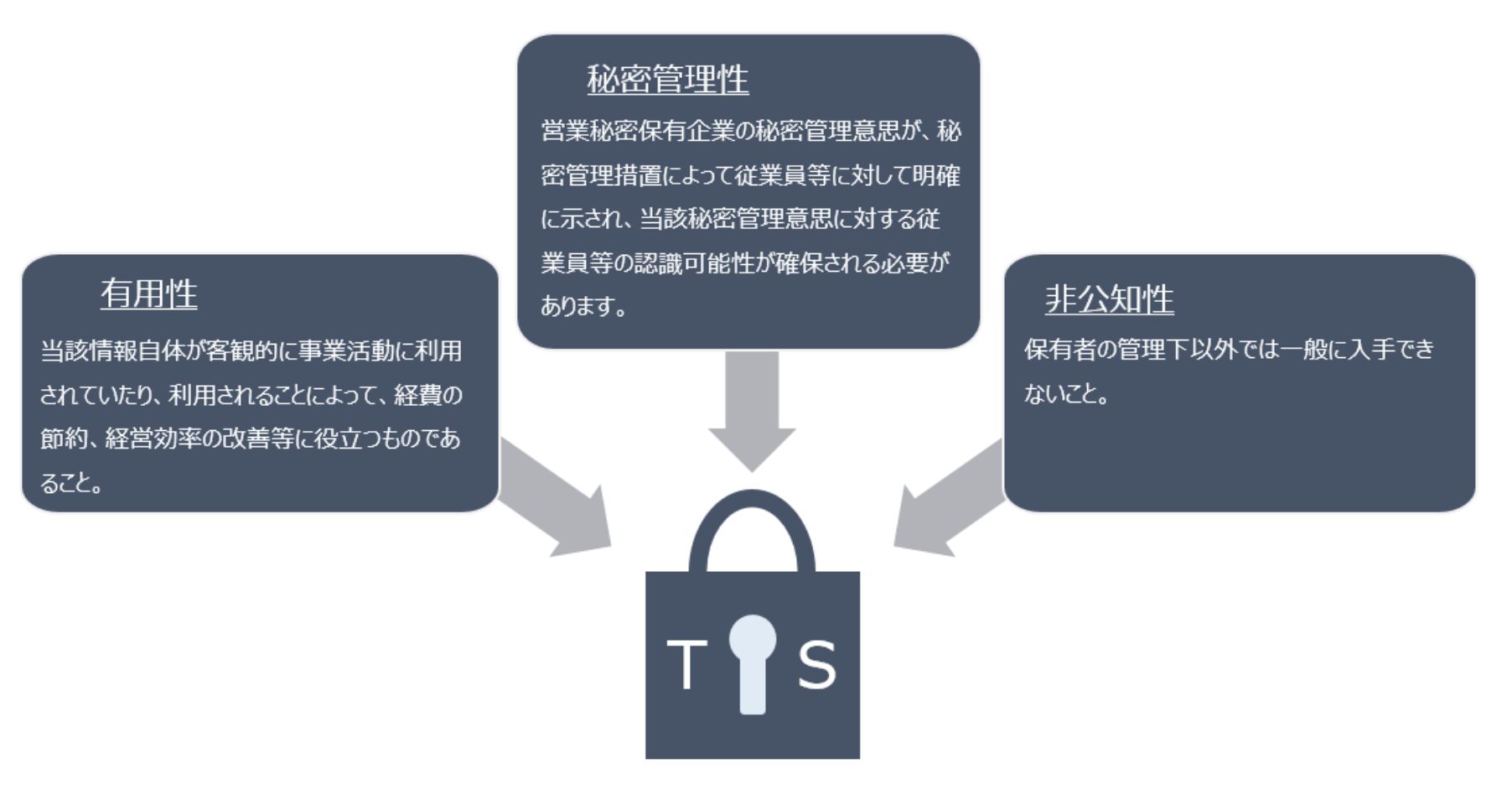

不正競争防止法との関連性

不正競争防止法は、企業の営業秘密(トレードシークレット)を保護するための法律です。

企業の技術情報、販売ノウハウ、顧客リストなど、秘密として管理されている有用な情報は、この法律によって守られています。

これらの営業秘密をChatGPTに入力した場合、情報が外部に漏洩し、不正競争防止法で保護されるべき利益が損なわれるリスクがあります。

ガイドラインでは、同法で定義される営業秘密に該当する情報の入力を明確に禁止し、企業の競争力の源泉である知的資産を保護しなければなりません。

こちらは経済産業省が公開している、企業の営業秘密の保護に関する資料です。 合わせてご覧ください。 https://www.meti.go.jp/policy/economy/chizai/chiteki/trade-secret.html

ChatGPT自体の利用規約

見落とされがちですが、ChatGPTを提供するOpenAI社の利用規約を確認し、遵守することも非常に重要です。

利用規約には、サービスの利用目的の制限、禁止行為、生成されたコンテンツの所有権などに関する重要な規定が含まれています。

例えば、規約では、ヘイトスピーチや暴力的なコンテンツの生成など、特定の目的での利用が禁止されています。

自社のガイドラインがOpenAI社の利用規約に反していないかを確認し、従業員にも規約の存在を周知することで、アカウント停止などのリスクを防ぐことができます。

【コピペ可】今すぐ使えるChatGPTガイドラインのひな形

ここでは、これまでの内容を踏まえ、企業ですぐに使えるChatGPTガイドラインの基本的なひな形を紹介します。

これはあくまで一般的な内容ですので、必ず自社の状況に合わせて内容を修正・追記してご活用ください。

- 第1条:目的

- 第2条:適用範囲

- 第3条:利用における基本原則

- 第4条:禁止事項

- 第5条:情報セキュリティ

- 第6条:懲戒処分

このひな形をベースに、自社独自のガイドラインを作成していきましょう。

第1条:目的

本ガイドラインは、当社におけるChatGPTを含む生成AIサービス(以下「本サービス」という)の利用にあたり、遵守すべき事項を定めるものである。

本ガイドラインの目的は、本サービスの利用に伴う情報漏洩、著作権侵害、法令違反等のリスクを管理し、従業員が本サービスを安全かつ効果的に活用することで、業務効率の向上と企業価値の増大に資することにある。

第2条:適用範囲

本ガイドラインは、当社の役員および従業員(正社員、契約社員、派遣社員、アルバイト等を含む)すべてに適用される。

また、当社の情報資産を利用して本サービスにアクセスするすべての者に対して適用されるものとする。

本ガイドラインで定義する本サービスには、会社が利用を許可したすべての生成AIツールが含まれる。

第3条:利用における基本原則

本サービスを利用する者は、以下の基本原則を遵守しなければならない。

- 業務効率化を目的として利用し、私的利用は行わないこと。

- 生成された情報は、不正確または偏見を含む可能性があることを常に認識すること。

- 生成された情報を利用する場合は、必ず内容の真偽を確認(ファクトチェック)し、自らの責任で編集・加工を行うこと。

- 本ガイドラインおよび関連法規を遵守し、倫理的な利用を心がけること。

第4条:禁止事項

本サービスを利用するにあたり、以下の行為を禁止する。

- 第5条に定める機密情報および個人情報を入力すること。

- 差別的、誹謗中傷、暴力的、その他公序良俗に反する内容を生成させること。

- 他者の著作権、商標権、その他の知的財産権を侵害する目的で利用すること。

- 法令に違反する行為、または犯罪行為を助長する目的で利用すること。

- 会社の許可なく、本サービスを利用して作成したコンテンツを外部に公開すること。

第5条:情報セキュリティ

本サービスの利用にあたり、情報漏洩を防止するため、以下の情報の入力を固く禁止する。

- 個人情報保護法に定める個人情報(氏名、住所、マイナンバー、個人を特定できる情報等)

- 当社の営業秘密、技術情報、財務情報、人事情報等の機密情報

- 取引先から得た機密情報および非公開情報

- アクセス認証情報(ID、パスワード等)

第6条:懲戒処分

従業員が本ガイドラインに違反したと認められる場合、就業規則の定めに従い、懲戒処分の対象となることがある。

処分の内容は、違反の程度や影響を考慮し、個別に決定する。

ChatGPTガイドラインを社内で浸透させるための対策

ガイドラインは作成するだけでは意味がありません。従業員一人ひとりが内容を理解し、日々の業務で遵守して初めて機能します。

ここでは、策定したChatGPTガイドラインを社内で浸透させるための具体的な対策を紹介します。

- ガイドラインの整備と全社への周知徹底

- 定期的なリテラシー教育や研修の実施

- 生成AIに有効なセキュリティサービスの導入

- 利用状況を可視化・モニタリングする体制の構築

これらの対策を組み合わせることで、ガイドラインの実効性を高めることができます。

ガイドラインの整備と全社への周知徹底

まず基本となるのが、完成したガイドラインをアクセスしやすい場所に保管し、全従業員にその存在を知らせることです。

社内ポータルサイトや共有フォルダにデータを格納し、いつでも誰でも閲覧できる状態にしておきましょう。

周知の方法としては、全社メールでの通知に加え、部署ごとの朝礼や定例ミーティングで担当者が直接説明する機会を設けるのが効果的です。

なぜガイドラインが必要なのか、その背景や目的を丁寧に伝えることで、従業員の理解を深め、自分事として捉えてもらうことができます。

定期的なリテラシー教育や研修の実施

ChatGPTガイドラインの内容を形骸化させないためには、定期的な教育や研修の実施が不可欠です。

研修では、ガイドラインの読み合わせだけでなく、具体的な業務シーンを想定したケーススタディを取り入れると良いでしょう。

例えば、「このような情報を入力しても良いか?」「生成されたこの文章をそのまま使って良いか?」といったクイズ形式の演習を行うことで、従業員は実践的な判断力を養うことができます。

また、新たなリスクやツールのアップデートに合わせて、研修内容も随時更新していくことが重要です。

生成AIに有効なセキュリティサービスの導入

人的な対策に加えて、技術的な対策を講じることも社内浸透を後押しします。

例えば、DLP(Data Loss Prevention)ツールを導入すれば、機密情報や個人情報がChatGPTなどの外部サービスに送信されそうになった際に、自動で検知しブロックすることが可能です。

また、従業員が安全な環境でChatGPTを利用できる、法人向けのセキュリティが強化されたAIプラットフォームを導入することも有効な選択肢です。

こうしたツールは、ガイドラインの遵守を物理的にサポートし、ヒューマンエラーによる情報漏洩リスクを大幅に低減させます。

利用状況を可視化・モニタリングする体制の構築

従業員のChatGPT利用状況を可視化し、モニタリングする体制を構築することも、ガイドラインの浸透とリスク管理に繋がります。

法人向けのサービスや専用ツールを使えば、誰が、いつ、どのような目的でChatGPTを利用しているかを把握することができます。

モニタリングの目的は、従業員を監視することではなく、不適切な利用を早期に発見して是正したり、便利な使い方をしている従業員のノウハウを社内で共有したりすることにあります。

利用データを分析することで、ガイドラインの見直しや、より効果的な活用方法の検討にも役立てることができます。

企業におけるChatGPTガイドラインの具体的な活用方法

最後に、策定したChatGPTガイドラインが、実際のビジネスシーンでどのように活用されるのか、具体的な例をいくつか紹介します。

- カスタマーサービスでのChatGPTガイドライン活用

- マーケティング業務でのChatGPTガイドライン活用

- 教育・研修でのChatGPTガイドライン活用

これらの例を参考に、自社の業務にどのように応用できるかをイメージしてみてください。

カスタマーサービスでのChatGPTガイドライン活用

カスタマーサービス部門では、顧客からの問い合わせ内容の要約や、よくある質問への回答文案の作成などにChatGPTを活用できます。

この際、ガイドラインは重要な役割を果たします。

ガイドラインで「顧客の個人情報は絶対に入力しない」と定められていれば、オペレーターは問い合わせ内容から個人情報を削除または匿名化してから入力するようになります。

これにより、情報漏洩のリスクを回避しつつ、迅速かつ質の高い顧客対応を実現できます。

また、「生成された回答は必ず人間が確認・修正する」というルールも、誤った情報を顧客に伝えてしまうのを防ぎます。

マーケティング業務でのChatGPTガイドライン活用

マーケティング部門では、広告コピー、ブログ記事、SNS投稿などのコンテンツ作成にChatGPTが活用されます。

ここでもガイドラインは不可欠です。

「生成された文章は、必ずコピーチェックツールで確認する」というルールがあれば、意図しない著作権侵害を防ぐことができます。

また、「会社のブランドイメージやトーン&マナーに合致するように必ず修正する」という規定を設けることで、AIが生成した無機質な文章ではなく、企業らしさのある一貫したメッセージを発信することが可能になります。

教育・研修でのChatGPTガイドライン活用

人事部門や研修担当者は、新人研修の資料作成や、ロールプレイング研修のシナリオ作成などにChatGPTを活用できます。

ガイドラインは、研修コンテンツの質と安全性を両立させるために役立ちます。

例えば、「社内の未公開情報や人事考課に関する情報は入力しない」というルールを徹底することで、機密情報を守りながら研修資料を作成できます。

また、「多様性や倫理観に配慮した表現を用いること」をガイドラインで定めることで、ハラスメントに繋がるような不適切な研修コンテンツが作成されるのを防ぎ、すべての従業員が安心して学べる環境を維持することができます。

そのChatGPT利用は「諸刃の剣」。会社の未来を守るガイドラインという羅針盤

ChatGPTが業務効率化の切り札として注目される一方、その利用方法を一歩間違えれば、企業の信頼を根底から揺るがす大事故に繋がりかねません。

海外の有名企業では、従業員が機密情報を含むソースコードをChatGPTに入力した結果、情報が外部に漏洩したとされる事件が現実に発生しています。これは決して対岸の火事ではありません。ガイドラインという羅針盤を持たずに生成AIという大海原へ乗り出すことは、情報漏洩、著作権侵害、そして莫大な損害賠償といった見えない氷山に突進するようなものです。

しかし、恐れる必要はありません。パナソニックコネクトや富士通といった国内の先進企業は、明確なガイドラインを策定することで、AIを安全な航海へと導き、その能力を最大限に引き出しています。この記事では、ChatGPTを単なる便利なツールから、企業の成長を加速させる「最強のビジネスパートナー」へと変えるための、守りと攻めのガイドライン戦略を解説します。

引用元:

海外の有名企業にて、従業員が社内の機密情報を含むソースコードをChatGPTに入力し、情報が外部に漏洩したとされる事例が報告されています。(本記事「実際に発生したセキュリティ事故事例」より)

国内企業では、パナソニックコネクト株式会社が全従業員向けに「生成AI利用ガイドライン」を公開しており、富士通株式会社も「AI倫理」に関する考え方を公表しています。(本記事「国内企業のChatGPTガイドライン事例」より)

まとめ

企業はChatGPTの活用による業務効率化に大きな期待を寄せていますが、その裏には情報漏洩や著作権侵害といった深刻なリスクが潜んでいます。

しかし、実際には「ガイドラインの策定方法がわからない」「セキュリティ対策まで手が回らない」といった理由で、本格的な導入に踏み出せない企業も少なくありません。

そこでおすすめしたいのが、Taskhub です。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「何をどう使えばいいのかわからない」という初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なガイドライン策定や高度なAI知識がなくても、すぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最速の生成AI活用”を体験し、御社のDXを一気に加速させましょう。