「ChatGPTを使っているけど、知らないうちに利用規約違反になっていないか心配…」

「どんな行為が具体的に規約違反になるのか、はっきり知りたい」

「もし違反したらどうなるの?アカウント停止のリスクは避けたいな…」

こういった悩みや疑問を持っている方もいるのではないでしょうか?

本記事では、ChatGPTの利用規約違反となる具体的な禁止事項、違反した場合の罰則、そして企業や個人が直面するリスクについて、事例を交えながら徹底的に解説します。

さらに、アカウント停止などのトラブルを未然に防ぐための具体的な対策まで網羅しました。

この記事を最後まで読めば、ChatGPTの利用規約に関する不安を解消し、安全かつ効果的にAIを活用するための知識が身につきます。

まずは基本から!ChatGPT利用規約違反とは何か?

ここからは、ChatGPTの利用規約の基本的な考え方について解説します。

- 利用規約とポリシーの概要

- 禁止事項の全体像

- 規約遵守の重要性

これらの基礎知識を押さえることで、なぜ特定の行為が禁止されるのかを深く理解できるようになります。

それでは、1つずつ順に見ていきましょう。

ChatGPTの利用規約とポリシーの概要

ChatGPTの利用規約とは、OpenAIが提供するサービスを利用する上でのルールを定めたものです。主に「利用規約(Terms of Use)」と、より具体的な禁止事項を記した「利用ポリシー(Usage policies)」から構成されています。

これらの規約は、ユーザーとOpenAI双方の権利と義務を明確にし、AIが悪用されるのを防ぎ、全てのユーザーが安全にサービスを利用できる環境を維持するために存在します。

例えば、違法行為への利用禁止や、他者の権利を侵害するようなコンテンツの生成を制限する内容が含まれています。規約は社会情勢や技術の進展に合わせて更新されることがあるため、定期的な確認が推奨されます。

こちらはOpenAIが公式に定めている、より詳細な禁止事項を記した「使用ポリシー」の日本語版です。合わせてご覧ください。 https://openai.com/ja-JP/policies/usage-policies/

禁止事項の全体像と規約の基礎知識

ChatGPTの利用規約における禁止事項は、多岐にわたりますが、大きく分けると「違法・有害なコンテンツの生成」「他者の権利侵害」「サービスの不正利用」の3つのカテゴリーに分類できます。

具体的には、ヘイトスピーチや児童虐待に関連するコンテンツ、マルウェアの生成、著作権で保護されたコンテンツの不正利用などが厳しく禁じられています。

これらのルールは、AIという強力なツールが社会に与える影響を考慮し、倫理的な観点から設定されています。規約を理解することは、単にルールを守るだけでなく、AIを責任ある形で活用するための第一歩と言えるでしょう。

なぜ利用規約の遵守が重要なのか

利用規約の遵守は、ChatGPTを継続的に利用する上で極めて重要です。規約違反が発覚した場合、軽微なものであれば警告で済むこともありますが、悪質なケースや度重なる違反にはアカウントの一時停止や永久停止といった厳しい措置が取られます。

アカウントが永久停止されると、過去の履歴にアクセスできなくなるだけでなく、同じ情報での再登録も困難になる可能性があります。

さらに、著作権侵害や情報漏洩といった違反内容は、法的な問題に発展し、損害賠償請求などのリスクを負うことにもなりかねません。個人の利用はもちろん、特にビジネスで活用する際には、規約遵守が信用の維持に直結します。

【一覧】これがChatGPT利用規約違反!注意すべき禁止事項10選

ここからは、ChatGPTの利用規約で特に注意すべき具体的な禁止事項を10個ピックアップして解説します。

①不適切なコンテンツ(ヘイトスピーチ・暴力等)の生成

②著作権や商標権を侵害するコンテンツの利用

③個人情報や機密情報の不正な取り扱い

④マルウェア生成などの犯罪・加害行為への利用

⑤虚偽情報(ディープフェイク等)の意図的な拡散

⑥学術的な不正行為への利用

⑦医療・法律・金融分野での不適切なアドバイス生成

⑧高リスクな政府の意思決定への利用

⑨性的・暴力的なコンテンツの生成

⑩禁止ワード・NGワードの利用

これらは知らず知らずのうちに違反してしまう可能性もあるため、しっかりと内容を理解しておきましょう。

それでは、一つずつ詳しく見ていきます。

①不適切なコンテンツ(ヘイトスピーチ・暴力等)の生成

ChatGPTを利用して、ヘイトスピーチや差別的、暴力的、嫌がらせにあたるコンテンツを生成することは固く禁じられています。

これには、特定の人種、民族、宗教、性別、性的指向などに対する差別を助長するような文章や、他者を脅迫、中傷する内容が含まれます。

また、自傷行為や他者への暴力を推奨、賛美するようなコンテンツの生成も同様に禁止事項です。AIが社会的な分断や憎悪を煽るために使われることを防ぐための重要なルールです。

②著作権や商標権を侵害するコンテンツの利用

ChatGPTを使って、他者が著作権や商標権を持つコンテンツを無断で複製、改変、配布することは利用規約違反にあたります。

例えば、特定の作家の小説を丸ごと入力して続きを書かせたり、有名なキャラクターやブランドロゴに酷似した画像を生成させたりする行為は、権利侵害とみなされる可能性があります。

生成されたコンテンツを公開・商用利用する際には、既存の作品と酷似していないか、第三者の権利を侵害していないかを慎重に確認する必要があります。

③個人情報や機密情報の不正な取り扱い

ChatGPTに個人情報や企業の機密情報を入力することは、情報漏洩のリスクがあり、規約上も推奨されていません。

名前、住所、電話番号、マイナンバー、医療情報といった個人を特定できる情報や、企業の内部情報、顧客データ、未公開のソースコードなどをプロンプトに含めるべきではありません。

デフォルト設定では入力されたデータがAIの学習に利用される可能性があるため、機密情報の取り扱いには最大限の注意が必要です。これは自分だけでなく、他者の情報を守る上でも重要なルールです。

④マルウェア生成などの犯罪・加害行為への利用

ChatGPTを犯罪行為や他者への加害行為に利用することは、最も厳しく禁止されている事項の一つです。

これには、コンピュータウイルスやマルウェア、ランサムウェアのコードを生成させること、フィッシング詐欺のメール文面を作成させること、不正アクセスのための手法を尋ねることなどが含まれます。

AIをサイバー攻撃や詐欺、その他の違法行為のツールとして使用しようとする試みは、即座にアカウント停止や法的措置の対象となる可能性があります。

⑤虚偽情報(ディープフェイク等)の意図的な拡散

ChatGPTを用いて、意図的に虚偽の情報を生成し、拡散させる行為は禁止されています。特に、ディープフェイク技術を悪用して、特定の人物が言ってもいないことを言っているかのような偽の画像や動画、音声を作成することは社会的な混乱を招くため問題視されています。

プロパガンダ、陰謀論、偽ニュースの作成など、世論を不正に操作したり、他者の名誉を毀損したりする目的での利用は、規約違反となります。情報の真偽を見極めるリテラシーが、利用者にも求められます。

⑥学術的な不正行為への利用

教育現場において、ChatGPTを不正行為に利用することは認められていません。

例えば、学生がレポートや論文をChatGPTに丸投げして作成させ、それを自身の成果物として提出する行為は、盗用や剽窃にあたります。

また、試験中にChatGPTを使って答えを得るなどの行為もカンニングとみなされます。多くの教育機関では、AIの適切な利用に関するガイドラインを策定しており、それに従う必要があります。アイデア出しや文章構成の補助として使うことは有益ですが、最終的な成果物は自身の言葉で作成することが求められます。

⑦医療・法律・金融分野での不適切なアドバイス生成

ChatGPTは専門家ではありません。そのため、医療、法律、金融といった高度な専門知識が求められ、人々の生命や財産に大きな影響を与える可能性のある分野で、資格を持たない者がアドバイスを行うことは禁止されています。

例えば、「この症状はどんな病気ですか?」と診断を求めたり、「この契約書は法的に有効ですか?」と法律相談を行ったり、「どの株に投資すれば儲かりますか?」と具体的な投資助言を求めたりする行為です。

生成された情報はあくまで参考程度に留め、最終的な判断は必ず資格を持つ専門家に相談する必要があります。

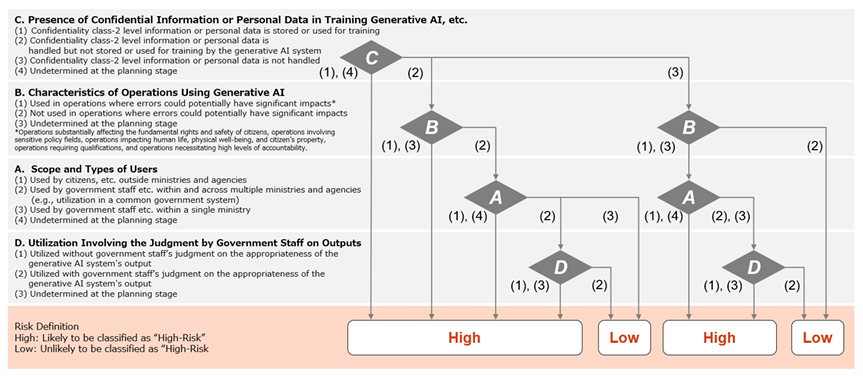

⑧高リスクな政府の意思決定への利用

ChatGPTを含むOpenAIのモデルは、高リスクな政府の意思決定プロセス、特に法執行や軍事、司法といった分野での利用が制限されています。

例えば、武器の開発や軍事作戦の立案、個人のプロファイリングに基づく監視、裁判における判決の判断材料などに使用することは、深刻な人権侵害や社会的な危害をもたらす可能性があるため、規約で禁止されています。

これらの分野では、人間の倫理観と責任ある判断が不可欠であり、AIの回答に依存することは許されません。

⑨性的・暴力的なコンテンツの生成

性的、特にポルノグラフィに関連するコンテンツや、過度に暴力的なコンテンツを生成させることは明確に禁止されています。

これには、性的な行為を露骨に描写した文章や画像の生成、性的搾取に関連する内容、また、残虐な暴力シーンや凄惨な出来事を詳細に描写させることなどが含まれます。

これらのコンテンツは、ユーザー、特に未成年者に有害な影響を与える可能性があるため、厳しい制限が設けられています。AIが健全な情報提供ツールとして機能するための重要なルールです。

⑩禁止ワード・NGワードの利用

OpenAIは、禁止ワードやNGワードの具体的なリストを公開していません。しかし、これまでに挙げた禁止事項(ヘイトスピーチ、暴力、性的コンテンツなど)に関連する単語や表現は、システムのフィルターによって検出される可能性があります。

文脈によっては問題ないと判断される場合もありますが、規約の趣旨に反するような不適切な目的で、意図的にこれらの言葉を使おうとすると、警告や利用制限の対象となることがあります。

重要なのは、単語そのものよりも、その利用目的が規約に違反していないかという点です。

無視は危険!ChatGPT利用規約違反を犯した場合の罰則

ChatGPTの利用規約に違反した場合、どのようなペナルティが科されるのでしょうか。ここでは、違反の程度に応じて取られる可能性のある措置について解説します。

- メールでの警告と一時的な利用制限

- アカウントの一時停止と解除の手順

- アカウントの永久停止とその深刻な影響

- 法的措置に発展する可能性

軽い気持ちでの違反が、深刻な結果を招くこともあります。しっかりと理解しておきましょう。

メールでの警告と一時的な利用制限

利用規約違反が初めてであったり、比較的軽微であったりする場合、まずはOpenAIから登録したメールアドレス宛に警告通知が送られてくることが一般的です。

この警告メールには、どの行為が規約のどの部分に違反しているかが記載されています。

同時に、問題のあるコンテンツの生成を制限されたり、一定期間APIの利用が制限されたりするなど、一部機能が使えなくなることもあります。この段階で違反行為を止め、利用方法を改めれば、より厳しい措置に進むことは避けられる可能性が高いです。

アカウントの一時停止と解除の手順

警告を無視して違反を繰り返したり、中程度以上の規約違反を犯したりした場合には、アカウントが一時的に停止されることがあります。

アカウントが停止されると、ChatGPTへのログイン自体ができなくなります。停止期間は違反の内容によって異なります。

もし、停止措置に不服がある場合や、誤解に基づくと考える場合は、OpenAIのヘルプセンターなどを通じて異議申し立てを行うことができます。その際は、規約違反をしていないことを具体的に説明する必要がありますが、解除される保証はありません。

アカウントの永久停止とその深刻な影響

犯罪行為への加担や、重大な権利侵害、度重なる警告の無視など、悪質と判断された規約違反に対しては、アカウントの永久停止という最も重い罰則が科されます。

この場合、アカウントは二度と利用できなくなり、APIキーも無効化されます。ビジネスで利用していた場合、業務に深刻な支障をきたす可能性があります。

また、永久停止されたユーザーは、新しいアカウントを作成することも禁止されることが多く、事実上、OpenAIのサービスから追放されることになります。これまでの利用履歴やデータにもアクセスできなくなるため、その影響は計り知れません。

こちらは、OpenAIがアカウント停止の理由について説明している公式のヘルプページです。合わせてご覧ください。 https://help.openai.com/en/articles/10562188-why-was-my-openai-account-deactivated

法的措置に発展する可能性

利用規約違反の内容が、単なるルール違反にとどまらず、著作権侵害、名誉毀損、詐欺、サイバー攻撃など、国内外の法律に抵触する場合には、OpenAIからの措置だけでなく、法的な問題に発展する可能性があります。

被害を受けた第三者から損害賠償請求訴訟を起こされたり、犯罪行為であれば捜査機関による調査の対象となったりするリスクも考えられます。

利用規約はOpenAIとの契約であると同時に、社会の法律やルールを守るための最低限の指標でもあることを忘れてはなりません。

知らないと怖いChatGPT利用規約違反がもたらす企業・個人のリスク7選

利用規約違反は、アカウント停止だけでなく、企業や個人にさまざまな実害をもたらす可能性があります。ここでは、特に注意すべき7つのリスクについて解説します。

①機密情報・個人情報の漏洩

②プロンプトインジェクションによるセキュリティ侵害

③著作権・商標権侵害による訴訟

④ハルシネーション(誤情報)による信用の失墜

⑤ディープフェイクによる社会的混乱

⑥倫理的に不適切なアウトプットによるブランドイメージの低下

⑦従業員の過信による重大な業務ミス

これらのリスクを理解し、適切な対策を講じることが重要です。

①機密情報・個人情報の漏洩

企業がChatGPTを利用する上で最大のリスクの一つが、機密情報や個人情報の漏洩です。

従業員が業務上の機密情報、顧客データ、非公開のソースコードなどをChatGPTに入力してしまうと、それらの情報がOpenAIのサーバーに送信され、AIの学習データとして利用される可能性があります。

これにより、意図せず情報が外部に流出し、他社のユーザーへの回答に含まれてしまうといった事態も考えられます。一度漏洩した情報は取り戻すことが極めて困難であり、企業の競争力や社会的信用に深刻なダメージを与えます。

こちらは、サムスン電子で発生した機密情報漏洩インシデントについて、その詳細を報じた記事です。合わせてご覧ください。 https://www.ciodive.com/news/Samsung-Electronics-ChatGPT-leak-data-privacy/647137/

②プロンプトインジェクションによるセキュリティ侵害

プロンプトインジェクションとは、攻撃者が悪意のある特殊な指示(プロンプト)をAIに与えることで、開発者が意図しない動作をさせ、機密情報を引き出したり、システムを乗っ取ったりするサイバー攻撃の一種です。

例えば、ChatGPTを組み込んだ自社のチャットボットサービスがこの攻撃を受けると、本来は非公開であるはずのデータベースの情報などを外部に漏らしてしまう危険性があります。

AIを外部サービスと連携させる際には、このような新たなセキュリティリスクにも十分な対策が必要です。

こちらは、LLM(大規模言語モデル)アプリケーションにおけるセキュリティリスクを専門的にまとめたプロジェクト「OWASP Top 10 for LLM」の公式サイトです。合わせてご覧ください。 https://owasp.org/www-project-top-10-for-large-language-model-applications/

③著作権・商標権侵害による訴訟

ChatGPTが生成した文章、画像、コードなどが、既存の著作物や商標と酷似していた場合、意図せず著作権や商標権を侵害してしまうリスクがあります。

AIはインターネット上の膨大なデータを学習しているため、その過程で学習した特定のコンテンツに類似したものを出力することがあります。

それを知らずに自社のウェブサイトや製品に使用した場合、権利者から利用の差し止めや損害賠償を求める訴訟を起こされる可能性があります。生成物を公開する前には、必ず独自性の確認が必要です。

こちらは、ニューヨーク・タイムズがOpenAIを著作権侵害で提訴した件について、ハーバード大学の法律レビューで分析された記事です。合わせてご覧ください。 https://harvardlawreview.org/blog/2024/04/nyt-v-openai-the-timess-about-face/

④ハルシネーション(誤情報)による信用の失墜

ハルシネーションとは、AIが事実に基づかない、もっともらしい嘘の情報を生成してしまう現象です。ChatGPTの回答は常に正しいとは限りません。

このハルシネーションによって生成された誤った情報を、ファクトチェックせずにそのまま社内資料や顧客への回答、公開記事などに利用してしまうと、企業の信用を大きく損なうことになります。

特に、統計データや専門的な情報に関しては、必ず信頼できる情報源で裏付けを取るプロセスが不可欠です。

こちらは、ChatGPTのハルシネーション(誤情報)を防ぐ具体的な方法について解説した記事です。合わせてご覧ください。

⑤ディープフェイクによる社会的混乱

悪意を持った第三者がChatGPTなどの生成AIを使い、企業の代表者や政治家などの偽の画像や動画(ディープフェイク)を作成し、ネガティブな情報を発信した場合、社会的な混乱や企業の株価下落などを引き起こすリスクがあります。

自社が直接の加害者でなくても、このような攻撃の標的となる可能性があります。

偽情報がSNSなどで急速に拡散される現代において、企業はこうした新たなレピュテーションリスクにも備え、迅速に対応できる体制を整えておくことが求められます。

⑥倫理的に不適切なアウトプットによるブランドイメージの低下

ChatGPTが、意図せず差別的、偏見に満ちた、あるいは倫理的に問題のあるコンテンツを生成してしまう可能性はゼロではありません。

これは、AIが学習したデータに含まれる社会的なバイアスを反映してしまうために起こります。

もし企業が提供するサービスやマーケティング活動において、このような不適切なアウトプットが外部に出てしまった場合、「倫理観のない企業」というレッテルを貼られ、ブランドイメージが大きく傷つく可能性があります。AIの出力は、人間の目による倫理的なチェックが必須です。

⑦従業員の過信による重大な業務ミス

ChatGPTの便利さゆえに、従業員がその回答を過信し、鵜呑みにしてしまうリスクがあります。

例えば、プログラムのコードを生成させて、十分なテストやレビューを行わずに本番環境に実装してしまい、システム障害を引き起こすケース。

あるいは、法務や経理に関する質問の回答を信じ込み、誤った契約手続きや会計処理を行ってしまうケースなどが考えられます。AIはあくまで業務を補助するツールであり、最終的な判断と責任は人間が負うべきであるという意識の徹底が必要です。

【国内外】実際に起きたChatGPT利用規約違反の問題事例

ここでは、ChatGPTの利用に関連して実際に発生した、国内外の注目すべき問題事例を紹介します。

事例①:サムスン電子での社内ソースコード流出

事例②:ニューヨーク・タイムズによる著作権侵害訴訟

事例③:米国の作家らによる著作物学習に関する集団訴訟

事例④:国内外の大学における利用禁止やガイドライン策定の動き

事例⑤:日本国内企業での利用禁止やAIポリシー策定の現状

これらの事例は、利用規約違反や不適切な利用がもたらすリスクを具体的に示しています。

事例①:サムスン電子での社内ソースコード流出

2023年、韓国の大手電機メーカーであるサムスン電子で、従業員が業務上の機密情報をChatGPTに入力してしまったことで、社内のソースコードや会議の議事録が外部に流出したとされる事例が発生しました。

従業員がプログラムのデバッグや資料の要約といった目的で、機密と認識しながらも安易にChatGPTを利用したことが原因と見られています。

この事件をきっかけに、同社は社内での生成AI利用を厳しく制限することになりました。これは、機密情報漏洩リスクの典型的な事例として世界的に知られています。

事例②:ニューヨーク・タイムズによる著作権侵害訴訟

2023年12月、米国の有力紙ニューヨーク・タイムズが、自社の記事が著作権を無視してChatGPTの学習に大量に利用され、その結果、ChatGPTが記事をほぼそのまま出力できる状態になっているとして、OpenAIとマイクロソフトを相手取り訴訟を起こしました。

これは、生成AIの学習データと、その出力結果における著作権のあり方が問われた象徴的な事例です。

この訴訟の行方は、今後のAI開発とコンテンツ権利者の関係に大きな影響を与えるものとして、世界中から注目されています。

事例③:米国の作家らによる著作物学習に関する集団訴訟

ニューヨーク・タイムズの事例と同様に、米国ではサラ・シルバーマンなどの著名な作家やコメディアンらが、自身の著作物が許可なくAIの学習データとして使用されたことは著作権侵害にあたるとして、OpenAIなどに対し集団訴訟を起こしています。

作家たちは、AIが自分たちの作風を模倣したコンテンツを生成できるようになることで、自らの創作活動や経済的利益が脅かされると主張しています。

これもまた、AIの学習プロセスにおける著作物の公正な利用(フェアユース)の範囲がどこまで認められるのかという、根本的な問題を投げかけています。

事例④:国内外の大学における利用禁止やガイドライン策定の動き

教育現場では、学生がレポート作成などでChatGPTを不正に利用することを懸念し、利用を全面的に禁止したり、厳格なガイドラインを設けたりする動きが広がっています。

例えば、米国のいくつかの学区や、日本の大学でも東京大学などが早い段階でAI利用に関する注意喚起や方針を発表しました。

一方で、AIを完全に排除するのではなく、批判的思考を養うためのツールとして、いかに教育にうまく取り入れていくかという議論も活発に行われており、各教育機関で対応が分かれているのが現状です。

事例⑤:日本国内企業での利用禁止やAIポリシー策定の現状

サムスン電子の事例などを受け、日本国内でも多くの企業が生成AIの利用に関するリスクを認識し、対応を進めています。

一部の企業では、情報漏洩リスクを重く見て、業務におけるChatGPTなどの外部生成AIサービスの利用を全面的に禁止する措置を取りました。

また、全面禁止ではなく、利用目的や入力してはいけない情報の種類などを定めた社内向けの「AI利用ガイドライン」を策定し、従業員に周知徹底することで、リスクを管理しながら安全な活用を目指す企業も増えています。

【実践編】ChatGPT利用規約違反を回避するための6つの具体的対策

これまで見てきたようなリスクや規約違反を回避し、ChatGPTを安全に活用するためには、どのような対策を講じればよいのでしょうか。ここでは、すぐに実践できる6つの具体的な対策を紹介します。

①社内・組織向けの利用ガイドラインを策定・周知徹底する

②入力する情報(プロンプト)を精査し機密情報を含めない

③生成されたアウトプットのファクトチェックと編集を徹底する

④従業員・個人のAIリテラシー向上のための研修を実施する

⑤API連携やセキュリティの高い法人向けプランを検討する

⑥利用規約の変更を定期的に確認し最新情報をキャッチアップする

これらの対策を組み合わせることで、リスクを大幅に低減できます。

①社内・組織向けの利用ガイドラインを策定・周知徹底する

企業や組織としてChatGPTを導入する場合、まず最初に行うべきは、利用に関する明確なルールを定めたガイドラインの策定です。

このガイドラインには、利用目的の範囲、入力が禁止される情報(個人情報、顧客情報、機密情報など)の具体例、生成物の取り扱い方法(ファクトチェックの義務、著作権の確認など)、そして規約違反時の罰則などを明記します。

作成したガイドラインは、全従業員に配布し、研修などを通じてその内容を周知徹底させることが不可欠です。

こちらは、日本政府(デジタル庁)が策定した生成AIの利用に関するガイドラインです。公的な指針として参考になりますので、合わせてご覧ください。 https://www.digital.go.jp/assets/contents/node/basic_page/field_ref_resources/e2a06143-ed29-4f1d-9c31-0f06fca67afc/6e45a64f/20250527_resources_standard_guidelines_guideline_04.pdf

②入力する情報(プロンプト)を精査し機密情報を含めない

最も基本的かつ重要な対策は、ChatGPTに入力する情報、つまりプロンプトの内容を常に意識し、機密情報や個人情報を一切含めないことです。

これは個人の利用においても同様です。情報を入力する前に、「この情報は外部に漏れても問題ないか?」と自問自答する習慣をつけましょう。

どうしても社内データなどを扱いたい場合は、具体的な情報を抽象化したり、ダミーデータに置き換えたりするなどの工夫が必要です。情報漏洩は、一度起こると取り返しがつきません。

③生成されたアウトプアウトのファクトチェックと編集を徹底する

ChatGPTが生成した文章や情報を、そのまま鵜呑みにせず、必ずファクトチェックを行うことが重要です。特に、統計データ、歴史的な事実、専門的な知識に関する内容は、信頼できる公的な情報源や専門家のウェブサイトで裏付けを取りましょう。

また、著作権侵害を避けるため、生成された文章が他の文献と酷似していないか、コピペチェックツールなどを使って確認することも有効です。

最終的には、AIの出力をそのまま使うのではなく、自身の言葉で編集・加筆修正し、オリジナリティのあるコンテンツに仕上げることを心がけましょう。

④従業員・個人のAIリテラシー向上のための研修を実施する

ガイドラインを作成するだけでなく、従業員一人ひとりがAIの特性とリスクを正しく理解するための研修を実施することが効果的です。

研修では、利用規約の具体的な内容、ハルシネーションやバイアスの仕組み、プロンプトインジェクションといったセキュリティリスク、そして実際に起きた事故事例などを共有します。

こうした教育を通じて、従業員が「AIは便利なツールだが、万能ではなくリスクも伴う」という認識を持つことで、無防備な利用による事故を未然に防ぐことができます。

⑤API連携やセキュリティの高い法人向けプランを検討する

企業の機密情報を扱いながらChatGPTの能力を活用したい場合、ウェブブラウザ版の無料・有料プランではなく、よりセキュリティの高い選択肢を検討すべきです。

一つは、API(Application Programming Interface)を利用する方法です。API経由で送信されたデータは、ユーザーがオプトアウトすれば、デフォルトでAIモデルの学習には使用されないとされています。

また、OpenAIが提供する「ChatGPT Enterprise」などの法人向けプランは、入力データの非学習利用の保証や、高度なセキュリティ管理機能が備わっており、企業利用に適しています。

こちらは、セキュリティの高い法人向けプランを含む、ChatGPTの企業導入について網羅的に解説した記事です。合わせてご覧ください。

⑥利用規約の変更を定期的に確認し最新情報をキャッチアップする

OpenAIの利用規約やポリシーは、技術の進歩や社会情勢の変化に対応するため、随時更新される可能性があります。

一度確認したからといって安心せず、定期的に公式サイトの利用規約ページやポリシーページを訪れ、変更点がないかを確認する習慣をつけることが望ましいです。

また、OpenAIの公式ブログや、信頼できるITニュースサイトなどをチェックすることで、AIに関する最新の動向や新たなリスクについての情報を得ることができます。常に知識をアップデートし続けることが、安全な利用につながります。

【業界別】特に注意すべきChatGPT利用規約違反のポイント

ChatGPTの利用規約は全てのユーザーに適用されますが、特に専門性の高い特定の業界では、注意すべき独自のポイントが存在します。

- 医療分野での利用制約と患者情報の取り扱い

- 金融分野での機密データと投資アドバイスのリスク

- 法律分野での弁護士秘匿特権と判例の正確性

これらの業界でChatGPTを利用する際には、一般的な注意点に加えて、それぞれの分野特有の規制や倫理を遵守する必要があります。

医療分野での利用制約と患者情報の取り扱い

医療分野では、患者のプライバシー保護が最優先されます。患者の氏名、病歴、治療内容といった個人医療情報をChatGPTに入力することは、医療法や個人情報保護法に抵触する可能性が極めて高く、絶対に行ってはなりません。

また、ChatGPTに病状を相談し、診断や治療法を尋ねる行為も規約で禁止されています。

AIは医療資格を持っておらず、誤った情報を提供した場合、患者の生命や健康に深刻な影響を及ぼす危険があります。医療に関する判断は、必ず医師や有資格者の指示に従う必要があります。

金融分野での機密データと投資アドバイスのリスク

金融分野では、顧客の口座情報、資産状況、取引履歴といった機密性の高いデータを取り扱います。これらの情報をChatGPTに入力することは、重大な情報漏洩インシデントにつながるため厳禁です。

また、特定の金融商品の購入を勧めたり、相場を予測したりといった、個別具体的な投資アドバイスを生成させることも規約で禁止されています。

金融商品取引法などにより、投資助言は登録を受けた専門家でなければ行うことができません。市場分析の補助として利用する場合でも、最終的な投資判断は自己責任で行う必要があります。

法律分野での弁護士秘匿特権と判例の正確性

法律分野では、弁護士と依頼者の間の通信内容を保護する「弁護士秘匿特権(守秘義務)」が極めて重要です。依頼者との相談内容や事件に関する機密情報をChatGPTに入力した場合、この守秘義務に違反する可能性があります。

また、ChatGPTに判例や法令のリサーチをさせると、存在しない判例を生成したり(ハルシネーション)、古い法令を提示したりすることがあります。

法的な文書作成やリサーチの補助として利用する際は、必ず公式なデータベースで情報の正確性を検証し、最終的な法的判断は弁護士などの専門家が行わなければなりません。

ChatGPT利用規約違反に関するよくある質問(Q&A)

ここでは、ChatGPTの利用規約に関して、多くの人が抱きがちな疑問点についてQ&A形式で回答します。

- 商用利用は利用規約違反になりますか?

- 生成した文章や画像の著作権は誰にありますか?

- アカウント停止の警告が来たらどうすればいいですか?

- 日本語の利用規約はどこで確認できますか?

- 法人契約の場合の注意点はありますか?

これらの回答を参考に、疑問点をクリアにしておきましょう。

商用利用は利用規約違反になりますか?

いいえ、基本的には利用規約違反にはなりません。OpenAIの利用規約では、ChatGPTで生成したコンテンツ(文章、画像など)を商用利用(ブログ記事、マーケティングコピー、製品開発など)することが許可されています。

ただし、生成されたコンテンツが他者の著作権を侵害していないか、また、規約で禁止されている用途(違法行為、ヘイトスピーチなど)に該当しないかを確認する責任は、利用者自身にあります。

商用利用する際は、特に内容の独自性と正確性に注意が必要です。

生成した文章や画像の著作権は誰にありますか?

OpenAIの利用規約(Terms of Use)によると、規約を遵守している限り、ChatGPTが生成したコンテンツに対する所有権は、そのコンテンツを生成したユーザーに譲渡されると定められています。

したがって、生成物の著作権は基本的にユーザーに帰属します。

ただし、注意点として、生成物が既存の著作物と酷似している場合、第三者の著作権を侵害する可能性があります。また、AI生成物の著作権の扱いは、国や地域の法律によって解釈が異なる場合があるため、法的な保護が完全に保証されるわけではない点に留意が必要です。

著作権侵害を含む、生成AIの企業利用に伴う様々なリスクとその対策については、こちらの記事で詳しく解説しています。合わせてご覧ください。

アカウント停止の警告が来たらどうすればいいですか?

まず、慌てずに警告メールの内容をよく読んでください。どの行為が利用規約のどの条項に違反したと指摘されているかを確認します。

指摘された行為に心当たりがある場合は、直ちにその利用を中止してください。もし、警告内容に納得がいかない場合や、システムのエラーだと思われる場合は、OpenAIが指定する手順に従って異議申し立てを行うことができます。

いずれにせよ、警告を無視することは最も避けるべきです。誠実に対応することが、アカウントの永久停止といった最悪の事態を防ぐ鍵となります。

日本語の利用規約はどこで確認できますか?

OpenAIの公式サイトにある利用規約(Terms of Use)や利用ポリシー(Usage policies)のページは、基本的に英語で書かれています。

しかし、多くのウェブブラウザには翻訳機能が搭載されているため、ページ全体を日本語に翻訳して内容を確認することが可能です。ただし、機械翻訳のため、細かなニュアンスが正確でない可能性もあります。

法的な解釈など、正確性を期す必要がある場合は、原文である英語の規約を確認するか、専門家に相談することをお勧めします。

こちらは、OpenAIの公式サイトで公開されている利用規約(グローバル規約準拠)の日本語版です。合わせてご覧ください。 https://openai.com/ja-JP/policies/row-terms-of-use/

法人契約の場合の注意点はありますか?

法人契約(ChatGPT Enterpriseなど)を締結する場合、通常の利用規約に加えて、法人向けの契約内容が適用されます。

注意点としては、まずセキュリティ設定です。入力したデータがAIの学習に使われない(ゼロリテンション)設定になっているかを確認することが最も重要です。

また、契約によって利用できるユーザー数や機能が異なりますので、自社のニーズに合ったプランを選択する必要があります。そして、契約後も、従業員全員が社内の利用ガイドラインを遵守するよう、継続的な教育と管理体制の構築が不可欠です。

ChatGPT利用規約違反を正しく理解し安全に活用しよう

この記事では、ChatGPTの利用規約違反について、具体的な禁止事項からリスク、事例、そして実践的な対策まで幅広く解説してきました。最後に、安全な活用のためのポイントを再確認しましょう。

ChatGPT利用規約違反を回避するための最終チェックリスト

ChatGPTを利用する前に、常に以下の点を確認する習慣をつけましょう。

- 個人情報や会社の機密情報を入力しようとしていないか?

- 差別的、暴力的、違法なコンテンツの生成を指示していないか?

- 著作権や他者の権利を侵害するような使い方ではないか?

- 生成された情報は鵜呑みにせず、ファクトチェックを行う準備はできているか?

- 医療、法律、金融など、専門家のアドバイスの代わりとして使おうとしていないか?

このチェックリストを意識するだけで、意図しない規約違反のリスクを大幅に減らすことができます。

最新の規約アップデート情報を確認する方法

ChatGPTの利用規約やポリシーは、今後も更新される可能性があります。最新の情報を得るためには、OpenAIの公式サイトにある「Terms of Use」や「Usage policies」のページを定期的に確認することが最も確実です。

また、OpenAIの公式ブログでは、新機能の発表とともにポリシーに関する重要なアナウンスが行われることもあるため、併せてチェックすることをお勧めします。

継続的な学習と安全な活用のための推奨プラクティス

ChatGPTは非常に強力で便利なツールですが、万能ではありません。常にその限界とリスクを理解し、批判的な視点を持って利用することが重要です。

AIの出力を鵜呑みにせず、最終的な判断と責任は人間が持つという原則を忘れないでください。

利用規約を遵守することは、自分自身や組織を不要なトラブルから守るだけでなく、AIという技術が社会と健全な関係を築いていくために、すべての利用者に課せられた責任でもあります。本記事で得た知識を活かし、安全かつ効果的にChatGPTを活用していきましょう。

ChatGPTの落とし穴:「便利」が「違法」に変わる瞬間

ChatGPTを業務で使うのが当たり前になった今、「その使い方、実は会社の存続を揺るしかねない危険な行為かもしれない」と聞いたら、あなたはどう思いますか?便利なチャットの裏側には、情報漏洩や著作権侵害といった、気づきにくい法的な落とし穴が潜んでいます。実際に、世界的な大企業が従業員の安易な利用によって機密情報を流出させたり、大手メディアが自社のコンテンツを無断で学習データに使われたとして訴訟を起こしたりする事件が後を絶ちません。この記事では、あなたの会社が「知らなかった」では済まされないChatGPTのリスクと、その具体的な対策を解説します。

会社の信用を失う「コピペ感覚」の危険性

「ChatGPTに会社の資料を読み込ませて、要約や翻訳をさせれば効率的だ」——。もしそう考えているなら、非常に危険なサインです。あなたや従業員が入力した機密情報や顧客データは、AIの学習データとして利用され、意図せず外部に漏洩するリスクを常に抱えています。サムスン電子では、従業員が機密情報を含むソースコードをChatGPTに入力してしまい、問題となりました。

また、「AIが作った文章だから著作権は問題ない」というのも大きな誤解です。AIはインターネット上の膨大な情報を学習しているため、生成された文章や画像が、既存の著作物と酷似してしまうことがあります。ニューヨーク・タイムズは、自社の記事が許可なく大量に学習データとして利用され、著作権を侵害されたとしてOpenAI社を提訴しました。このような法的リスクは、企業のブランドイメージや信頼を根底から覆しかねないのです。

引用元:

サムスン電子は、従業員が機密性の高いコードをプラットフォームにアップロードした後、ChatGPTやその他の生成AIツールの社内での使用を禁止しました。(Bloomberg, “Samsung Bans Use of Generative AI Tools Like ChatGPT After Leak”, 2023年5月2日)

ニューヨーク・タイムズは、同社の数百万の記事がChatGPTのようなチャットボットを訓練するために不正利用されたとして、OpenAIとマイクロソフトを著作権侵害で提訴しました。(Reuters, “New York Times sues OpenAI, Microsoft for infringing its copyright”, 2023年12月27日)

まとめ

企業は業務効率化の切り札として生成AIの活用に注目していますが、その裏側には利用規約違反や情報漏洩、著作権侵害といった深刻なセキュリティリスクが潜んでいます。

しかし、実際には「従業員の利用をどう管理すればいいかわからない」「安全な利用環境を構築するノウハウがない」といった理由で、本格的な導入に踏み切れない企業も少なくありません。

そこでおすすめしたいのが、Taskhubです。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「何をどう使えばいいのかわからない」という初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプログラミングや高度なAI知識がなくても、すぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最速の生成AI活用”を体験し、御社のDXを一気に加速させましょう。