「自社でも生成AIを導入したいが、どんなリスクがあるのか不安…」

「生成AIのリスク対策と言われても、何から手をつければ良いかわからない…」

こういった悩みを持っている方もいるのではないでしょうか?

本記事では、企業が生成AIを活用する上で直面する9つの具体的なリスクと、それぞれの立場から見たリスクの違い、そして今日から始められる具体的な対策について詳しく解説しました。

生成AIの導入を検討している、あるいはすでに利用しているがリスク管理に課題を感じている企業様にとって、必ず役立つ情報が満載です。

ぜひ最後までご覧いただき、安全なAI活用の第一歩を踏み出してください。

企業が直面する生成AIのリスクとは?

生成AIは業務効率化や新たな価値創造に大きく貢献する一方で、多くの潜在的なリスクを抱えています。

これらのリスクを正しく理解し、事前に対策を講じることが、企業の持続的な成長には不可欠です。

ここからは、企業が直面する可能性のある、生成AIの代表的なリスクを7つ紹介します。

- 機密情報や個人情報の漏洩リスク

- 著作権や商標権の侵害リスク

- サイバー攻撃の標的になるリスク

- AIが生成した誤情報・不正確な情報のリスク

- AIの学習データによる偏見(バイアス)のリスク

- フェイクコンテンツ生成による悪用のリスク

- 従業員の創造性低下のリスク

それでは、1つずつ順に解説します。

機密情報や個人情報の漏洩リスク

生成AIの利用において最も懸念されるのが、機密情報や個人情報の漏洩リスクです。

従業員が業務上の機密情報や顧客の個人情報をプロンプトとして入力した場合、そのデータがAIモデルの学習に利用され、意図せず第三者への回答として出力されてしまう可能性があります。

特に、多くの一般向け生成AIサービスでは、入力されたデータがサービス改善のために利用されることが利用規約に明記されています。

また、API連携で自社システムに生成AIを組み込む場合でも、通信経路やAIサービス提供者のセキュリティ対策が不十分であれば、情報漏洩に繋がる恐れがあります。

一度漏洩した情報は完全な削除が困難であり、企業の社会的信用の失墜や、重大な損害賠償問題に発展する可能性があります。

著作権や商標権の侵害リスク

生成AIが生成した文章、画像、音楽などが、既存の著作物や登録商標と酷似してしまうことで、意図せず権利を侵害してしまうリスクがあります。

生成AIは、インターネット上の膨大なデータを学習してコンテンツを生成しますが、その学習データに著作物が含まれている場合、生成物が学習元の著作物に類似する可能性があるのです。

生成物を利用した結果、著作権者や商標権者から訴訟を起こされた場合、企業のブランドイメージが損なわれるだけでなく、法的な責任を問われることになります。

特に、商用利用を目的とする場合は、生成されたコンテンツが他者の権利を侵害していないか、慎重に確認するプロセスが不可欠です。

サイバー攻撃の標的になるリスク

生成AIの技術は、サイバー攻撃をより巧妙化、高度化させるためにも悪用される可能性があります。

例えば、過去のメール文面を学習させることで、個人に最適化された極めて見分けのつきにくいフィッシングメールを大量に自動生成することが可能です。

また、ソフトウェアの脆弱性を発見・分析するために生成AIが悪用され、サイバー攻撃の起点とされるケースも考えられます。

さらに、生成AIを導入している企業自体が攻撃の標的になることもあります。

AIシステムの制御を乗っ取る、あるいは敵対的なデータを入力して誤作動を誘発させるような新たな攻撃手法も登場しており、従来のセキュリティ対策だけでは防ぎきれない可能性があります。

こちらは、日本のAIセーフティ・インスティテュートが、AIシステムに対する既知の攻撃手法を整理した公式資料です。合わせてご覧ください。 https://aisi.go.jp/assets/pdf/20240604_sanko2.pdf

AIが生成した誤情報・不正確な情報のリスク

生成AIは、時に「ハルシネーション(幻覚)」と呼ばれる、事実に基づかないもっともらしい嘘の情報を生成することがあります。

これはAIの仕組みに起因するものであり、現時点では完全になくすことは困難です。

従業員がAIの生成した誤情報を信じ込み、それを基に顧客対応や意思決定を行ってしまった場合、企業の信頼を損なうだけでなく、ビジネス上の大きな損失に繋がる可能性があります。

特に、専門的な知識や正確性が求められる分野で生成AIを利用する際には、必ず人間の専門家によるファクトチェックを行う体制を構築することが重要です。

AIの回答はあくまで参考情報として位置づけ、鵜呑みにしないという意識を社内全体で共有する必要があります。

こちらはChatGPTのハルシネーションを防ぐ方法について解説した記事です。合わせてご覧ください。 https://taskhub.jp/use-case/chatgpt-prevent-hallucination/

AIの学習データによる偏見(バイアス)のリスク

生成AIは、学習データに含まれる社会的・文化的な偏見や差別的な表現をそのまま学習し、出力に反映してしまうリスクがあります。

例えば、特定の性別や人種に対する固定観念に基づいた文章を生成したり、採用活動の書類選考でAIを利用した際に、過去のデータから無意識のバイアスを学習し、不公平な判断を下したりする可能性があります。

このような偏見を含んだAIの出力を企業が利用することは、倫理的な問題に発展するだけでなく、企業の評判を大きく傷つけ、顧客や従業員からの信頼を失う原因となります。

AIの導入にあたっては、学習データにどのようなバイアスが含まれうるかを検討し、出力結果を多角的に検証する仕組みが求められます。

フェイクコンテンツ生成による悪用のリスク

生成AI技術、特にディープフェイクと呼ばれる画像・音声合成技術は、悪意を持って使用されると深刻なリスクをもたらします。

例えば、企業の役員や著名人の偽の動画や音声を作成し、株価操作や詐欺行為に利用したり、企業の製品に関する虚偽の情報を拡散してブランドイメージを毀損したりするケースが考えられます。

これらのフェイクコンテンツは非常に精巧に作られているため、多くの人が本物と信じてしまい、瞬く間に情報が拡散してしまう危険性があります。

自社に関するネガティブなフェイクコンテンツが生成された場合に備え、平時からソーシャルメディアの監視体制を整え、迅速に事実関係を公表できる準備をしておくことが重要です。

従業員の創造性低下のリスク

生成AIの活用が常態化することで、従業員がAIに過度に依存し、自ら思考したり、創造性を発揮したりする機会が失われるリスクも指摘されています。

レポート作成やアイデア出しといった業務をすべてAIに任せてしまうと、問題解決能力や批判的思考力が低下する恐れがあります。

短期的には業務効率が向上するかもしれませんが、長期的には、企業のイノベーションの源泉である従業員の創造性が損なわれ、競争力の低下に繋がる可能性があります。

生成AIはあくまで思考を補助するツールとして位置づけ、最終的な判断や創造的な部分は人間が担うという役割分担を明確にすることが、従業員のスキル維持・向上のために重要です。

リスクのない生成AI導入を実現したい方は、こちらの記事を必ずご覧ください。総合生成AIコンサルティングファームとして大手企業含む多くの企業へのAI導入を成功させている弊社が、生成AI企業100社と、導入方法など、生成AI導入に関することを網羅的に解説しております。

【立場別】生成AIが企業にもたらすリスク

生成AIがもたらすリスクは、企業がどのような立場で関わるかによってその性質が異なります。

ここでは、企業が直面するリスクを以下の3つの立場に分けて整理します。

- 利用者としての企業の生成AIリスク

- サービス提供者としての企業の生成AIリスク

- 社会全体から見た企業の生成AIリスク

それぞれの立場でどのようなリスクが想定されるのかを理解することで、より網羅的な対策を検討できるようになります。

利用者としての企業の生成AIリスク

生成AIを業務で利用する企業にとってのリスクは、主に入力データと出力データの両面に存在します。

入力データに関する最大のリスクは、前述した「機密情報や個人情報の漏洩」です。

従業員が社内情報などを安易に入力してしまうことで、情報が外部に流出し、学習データとして利用される危険性があります。

一方、出力データに関しては、「誤情報のリスク」や「著作権侵害のリスク」が挙げられます。

AIが生成した不正確な情報を基に誤った経営判断を下したり、生成されたコンテンツが他者の権利を侵害していたりする可能性を常に念頭に置く必要があります。

これらのリスクを管理するためには、社内での利用ルールを明確に定め、従業員への教育を徹底することが不可欠です。

サービス提供者としての企業の生成AIリスク

自社で生成AIを開発したり、生成AIを組み込んだサービスを提供したりする企業は、利用者側とは異なる種類のリスクに直面します。

まず、開発したAIが予期せぬ不適切なコンテンツを生成してしまうリスクがあります。

差別的な発言や暴力的なコンテンツなどを生成した場合、サービス提供者として社会的な非難を浴び、ブランドイメージが大きく損なわれます。

また、AIの判断によって利用者に損害が生じた場合、製造物責任法(PL法)などに基づき、法的な責任を問われる可能性も考えられます。

さらに、自社のサービスが第三者によって悪用されるリスクにも備えなければなりません。

悪意のあるユーザーがサービスを利用してフェイクニュースを拡散したり、サイバー攻撃を仕掛けたりする可能性を考慮し、不正利用を検知・防止する仕組みを構築することが重要です。

社会全体から見た企業の生成AIリスク

企業の生成AI活用は、社会全体に対しても広範な影響を及ぼす可能性があり、それに伴うリスクも存在します。

その一つが、雇用の喪失や格差の拡大です。

AIによって定型的な業務が自動化されることで、一部の職が失われる可能性が指摘されています。

また、AIを使いこなせる人材とそうでない人材との間に経済的な格差が広がる「デジタルデバイド」の問題も深刻化する恐れがあります。

さらに、生成AIが特定の価値観や思想に偏った情報を大量に生成・拡散することで、社会の分断を助長するリスクも懸念されています。

企業は自社の利益追求だけでなく、AI活用が社会に与える影響にも配慮し、倫理的な観点から事業活動を行う責任があります。

こうした社会的責任(CSR)を軽視すると、長期的に見て企業の評判や持続可能性を損なうことになりかねません。

今日からできる!生成AIの企業リスク対策

これまで見てきたように、生成AIには様々なリスクが伴いますが、適切な対策を講じることで、そのリスクを管理し、安全に活用することが可能です。

ここからは、企業が今日からでも始められる具体的なリスク対策を5つ紹介します。

- 社内ガイドラインの策定と周知徹底

- 情報セキュリティ体制の強化

- AIモデルの透明性と説明可能性の確保

- 生成AIに関する従業員教育の実施

- 定期的なリスクアセスメントの実行

これらの対策を組み合わせることで、堅牢なリスク管理体制を構築できます。

社内ガイドラインの策定と周知徹底

生成AIを安全に利用するための第一歩は、全従業員が遵守すべき社内ガイドラインを策定することです。

ガイドラインには、生成AIの利用目的や許可される業務範囲を明記し、どのような情報を入力してはいけないか(例:個人情報、顧客情報、未公開の財務情報など)を具体的に定義する必要があります。

また、生成されたコンテンツを業務で利用する際のルール、例えば著作権侵害のリスクを避けるための確認手順や、情報の正確性を検証するファクトチェックの義務化なども盛り込むべきです。

策定したガイドラインは、単に文書として保管するだけでなく、研修や定期的なアナウンスを通じて全従業員に周知徹底し、その重要性を理解してもらうことが不可欠です。

情報セキュリティ体制の強化

生成AIの利用に伴う情報漏洩やサイバー攻撃のリスクに備え、既存の情報セキュリティ体制を見直し、強化することが急務です。

具体的には、生成AIサービスへのアクセス管理を徹底し、許可された従業員のみが利用できるように設定します。

特に、機密情報を扱う可能性のある部署では、入力したデータが学習に利用されないビジネス向けのプランや、セキュリティが担保されたクローズドな環境で利用できるAIサービスを選択することが重要です。

また、API連携を利用する場合は、通信の暗号化や脆弱性診断を定期的に実施し、外部からの不正アクセスを防ぐ対策を講じる必要があります。

従業員が私物の端末で生成AIを利用する際のルール(シャドーIT対策)も明確にしておくべきでしょう。

AIモデルの透明性と説明可能性の確保

企業が重要な意思決定にAIを利用する場合、そのAIが「なぜその結論に至ったのか」を説明できることが非常に重要になります。

AIの判断プロセスがブラックボックス化していると、予期せぬエラーやバイアスが含まれていた場合でも、原因を特定し、修正することが困難になります。

これを避けるため、可能な限り判断根拠を可視化できる「説明可能なAI(XAI)」技術の導入を検討することが望ましいです。

また、自社でAIを開発する際には、どのような学習データを用いたのか、どのようなアルゴリズムで動作しているのかといった情報を記録し、透明性を確保することが求められます。

これにより、問題が発生した際にも迅速な原因究明と対応が可能となり、規制当局や顧客に対する説明責任を果たすことができます。

生成AIに関する従業員教育の実施

どれだけ優れたガイドラインやシステムを導入しても、最終的にAIを利用するのは従業員です。

そのため、従業員一人ひとりのAIリテラシーを向上させることが、リスク対策の根幹をなします。

研修では、生成AIの基本的な仕組みやメリットだけでなく、本記事で解説したような様々なリスク(情報漏洩、著作権、誤情報、バイアスなど)について具体例を交えながら詳しく説明します。

特に、どのようなプロンプトが危険であるか、生成された情報を鵜呑みにせず批判的に吟味する必要性などを強調することが重要です。

また、全社一律の研修だけでなく、開発部門、法務部門、人事部門など、部署の業務内容に応じた専門的な研修を実施することで、より実践的なリスク対応能力を養うことができます。

定期的なリスクアセスメントの実行

生成AIの技術は日進月歩で進化しており、それに伴って新たなリスクも次々と生まれています。

一度対策を講じたら終わりではなく、定期的にリスクアセスメント(リスクの特定・分析・評価)を実行し、管理体制を継続的に見直していくことが不可欠です。

リスクアセスメントでは、現在のAI利用状況を棚卸しし、新たな脆弱性や脅威が発生していないかを確認します。

社内で発生したインシデントやヒヤリハット事例を収集・分析することも有効です。

そして、評価結果に基づいて社内ガイドラインを更新したり、セキュリティ対策を強化したり、追加の従業員教育を実施したりと、PDCAサイクルを回していくことが重要です。

これにより、変化し続けるリスク環境に柔軟に対応し、常に安全なAI活用を維持することができます。

生成AIの企業リスクマネジメントの重要性

これまで見てきたように、生成AIの企業利用には、情報漏洩から人権侵害、ブランドイメージの毀損に至るまで、多岐にわたるリスクが伴います。

これらのリスクを軽視し、何の対策も講じずにAIの導入を進めることは、企業の存続そのものを脅かしかねない危険な行為です。

一方で、リスクを恐れるあまりAIの活用に踏み出せなければ、他社との競争から取り残されてしまうでしょう。

重要なのは、リスクをゼロにすることではなく、リスクを正しく理解し、許容できるレベルにまでコントロールする「リスクマネジメント」の視点です。

適切なガイドラインを設け、セキュリティを固め、従業員教育を徹底することで、リスクを管理しながらAIがもたらす恩恵を最大限に引き出すことができます。

攻め(AI活用による競争力強化)と守り(リスクマネジメント)の両輪をバランスよく回していくことこそが、これからの時代に企業が持続的に成長していくための鍵となるのです。

こちらは企業でのChatGPT導入に関する包括的なガイドです。合わせてご覧ください。 https://taskhub.jp/useful/chatgpt-for-companies/

生成AI導入の成否を分ける「AIガバナンス」とは?失敗しない体制構築の3つの要点

生成AIのリスク対策として社内ガイドラインの策定は不可欠ですが、それだけでは十分ではありません。ルールが形骸化せず、全社で安全かつ効果的にAIを活用し続けるためには、経営層から現場まで一貫した「AIガバナンス」の体制を構築することが成功の鍵を握ります。AIガバナンスとは、AIの開発・利用に関する原則や方針を定め、それを組織全体で実践・監督するための仕組みのことです。この体制がなければ、部門ごとにバラバラなルールでAIを利用してしまい、思わぬセキュリティインシデントや倫理的な問題を引き起こす可能性があります。ここでは、AIガバナンス体制を構築する上で特に重要な3つの要点を紹介します。

第一に、経営層が明確なビジョンと責任を持つことです。AI活用を単なる現場の業務改善ツールと捉えるのではなく、経営戦略の根幹に関わる重要事項として位置づけ、トップがその方針と責任の所在を内外に示す必要があります。

第二に、部門横断型の専門チームを設置することです。法務、IT、人事、そして実際にAIを利用する事業部門など、多様な知見を持つメンバーで構成されるチームが、ガイドラインの策定・更新、利用状況のモニタリング、従業員からの相談対応などを担います。

そして第三に、継続的な教育とモニタリングの仕組みを組み込むことです。AI技術や社会のルールは常に変化するため、一度作った体制に安住するのではなく、定期的な研修で従業員のリテラシーを維持し、AIの利用状況を監査してリスクの兆候を早期に発見するPDCAサイクルを回し続けることが不可欠です。

引用元:

総務省および経済産業省は、AI開発者、AI提供者、AI利用者といった関係者が留意すべき事項をまとめた「AI事業者ガイドライン(第1.0版)」を公表しています。この中では、AIガバナンスの重要性や、人権の尊重、安全性、公平性、プライバシー保護といったAI開発・利用における基本理念が示されています。(総務省・経済産業省「AI事業者ガイドライン案」2024年)

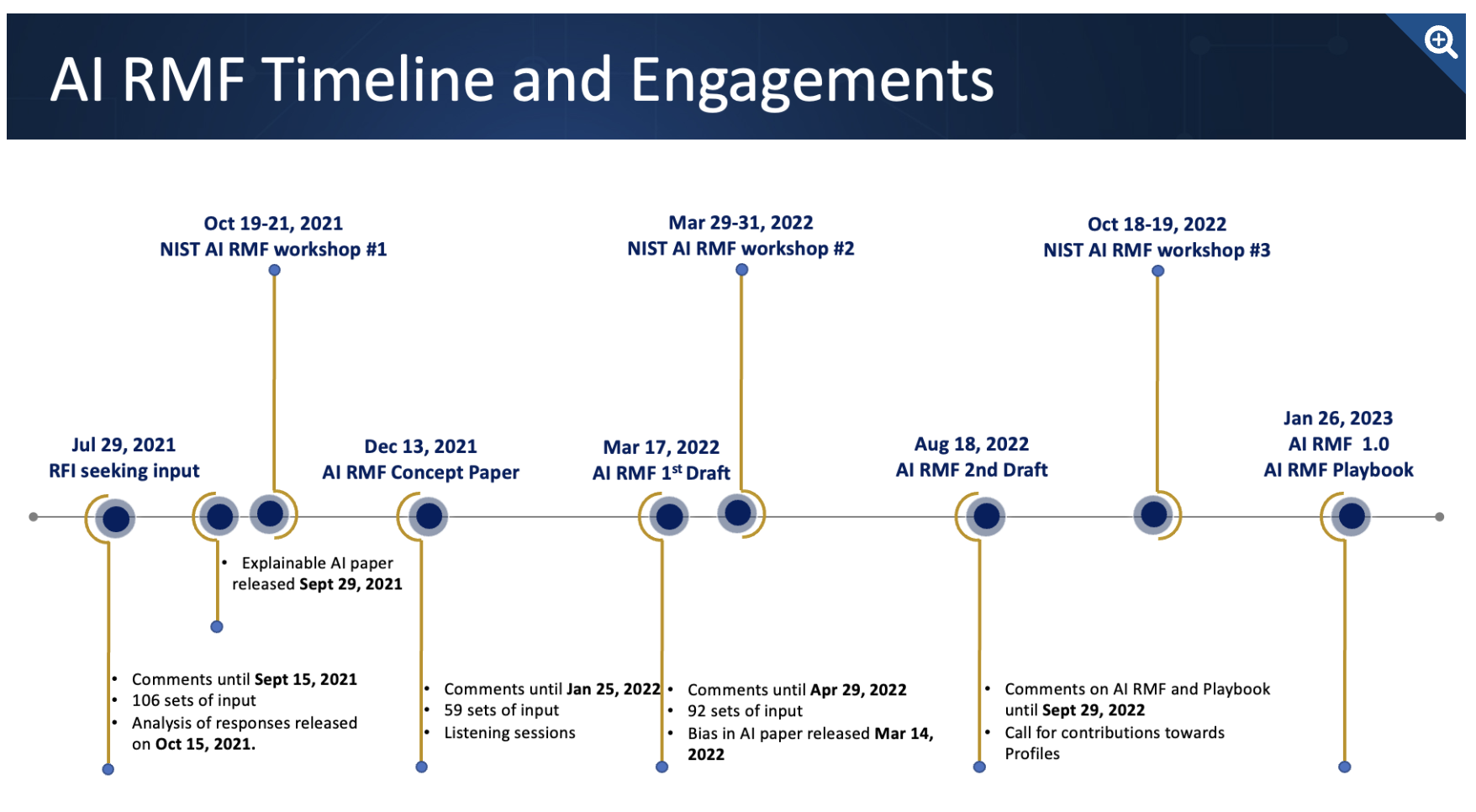

こちらは、AIのリスク管理に関する国際的な標準となっている米国国立標準技術研究所(NIST)のフレームワークです。合わせてご覧ください。 https://www.nist.gov/itl/ai-risk-management-framework

まとめ

企業は生成AIの活用による業務効率化を期待する一方で、情報漏洩や著作権侵害といった多様なリスクに直面しています。

しかし、実際には「何から対策すればいいかわからない」「セキュリティに詳しい人材がいない」といった理由で、安全な導入と活用に踏み切れない企業も少なくありません。

そこでおすすめしたいのが、Taskhubです。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「何をどう使えばいいのかわからない」という初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプログラミングや高度なAI知識がなくても、すぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最速の生成AI活用”を体験し、御社のDXを一気に加速させましょう。