「会社で生成AIを導入したいけど、情報漏洩などのリスクが心配…」

「生成AIの社内ガイドラインが必要なのはわかるけど、何から手をつければいいのかわからない…」

こういった悩みを持っている方もいるのではないでしょうか?

本記事では、生成AIの社内ガイドラインの作り方を3ステップで分かりやすく解説し、雛形として使える必須の記載項目8選や、策定後のリスク対策まで具体的にご紹介します。

企業のDX推進やAI導入を支援してきた専門家の視点から、実務で本当に役立つ情報だけをまとめました。

この記事を最後まで読めば、自社に最適化された、安全で実用的なガイドラインを作成できるようになります。ぜひ、貴社のAI活用推進にお役立てください。

そもそも生成AIの社内ガイドラインとは?策定の重要性

まず初めに、生成AIの社内ガイドラインが具体的に何を指すのか、そしてなぜ今、多くの企業にとってその策定が急務とされているのかについて、基本的な定義と必要性を解説します。

生成AIの社内ガイドラインの定義

生成AIの社内ガイドラインとは、従業員が業務でChatGPTなどの生成AIツールを利用する際に遵守すべきルールや方針をまとめた公式な文書のことです。

このガイドラインは、単に利用を制限するためだけのものではありません。

むしろ、情報漏洩や著作権侵害といった潜在的なリスクを管理し、従業員が安全かつ効果的に生成AIを活用できる環境を整えることを目的としています。

具体的には、利用できる業務の範囲、入力してはいけない情報、生成物の取り扱い方、トラブル発生時の対応などを明確に定めます。

ChatGPTを企業で利用する際の具体的な導入方法や活用事例、注意点については、こちらの記事で詳しく解説しています。 合わせてご覧ください。 https://taskhub.jp/useful/chatgpt-company-use/

企業に生成AIの社内ガイドラインが不可欠な理由

今、多くの企業で生成AIの社内ガイドラインが不可欠とされている理由は、その絶大な利便性の裏に、企業活動を揺るがしかねない重大なリスクが潜んでいるためです。

例えば、ある従業員が軽い気持ちで社外秘の情報を入力してしまえば、それがAIの学習データとして取り込まれ、意図せず外部に漏洩する可能性があります。

また、AIが生成した文章や画像をそのまま商用利用した結果、知らず知らずのうちに第三者の著作権を侵害してしまうケースも考えられます。

このようなリスクを放置したままでは、従業員は萎縮してしまい、せっかくの革新的な技術を業務効率化や生産性向上に活かすことができません。

明確なガイドラインを設けることで、従業員は「何をしてはいけないか」と「何をして良いか」を正しく理解し、安心して生成AIのメリットを享受できるようになるのです。

企業が生成AIの社内ガイドラインを策定する3つのメリット

生成AIの社内ガイドラインを策定することは、リスク管理だけでなく、企業の成長を加速させる多くのメリットをもたらします。

- 情報漏洩や法的リスクを未然に防ぐ

- 社員のAIリテラシーが向上し生産性がアップする

- 全社で生成AIの積極的な活用が促進される

ここでは、ガイドライン策定によって得られる代表的な3つのメリットを具体的に解説します。

メリット①:情報漏洩や法的リスクを未然に防ぐ

最大のメリットは、セキュリティリスクやコンプライアンス違反を組織的に防止できる点です。

ガイドラインで機密情報の入力を明確に禁止し、生成物の著作権確認を義務付けることで、従業員の不注意や知識不足による重大なインシデントの発生確率を大幅に低減できます。

万が一トラブルが発生した場合でも、ガイドラインの存在は、企業が然るべき対策を講じていたことを示す証拠となり、対外的な信用低下を最小限に食い止めることにも繋がります。

企業のレピュテーションや資産を守る上で、ガイドラインは不可欠な防波堤の役割を果たすのです。

メリット②:社員のAIリテラシーが向上し生産性がアップする

ガイドラインの策定と周知のプロセスは、全従業員のAIリテラシーを底上げする絶好の機会となります。

ガイドラインを通じて、生成AIの仕組み、得意なこと、苦手なこと、そして潜むリスクを体系的に学ぶことで、従業員は「AIを賢く使いこなす」スキルを習得できます。

例えば、どのような指示(プロンプト)を出せば質の高いアウトプットが得られるか、AIの回答を鵜呑みにせずどう検証すべきか、といった実践的なノウハウが社内に蓄積されていきます。

結果として、個々の従業員の業務効率が飛躍的に向上し、組織全体の生産性アップに直結するのです。

メリット③:全社で生成AIの積極的な活用が促進される

意外に思われるかもしれませんが、ルールを定めることは、むしろAIの活用を促進する効果があります。

ルールがない状態では、従業員は「何か問題を起こしたらどうしよう」と不安に感じ、AIの利用に臆病になりがちです。

しかし、「このルールさえ守れば、自由にAIを使って良い」という明確なガイドラインがあれば、従業員は安心して新しいツールの活用にチャレンジできます。

これにより、これまで人間が行っていた定型業務をAIに任せ、人間はより創造的な仕事に集中できるようになります。

現場から革新的なAI活用アイデアが次々と生まれるような、ポジティブな循環が期待できるでしょう。

生成AI導入を本格的に検討している方は、ぜひこちらの記事を合わせてご覧ください。総合生成AIコンサルティングファームとして大手企業含む多くの企業へのAI導入を成功させている弊社が、生成AI企業100社と、導入方法など、生成AI導入に関することを網羅的に解説しております。

生成AIの社内ガイドラインがない場合に潜む様々なリスク

もし、明確な社内ガイドラインがないまま、従業員が個人の判断で生成AIを使い始めた場合、企業はどのような危険に晒されるのでしょうか。

- 機密情報や個人情報の漏洩

- 著作権などの知的財産権の侵害

- 不正確・差別的な情報の生成と利用

- サイバー攻撃の起点となる可能性

ここでは、ガイドラインがないことによって引き起こされる具体的なリスクについて解説します。

リスク①:機密情報や個人情報の漏洩

最も懸念されるのが、企業の機密情報や顧客の個人情報が漏洩するリスクです。

多くの生成AIサービスでは、ユーザーが入力した情報をサービス改善のための学習データとして利用する場合があります。

従業員がこの仕様を理解しないまま、会議の議事録要約のために社外秘の開発情報や取引先の個人情報を入力してしまうと、そのデータがAI提供元のサーバーに送信され、学習データとして取り込まれてしまう恐れがあります。

一度学習データとなってしまうと、他のユーザーへの回答として、断片的に情報が出力されてしまう可能性もゼロではありません。

リスク②:著作権などの知的財産権の侵害

生成AIは、インターネット上の膨大なテキストや画像を学習してコンテンツを生成します。

そのため、AIが作り出した文章やイラストが、意図せず既存の著作物と酷似してしまうことがあります。

従業員がAIの生成物であることを意識せずに、社外向けの資料やマーケティングコンテンツにそのまま利用した場合、第三者の著作権や商標権を侵害してしまうリスクが生じます。

このような権利侵害は、損害賠償請求や企業の信用失墜に繋がりかねない重大な問題です。

リスク③:不正確・差別的な情報の生成と利用

生成AIは、時として「ハルシネーション(Hallucination)」と呼ばれる、事実に基づかないもっともらしい嘘の情報を生成することがあります。

例えば、市場調査レポートを作成させた際に、存在しない統計データや架空の専門家のコメントがもっともらしく記述されるケースです。

これをファクトチェックせずに利用すれば、誤った経営判断を下す原因となります。

また、AIの学習データには社会的な偏見や差別的な表現が含まれている可能性があり、不適切なコンテンツを生成してしまうリスクも指摘されています。

リスク④:サイバー攻撃の起点となる可能性

生成AIの利用が、新たなサイバー攻撃の標的となる可能性もあります。

代表的なのが「プロンプトインジェクション」と呼ばれる攻撃手法です。

これは、攻撃者が悪意のある指示(プロンプト)を生成AIに埋め込むことで、AIを操り、機密情報を盗み出したり、ユーザーを不正なウェブサイトへ誘導したりするものです。

また、フィッシング詐欺メールの作成や、マルウェア(悪意のあるソフトウェア)のコード生成にAIが悪用されるケースも増えており、従業員がそうした攻撃の被害者、あるいは加害者になってしまうリスクも考慮する必要があります。

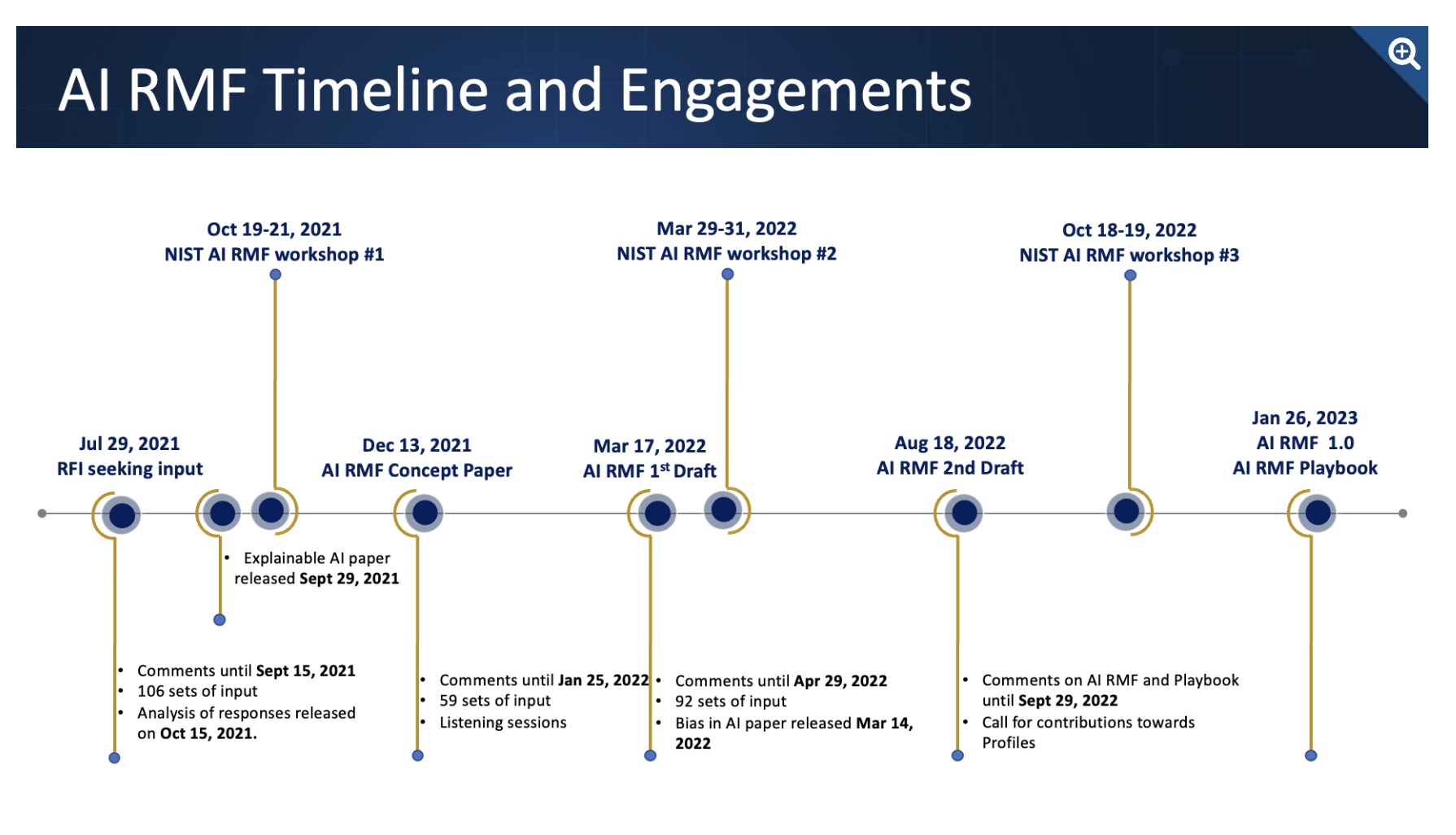

こちらは米国国立標準技術研究所(NIST)が策定した、国際的なAIのリスク管理フレームワークです。合わせてご覧ください。 https://www.nist.gov/itl/ai-risk-management-framework

【事例】生成AIの社内ガイドライン違反によるセキュリティ事故

残念ながら、生成AIの不適切な利用によるセキュリティ事故は、すでに現実のものとなっています。ここでは、ガイドラインの重要性を浮き彫りにする実際の事故事例を2つ紹介します。

事例①:大手メーカーで機密情報であるソースコードが流出

韓国の大手電機メーカーで、従業員が半導体のソースコードや社外秘の会議内容をChatGPTに入力し、情報が外部に流出するという事故が発生しました。

従業員は、ソースコードのエラー修正や議事録の要約といった業務効率化を目的としていましたが、入力データがAIの学習に使われるリスクを認識していませんでした。

この事故を受け、同社は緊急で社内での生成AI利用を制限する措置を取りましたが、一度流出してしまった情報の完全な回収は困難です。

この事例は、利便性の追求が、いかに簡単に重大な情報漏洩に繋がりうるかを示す教訓と言えます。

事例②:弁護士が実在しない判例を生成し提出

アメリカで、ある弁護士がChatGPTを使って作成した準備書面を裁判所に提出したところ、記載されていた判例がすべてAIによって捏造された架空のものであったことが発覚し、大きな問題となりました。

この弁護士は、生成AIが生成した情報を鵜呑みにし、その内容の真偽を確認する「ファクトチェック」を怠っていました。

結果として、裁判所から制裁を科され、専門家としての信頼を著しく損なうことになりました。

この事例は、生成AIの出力は必ずしも正確ではないという特性を理解し、人間による最終確認が不可欠であることを物語っています。

【3ステップで簡単】生成AIの社内ガイドラインの作り方

それでは、実際に自社のための生成AI社内ガイドラインを作成する手順を見ていきましょう。ゼロから作るのは大変に思えるかもしれませんが、以下の3ステップに沿って進めることで、効率的かつ確実に策定を進めることができます。

- Step1:JDLAなど公開されている雛形をベースにする

- Step2:自社の業務内容や活用方針を整理する

- Step3:雛形と自社方針を組み合わせてカスタマイズする

この手順を踏むことで、抜け漏れがなく、自社の実態に即した実用的なガイドラインを作成できます。

Step1:JDLAなど公開されている雛形をベースにする

最初からすべての条文を自社で考え出す必要はありません。

まずは、信頼できる公的機関や業界団体が公開しているガイドラインの雛形(テンプレート)を入手し、それをベースにするのが最も効率的な方法です。

特に、一般社団法人日本ディープラーニング協会(JDLA)が公開している「生成AIの利用ガイドライン」は、多くの企業で参考にされており、網羅的かつ汎用的な内容で構成されています。

こうした雛形を利用することで、検討すべき項目が明確になり、作成の工数を大幅に削減できます。

Step2:自社の業務内容や活用方針を整理する

次に、雛形をカスタマイズするための準備として、自社における生成AIの活用イメージを具体的に整理します。

「そもそも、自社では生成AIを何のために、どの部署の、どのような業務で活用したいのか?」を明確にすることが重要です。

例えば、マーケティング部門での広告コピー作成、開発部門でのコーディング補助、人事部門での採用メール文面作成など、具体的なユースケースを洗い出します。

同時に、自社が取り扱う情報の種類(個人情報、顧客情報、技術情報など)を整理し、それぞれのリスクレベルを評価しておくことも、後のルール策定に役立ちます。

Step3:雛形と自社方針を組み合わせてカスタマイズする

最後に、Step1で入手した雛形に、Step2で整理した自社の方針を反映させて、オリジナルのガイドラインを完成させます。

雛形の条文を一つひとつ確認しながら、「自社の場合はどうするか?」を検討し、加筆・修正を行っていきます。

例えば、雛形にある「機密情報の入力禁止」という項目に対して、自社が定義する機密情報の範囲を具体的に追記したり、活用したい業務内容に合わせて「利用を推奨する業務」のリストを追加したりします。

このカスタマイズのプロセスを経ることで、単なる形式的なルールではなく、日々の業務で本当に役立つ「生きたガイドライン」となるのです。

生成AIの社内ガイドラインに記載すべき必須項目8選

ここでは、業種や規模を問わず、どのような企業のガイドラインにも必ず含めるべき8つの必須項目を解説します。これらの項目を網羅することで、リスクを適切に管理し、安全なAI活用を促進する基盤が整います。

- ガイドラインの目的と基本方針

- 利用を許可する業務・禁止する業務の範囲

- 機密情報・個人情報の取り扱いに関する注意点

- 生成物の著作権と商用利用に関するルール

- 生成された情報の正確性確認(ファクトチェック)の義務

- ツールの利用申請・承認フロー

- 罰則規定と相談窓口の設置

- ガイドラインの定期的な見直しについて

それでは、一つずつ見ていきましょう。

①:ガイドラインの目的と基本方針

ガイドラインの冒頭で、なぜこのルールを定めるのか、その目的と会社の基本的な考え方を明確に示します。

単に禁止事項を並べるのではなく、「生産性向上とイノベーション創出のために生成AIの活用を推奨する」といったポジティブなメッセージを伝えることが重要です。

そして、「ただし、関連法規や情報セキュリティポリシーを遵守し、企業倫理に則って適切に利用する必要がある」という基本方針を宣言します。

このセクションは、ガイドライン全体の方向性を決定づける羅針盤の役割を果たします。

②:利用を許可する業務・禁止する業務の範囲

従業員が判断に迷わないよう、生成AIの利用が許可される業務と、禁止される業務の範囲を具体的に例示します。

許可される業務としては、「社内向け資料の草案作成」「アイデアの壁打ち」「公開情報の要約」などが考えられます。

一方、禁止する業務としては、「人事評価や採用可否の最終判断」「重要な経営判断の根拠としての利用」「医療や法律など高度な専門性が求められる分野での無検証な利用」などを明記します。

業務の特性やリスクに応じて、レベル分け(例:原則禁止、上長承認の上で許可、自由利用可)するのも有効です。

③:機密情報・個人情報の取り扱いに関する注意点

情報漏洩リスクを防ぐため、最も重要な項目の一つです。

まず、自社における「機密情報」や「個人情報」の定義を明確にした上で、これらの情報を生成AIに入力することを原則として禁止します。

具体的には、「顧客リスト」「未公開の財務情報」「技術的なノウハウ」「従業員の個人情報」などが該当します。

なぜ入力してはいけないのか、その理由(AIの学習データになる可能性があることなど)も併記することで、従業員の理解を深めることができます。

④:生成物の著作権と商用利用に関するルール

生成AIが作成したコンテンツの取り扱いについて定めます。

まず、生成物が第三者の著作権を侵害していないかを確認する責任が、利用者自身にあることを明確にします。

特に、社外向けの資料やウェブサイト、製品デザインなどに利用する場合は、類似のコンテンツが存在しないかを確認するプロセスを義務付けるべきです。

また、利用するAIサービスの利用規約によっては、生成物の商用利用が制限されている場合があるため、規約を確認し、それに準拠したルールを設ける必要があります。

⑤:生成された情報の正確性確認(ファクトチェック)の義務

生成AIの「ハルシネーション(もっともらしい嘘をつく)」リスクに対応するための項目です。

AIが生成した情報は、必ずしも正確・最新であるとは限らないことを従業員に周知し、その内容を鵜呑みにしないよう注意喚起します。

特に、統計データ、専門的な見解、法令に関する情報などを業務に利用する際は、必ず信頼できる情報源(公的機関のウェブサイト、専門家の論文など)を参照し、事実確認(ファクトチェック)を行うことを義務付けます。

「最終的な文責はAIではなく利用者自身にある」という原則を徹底させることが重要です。

こちらはAIのハルシネーションを防ぐプロンプトについて解説した記事です。 合わせてご覧ください。 https://taskhub.jp/use-case/chatgpt-prevent-hallucination/

⑥:ツールの利用申請・承認フロー

会社としてどの生成AIツールの利用を許可するのか、また、利用を開始する際にどのような手続きが必要なのかを定めます。

セキュリティやコスト管理の観点から、会社が安全性を確認し、契約したツールのみ利用を許可する「ホワイトリスト方式」が推奨されます。

従業員が新しいツールを利用したい場合は、情報システム部門などに申請し、セキュリティリスクや利用規約の確認、費用の妥当性などを評価した上で承認する、といったフローを明確にしておくと、無秩序なツールの導入(シャドーIT)を防ぐことができます。

⑦:罰則規定と相談窓口の設置

ガイドラインの実効性を担保するために、違反した場合の措置について定めておきます。

就業規則の懲戒規定と連携させ、違反の程度に応じて厳重注意、減給、懲戒解雇などの処分が科される可能性があることを明記します。

ただし、罰則だけで縛るのではなく、従業員が利用方法に迷ったり、問題を発見したりした際に、気軽に相談できる窓口を設置することも同様に重要です。

法務部門や情報システム部門が担当する相談窓口を設け、安心して利用できる環境を整えることが、トラブルの未然防止に繋がります。

⑧:ガイドラインの定期的な見直しについて

生成AIの技術は日進月歩であり、新たなサービスやリスクが次々と登場します。

そのため、一度作成したガイドラインがすぐに陳腐化してしまう可能性があります。

「このガイドラインは、少なくとも半年に一度、または重大な技術的・法的な変更があった場合に見直しを行う」といった規定を盛り込み、常に最新の状況に対応できるようにしておくことが不可欠です。

見直しの責任部署やプロセスをあらかじめ決めておくことで、継続的な改善サイクルを確立できます。

策定の参考にしたい生成AIの社内ガイドライン公開企業4選

自社のガイドラインを作成する際には、他社がどのようなルールを定めているかを知ることが非常に有益です。ここでは、それぞれの特徴と共に、一般に公開されていて参考にしやすいガイドラインを4つ紹介します。

①日本ディープラーニング協会(JDLA)

多くの企業が雛形として利用している、最もスタンダードなガイドラインの一つです。

法律の専門家やAI技術者が監修しており、法的な観点と技術的な観点の両方から、網羅的にリスクと対策が整理されています。

利用者の役割(一般利用者、管理者、開発者など)に応じた注意事項が記載されている点が特徴で、自社の状況に合わせてカスタマイズしやすい構成になっています。

まずはこのJDLAのガイドラインに目を通すことから始めるのが良いでしょう。

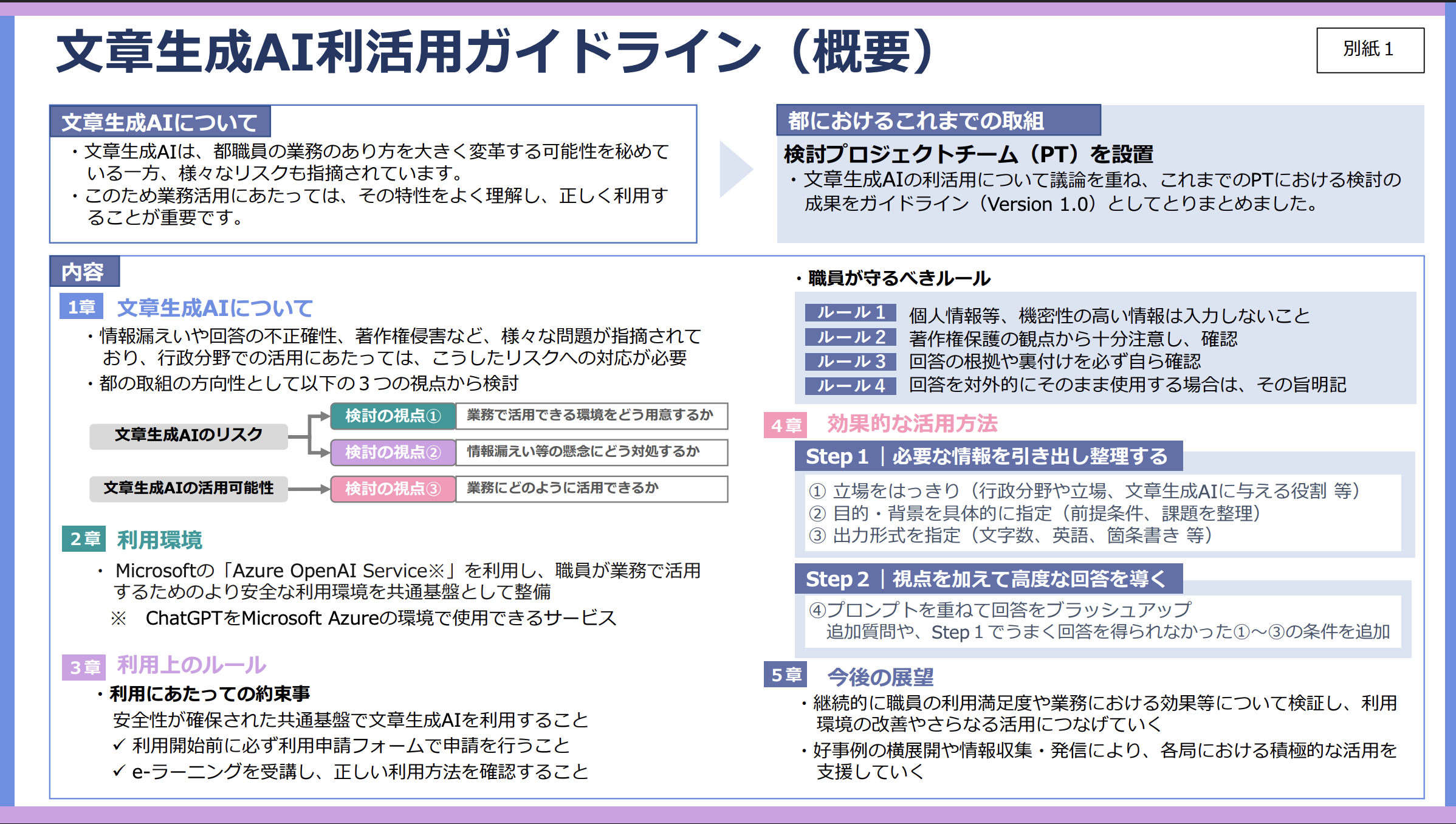

②東京都デジタルサービス局

行政機関という立場から、セキュリティとコンプライアンスを重視した、非常に堅実なガイドラインを公開しています。

特に、情報の機密性に応じた分類(機密性3, 2, 1)を行い、それぞれの分類で入力して良い情報・ダメな情報を具体的に定義している点は、多くの企業にとって参考になるでしょう。

リスク管理を徹底したいと考えている企業にとって、手本とすべき内容が多く含まれています。

こちらは東京都が公開している、具体的な情報の機密性分類などが参考になる文章生成AI利活用ガイドラインです。合わせてご覧ください。 https://www.spt.metro.tokyo.lg.jp/tosei/hodohappyo/press/2023/08/23/14.html

③株式会社サイダス

人事・組織開発のDXを支援する企業であるサイダスは、「守り」のルールだけでなく、「攻め」の活用を促進するためのガイドラインを公開しています。

単なる禁止事項の羅列ではなく、どのようなプロンプト(指示文)が有効かといった、実践的なノウハウにまで踏み込んでいるのが特徴です。

従業員の生産性向上を主眼に置き、AIの積極的な活用を後押ししたい企業にとって、大いに参考になる事例と言えます。

④上智大学

教育・研究機関の視点から策定されたガイドラインであり、特に著作権や研究倫理に関する記述が詳細です。

レポート作成や論文執筆における生成AIの適切な利用範囲や、引用・出典の明記事項などを具体的に定めています。

知的財産や学術的な正確性を重視する業種の企業や、研修資料作成時のルールを定める際に参考になるでしょう。

AIの生成物をどのように扱うべきか、その倫理的な側面について深く考えるきっかけを与えてくれます。

生成AIの社内ガイドラインと合わせて確認すべき利用規約のポイント

社内ガイドラインを策定する際には、利用する生成AIサービスの「利用規約」を精査することが不可欠です。規約内容はサービスによって大きく異なるため、特に以下の3つのポイントは必ず確認するようにしましょう。

チェックポイント①:入力データの機械学習への利用可否

最も重要な確認項目です。ユーザーが入力したデータ(プロンプトやアップロードしたファイル)が、そのAIモデルの性能向上のための学習データとして利用されるかどうかを確認します。

多くのサービスでは、設定を変更することで学習への利用を拒否(オプトアウト)できる仕組みを提供しています。

企業の機密情報や個人情報を扱う可能性がある場合、学習に利用されない設定が可能であること、あるいは法人向けプランなどでデータのプライバシーが保護されていることを必ず確認する必要があります。

チェックポイント②:禁止事項の詳細

利用規約には、そのサービスの利用にあたっての禁止事項が具体的に記載されています。

例えば、違法なコンテンツの生成、他者の権利を侵害する行為、サービスの脆弱性を狙った攻撃などが挙げられます。

これらの禁止事項は、自社の社内ガイドラインにも反映させる必要があります。

従業員が意図せず規約違反を犯し、アカウント停止や法的な問題に発展することを防ぐためにも、禁止されている行為の内容を正確に把握し、社内に周知することが重要です。

チェックポイント③:知的財産権の帰属

ユーザーが生成AIを利用して作成したコンテンツ(文章、画像、コードなど)の著作権が、誰に帰属するのかを定める項目です。

多くのサービスでは、生成物の知的財産権はユーザーに帰属すると定めていますが、サービスによっては一部の権利をAI提供元が保持する場合や、特定の条件下での利用を制限している場合があります。

生成物を商用利用したり、製品に組み込んだりすることを想定している場合は、自社が自由にその権利を行使できるかどうかを、利用規約で明確に確認しておく必要があります。

生成AIの社内ガイドライン策定後に実施すべきリスク対策

ガイドラインは、作成して社内に公開すれば終わり、というわけではありません。そのルールが形骸化せず、全従業員に遵守されるための仕組みを構築することが極めて重要です。ここでは、ガイドライン策定後に必ず実施すべき3つの対策を解説します。

対策①:全従業員への研修とガイドラインの周知徹底

ガイドラインを策定したら、全従業員を対象とした研修会を実施し、その内容を丁寧に説明する必要があります。

なぜこのようなルールが必要なのか、具体的なリスク事例を交えながら解説することで、従業員の当事者意識を高めます。

また、ガイドラインの全文をいつでも閲覧できる場所に保管し(社内ポータルなど)、定期的にリマインドの通知を送るなど、継続的な周知活動が不可欠です。

新入社員向けの研修プログラムに組み込むことも有効でしょう。

対策②:機密情報を入力させないためのシステム的制御

従業員の注意喚起だけに頼るのではなく、システム的な制御を導入することも重要です。

例えば、DLP(Data Loss Prevention)ツールを導入し、機密情報や個人情報と見なされる特定のキーワードやデータパターンが、生成AIサービスに送信されそうになった際に、自動的にブロックしたり、管理者にアラートを通知したりする仕組みです。

ヒューマンエラーを技術的にカバーすることで、情報漏洩のリスクをより確実に低減させることができます。

対策③:利用状況のモニタリングと可視化

法人向けの生成AIサービスには、従業員の利用状況を管理者がモニタリングできる機能が備わっているものがあります。

誰が、いつ、どの程度AIを利用しているか、どのような内容のやり取りが行われているかを把握することで、ガイドラインからの逸脱がないかを確認できます。

また、利用状況を分析することで、どの部署で活用が進んでいるか、どのような業務に効果を発揮しているかを可視化し、成功事例を社内で共有するなど、活用の促進にも繋げることができます。

企業導入を成功させるための生成AI社内ガイドライン活用法

策定したガイドラインは、単にリスクを管理するための「守り」のツールとしてだけでなく、全社的なAI活用を加速させるための「攻め」の基盤として活用することが可能です。ここでは、ガイドラインを企業の成長に繋げるための活用法を3つ紹介します。

活用法①:業務の棚卸しと活用インパクトの試算

ガイドライン策定のプロセスで明確にした「利用を推奨する業務」を起点に、全社的に業務の棚卸しを行います。

各部署で「生成AIを使えば効率化できそうな業務」をリストアップし、それぞれどの程度の時間削減やコスト削減に繋がるか、そのインパクトを試算します。

これにより、AI導入の投資対効果(ROI)が明確になり、経営層の理解を得やすくなるとともに、優先的に取り組むべき業務の特定にも繋がります。

活用法②:アジャイルアプローチでの導入と改善

最初から全社一斉に大規模な導入を目指すのではなく、特定の部署やチームでスモールスタートし、アジャイル(迅速かつ柔軟)に改善を繰り返していくアプローチが有効です。

試験導入で得られた成功事例や課題、従業員からのフィードバックを収集し、それをガイドラインや運用ルールに素早く反映させます。

この小さな成功体験を積み重ね、その効果を社内に広く共有することで、他の部署への展開がスムーズに進みます。

活用法③:システムとルールの両面からのリスク管理

ガイドラインという「ルール」によるソフト面の対策と、前述したDLPツールや利用状況モニタリングといった「システム」によるハード面の対策を両輪で進めることが、堅牢なリスク管理体制の構築に繋がります。

ルールは従業員の意識を高め、システムは万が一の見落としやミスを防ぎます。

この両面からのアプローチによって、企業は従業員の自主性を尊重しつつ、組織として許容できないリスクを確実にコントロールすることが可能になります。

生成AIの社内ガイドラインと並行して進めるべき導入4ステップ

生成AIの社内ガイドライン策定は、AI導入プロジェクト全体の一部です。ガイドライン作りと並行して、以下の4つのステップを計画的に進めることで、よりスムーズで効果的な全社導入が実現します。

Step1:活用方針と目的の具体化

まず、「自社は何を成し遂げるために生成AIを導入するのか」という目的を明確にします。

「業務効率化によるコスト削減」「新たな顧客体験の創出」「データ分析能力の強化による意思決定の迅速化」など、具体的なゴールを設定します。

この目的が、ツール選定やガイドラインの方向性を決定する上での重要な判断基準となります。

Step2:利用環境の構築とツール選定

設定した目的に基づき、自社に最適な生成AIツールを選定し、利用環境を構築します。

セキュリティ要件、既存システムとの連携性、コスト、サポート体制などを多角的に評価します。

特に、入力したデータが学習に利用されないことや、アクセス管理機能が充実しているなど、企業の利用に適したセキュリティを備えた法人向けサービスの導入が推奨されます。

Step3:スモールスタートでの試験運用(PoC)

全社展開の前に、特定の部署やプロジェクトチームで試験的な運用(PoC:Proof of Concept)を実施します。

この段階で、実際の業務における有効性や課題点を洗い出します。

例えば、マーケティングチームで広告文の作成に利用してみたり、カスタマーサポートで問い合わせメールの返信案作成に活用したりします。

PoCの結果を分析し、本格導入に向けた改善点や、より効果的な活用方法を検討します。

Step4:本格的な開発と全社展開

PoCで得られた知見を基に、ガイドラインや運用ルールを最終調整し、本格的な全社展開へと移行します。

全従業員への研修を再度実施し、利用方法や成功事例を共有する場を設けます。

また、継続的に利用状況をモニタリングし、定期的に効果測定を行いながら、さらなる活用領域の拡大や、より高度な利用方法(API連携による業務システムへの組み込みなど)を検討していくことで、AI活用のレベルを継続的に高めていきます。

ChatGPTの企業への導入を検討されている方は、こちらの記事で導入ガイドや企業での具体的な使い方、成功事例を詳しく解説しています。 合わせてご覧ください。 https://taskhub.jp/useful/chatgpt-introduction/

ガイドラインの次に必要な「思考法」 AIで賢くなる組織、思考停止する組織

生成AIの社内ガイドラインを整えても、使い方を誤れば組織の思考力はかえって低下するかもしれません。マサチューセッツ工科大学(MIT)の研究は、AIに頼ることで人間の脳の活動が著しく低下する可能性を示唆しています。一方で、東京大学などの研究機関では、AIを思考を深めるための強力なパートナーとして活用する動きが広がっています。ここでは、AIによって「思考停止する組織」と「賢くなる組織」を分ける、具体的なAI活用法を解説します。

AIはあなたの脳を「省エネモード」にする

「AIが答えを出してくれるから考えなくていい」という風潮は危険な兆候です。MITの研究によれば、生成AIを用いて文章を作成した際、人間の脳の認知活動が大幅に低下することが確認されました。これは、本来人間が担うべき思考プロセスをAIに丸投げしてしまう「思考の外部委託」が起きていることを意味します。この状態が続くと、組織全体として、深く洞察する力、情報を多角的に疑う批判的思考力、そして新たなアイデアを生み出す創造性が徐々に失われていくリスクがあります。

引用元:

Shmidman, A., Sciacca, B., et al. (2024). “Does the use of large language models affect human cognition?”. この研究では、大規模言語モデル(LLM)支援のライティングタスクにおいて、人間の脳活動が有意に減少することが示された。

AIを「思考のジム」に変える賢い使い方

では、「賢くなる組織」はAIをどのように活用しているのでしょうか。彼らはAIを単なる「答えを出す機械」ではなく、「思考を鍛えるための対話相手」と捉えています。

使い方①:AIを最強の「反論者」にする

企画書や提案の弱点を洗い出すために、AIに敢えて批判的な役割を与えましょう。

プロンプト例:「あなたは優秀な経営コンサルタントです。この事業計画について、最もリスクが高い点を3つ、厳しい視点で指摘してください。」

これにより、自分たちだけでは気づけなかった視点や思考の漏れを発見し、戦略をより強固なものにできます。

使い方②:AIに「新人」として説明する

複雑なテーマの理解度を測るには、他者に説明してみるのが最善の方法です。AIを「この分野の知識が全くない新人」と設定し、あなたが専門用語を使わずにプロジェクトの概要を説明してみましょう。

プロンプト例:「今から新しいマーケティング戦略について説明します。あなたは今日配属されたばかりの新人です。私の説明で少しでも分からない言葉や文脈があれば、遠慮なく質問してください。」

AIからの素朴な質問に答える過程で、自身の理解の曖昧な部分が明確になり、知識が体系的に整理されます。

まとめ

企業は労働力不足や業務効率化の課題を抱える中で、生成AIの活用がDX推進や業務改善の切り札として注目されています。

しかし、実際には「どこから手を付ければいいかわからない」「社内にAIリテレシを持つ人材がいない」といった理由で、導入のハードルが高いと感じる企業も少なくありません。

そこでおすすめしたいのが、Taskhub です。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「何をどう使えばいいのかわからない」という初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプログラミングや高度なAI知識がなくても、すぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最速の生成AI活用”を体験し、御社のDXを一気に加速させましょう。