「ChatGPTに資料作成を手伝ってもらったら、事実と異なる情報が混じっていた…」

「生成AIのハルシネーションが怖くて、業務で本格的に活用できない」

こういった悩みを持っている方もいるのではないでしょうか?

本記事では、生成AIが嘘をつく「ハルシネーション」の主な原因から、プロンプトを使って対策する方法まで、具体的な例文を交えて徹底解説します。

さらに、企業で安全にAIを活用するための体制づくりや、万が一ハルシネーションが起きた際の対処法まで網羅しました。

上場企業をメインに生成AIコンサルティング事業を展開している弊社が、実践的なノウハウだけをご紹介します。

きっと役に立つと思いますので、ぜひ最後までご覧ください。

ハルシネーションとは?生成AIが“もっともらしい嘘”をつく現象

ハルシネーションとは、AIが学習したデータには基づいていない、事実と異なる情報や、もっともらしい嘘を生成してしまう現象のことです。

AIがまるで幻覚(Hallucination)を見ているかのように振る舞うことから、この名前が付けられました。

単なる間違いとは異なり、文脈は自然でありながら、内容が完全に創作されている場合があるため、見抜くのが難しいという特徴があります。

ハルシネーションの具体例

ハルシネーションは、日常的な調べ物から専門的な業務まで、さまざまな場面で発生する可能性があります。

例えば、以下のようなケースが報告されています。

- 存在しない法律の判例を引用して、法的なアドバイスを生成する。

- 歴史上の人物について、実際にはなかった逸話や発言を創作する。

- 論文を要約させた際に、本文には書かれていない結論を付け加える。

- 特定の製品について、搭載されていない架空の機能を説明する。

- 問い合わせ先の電話番号として、全く関係のない番号を提示する。

これらの例のように、ハルシネーションによって生成された情報は一見すると正しく見えるため、注意が必要です。

ハルシネーションが起こると何が問題なのか?

ハルシネーションは、個人の利用においてはもちろん、ビジネスで利用する際にはさらに深刻な問題を引き起こす可能性があります。

最も大きな問題は、誤った情報に基づいて意思決定をしてしまうリスクです。

例えば、不正確な市場分析レポートを信じて事業戦略を立ててしまったり、虚偽の情報を顧客に提供してしまったりすれば、企業の信用失墜や経済的な損失に直結します。

また、医療や法律などの専門分野で誤った情報が使われると、人命に関わる事態や法的なトラブルに発展する危険性も否定できません。

ハルシネーションはなぜ起こる?プロンプトにも関わる主な4つの原因

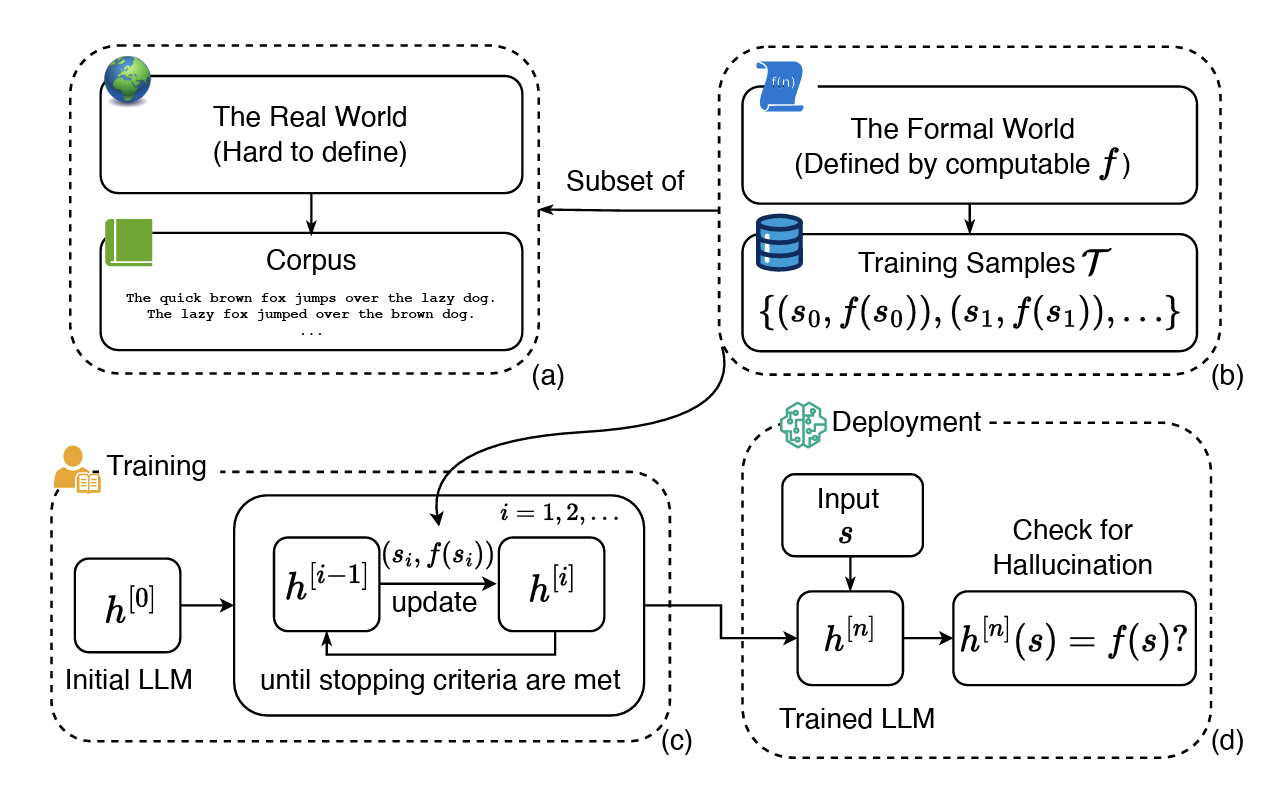

こちらは、OpenAIが公式に発表した、言語モデルがハルシネーションを起こす根本的な原因を解説した論文です。合わせてご覧ください。 https://cdn.openai.com/pdf/d04913be-3f6f-4d2b-b283-ff432ef4aaa5/why-language-models-hallucinate.pdf

なぜAIはハルシネーションを起こしてしまうのでしょうか。ここでは、その主な4つの原因を解説します。プロンプトの工夫によって対策できる部分も多いため、仕組みを理解しておくことが重要です。

それでは、1つずつ順に解説します。

原因1:プロンプトの指示が曖昧

ユーザーがAIに与える指示、つまりプロンプトが曖昧であると、ハルシネーションが発生しやすくなります。

例えば、「日本の経済について教えて」のような漠然とした質問をすると、AIは何に焦点を当てるべきか判断できません。

その結果、AIは文脈を補完しようとして、不確かな情報や一般的な話を組み合わせてしまい、結果的に事実と異なる内容を生成してしまうことがあります。

より具体的で明確なプロンプトを与えることが、ハルシネーション対策の第一歩となります。

原因2:学習データに誤りや偏りがある

元となるデータに誤った情報、古い情報、あるいは偏った意見が含まれている場合、AIはそれらを「正しい情報」として学習してしまいます。

生成AIは、インターネット上の膨大なテキストデータなどを学習して知識を獲得しています。

そして、学習した内容に基づいて回答を生成するため、結果的に誤った情報や偏見を含んだ文章が出力されてしまうのです。

AIは自ら情報の真偽を判断するわけではなく、あくまで学習データに基づいて確率的に最もらしい言葉を繋げているに過ぎません。

原因3:AIモデルの知識が古い・不足している

AIモデルには、学習データが収集された期間に基づく「知識のカットオフ(締切日)」が存在します。

そのため、その日付以降に起きた出来事や新しい情報については、基本的に知識がありません。

最新の出来事について質問された場合、AIは知識がないにもかかわらず、それらしい回答を生成しようとしてハルシネーションを起こすことがあります。

最近のモデルではWebブラウジング機能で最新情報を補うことも可能になりましたが、基本的な仕組みとして知識の限界があることは理解しておく必要があります。

原因4:確率に基づいて文章を生成している

生成AIの根本的な仕組みが、ハルシネーションの原因となることもあります。

AIは、入力された文章(プロンプト)に続いて、次にどの単語が来る確率が最も高いかを計算し、文章を生成しています。

これは、事実の正確さよりも「それらしい文章の流れ」を優先する仕組みとも言えます。

そのため、統計的に自然な文章を生成しようとした結果、事実とは異なる単語の組み合わせが選ばれてしまい、ハルシネーションにつながることがあるのです。

【コピペOK】プロンプトでハルシネーションを抑える7つの対策と例文

ハルシネーションの多くは、プロンプトを工夫することで抑制できます。

ここでは、今日からすぐに使える7つの対策と、具体的なプロンプトの例文を紹介します。

ぜひコピーして活用してみてください。

対策1:具体的で明確な指示を出す

曖昧な指示はハルシネーションの元です。AIが解釈に迷わないよう、具体的かつ明確なプロンプトを心がけましょう。

「何を」「どのような形式で」「どのくらいの長さで」といった要素(5W1H)を盛り込むのがコツです。

悪い例:

「GPT-5について教えて」

良い例:

「あなたはITジャーナリストです。中学生にも分かるように、2025年8月にリリースされた言語モデル『GPT-5』の主な特徴を3つ、箇条書きで300字程度で説明してください。」

対策2:思考を制御するルールを設ける

AIの思考プロセスに制約やルールを設けることで、自由な解釈によるハルシネーションを防ぎます。

「〇〇という役割で」「〇〇の観点から」といった役割設定や、「〇〇以外の情報は含めないで」といった制約が有効です。

プロンプト例:

「あなたは公平な視点を持つ書評家です。以下のレビュー記事のみを参考にして、書籍『AI時代の働き方』のメリットとデメリットをそれぞれ2つずつ挙げてください。レビュー記事に書かれていないあなたの意見や推測は一切含めないでください。」

対策3:情報源や根拠の提示を求める

回答と同時に、その情報の出典や根拠を示すように指示することで、AIに事実に基づいた回答をさせる意識付けができます。

信頼できる情報源を元に回答するようになり、ハルシネーションの抑制につながります。

プロンプト例:

「日本の再生可能エネルギーの現状について、2025年時点の最新情報をまとめてください。その際、主張の根拠となる公的機関の統計データやレポート名、そしてそのURLを必ず併記してください。」

対策4:不明な点は「不明」と答えさせる

AIは知らない情報についても、知っているかのように振る舞おうとすることがあります。

これを防ぐために、「知らない場合は無理に答えず、正直に『不明』と回答してください」という一文をプロンプトに加えるのが非常に効果的です。

プロンプト例:

「2024年のノーベル物理学賞受賞者の名前と、その受賞理由を教えてください。もし正確な情報がわからない場合は、推測で答えるのではなく『現時点では不明です』と回答してください。」

対策5:推測や憶測を禁止する

AIが情報を補完しようとして、推測や憶測で文章を生成するのを直接的に禁止します。

特に、事実関係が重要なビジネス文書やレポート作成の際に有効なプロンプトです。

プロンプト例:

「以下の議事録を要約してください。要約には、議事録で明確に述べられている事実のみを記載し、参加者の意図に関する推測や、書かれていない背景情報の憶測は一切禁止します。」

対策6:参照テキストからの引用を指示する

特定の文章やデータ(参照テキスト)をAIに与え、その範囲内でのみ回答を生成させる方法です。

RAG(後述)の簡易版とも言え、外部の誤った知識を参照するのを防ぎ、正確性を大幅に向上させることができます。

プロンプト例:

「以下の記事を読んで、この記事で述べられている『プロンプトエンジニアリングの3つのコツ』を、記事内の表現をそのまま引用する形でリストアップしてください。

(ここに参照記事の全文を貼り付け)」

対策7:「ハルシネーションを避けて」と直接指示する

シンプルですが、AIに対して直接的に「ハルシネーションを避けるように」と指示することも一定の効果が期待できます。

AIモデルはこのようなメタ的な指示(指示そのものに関する指示)を理解する能力が向上しているため、注意喚起として有効です。

プロンプト例:

「次世代の交通システムと言われる『ハイパーループ』の仕組みについて解説してください。その際、ハルシネーションを避け、科学的根拠に基づいた事実のみを記述するように注意してください。」

【応用編】さらに精度を高める技術的なハルシネーション対策

プロンプトの工夫に加えて、より技術的なアプローチでハルシネーションを抑制する方法もあります。

専門的な知識が必要なものもありますが、知っておくことでAI活用の幅が広がります。

最新・高性能なAIモデルを利用する

AIモデルは日々進化しており、新しいモデルほどハルシネーションが起こりにくくなる傾向にあります。

例えば、2025年8月に登場したOpenAIの「GPT-5」は、旧モデルに比べて事実に基づいた応答生成能力や、不正な指示への耐性が向上しています。

利用しているサービスの基盤となっているAIモデルが最新のものかを確認し、可能であればより高性能なモデルを選択することが、ハルシネーション対策の基本となります。

RAG(外部データベースを参照させる技術)を活用する

RAG(Retrieval-Augmented Generation)は、AIが回答を生成する前に、社内マニュアルや最新の業界レポートなど、信頼できる外部のデータベースを参照する技術です。

AIの内部知識だけに頼らず、リアルタイムで正確な情報源を検索してから回答するため、ハルシネーションを劇的に減らすことができます。

自社の独自情報に基づいた正確な回答が求められる、カスタマーサポートのチャットボットなどで活用が進んでいます。

こちらは、ハルシネーション対策の鍵となるRAG(検索拡張生成)の技術について、包括的に解説したサーベイ論文です。合わせてご覧ください。 https://arxiv.org/html/2401.01313v1

Webブラウジング機能で最新情報を検索させる

ChatGPTの有料プランなどで提供されているWebブラウジング機能も、ハルシネーション対策に有効です。

この機能を使うと、AIは自身の内部知識だけでは答えられない質問に対して、リアルタイムでインターネットを検索し、最新情報に基づいて回答を生成します。

AIの知識のカットオフ問題を克服し、時事性の高いトピックについても正確な情報を提供しやすくなります。

特定の業務に特化させる(ファインチューニング)

ファインチューニングとは、既存のAIモデルに対して、特定の専門分野や業務に関する高品質なデータを追加で学習させることです。

例えば、法律分野の判例データや、医療分野の論文データを学習させることで、その分野に特化した「専門家AI」を作ることができます。

専門知識が深まることで、その分野における不正確な情報の生成が減り、回答の精度と信頼性が向上します。

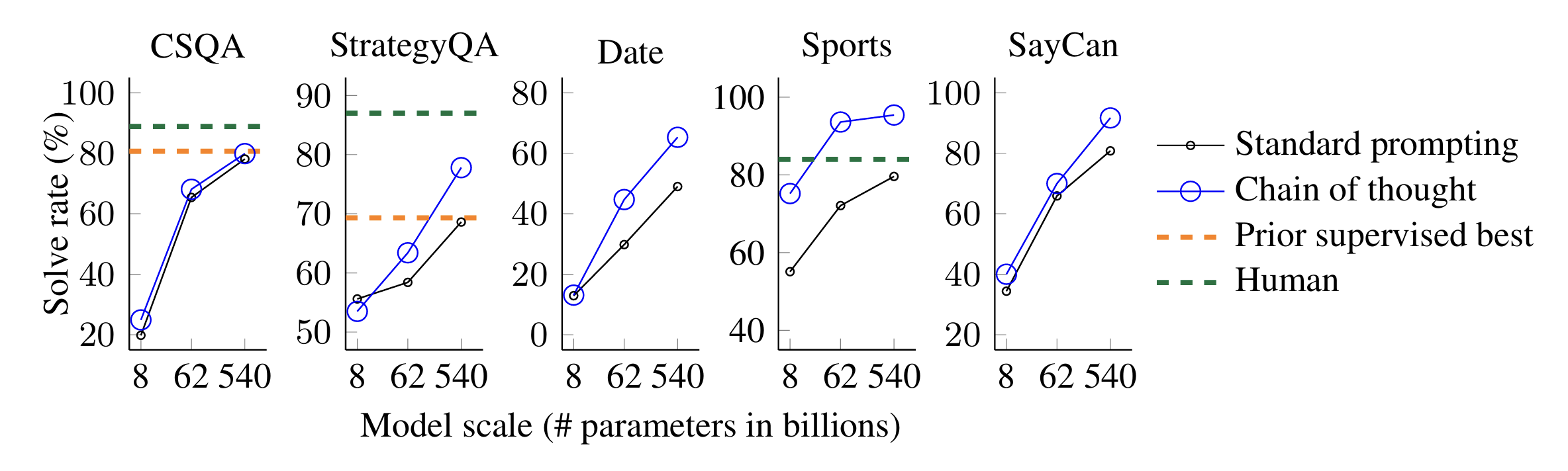

思考の連鎖(Chain-of-Thought)で段階的に考えさせる

Chain-of-Thought(CoT)プロンプティングは、AIに最終的な答えだけを求めず、結論に至るまでの中間的な思考プロセスを段階的に出力させる手法です。

「ステップ・バイ・ステップで考えてください」のように指示することで、AIは複雑な問題に対しても論理的に順序立てて考えるようになり、結論の飛躍や誤りを減らすことができます。

生成された思考プロセスを確認することで、人間がAIの回答の妥当性を検証しやすくなるという利点もあります。

こちらは、AIに段階的な思考を促す「思考の連鎖(Chain-of-Thought)」プロンプティングを最初に提唱したGoogleの研究論文です。合わせてご覧ください。 https://arxiv.org/abs/2201.11903

出力の多様性を調整する(Temperature)

API経由でAIを利用する場合、「Temperature」というパラメータを調整することができます。

この値は0から1(またはそれ以上)で設定され、値が低いほどAIの回答は決定的で一貫性のあるものになり、高いほど多様で創造的になります。

ハルシネーションを抑え、事実に基づいた正確な回答が欲しい場合は、Temperatureを0.2などの低い値に設定することが有効です。

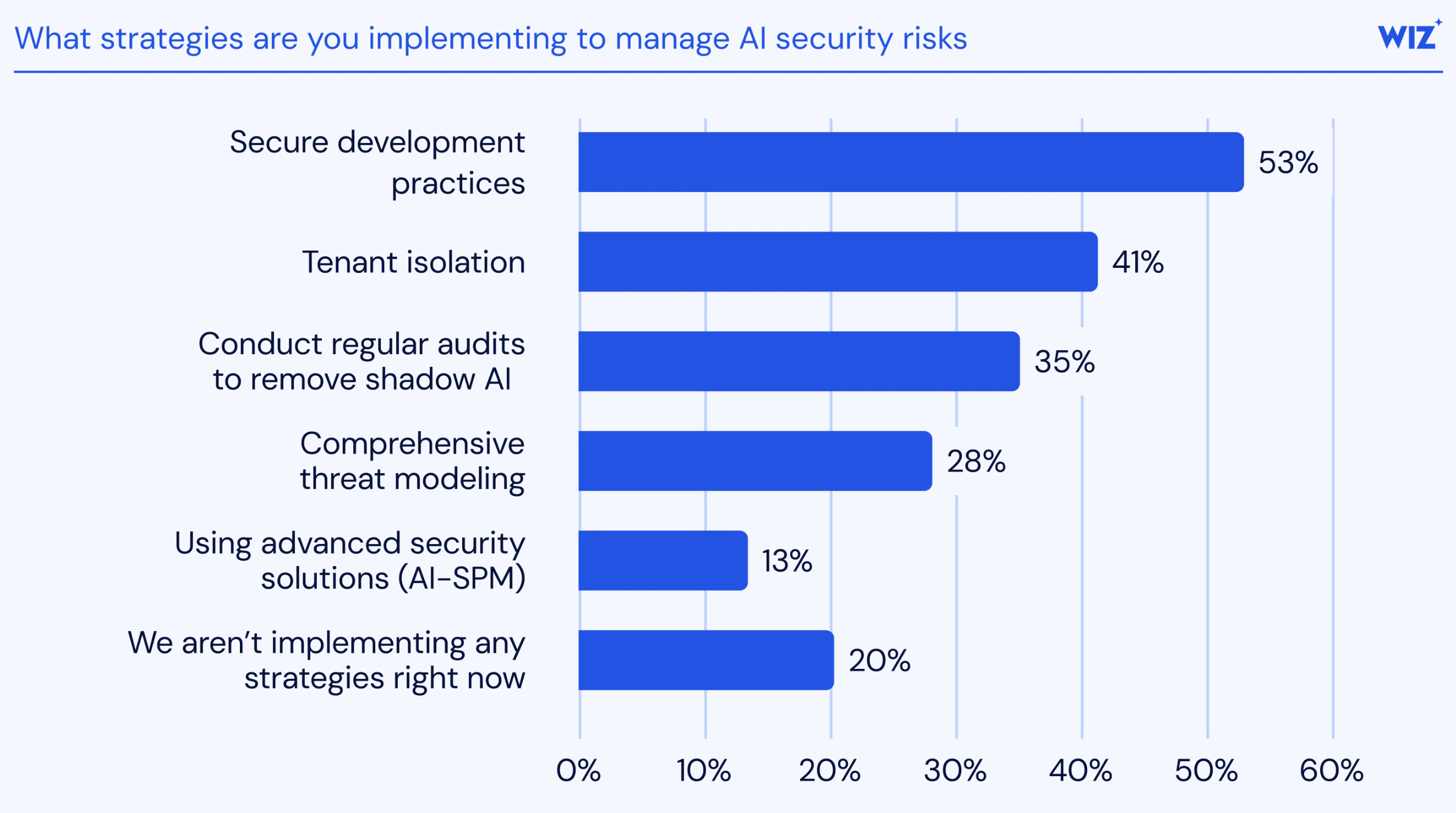

企業で生成AIを安全に使うためのハルシネーション対策

こちらは、米国立標準技術研究所(NIST)が策定した、企業がAIのリスクを管理するための世界的なフレームワークに関する解説です。合わせてご覧ください。 https://www.wiz.io/academy/nist-ai-risk-management-framework

個人のプロンプトの工夫だけでなく、組織としてルールや体制を整備することも、ハルシネーションのリスクを管理する上で不可欠です。

企業が安全に生成AIを活用するために、取り組むべき3つの対策を紹介します。

生成AIの利用ガイドラインを定める

まず、全従業員が遵守すべき生成AIの利用ガイドラインを策定することが重要です。

ガイドラインには、入力してはいけない情報(機密情報、個人情報など)の定義、AIが生成した情報の取り扱い(ファクトチェックの義務付けなど)、ハルシネーションを発見した場合の報告手順などを明記します。

これにより、従業員のAIリテラシーを向上させ、組織全体で一貫したリスク管理が可能になります。

必ず人間がファクトチェックを行う体制を整える

AIが生成した文章を、特に社外への公開や重要な意思決定に利用する前には、必ず人間の目によるファクトチェックを行う体制を構築する必要があります。

現状の技術では、ハルシネーションを完全にゼロにすることはできません。

内容の重要度に応じて、誰が、どのレベルまで確認するのかというダブルチェックのプロセスを明確に定めておくことが、ミスを防ぐ鍵となります。

継続的なフィードバックの仕組みを構築する

実際にAIを利用する中で発生したハルシネーションの事例や、うまくハルシネーションを抑制できたプロンプトのノウハウは、組織にとって貴重な財産です。

従業員がそうした事例を気軽に報告・共有できる仕組み(チャットツール上の専門チャンネルなど)を設けましょう。

集まったフィードバックを分析し、プロンプトのテンプレートや利用ガイドラインを定期的に改善していくことで、組織全体のAI活用レベルを向上させることができます。

もしハルシネーションが発生してしまった場合の対処法

どれだけ対策をしても、ハルシネーションが起きてしまう可能性はあります。

万が一、業務においてAIの生成した誤情報を使ってしまった場合に、冷静に対処するための3つのステップを解説します。

STEP1:事実確認と影響範囲の特定

まずは、AIが生成した情報が本当に誤りであるか、信頼できる情報源と照らし合わせて客観的な事実確認を行います。

誤りであると確定したら、その情報が誰に、どのような形で伝わってしまったのか、影響範囲を迅速に特定します。

社内資料に記載しただけなのか、既にお客様に提示してしまったのかによって、その後の対応が変わってきます。

STEP2:原因の分析とプロンプトの見直し

次に、なぜハルシネーションが発生したのか、原因を分析します。

原因の多くはプロンプトにあるため、どのような指示を出したのかを詳細にレビューします。

「指示が曖昧だった」「前提条件が不足していた」などの原因を特定し、同じ間違いを繰り返さないようにプロンプトを修正・改善します。

STEP3:関係者への情報共有と再発防止策の徹底

誤った情報が外部に伝わってしまった場合は、速やかに関係者に連絡し、訂正とお詫びを行います。

社内では、発生した事案と原因、そして改善したプロンプトをナレッジとしてチーム全体に共有します。

個人の失敗で終わらせず、組織としての学びとして次に活かすことが、再発防止において最も重要です。

ハルシネーション対策で知っておくべき注意点

ハルシネーション対策を進める上で、念頭に置いておくべき2つの重要な注意点があります。

これらを理解することで、より現実的で効果的なAIとの付き合い方が可能になります。

注意点1:ハルシネーションを100%なくすことは難しい

プロンプトの工夫や最新技術の活用により、ハルシネーションの発生確率を大幅に下げることは可能ですが、現時点の技術で100%なくすことは困難です。

AIはあくまで「確率的にもっともらしい文章を生成するツール」であるという本質を理解し、常に「間違える可能性がある」という前提で利用することが重要です。

最終的な判断と責任は、AIではなく利用する人間にあることを忘れてはいけません。

こちらは、計算可能性理論に基づき「大規模言語モデルにおけるハルシネーションは本質的に避けられない限界である」と論じた論文です。合わせてご覧ください。 https://arxiv.org/abs/2401.11817

注意点2:AIモデルのアップデートに合わせて対策を見直す

AIモデルは急速に進化しており、新しいモデルが登場するたびにその特性や性能は変化します。

あるモデルで有効だったハルシネーション対策のプロンプトが、新しいモデルでは最適ではない可能性もあります。

定期的に最新のAIモデルの情報を収集し、自社で活用しているプロンプトやガイドラインが時代遅れになっていないか、継続的に見直しと改善を行っていく姿勢が求められます。

ハルシネーション以外に注意すべき生成AIの主なリスク

ハルシネーションは生成AIが持つリスクの一つに過ぎません。

安全に活用するためには、以下のような他のリスクについても正しく理解し、対策を講じる必要があります。

機密情報・個人情報の漏洩

多くの対話型AIサービスでは、入力した情報がAIの学習データとして利用される可能性があります。

そのため、企業の内部情報や顧客の個人情報などを安易に入力してしまうと、情報漏洩につながるリスクがあります。

セキュリティを重視する場合は、入力したデータが学習に使われないことが保証されている法人向けサービス(例:「ChatSense」)などを利用することが推奨されます。

こちらは、大規模言語モデルにおけるデータ漏洩などのプライバシーリスクと、その保護技術について網羅的にまとめた調査論文です。合わせてご覧ください。 https://arxiv.org/abs/2508.09776v1

著作権の侵害

生成AIは、学習データに含まれる著作物を意図せず模倣し、それと酷似したコンテンツを生成してしまうことがあります。

生成された文章や画像を、元の著作物とは知らずに商用利用してしまうと、著作権侵害にあたる可能性があります。

AIによる生成物を利用する際は、既存の著作物と類似していないかを確認するプロセスを設けることが重要です。

倫理的な問題と偏見(バイアス)

AIの学習データには、インターネット上に存在する社会的な偏見や差別的な表現が含まれている場合があります。

その結果、AIが特定の属性を持つ人々に対して差別的な内容や、倫理的に問題のあるコンテンツを生成してしまうリスクがあります。

AIの回答を鵜呑みにせず、常に批判的な視点を持ち、偏った表現が含まれていないかを確認することが求められます。

こちらは、AIの倫理に関してUNESCO(国連教育科学文化機関)が採択した国際的な標準勧告です。合わせてご覧ください。 https://www.unesco.org/en/artificial-intelligence/recommendation-ethics

あなたのAIは嘘つきかも?生成AIの「ハルシネーション」を見抜いて“賢く使う”ための実践ガイド

「ChatGPT、便利だけど時々もっともらしい嘘をつくから信用できない…」そう感じていませんか?実は、その感覚は正しく、スタンフォード大学の研究でも大規模言語モデルが事実に基づかない情報を生成する「ハルシネーション」が大きな課題として指摘されています。しかし、ご安心ください。ハルシネーションは、その仕組みを理解し、適切な「質問の技術」を身につけることで、大幅に抑制することが可能です。この記事では、AIの嘘を見抜き、業務で安全に活用するための、今日から使える具体的なプロンプト術を分かりやすく解説します。

【警告】なぜAIは「もっともらしい嘘」をついてしまうのか

AIがハルシネーションを起こすのは、AIが「知らない」という状態を認識できず、確率的に最も自然に見える言葉を繋ぎ合わせようとする性質が原因です。AIは事実を理解しているのではなく、膨大なデータから学習したパターンを再現しているに過ぎません。この仕組みを理解しないままAIの回答を鵜呑みにすると、次のようなリスクに直面する可能性があります。

- 誤った情報に基づく意思決定

- 顧客信用の失墜

- 著作権やプライバシーの侵害

便利なツールも、使い方を誤ればビジネスに深刻なダメージを与えかねないのです。

引用元:

スタンフォード大学の基礎モデル研究センター(CRFM)は、主要な大規模言語モデルの透明性と信頼性を評価するプロジェクトを進めており、その中でハルシ-ネーション(モデルが生成する不正確または作り話の情報)が重要な評価指標の一つとされています。(Stanford University “Center for Research on Foundation Models (CRFM)”)

【実践】AIを「正直なアシスタント」に変えるプロンプト術

では、「賢く使う人」はAIの嘘をどうやって防いでいるのでしょうか。答えは、AIの思考を適切に導く「指示の出し方」にあります。ここでは、誰でも真似できる3つのテクニックをご紹介します。

テクニック①:出典を明記させる

情報の正確性が求められる場面では、必ず回答の根拠となる情報源を提示させましょう。これにより、AIは事実に基づいた回答を生成しようとします。

プロンプト例:

「日本の最新のエネルギー政策について、2025年時点の情報を基に要約してください。その際、主張の根拠となる公的機関のレポート名と、そのURLを必ず併記してください。」

テクニック②:「知らない」と言わせる

AIは知らないことでも知っているかのように振る舞うことがあります。それを防ぐため、正直に答えるよう指示します。

プロンプト例:

「作家、夏目漱石が執筆した未発表の作品について教えてください。もし情報が存在しない、あるいは不明な場合は、推測で答えずに『不明です』と回答してください。」

テクニック③:役割を与え、思考を制限する

AIに特定の役割を与え、参照する情報の範囲を限定することで、余計な創作を防ぎ、回答の精度を高めます。

プロンプト例:

「あなたは公平な視点を持つ編集者です。以下のインタビュー記事のみを参考にして、A氏の発言の要点を3つにまとめてください。記事に書かれていないあなたの意見や推測は一切含めないでください。」

まとめ

企業が業務効率化を目指して生成AIの導入を進める中で、ハルシネーション、つまりAIが生成する「もっともらしい嘘」が大きな障壁となっています。

しかし、実際には「ハルシネーションを防ぐプロンプトの専門知識がない」「安全に運用するための社内体制をどう作ればいいかわからない」といった理由で、本格的な活用に踏み出せない企業も少なくありません。

そこでおすすめしたいのが、Taskhubです。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、レポート自動生成など、ハルシネーションが起きにくいよう業務に最適化された「アプリ」を選ぶだけで、誰でも安全かつ直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「AIのリスク管理をどうすればいいのか」という初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプロンプトの知識がなくても、安全に業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“安全な生成AI活用”を体験し、御社のDXを一気に加速させましょう。