「自社でも生成AIを導入したいが、何から手をつければ良いかわからない…」

「従業員が勝手にAIを使い始め、情報漏洩や著作権侵害が起きないか心配…」

こういった悩みを持っている経営者や担当者の方も多いのではないでしょうか?

本記事では、企業が生成AI利用ガイドラインを策定すべき理由から、盛り込むべき必須要素、具体的な作成手順、さらには参考にすべき雛形事例までを網羅的に解説します。

この記事を読めば、自社に合った実効性の高いガイドラインを策定し、安全なAI活用の第一歩を踏み出すことができるでしょう。

ぜひ最後までご覧ください。

なぜ必要?企業が生成AI利用ガイドラインを策定すべき理由

ここからは、企業が生成AI利用ガイドラインを策定すべき4つの主な理由を解説します。

- 法的リスクの回避とコンプライアンス遵守のため

- 情報漏洩・セキュリティリスクを防ぐため

- 企業の社会的信用とブランドイメージを維持するため

- 従業員が安全かつ効率的にAIを活用するため

これらの理由を理解することで、ガイドライン策定の重要性を具体的に把握できます。

それでは、1つずつ順に解説します。

法的リスクの回避とコンプライアンス遵守のため

生成AIの利用には、個人情報保護法や著作権法などの法律に関わるリスクが潜んでいます。

例えば、AIへの入力データに顧客の個人情報が含まれていれば個人情報保護法に抵触する恐れがあり、生成されたコンテンツが既存の著作物に類似していれば著作権侵害を問われる可能性があります。

ガイドラインで利用ルールを明確に定めることで、従業員が意図せず法を犯すことを防ぎ、企業のコンプライアンス体制を強化できます。

こちらは、企業が準拠すべき指針として経済産業省が公開している「AI事業者ガイドライン」です。合わせてご覧ください。 https://www.meti.go.jp/press/2024/04/20240419004/20240419004.html

情報漏洩・セキュリティリスクを防ぐため

多くの生成AIサービスは、入力されたデータをサービス改善のために学習データとして利用する可能性があります。

もし従業員が社外秘の機密情報や顧客の個人情報を入力してしまえば、それが外部に漏洩し、深刻なセキュリティインシデントに発展する危険性があります。

ガイドラインで入力してはならない情報を具体的に定義し、周知徹底することで、このような情報漏洩リスクを未然に防ぐことが不可欠です。

企業の社会的信用とブランドイメージを維持するため

生成AIの不適切な利用による情報漏洩やコンプライアンス違反が発生すれば、企業の社会的信用は大きく損なわれます。

一度失った信用を回復するには多大な時間とコストがかかり、企業の存続そのものを脅かすことにもなりかねません。

ガイドラインを策定し、全社でAI利用に関する統一されたルールを持つことは、企業のレピュテーションリスクを管理し、ブランドイメージを維持する上で極めて重要です。

従業員が安全かつ効率的にAIを活用するため

明確なルールがない状態では、従業員は「何が許可されていて、何が禁止されているのか」が分からず、AIの利用に萎縮してしまいます。

これでは、せっかくの革新的な技術も業務効率化や生産性向上に繋がりません。

ガイドラインによって安全な利用範囲とルールを示すことで、従業員は安心してAIを業務に活用できるようになります。

結果として、AIのポテンシャルを最大限に引き出し、企業全体の競争力強化に貢献します。

こちらの記事では、ChatGPTを会社で導入する際の方法から具体的な注意点まで網羅的に解説しています。合わせてご覧ください。 https://taskhub.jp/useful/chatgpt-use-in-company/

企業が生成AI利用ガイドラインで対策すべきリスク

ここでは、企業が生成AI利用ガイドラインを策定する上で、特に対策すべき4つの主要なリスクについて解説します。

- 機密情報や個人情報の漏洩リスク

- 著作権や商標権などの知的財産権の侵害リスク

- AI生成物の不正確性・虚偽情報によるリスク

- マルウェア感染やサイバー攻撃のリスク

これらのリスクを正しく理解し、それぞれに対する具体的な対策をガイドラインに盛り込むことが重要です。

それでは、各リスクを詳しく見ていきましょう。

機密情報や個人情報の漏洩リスク

生成AIの利用における最大のリスクの一つが、機密情報や個人情報の漏洩です。

従業員が業務上のやり取りで得た顧客情報や、開発中の製品に関する社外秘の情報をAIツールに入力した場合、そのデータがAIモデルの学習に使用され、他のユーザーへの回答として出力されてしまう可能性があります。

このような事態を防ぐため、ガイドラインでは入力禁止情報を明確に定義し、徹底させることが不可欠です。

著作権や商標権などの知的財産権の侵害リスク

生成AIは、インターネット上の膨大なデータを学習してコンテンツを生成します。

そのため、生成された文章や画像が、意図せず既存の著作物や商標と酷似してしまうケースがあり、知的財産権の侵害につながるリスクをはらんでいます。

ガイドラインでは、生成物の利用前に必ず類似コンテンツのチェックを行うことや、商用利用する際のルールを定めるなど、権利侵害を未然に防ぐための具体的な手順を規定する必要があります。

AI生成物の不正確性・虚偽情報によるリスク

生成AIは、時に「ハルシネーション(幻覚)」と呼ばれる、事実に基づかないもっともらしい嘘の情報を生成することがあります。

AIが生成した情報を鵜呑みにし、ファクトチェックを怠ったまま顧客への提案資料や公式発表に利用してしまうと、企業の信用を著しく損なう原因となります。

ガイドラインには、AIの生成物はあくまで「下書き」や「たたき台」として扱い、必ず人間によるファクトチェックと内容の精査を義務付ける条項を盛り込むべきです。

マルウェア感染やサイバー攻撃のリスク

生成AIの利用を装ったフィッシングサイトや、AI機能を搭載した悪意のあるソフトウェア、ブラウザ拡張機能などを通じて、マルウェアに感染するリスクも存在します。

これらは、IDやパスワード、企業の機密情報を窃取するサイバー攻撃の入口となり得ます。

ガイドラインで会社が許可したAIツールのみ利用を許可し、安易に不明なサービスやツールをインストールしないよう注意喚起することが、こうしたセキュリティリスクを低減する上で重要です。

事例で学ぶ!企業の生成AI利用ガイドライン違反による事故事例

ここでは、実際に発生した生成AIの不適切な利用による事故事例を3つ紹介します。

- 大手メーカーでの機密ソースコード流出事例

- 法律事務所での架空判例引用による信用失墜事例

- 個人情報の不適切な入力によるプライバシー侵害事例

これらの失敗事例から学ぶことで、ガイドライン策定の重要性をより深く理解することができます。

大手メーカーでの機密ソースコード流出事例

海外の大手電機メーカーにおいて、従業員が業務効率化のために、社外秘のソースコードや機密情報を含む会議の議事録を外部の生成AIサービスに入力していたことが発覚しました。

入力されたデータがAIの学習に利用され、外部に流出した可能性が指摘されました。

この事例は、従業員の悪意なき行動が、いかに容易に重大な情報漏洩に繋がりうるかを示しており、入力データに関する厳格なルール設定の必要性を物語っています。

法律事務所での架空判例引用による信用失墜事例

米国の法律事務所で、弁護士が訴訟準備のために生成AIを利用し、AIが提示した過去の判例を引用して準備書面を作成しました。

しかし、後にその判例がAIによって生成された架空のものであったことが判明し、裁判所から制裁を科される事態となりました。

この一件は専門家の間でも大きな波紋を呼び、AI生成物のファクトチェックを怠ることの危険性と、専門業務におけるAI利用の責任の所在を問いかける事例となりました。

個人情報の不適切な入力によるプライバシー侵害事例

ある企業で、従業員が顧客からの問い合わせ対応を効率化しようと、顧客の氏名や連絡先、相談内容といった個人情報を含むテキストを要約のために生成AIに入力してしまいました。

これは企業のプライバシーポリシーに違反するだけでなく、個人情報保護法に抵触する可能性のある重大なインシデントです。

たとえ業務目的であっても、個人情報を安易に入力することの危険性を示しており、ガイドラインで個人情報の取り扱いを厳格に定めることの重要性が分かります。

企業が生成AI利用ガイドラインに盛り込むべき必須要素

効果的なガイドラインを策定するためには、いくつかの必須要素を網羅する必要があります。

- 利用目的と対象範囲の明確化

- 入力禁止情報(機密情報・個人情報など)の定義

- 生成物の著作権・帰属と利用ルールの策定

- AI生成物のファクトチェックと正確性担保の義務

- 罰則規定やインシデント発生時の報告体制

これらの要素を自社の状況に合わせて具体的に定めることで、実用性の高いガイドラインを作成できます。

以下で、それぞれの要素について詳しく解説します。

利用目的と対象範囲の明確化

まず、ガイドラインの冒頭で、生成AIを導入する目的を明確に示します。

「業務効率化による生産性の向上」や「新たなアイデア創出の促進」など、具体的な目的を掲げることで、従業員の理解を促進し、積極的な活用を促します。

同時に、ガイドラインが適用される対象者(全従業員、特定の部署など)や、利用が許可される業務の範囲(資料作成、情報収集など)を具体的に定義することで、ルールの適用範囲を明確にします。

入力禁止情報(機密情報・個人情報など)の定義

ガイドラインの中核となるのが、入力してはならない情報の定義です。

「個人情報(氏名、住所、電話番号など)」「顧客情報(取引履歴、契約内容など)」「社外秘情報(開発情報、財務情報など)」「アクセス情報(ID、パスワードなど)」のように、具体的な例を挙げてリスト化することが重要です。

何が機密情報にあたるかの判断基準も示し、従業員が迷うことなく遵守できるよう配慮する必要があります。

生成物の著作権・帰属と利用ルールの策定

生成AIが作成したコンテンツ(文章、画像、コードなど)の著作権が誰に帰属するのか、またそれをどのように利用できるのかを定めます。

基本的には、業務時間中に会社の設備を使用して生成したものは会社の著作物となる旨を明記します。

さらに、生成物を社外に公開する場合のルール(上長の承認、ファクトチェックの徹底など)や、社内での利用範囲についても規定し、無秩序な利用によるトラブルを防ぎます。

AI生成物のファクトチェックと正確性担保の義務

生成AIは誤った情報を生成するリスクがあるため、生成された情報を鵜呑みにしないよう、利用者に対する義務を明確に定めます。

具体的には、AIが生成した情報やデータは必ず一次情報や信頼できる情報源と照合し、内容の正確性を確認する「ファクトチェック」を義務付けることが不可欠です。

特に、外部に公開する資料や意思決定の根拠となるデータに利用する際には、複数人でのダブルチェックを推奨するなど、より厳格なプロセスを設けるべきです。

罰則規定やインシデント発生時の報告体制

ガイドラインの実効性を担保するためには、違反した場合の措置を明記することが重要です。

就業規則に基づき、懲戒処分の対象となる可能性があることを示すことで、従業員の規範意識を高めます。

同時に、ガイドライン違反や情報漏洩などのインシデントが発生、またはその恐れがある場合に、従業員が速やかに報告すべき部署(情報システム部、法務部など)と報告手順を定めておくことで、迅速な初期対応と被害の最小化を図ることができます。

企業向け生成AI利用ガイドラインの簡単な作成手順4ステップ

ここでは、実際にガイドラインを作成するための具体的な手順を4つのステップに分けて解説します。

- Step1:AIの利用目的と活用範囲を明確にする

- Step2:潜在的なリスクを洗い出し、対策を検討する

- Step3:他社のガイドライン事例を参考に草案を作成する

- Step4:弁護士など専門家のレビューを受け、周知徹底する

この手順に沿って進めることで、網羅的かつ自社に合ったガイドラインを効率的に作成できます。

Step1:AIの利用目的と活用範囲を明確にする

最初に、自社がなぜ生成AIを導入するのか、その目的を定義します。

「マーケティングコンテンツの作成効率化」「議事録作成の自動化による工数削減」「ソフトウェア開発におけるコーディング支援」など、具体的な活用シーンを想定します。

この目的を軸に、どの部署の、どのような業務でAI利用を許可するのか、といった活用範囲を定めることで、ガイドライン全体の方向性が明確になります。

Step2:潜在的なリスクを洗い出し、対策を検討する

次に、Step1で定めた利用目的と活用範囲に沿って、どのようなリスクが想定されるかを洗い出します。

情報漏洩、著作権侵害、虚偽情報といった一般的なリスクに加え、自社の業務特有のリスクについても検討します。

例えば、顧客との対話で利用する場合は個人情報の入力リスクが、製品開発で利用する場合は技術情報の漏洩リスクが高まります。

洗い出したリスクそれぞれに対し、具体的な禁止事項や遵守事項といった対策を検討します。

Step3:他社のガイドライン事例を参考に草案を作成する

ゼロからガイドラインを作成するのは大変な作業です。

そこで、後述する他社の公開事例や、業界団体が提供する雛形を参考にします。

これらの事例から、自社に必要な項目や表現をピックアップし、Step1とStep2で検討した内容を盛り込みながら、ガイドラインの草案(ドラフト)を作成します。

他社の事例をそのまま流用するのではなく、必ず自社の実情に合わせてカスタマイズすることが重要です。

Step4:弁護士など専門家のレビューを受け、周知徹底する

草案が完成したら、法務部や顧問弁護士など、法律の専門家によるレビューを受けます。

著作権法や個人情報保護法などの観点から、法的な問題がないか、リスクが適切にカバーされているかを確認してもらうことで、ガイドラインの信頼性と実効性が高まります。

最終版が完成したら、研修会や説明会などを実施し、全従業員にガイドラインの内容を周知徹底します。

策定して終わりではなく、全社に浸透させることが最も重要です。

こちらは社員のAIリテラシー向上に役立つ生成AIプロンプト研修について解説した記事です。合わせてご覧ください。 https://taskhub.jp/useful/generation-ai-prompt-training/

【雛形あり】企業が参考にすべき生成AI利用ガイドライン事例11選

ここでは、ガイドライン作成の際に非常に参考になる、公的機関や企業が公開している事例を11個紹介します。

これらの雛形や事例を参考にすることで、自社で盛り込むべき項目や表現の具体的なイメージを掴むことができます。

【ひな形】日本ディープラーニング協会

一般社団法人日本ディープラーニング協会(JDLA)は、企業が利用できる「生成AIの利用ガイドライン」の雛形を無償で公開しています。

この雛形は、基本的な構成要素が網羅されており、Word形式でダウンロードして自社の状況に合わせて自由にカスタマイズできるため、これからガイドラインを作成する企業にとって最初のたたき台として非常に有用です。

法務、知財、技術、倫理の専門家が監修しており、信頼性が高い点も特徴です。

【省庁】総務省:AI利活用ガイドライン

総務省は、AI開発者、AI提供者、AI利用者といった様々なステークホルダーを対象とした「AI利活用ガイドライン」を公表しています。

特に「利用者」向けの内容は、企業がガイドラインを策定する上で直接参考になります。

AI利活用の原則や、プライバシー保護、セキュリティ確保といった基本的な考え方が示されており、自社のガイドラインに社会的な公正性や倫理的な配慮を盛り込む際の指針となります。

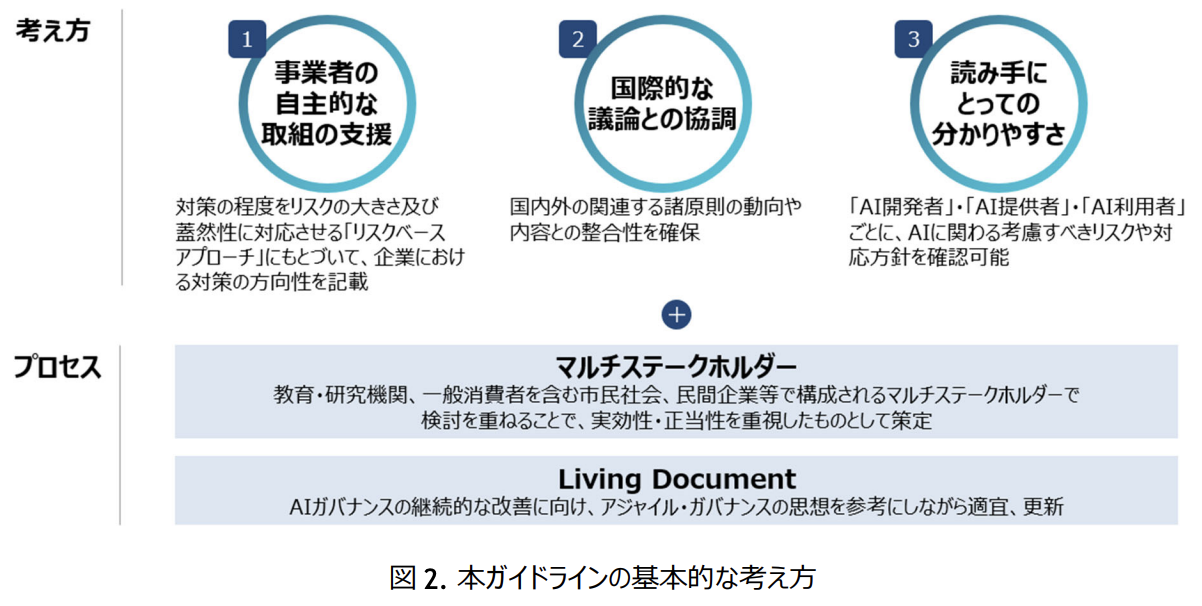

【省庁】経済産業省:AI事業者ガイドライン

経済産業省が総務省と共同で策定した「AI事業者ガイドライン」は、AIを提供する側の事業者に向けたものですが、AIを利用する企業にとっても重要な示唆に富んでいます。

AIの品質や公平性、透明性、セキュリティといった観点から、信頼できるAIサービスを選定する際の基準として活用できます。

自社で利用するAIツールを選定する際のルールをガイドラインに盛り込む場合に参考にすると良いでしょう。

【省庁】文部科学省:教育現場向けガイドライン

文部科学省が公表している「初等中等教育段階における生成AIの利用に関する暫定的なガイドライン」は、教育現場を対象としたものですが、その考え方は企業にも応用できます。

特に、AIの特性や限界、誤った情報が含まれる可能性を理解した上で、批判的思考(クリティカル・シンキング)を持って向き合う姿勢の重要性を説いています。

従業員のAIリテラシー向上に関する項目を設ける際に参考になります。

【自治体】東京都デジタルサービス局

東京都は、都庁内でのChatGPT利用に関するガイドラインをいち早く策定・公開しました。

行政機関としての立場から、個人情報や機密情報の取り扱いについて厳格なルールを定めている点が特徴です。

入力してはならない情報の具体例や、利用時の注意点が明確に示されており、特に個人情報や機密情報を扱う機会の多い企業にとって、リスク管理の観点から非常に参考になる事例です。

【自治体】愛知県

愛知県も、県庁職員向けの「文章生成AI利活用ガイドライン」を公開しています。

このガイドラインは、具体的な活用例(アイデア出し、文章の校正、翻訳など)と、それに伴うリスク、そして禁止事項がセットで分かりやすく整理されています。

従業員がAIをどのような業務に活用できるのか、その際に何を注意すべきなのかを具体的に示す際の構成として参考にできます。

平易な言葉で書かれているため、分かりやすいガイドラインを目指す上で役立ちます。

【国内企業】富士通

大手ITベンダーである富士通は、社内実践で得た知見を基にした「Fujitsu Group AI倫理およびガバナンス」を公開しています。

その中では、AIを開発・提供する側、そして利用する側の双方の観点から、人権尊重、プライバシー保護、公平性といった倫理原則を定めています。

企業の社会的責任(CSR)やESG経営の観点から、倫理的なAI利用をガイドラインに盛り込みたい場合に、非常に参考になるでしょう。

【国内企業】CYDAS

株式会社サイダスは、人事・タレントマネジメントシステムを提供する企業として、独自の「生成AI利用ガイドライン」を公開しています。

このガイドラインは、同社のサービスを利用する顧客や社会に対する責任という視点が盛り込まれている点が特徴です。

特に、生成物の利用に関するルールが詳細に定められており、AIが生成したコンテンツをどのように取り扱うべきか、具体的なルールを策定する上で参考になります。

【国内企業】パナソニックコネクト

パナソニック コネクト株式会社は、全社員約28,500人を対象に自社開発の生成AIアシスタントを導入しており、その利用に関するガイドラインも策定しています。

このガイドラインは、生産性向上という目的を明確にしつつ、情報漏洩リスクへの対策を具体的に示しています。

特に、入力情報に関するルールが厳格に定められており、セキュリティを最優先に考えたい企業にとって、その記述方法や内容が手本となります。

【大学】上智大学

上智大学は、学生や教職員向けに「生成AIの利用に関する考え方と注意点」を公開しています。

教育・研究機関としての立場から、レポート作成などにおける不正利用の禁止や、著作権、倫理的配慮の重要性を強調しています。

特に、AIの生成物をそのまま利用するのではなく、あくまで思考を深めるための「補助的な道具」として位置づける考え方は、企業におけるAI利用のスタンスを定める上で参考になります。

【G7】広島AIプロセス

G7広島サミットで合意された「広島AIプロセス」は、生成AIに関する国際的なルール作りの指針です。

「人間の監視」「透明性」「偽情報対策」など、信頼できるAIの実現に向けた開発者向けの国際指針が含まれています。

これは直接的な企業のガイドラインではありませんが、自社のガイドラインが国際的な潮流や価値観と合致しているかを確認するための、より上位の概念として参照すべき重要な文書です。

企業が生成AI利用ガイドラインを安全に運用するための6つの注意点

ガイドラインは策定して終わりではありません。形骸化させず、安全に運用し続けるための注意点を6つ紹介します。

- 利用範囲やツールを適切に設定・選定する

- リスクを最小化するデータ管理体制を構築する

- 従業員向けのマニュアル整備と定期的な研修を行う

- 従業員のAIリテラシーを向上させる

- 最新の動向に合わせてガイドラインを定期的に見直す

- システムとルールの両面からリスク管理を行う

これらの点に留意することで、ガイドラインの実効性を維持し、変化に対応していくことができます。

利用範囲やツールを適切に設定・選定する

全社一律で同じツールを無制限に許可するのではなく、部署や業務内容に応じて利用できるAIツールや利用範囲を適切に設定することが重要です。

例えば、機密情報を扱う部署では、入力したデータが学習に使われないセキュリティの高い法人向けプランに限定するなどの対応が考えられます。

また、利用するAIツール自体も、提供元の信頼性やセキュリティポリシーを十分に調査した上で、会社として推奨・許可するツールをリスト化し、それ以外の利用を原則禁止にすることが望ましいです。

リスクを最小化するデータ管理体制を構築する

ルールだけでなく、技術的な側面からのデータ管理体制の構築も不可欠です。

例えば、AIに入力する前に個人情報や機密情報を自動でマスキング(匿名化)する仕組みを導入したり、AIツールの利用ログを監視して不適切な利用がないかをチェックしたりする体制を整えることが考えられます。

データへのアクセス権限を適切に管理し、必要最小限の従業員のみが重要な情報に触れられるようにすることも、リスク管理の基本となります。

従業員向けのマニュアル整備と定期的な研修を行う

ガイドラインは抽象的なルールであることが多いため、具体的な操作方法や判断基準を示したマニュアルを別途整備することが効果的です。

「こういう場合は入力OK」「こういう情報はNG」といった具体例(Do/Don’t)を豊富に盛り込むことで、従業員の理解を助けます。

また、一度周知して終わりではなく、入社時研修に組み込んだり、全社で定期的なeラーニングや研修会を実施したりすることで、ルールの形骸化を防ぎ、意識を高く保つことができます。

従業員のAIリテラシーを向上させる

なぜガイドラインを守る必要があるのか、その背景にあるリスクを従業員一人ひとりが正しく理解することが重要です。

生成AIの仕組みや特性、限界(ハルシネーションなど)について学ぶ機会を提供し、従業員のAIリテラシーを向上させる取り組みが求められます。

リテラシーが向上すれば、従業員はガイドラインを「やらされ仕事」としてではなく、自分自身と会社を守るための重要なルールとして認識し、自律的に遵守するようになります。

最新の動向に合わせてガイドラインを定期的に見直す

生成AIの技術や関連する法規制、社会的な動向は日々めまぐるしく変化しています。

策定した時点では万全だったガイドラインも、すぐに時代遅れになってしまう可能性があります。

そのため、最低でも半年に一度、あるいは新しい技術やサービスが登場したタイミングで、ガイドラインの内容を見直すプロセスをあらかじめ決めておくことが重要です。

常に最新の状況に合わせてアップデートし続けることで、ガイドラインの実効性を維持できます。

システムとルールの両面からリスク管理を行う

ガイドラインという「ルール」による対策と、前述したデータ管理や監視ツールといった「システム」による対策は、車の両輪です。

ルールだけで従業員の行動を100%縛ることは難しく、一方でシステムだけでは予期せぬ利用に対応できません。

両者を組み合わせることで、より堅牢なリスク管理体制を構築できます。

例えば、ガイドラインで「個人情報の入力禁止」を定めると同時に、システムで個人情報パターンを検知して入力をブロックする、といった対策が考えられます。

企業が生成AI利用ガイドラインの導入を成功させる5つのポイント

ガイドラインを策定し、AI導入を成功に導くためには、いくつかの重要なポイントがあります。

- 導入前に業務を棚卸し、活用インパクトを試算する

- 投資対効果の高い課題からスモールスタートする

- アジャイルなアプローチで開発・導入を進める

- PoC(概念実証)で効果を検証しながら進める

- 経営層の理解と協力体制を構築する

これらのポイントを押さえることで、計画的かつ効果的にAI活用を進めることができます。

導入前に業務を棚卸し、活用インパクトを試算する

やみくもにAI導入を進めるのではなく、まずは自社の業務プロセスを詳細に洗い出す「業務の棚卸し」を行います。

そして、各業務の中で「AIを活用することで、どの程度の時間短縮やコスト削減が見込めるか」「どのような付加価値が生まれるか」といった活用インパクトを試算します。

これにより、AIを導入すべき優先順位が明確になり、投資判断の的確な根拠となります。

投資対効果の高い課題からスモールスタートする

最初から全社一斉に大規模な導入を目指すのは、リスクもコストも高くなります。

まずは、前段の試算で明らかになった「投資対効果(ROI)が高い」と見込まれる特定の業務や部署に絞って、小規模に導入を開始する「スモールスタート」が賢明です。

例えば、マーケティング部門のブログ記事作成支援や、カスタマーサポート部門のFAQ作成など、限定的な範囲で始めることで、成功体験を積みやすく、ノウハウを蓄積できます。

アジャイルなアプローチで開発・導入を進める

生成AIの技術は発展途上であり、最初から完璧な導入計画を立てることは困難です。

そこで、「計画→実行→評価→改善」というサイクルを短期間で何度も繰り返す「アジャイルなアプローチ」が有効です。

まずは小規模なプロトタイプを導入し、利用者のフィードバックを元に改善を重ねていくことで、現場のニーズに即した、より実用的なAI活用を実現できます。

ガイドライン自体も、このアプローチで見直していくことが望ましいです。

PoC(概念実証)で効果を検証しながら進める

本格的な導入の前に、PoC(Proof of Concept:概念実証)を実施することも重要なポイントです。

PoCとは、新しい技術やアイデアが実現可能か、期待した効果が得られるかを、小規模な環境で検証する取り組みです。

特定の課題に対して生成AIを試験的に適用し、その有効性や課題点を具体的に評価します。

この検証結果に基づき、本格導入の可否を判断したり、導入計画を修正したりすることで、失敗のリスクを最小限に抑えることができます。

経営層の理解と協力体制を構築する

生成AIの全社的な導入は、単なるツール導入に留まらず、業務プロセスの変革を伴う大きなプロジェクトです。

そのため、プロジェクトを推進するには、経営層の深い理解と強力なリーダーシップが不可欠です。

AI導入の戦略的な重要性や期待される効果を経営層に十分に説明し、予算確保や部門間の調整など、全社的な協力体制を構築することが、成功の鍵を握ります。

企業が生成AI利用ガイドライン策定で参考にすべきG7の5原則

G7広島サミットで合意された「広島AIプロセス」では、すべてのAI関係者が推進すべき5つの国際的な原則が示されています。

- 法の支配

- 人権尊重

- 適正な手続き

- 民主主義

- 技術革新の機会の活用

これらの原則は、企業のガイドラインが準拠すべき基本的な価値観として、策定時に念頭に置くべきものです。

法の支配

AIの利用は、各国の法律や規制を遵守して行われるべきであるという原則です。

企業のガイドラインにおいても、著作権法、個人情報保護法、その他の関連法規を遵守することを明確に記載し、コンプライアンスを徹底する姿勢を示す必要があります。

法的なリスクを回避し、社会的な信頼を得るための基本中の基本と言えます。

人権尊重

AIの利用が、個人のプライバシーや表現の自由、尊厳といった基本的人権を侵害してはならないという原則です。

ガイドラインでは、個人情報を不適切に扱わないことや、AIによる差別や偏見を助長するような利用を禁止するなど、人権への配慮を盛り込むことが求められます。

従業員一人ひとりが、自らのAI利用が人権に与える影響を意識することが重要です。

適正な手続き

AIシステムの意思決定プロセスは、公正かつ透明であるべきだという原則です。

企業がAIを採用活動や人事評価などに利用する場合、その判断基準がブラックボックス化しないよう、透明性を確保し、人間が適切に関与・監督する仕組みを設ける必要があります。

ガイドラインにおいても、AIの判断を鵜呑みにせず、必ず人間が最終的な責任を持つことを明記すべきです。

民主主義

AI技術が、特定の思想を押し付けたり、社会の分断を煽ったりするなど、民主主義的な価値を脅かすために利用されてはならないという原則です。

企業活動においては、AIを利用してフェイクニュースを拡散したり、世論を不当に操作したりすることを厳に禁じる必要があります。

企業の社会的責任として、民主主義社会の健全な発展に貢献するようなAI利用を心掛けるべきです。

技術革新の機会の活用

AIがもたらすポジティブな側面、すなわちイノベーションを促進し、社会課題の解決に貢献する可能性を最大限に活用すべきであるという原則です。

ガイドラインは、リスク管理のために制限を設けるだけでなく、同時に、従業員がAIを安全かつ創造的に活用し、新たな価値を生み出すことを奨励する内容であるべきです。

守りと攻めの両方のバランスを取ることが重要になります。

企業が生成AI利用ガイドラインの実効性を高めるツールとは

ガイドラインというルールを定着させ、その実効性を高めるためには、従業員の意識だけでなく、テクノロジーの力を活用することも非常に有効です。

ここでは、ガイドライン運用を支援する3種類のツールを紹介します。

AIの利用状況を可視化・監視する

従業員が「いつ」「誰が」「どのAIサービスを」「何のために」利用しているかを可視化・監視できるツールがあります。

これにより、ガイドラインで許可されていないツールの利用(シャドーIT)や、特定の部署での利用頻度の偏りなどを把握できます。

利用実態をデータに基づいて把握することで、より実態に即したガイドラインの見直しや、必要な研修の特定に繋げることができます。

不適切な利用や情報入力をブロックする

ガイドラインで禁止されている情報の入力をシステム的にブロックするツールも存在します。

例えば、個人情報や、あらかじめ登録した企業の機密情報に関するキーワードがAIへのプロンプトに含まれていた場合に、送信を自動で遮断したり、警告を発したりすることができます。

従業員のうっかりミスによる情報漏洩を未然に防ぐ上で、非常に効果的な対策となります。

セキュリティサービスを導入してリスクを低減する

AI利用に特化したセキュリティサービスを導入することで、リスク管理を強化できます。

これらのサービスは、AIとの通信を暗号化したり、マルウェアの脅威から保護したり、利用ログを分析して不審な動きを検知したりする機能を統合的に提供します。

情報システム部門の管理負担を軽減しつつ、多角的なセキュリティ対策を実現するために、専門的なサービスの導入を検討する価値は高いでしょう。

そのガイドライン、社員を”AIを使えない人材”にしていませんか?

生成AIの利用ガイドラインを策定し、リスク管理に万全を期すことは非常に重要です。しかし、そのルールが厳格すぎるあまり、社員がAIの活用に臆病になり、結果として生産性向上の機会を逃しているとしたら、本末転倒かもしれません。ボストン コンサルティング グループ(BCG)の調査によれば、生成AIの導入で大きな成果を上げている企業は、単にリスクを管理するだけでなく、従業員が積極的にAIを試し、失敗から学べる「心理的安全性」を確保しているという共通点があります。厳しいだけのガイドラインは、イノベーションの芽を摘み、「AIを使わない」という、これからの時代における最大の経営リスクを生み出しかねません。

引用元:

ボストン コンサルティング グループ(BCG)の調査によると、生成AIの導入効果を最大限に引き出している企業は、リーダーが明確なビジョンを示し、従業員がリスクを恐れずに新しい活用法を試せる文化を醸成しています。(BCG, “GenAI Is a General-Purpose Technology—and That Changes Everything,” 2023年)

まとめ

企業は労働力不足や業務効率化の課題を抱える中で、生成AIの活用がDX推進や業務改善の切り札として注目されています。

しかし、実際には「どこから手を付ければいいかわからない」「社内にAIリテラシーを持つ人材がいない」といった理由で、導入のハードルが高いと感じる企業も少なくありません。

そこでおすすめしたいのが、Taskhub です。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「何をどう使えばいいのかわからない」という初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプログラミングや高度なAI知識がなくても、すぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最速の生成AI活用”を体験し、御社のDXを一気に加速させましょう。