「待望のGPT-5がリリースされたけど、GPT-5 APIはどうやって使うの?」

「GPT-4のAPIと何が違うのか、料金や具体的なコード例が知りたい。」

「PythonやNode.jsでGPT-5 APIを組み込む方法がわからない…。」

こういった悩みを持っている開発者やAI活用担当者の方も多いのではないでしょうか?

2025年8月にOpenAIからリリースされたGPT-5は、その高度な推論能力と応答速度で注目を集めています。

本記事では、GPT-5 APIの概要や特徴、料金体系から、具体的なセットアップ手順、Python・Node.jsを使ったコード例、さらには実践的なユースケースまでを網羅的に解説します。

上場企業をメインに生成AIコンサルティング事業を展開している弊社が、最新の公式情報と実践的な知見に基づき、GPT-5 APIの活用法をご紹介します。

この記事を読めば、GPT-5 APIをあなたのサービスや業務に組み込むための具体的なステップが理解できるはずです。ぜひ最後までご覧ください。

GPT-5 APIとは?GPT-4との違いや主な特徴

まずは、GPT-5 APIがどのようなものなのか、その基本的な概要と従来モデルとの違いを解説します。

- GPT-5 APIで何ができるようになるのか

- GPT-4など従来モデルのAPIとの違い

- gpt-5, gpt-5-mini, gpt-5-nanoなど利用可能なモデルの種類

- GPT-5の強み:高度なコード探索と計画能力

- GPT-5 APIに関する公式情報の要点

これらのポイントを押さえることで、GPT-5 APIのポテンシャルを最大限に引き出す準備ができます。

それでは、1つずつ順に見ていきましょう。

GPT-5 APIで何ができるようになるのか

GPT-5 APIの最大の特徴は、質問の難易度に応じてAIが「思考時間」を自動で切り替える能力にあります。

これにより、開発者はAPIを通じて、簡単な質問には即時応答を、コーディングや数学、データ分析といった複雑な推論が必要な質問には、じっくり考えた高精度な回答を得られるようになります。

例えば、単純なテキスト分類や要約は高速に処理しつつ、複雑なバグを含むコードのデバッグや、詳細な市場分析レポートの作成といった高度なタスクも、同じAPIエンドポイントで実行可能です。

また、画像や音声、動画といったマルチモーダルな入力にも標準対応しており(GPT-4oの機能を継承・強化)、テキスト生成だけでなく、より高度な画像分析やデータ解釈、コンテンツ生成がAPI経由で実現します。

こちらはGPT-5のベースとなったGPT-4oの特徴、使い方、APIについて解説した記事です。 合わせてご覧ください。

これにより、チャットボット、コーディングアシスタント、データ分析ツール、コンテンツ制作自動化など、あらゆるアプリケーションの「知能」を飛躍的に向上させることができます。

GPT-4など従来モデルのAPIとの違い

GPT-5 APIは、従来のGPT-4やGPT-4oのAPIと比較して、いくつかの決定的な違いがあります。

最大の違いは「モデルの統合」です。従来は「高速だが精度が低いモデル(GPT-3.5 Turboなど)」と「高精度だが高価で遅いモデル(GPT-4など)」を、開発者が用途に応じて使い分ける必要がありました。

しかしGPT-5では、これが単一のモデル(gpt-5)に統合されました。API側で質問の難易度を判断し、応答モード(即時応答モードや長考モード)を自動で切り替えてくれます。これにより、開発者はモデル選択に迷う必要がなくなりました。

二つ目の違いは「安全性の強化」です。GPT-5では「出力中心の安全性」という新しい概念が導入されました。これにより、不正な指示(プロンプトインジェクション)に対する耐性が大幅に向上しており、APIを通じてより安全にサービスを提供できるよう設計されています。

また、APIの入力コストが旧モデル(GPT-4など)より比較的安価に設定されている点も、開発者にとっては大きなメリットと言えるでしょう。

gpt-5, gpt-5-mini, gpt-5-nanoなど利用可能なモデルの種類

GPT-5 APIでは、用途に応じて選択可能な複数のモデルが提供されています。これにより、開発者はコストとパフォーマンスのバランスを最適化できます。

主なモデルは以下の3種類です。

- gpt-5(標準モデル)最も強力でバランスの取れたモデルです。簡単なタスクから複雑な推論まで、あらゆる状況に対応します。質問の難易度に応じて思考時間を自動で切り替える機能が最大の特徴です。

- gpt-5-mini(低コストモデル)gpt-5の能力を維持しつつ、より低コストで利用できるように最適化されたモデルです。応答速度も速く、チャットボットの日常的な応答や、大量のテキスト処理に適しています。

- gpt-5-nano(最速モデル)最も高速な応答が求められるタスク(例:リアルタイムの自動補完、単純な分類)に特化したモデルです。コストは最も安価ですが、複雑な推論能力は他のモデルに劣ります。

これらのモデルは、APIリクエスト時に model パラメータで指定して使い分けます。GPT-4時代の gpt-4-turbo や gpt-4o のような複雑なモデル分岐がなくなり、用途に応じた選択がよりシンプルになりました。

各モデルの詳細なスペックや性能比較については、こちらの公式モデル比較ガイドが参考になります。 合わせてご覧ください。 https://platform.openai.com/docs/models/compare

GPT-5の強み:高度なコード探索と計画能力

GPT-5 APIは、特に専門分野での能力が飛躍的に向上しています。その中でも「高度なコード探索と計画能力」は特筆すべき強みです。

参考情報によれば、GPT-5はコーディング、数学、データ分析といった分野で精度が大幅に向上しました。

これは、単にコードスニペットを生成するレベルではありません。APIを通じて、大規模なコードベース全体を理解し、バグの原因を特定したり、複雑なアルゴリズムを計画的に実装したり、あるいは既存のコードをリファクタリングしたりする能力を持ちます。

例えば、「このPythonプロジェクトのパフォーマンスボトルネックを特定し、改善案を提示して」といった抽象的な指示に対しても、APIが内部的に「長考(Thinking)」モードに切り替わり、コード間の依存関係を分析して具体的な回答を生成します。

この能力は、開発者支援ツールの構築、自動デバッグシステムの開発、あるいはデータサイエンティストの分析作業の自動化など、高度な技術的タスクの実行に革命をもたらす可能性を秘めています。

GPT-5 APIに関する公式情報の要点

2025年8月7日にOpenAIからリリースされたGPT-5に関する公式情報のうち、特にAPI利用者が押さえておくべき要点をまとめます。

- 思考時間の自動切替:APIがリクエストの難易度を判断し、「即時応答」と「長考(推論)」を自動で切り替えます。これにより、開発者はモデル選択の負担なく、速度と精度の両立が可能です。

- 専門分野での精度向上:コーディング、数学、データ分析などの領域で、旧モデル(GPT-4oなど)を大幅に上回る精度を達成しています。

- モデルの統合とAPIラインナップ:Chat Completions APIでは、gpt-5(標準)、gpt-5-mini(低コスト)、gpt-5-nano(最速)の3種類が提供されます。

- 料金体系:API料金、特に入力トークンのコストが旧モデルより比較的安価に設定されており、大規模な処理でもコスト効率が向上しています。

- 安全性の強化:「出力中心の安全性」の導入により、プロンプトインジェクションなど悪意のある入力への耐性が強化されています。

これらの特徴を理解することは、GPT-5 APIを効果的に設計・運用する上で非常に重要です。

GPT-5の機能や安全性、評価に関する詳細な公式情報(システムカード)はこちらで公開されています。 合わせてご覧ください。 https://openai.com/index/gpt-5-system-card/

GPT-5 APIの料金体系

GPT-5 APIの利用を検討する上で、料金体系の理解は不可欠です。

こちらはChatGPTの月額料金体系や無料版と有料版の違いについて解説した記事です。 合わせてご覧ください。

ここでは、具体的な料金プランと計算方法、そして無料利用枠について解説します。

- GPT-5 APIの料金プランと具体的な計算方法

- APIの無料利用枠(Free Tier)について

最新の料金情報を確認し、コストを見積もる際の参考にしてください。

GPT-5 APIの料金プランと具体的な計算方法

GPT-5 APIの料金は、従来通り「トークン」単位で計算されます。トークンとは、テキストを処理する際の最小単位(おおよそ単語や文字の一部)です。

料金は「入力トークン(APIに送信するテキスト)」と「出力トークン(APIが生成するテキスト)」で単価が異なります。

公式情報によれば、GPT-5 APIは旧モデル(GPT-4など)に比べて「入力コストが比較的安価に設定」されています。これは、大量のコンテキスト(文脈)をAPIに渡す際のコスト負担が軽減されることを意味します。

料金プランは、利用するモデルによって異なります。

gpt-5(標準):

最も高機能なモデルであり、料金も高めに設定されています。特に「長考(Thinking)」モードでの出力トークンは、即時応答モードよりも高価になる可能性があります。

gpt-5-mini(低コスト):

gpt-5の能力を維持しつつ、トークン単価(特に入力)が大幅に抑えられています。コストとパフォーマンスのバランスが最も良いモデルです。

gpt-5-nano(最速):

最も安価なモデルです。高速応答が求められるRAG(検索拡張生成)の最終応答生成など、速度重視の用途に適しています。

具体的な計算例:

gpt-5-mini を使い、入力1,000トークン、出力500トークンを処理した場合。

(入力単価 × 1000) + (出力単価 × 500) = 合計料金

となります。

正確な単価は、OpenAIの公式料金ページで常に最新の情報を確認するようにしてください。

こちらはOpenAI公式のAPI料金ページです。モデルごとの最新のトークン単価を確認できます。 合わせてご覧ください。 https://platform.openai.com/docs/pricing

APIの無料利用枠(Free Tier)について

OpenAIは、APIを初めて利用する開発者向けに、一定期間または一定額の無料利用枠(Free Tier)を提供していることが一般的です。

GPT-5 APIのリリースに伴い、この無料枠も更新されている可能性があります。通常、この無料枠は、新しいアカウントを作成してから最初の数ヶ月間有効で、例えば「$5.00分」といったクレジットが付与されます。このクレジットは、gpt-5、gpt-5-mini、gpt-5-nano など、OpenAIが提供する各種APIモデルの利用料金に充当できます。

ただし、ChatGPT Plusなどのサブスクリプションプランと、APIの利用料金は別体系である点に注意が必要です。ChatGPT本体の無料プランでは、GPT-5の利用に「5時間あたり10メッセージ」や「Thinkingモードは1日1回」といった制限がありますが、API利用にはこの制限は適用されません。

APIの無料利用枠は、開発者がアプリケーションのプロトタイプを作成したり、GPT-5 APIの性能をテストしたりするために非常に有用です。無料枠を使い切った後は、登録したクレジットカード情報に基づき、従量課金制へと移行します。

GPT-5 APIを使い始めるための準備

GPT-5 APIを実際に使い始める前に、いくつか必要な準備があります。

ここでは、APIを利用するために必要なアカウントや知識、そして利用開始のプロセスについて解説します。

- 利用に必要なアカウントと前提知識

- ウェイティングリストへの登録は必要?

これらの準備を整えることで、スムーズにAPIのセットアップに進むことができます。

利用に必要なアカウントと前提知識

GPT-5 APIを利用するためには、まず「OpenAIアカウント」が必要です。

ChatGPTをすでに利用している場合は、そのアカウントでAPIも利用できます。まだ持っていない場合は、OpenAIの公式サイトからサインアップしてください。

アカウント作成後、APIを利用するためには支払い情報(クレジットカード情報)の登録が必要になる場合があります。これにより、無料利用枠を超過した場合の料金が請求されます。

次に、前提知識として、APIの基本的な概念を理解している必要があります。APIが何であるか、HTTPリクエスト(POSTなど)やJSON形式のデータ送受信について基本的な知識があるとスムーズです。

さらに、実際にAPIを組み込みたいプログラミング言語の基礎知識が求められます。本記事ではPythonとNode.jsを例に挙げますが、curl コマンドや他の言語(Ruby, Java, Goなど)のライブラリ(SDK)も提供されています。ライブラリ(SDK)の使い方や、環境変数の設定方法についての理解も必要です。

ウェイティングリストへの登録は必要?

結論から言うと、GPT-5 APIの利用において、特別なウェイティングリスト(待機リスト)への登録は原則として不要です。

参考情報にある通り、GPT-5はChatGPTにおいて「全てのユーザー(無料・有料)がデフォルトで利用できる」ようになりました。これは、OpenAIがGPT-5を安定して大規模に提供できる体制を整えたことを意味します。

APIについても同様で、GPT-4の初期リリース時のような厳格なウェイティングリストは設けられておらず、OpenAIアカウントを持ち、支払い情報を登録している開発者であれば、すぐにGPT-5 API(gpt-5, gpt-5-mini など)にアクセスできる可能性が非常に高いです。

ただし、リリース直後の非常に高いトラフィックが予想される期間や、特定のベータ機能(例えば、まだ一般公開されていない新しいToolなど)を利用する場合には、別途申請やウェイティングリストへの登録が求められるケースも考えられます。

しかし、基本的なテキスト生成やGPT-5のコア機能を利用するだけであれば、OpenAIプラットフォームのダッシュボードからAPIキーを発行すれば、すぐに使い始めることができるでしょう。

GPT-5 APIのセットアップ手順(3ステップ)

ここからは、実際にGPT-5 APIを利用するための具体的なセットアップ手順を3つのステップで解説します。

- ステップ1:OpenAI SDKをインストールする

- ステップ2:APIキーを取得して環境変数に設定する

- ステップ3:簡単な接続テストを実行する

この手順に従えば、誰でも簡単にGPT-5 APIを動かす準備が整います。それでは、各ステップを詳しく見ていきましょう。

ステップ1:OpenAI SDKをインストールする

GPT-5 APIを利用する最も簡単な方法は、OpenAIが公式に提供しているSDK(Software Development Kit)ライブラリを使用することです。

まず、ご自身の開発環境に合わせて、対応するSDKをインストールします。

Pythonの場合:

ターミナル(コマンドプロンプト)を開き、以下のpipコマンドを実行します。

pip install –upgrade openai

最新のライブラリ情報や詳細な使い方については、公式のPython SDKリポジトリもご覧ください。 https://github.com/openai/openai-python

すでに古いバージョンがインストールされている場合に備えて、–upgrade オプションを付けることを推奨します。

Node.js (JavaScript/TypeScript) の場合:

プロジェクトディレクトリで、以下のnpmコマンドを実行します。

npm install --save openai

もしくは、yarnを使用している場合は yarn add openai を実行します。

これにより、PythonやNode.jsのコードから openai ライブラリをインポートして、GPT-5 APIの機能を簡単に呼び出せるようになります。最新のAPI機能を利用するために、常にSDKを最新版に保つように心がけましょう。

ステップ2:APIキーを取得して環境変数に設定する

次に、OpenAI APIにアクセスするための「APIキー」を取得します。APIキーは、あなたのリクエストを認証するための秘密の鍵です。

- OpenAIのプラットフォーム(platform.openai.com)にログインします。

- 右上のアカウントアイコンから「View API keys」(または「API keys」)メニューを選択します。

- 「Create new secret key」ボタンをクリックします。

- キーに識別しやすい名前(例: “gpt5-project”)を付け、「Create secret key」をクリックします。

sk-から始まる英数字の羅列(APIキー)が表示されます。このキーは一度しか表示されないため、必ず安全な場所(パスワードマネージャーなど)にコピーしてください。

取得したAPIキーは、コードに直接書き込むべきではありません。セキュリティ上、環境変数に設定するのがベストプラクティスです。

Mac/Linuxの場合:

.bashrc や .zshrc ファイルに以下を追記します。

export OPENAI_API_KEY='sk-あなたのAPIキー'Windowsの場合:

システムのプロパティから環境変数を設定するか、コマンドプロンプトで以下を実行します。

setx OPENAI_API_KEY "sk-あなたのAPIキー"

設定後、ターミナルを再起動すると、SDKが自動的にこの環境変数を読み込み、APIキーとして使用します。ステップ3:簡単な接続テストを実行する

APIキーの設定が完了したら、SDKが正しく認証され、APIと通信できるか簡単なテストを行います。

ここでは、利用可能なモデルの一覧を取得するコードを実行してみましょう。

これが成功すれば、認証と通信設定は完了です。

Pythonの場合:

Python

from openai import OpenAI

# 環境変数 OPENAI_API_KEY から自動でキーが読み込まれます

client = OpenAI()

try:

# モデル一覧を取得

models = client.models.list()

# モデルデータ(一部)を表示

for model in models.data[:5]:

print(model.id)

print("\nGPT-5 APIへの接続テストが成功しました。")

except Exception as e:

print(f"エラーが発生しました: {e}")

Node.js の場合:

JavaScript

import OpenAI from 'openai';

// 環境変数 OPENAI_API_KEY から自動でキーが読み込まれます

const client = new OpenAI();

async function main() {

try {

const models = await client.models.list();

// モデルデータ(一部)を表示

for (const model of models.data.slice(0, 5)) {

console.log(model.id);

}

console.log('\nGPT-5 APIへの接続テストが成功しました。');

} catch (e) {

console.error(`エラーが発生しました: ${e}`);

}

}

main();

これを実行し、gpt-5 や gpt-5-mini などのモデル名が一覧に表示されれば、セットアップは正常に完了です。

GPT-5 APIの基本的な使い方(テキスト生成)

セットアップが完了したら、いよいよGPT-5 APIの核となる機能、テキスト生成の使い方を見ていきましょう。

Chat Completions API(チャット補完API)を使って、GPT-5モデルに質問を投げかけ、回答を得る方法を解説します。

GPT-5 APIでテキストを生成する基本コード

このコードが、GPT-5 API活用の基本となります。

GPT-5 APIでテキストを生成する基本コード

GPT-5 APIでテキストを生成するには、client.chat.completions.create メソッドを使用します。これはGPT-4やGPT-4oのAPIと共通のメソッドです。

重要なのは model パラメータで、ここで gpt-5 や gpt-5-mini を指定します。

messages 配列には、会話の履歴を渡します。role には system(AIへの指示)、user(ユーザーの発言)、assistant(AIの過去の回答)を指定します。

Pythonの基本コード例:

Python

from openai import OpenAI

client = OpenAI() # 環境変数からAPIキーを読み込み

try:

completion = client.chat.completions.create(

model="gpt-5-mini", # または "gpt-5"

messages=[

{"role": "system", "content": "あなたは親切なアシスタントです。"},

{"role": "user", "content": "GPT-5 APIの主な特徴を3つ教えてください。"}

]

)

# 生成されたテキストを取得

response_message = completion.choices[0].message.content

print(response_message)

except Exception as e:

print(f"エラーが発生しました: {e}")

Node.jsの基本コード例:

JavaScript

import OpenAI from 'openai';

const client = new OpenAI(); // 環境変数からAPIキーを読み込み

async function generateText() {

try {

const completion = await client.chat.completions.create({

model: "gpt-5-mini", // または "gpt-5"

messages: [

{ role: "system", content: "あなたは親切なアシスタントです。" },

{ role: "user", content: "GPT-5 APIの主な特徴を3つ教えてください。" }

],

});

// 生成されたテキストを取得

const responseMessage = completion.choices[0].message.content;

console.log(responseMessage);

} catch (e) {

console.error(`エラーが発生しました: ${e}`);

}

}

generateText();

このコードを実行すると、GPT-5 APIが「GPT-5 APIの主な特徴」を生成して出力します。

これがAPIとの対話の基本形です。

GPT-5 APIの応用的な使い方:画像・ファイル分析

GPT-5 APIは、テキスト生成だけでなく、GPT-4oから引き継いだ強力なマルチモーダル能力(画像分析)や、データ分析能力(ファイル分析)も備えています。

ここでは、テキスト以外のデータを扱う応用的な使い方を紹介します。

- 画像(ビジョン)を分析するコード例

- ファイルをアップロードして分析するコード例

これらの機能を使いこなすことで、アプリケーションの可能性が大きく広がります。

画像(ビジョン)を分析するコード例

GPT-5 APIは、画像を入力として受け取り、その内容について質問したり、説明させたりする「ビジョン能力」を持っています。

messages 配列内の content を、テキストと画像URL(またはBase64エンコードされた画像データ)の配列として渡すことで、この機能を利用できます。

モデルは gpt-5 や gpt-5-mini のままで、自動的に画像入力を処理します(GPT-4時代の gpt-4-vision-preview のような別モデル指定は不要です)。

Pythonのコード例(画像URLを指定):

Python

from openai import OpenAI

client = OpenAI()

try:

completion = client.chat.completions.create(

model="gpt-5", # ビジョン能力を持つモデル

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": "この画像に写っている動物は何ですか?また、どのような状況ですか?"},

{

"type": "image_url",

"image_url": {

"url": "https://example.com/path/to/image.jpg", # 分析したい画像のURL

},

},

],

}

]

)

print(completion.choices[0].message.content)

except Exception as e:

print(f"エラーが発生しました: {e}")

このコードは、指定されたURLの画像をGPT-5 APIが「見て」、画像の内容(動物の種類や状況)をテキストで回答します。

Webサイトの画像認識や、ユーザーがアップロードした画像の分類など、多様なユースケースが考えられます。

ファイルをアップロードして分析するコード例

GPT-5 APIは、特にデータ分析能力が強化されており、CSV、JSON、PDFなどのファイルを分析する能力も期待されます。

(注:以下のコードは、GPT-5 APIにファイルアップロードと分析機能が統合された場合の想定例です。具体的な実装は公式ドキュメントを確認してください。)

従来のCode Interpreter(現Advanced Data Analysis)のように、ファイルをAPI経由でアップロードし、その内容について質問やデータ分析を指示する流れが想定されます。

Pythonのコード例(仮):

Python

from openai import OpenAI

client = OpenAI()

try:

# 1. ファイルをアップロード(仮のメソッド)

# (実際には Assistant API や別エンドポイントを使う可能性があります)

# uploaded_file = client.files.create(

# file=open("data.csv", "rb"),

# purpose="analysis"

# )

# file_id = uploaded_file.id

# 2. Chat Completions でファイルIDを指定して分析を指示(仮の形式)

completion = client.chat.completions.create(

model="gpt-5",

messages=[

{

"role": "user",

"content": "添付したCSVファイル(file-id: XXXX)について、'売上'列の平均値を計算してください。"

# ここで file_id を渡す方法が別途定義される想定

}

]

# "attachments" や "tools" パラメータでファイルを指定する可能性もある

)

print(completion.choices[0].message.content)

except Exception as e:

print(f"エラーが発生しました: {e}")

GPT-5では、データ分析機能がChat Completions APIに、よりシームレスに統合されている可能性があります。

例えば、tools パラメータに file_search や data_analysis を指定し、アップロード済みのファイルIDを渡すことで、複雑なデータ集計やインサイト抽出を実行できると考えられます。

正確な実装方法は、リリース時のAPIリファレンスを参照してください。

GPT-5 APIの強力な新機能「Tools」の使い方

GPT-5 APIでは、従来のFunction Callingが「Tools」という概念に拡張され、AIが外部の機能をより強力に呼び出せるようになりました。

ここでは、GPT-5 APIのTools機能、特に注目されるWeb検索やファイル検索、従来のFunction Callingの使い方を解説します。

- Web検索(web-search)機能の使い方とコード例

- ファイル検索(file-search)機能の使い方

- Function Calling(関数呼び出し)の活用方法

これらのToolを使いこなし、APIの能力を外部世界と連携させましょう。

Web検索(web-search)機能の使い方とコード例

GPT-5 APIは、最新の情報を取得するために、API内部でWeb検索を実行する機能を tools パラメータを通じて提供する可能性があります。

(注:これはGPT-5 APIの機能に関する仮説に基づいています。ChatGPT本体のブラウジング機能がAPIにどう提供されるかは公式情報を確認してください。)

もし web_search ツールが提供された場合、開発者はAIにリアルタイムの情報を調べさせることができます。

Pythonのコード例(web_search ツールが存在する場合の仮説):

Python

from openai import OpenAI

client = OpenAI()

try:

completion = client.chat.completions.create(

model="gpt-5",

messages=[

{"role": "user", "content": "2025年10月現在の東京の天気を教えてください。"}

],

tools=[

{

"type": "web_search" # Web検索ツールの利用を許可

}

],

tool_choice="auto" # AIが必要と判断したらツールを使う

)

# ツールが使われた場合、その結果も含めてAIが最終回答を生成する

print(completion.choices[0].message.content)

except Exception as e:

print(f"エラーが発生しました: {e}")

このように tools に web_search を指定するだけで、AIは「2025年10月の天気」という内部知識にない情報を、自動的にWeb検索して回答を生成してくれるようになると期待されます。

開発者は、検索クエリを考えたり、検索結果をパースしたりする必要がなく、AIにタスクを委任するだけで最新情報を扱えるようになります。

ファイル検索(file-search)機能の使い方

web_search と同様に、file_search(または retrieval)ツールが提供される可能性があります。

これは、RAG (Retrieval-Augmented Generation) をAPIレベルで容易に実現する機能です。

開発者は、あらかじめOpenAIのプラットフォームにドキュメント(PDF, TXT, MDなど)をアップロードしておき、APIリクエスト時に file_search ツールを指定します。

ユーザーからの質問に関連する情報を、AIが自動的にアップロード済みドキュメントから検索し、その内容に基づいて回答を生成します。

Pythonのコード例(file_search ツールが存在する場合の仮説):

Python

from openai import OpenAI

client = OpenAI()

# 事前にファイルアップロードとVector Storeへの登録が必要と想定

# (e.g., client.vector_stores.files.create(...))

# vector_store_id = "vs_..."

try:

completion = client.chat.completions.create(

model="gpt-5",

messages=[

{"role": "user", "content": "弊社の最新のセキュリティポリシーについて教えて。"}

],

tools=[

{

"type": "file_search"

}

],

tool_resources={ # 検索対象のファイルストアを指定(仮)

"file_search": {

"vector_store_ids": ["vs_..."]

}

},

tool_choice="auto"

)

print(completion.choices[0].message.content)

except Exception as e:

print(f"エラーが発生しました: {e}")

これにより、開発者は自前でベクトルデータベースを構築・運用する必要なく、強力なRAGシステムをGPT-5 APIで簡単に構築できるようになると期待されます。

こちらはRAG(検索拡張生成)のプロンプト作成方法について、具体的な活用事例を交えて解説した記事です。 合わせてご覧ください。

これは特に、社内ドキュメント検索ボットや、専門知識を扱うQAシステムにおいて非常に強力な機能となります。

Function Calling(関数呼び出し)の活用方法

従来のFunction Calling機能も、tools の一部として引き続き提供され、さらに強化されています。

Function Callingは、AIがテキストで回答する代わりに、開発者側で定義した関数(例:自社DBへのクエリ、外部APIの呼び出し)を実行するよう指示するJSONを返す機能です。

GPT-5では、より複雑な関数定義や、複数の関数を並列で呼び出す(Parallel Function Calling)能力が向上していると期待されます。

Pythonのコード例(Function Calling):

Python

from openai import OpenAI

import json

client = OpenAI()

# 1. 呼び出してほしい関数の定義

tools = [

{

"type": "function",

"function": {

"name": "get_weather_forecast",

"description": "指定された場所の天気予報を取得する",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "天気予報を知りたい都市名 (例: 東京)",

},

},

"required": ["location"],

},

},

}

]

messages = [{"role": "user", "content": "東京の天気は?"}]

# 2. AIに関数を呼び出すようリクエスト

response = client.chat.completions.create(

model="gpt-5",

messages=messages,

tools=tools,

tool_choice="auto",

)

response_message = response.choices[0].message

tool_calls = response_message.tool_calls

# 3. AIが関数呼び出しを要求した場合

if tool_calls:

# (ここで実際の天気APIを呼び出す処理を実行)

# available_functions = {"get_weather_forecast": get_weather_forecast_from_api}

# ...

print("AIが関数呼び出しを要求しました:")

print(tool_calls[0].function.name)

print(tool_calls[0].function.arguments)

# (この後、関数の実行結果を再度APIに送るステップが続く)

else:

print(response_message.content)

GPT-5 APIとFunction Callingを組み合わせることで、AIが単なる対話相手ではなく、外部システムを操作する「エージェント」として機能するようになります。

Function Callingのより詳細な仕様やベストプラクティスについては、こちらの公式ガイドで解説されています。 合わせてご覧ください。 https://help.openai.com/en/articles/8555517-function-calling-in-the-openai-api

GPT-5 APIの新しい主要パラメータ

GPT-5 APIでは、モデルの挙動をより細かく制御するために、新しいパラメータが導入されている可能性があります。ここでは、GPT-5の特徴である「思考時間の自動切替」に関連すると想定されるパラメータについて解説します。

- 推論レベルを指定する「Reasoning effort」とは

- 出力の冗長性を決める「Verbosity」とは

- 各パラメータの指定方法とコード例

これらのパラメータを理解し、APIの応答を最適化しましょう。

推論レベルを指定する「Reasoning effort」とは

「Reasoning effort」(推論の労力)は、GPT-5の最大の特徴である「簡単な質問には素早く、複雑な質問にはじっくり考えて回答する能力」を、API側から制御するために導入された(と想定される)新しいパラメータです。

参考情報にあるChatGPTの有料プランの「Fast」「Thinking」モード選択に相当する機能と推測されます。このパラメータ(または類似の名称のパラメータ)で、開発者はAIの思考レベルを指定できる可能性があります。

- auto (デフォルト):

GPT-5が質問の難易度を自動で判断し、即時応答(Fast)と長考(Thinking)を切り替えます。 - low (または fast):

常に即時応答モードを強制します。応答は速いが、複雑なタスクの精度は低下する可能性があります。 - high (または thinking):

常に長考モードを強制します。応答は遅くなりますが、コーディングやデータ分析などのタスクで最高の精度を追求できます。

Reasoning effort を low に設定することは、gpt-5-mini や gpt-5-nano を使うのとは異なり、gpt-5(標準モデル)の能力を使いつつ速度を優先する、といった使い分けが可能になると考えられます。

出力の冗長性を決める「Verbosity」とは

「Verbosity」(冗長性、詳細度)は、AIの回答の「詳しさ」を制御するために導入された(と想定される)パラメータです。

従来のプロンプトで「簡潔に答えて」や「詳しく説明して」と指示するのに似ていますが、これをパラメータで制御できるようになる可能性があります。

- low:

簡潔な回答を優先します。チャットボットの短い応答や、要点のみを知りたい場合に適しています。 - medium (デフォルト):

標準的な詳細度で回答します。 - high:

非常に詳細で、背景知識やステップバイステップの説明を含む回答を生成します。レポート作成や学習コンテンツの生成に適しています。

このパラメータが temperature(出力のランダム性)とどう組み合わさるか、あるいは temperature の役割を一部代替するのかは、公式ドキュメントで確認する必要があります。

(注:Reasoning effort と Verbosity は、GPT-5の機能をAPIで制御するために導入が期待されるパラメータの仮説です。実際のパラメータ名は異なる場合があります。)

各パラメータの指定方法とコード例

もし reasoning_effort や verbosity といったパラメータが導入された場合、client.chat.completions.create メソッドの引数として指定することになります。

Pythonのコード例(仮説):

Python

from openai import OpenAI

client = OpenAI()

try:

# 複雑なタスクを、最高の精度で、詳細に回答させる例

completion = client.chat.completions.create(

model="gpt-5",

messages=[

{"role": "user", "content": "量子コンピュータの基本原理について、大学生向けに詳細なレポートを作成してください。"}

],

reasoning_effort="high", # 'Thinking' モードを強制

verbosity="high" # 詳細な出力を要求

)

print(completion.choices[0].message.content)

# 簡単なタスクを、高速に、簡潔に回答させる例

completion_fast = client.chat.completions.create(

model="gpt-5", # gpt-5モデルでも高速化

messages=[

{"role": "user", "content": "「AI」の日本語訳は?"}

],

reasoning_effort="low", # 'Fast' モードを強制

verbosity="low" # 簡潔な出力を要求

)

print(completion_fast.choices[0].message.content)

except Exception as e:

print(f"エラーが発生しました: {e}")

これらの新しいパラメータ(が提供された場合)を使いこなすことで、開発者はGPT-5 APIの応答速度、精度、詳細度を、ユースケースに合わせて柔軟に制御できるようになります。

【コード例】PythonでGPT-5 APIを使う方法

Pythonは、AI開発やデータサイエンスの分野で最も広く使われている言語の一つです。openaiライブラリを使ってGPT-5 APIを操作する方法を具体的なコード例で示します。

こちらはChatGPTを使ってPythonコードを生成する具体的な方法や活用事例を解説した記事です。 合わせてご覧ください。

ここでは、環境準備から基本的な使い方、応用までをステップバイステップで解説します。

- Python環境の準備(ライブラリインストール)

- 基本的なテキスト生成(コード例)

- 会話履歴(コンテキスト)を引き継ぐ方法

- Tools(Web検索)を使う(コード例)

これらのコードを参考に、PythonアプリケーションにGPT-5 APIを組み込んでみましょう。

Python環境の準備(ライブラリインストール)

まず、Python環境でOpenAIの公式SDK(ライブラリ)を使えるように準備します。

Python 3.7.1以上が推奨されます。

ターミナルまたはコマンドプロンプトを開き、以下のpipコマンドを実行して、openai ライブラリをインストール(または最新版にアップグレード)します。

pip install --upgrade openai

インストールが完了したら、次にAPIキーを環境変数に設定します。

(この手順は「セットアップ手順」で解説した通りです)

Mac/Linuxの場合:

export OPENAI_API_KEY=’sk-あなたのAPIキー’

Windowsの場合:

setx OPENAI_API_KEY “sk-あなたのAPIキー”

ターミナルを再起動すれば、Pythonスクリプトから openai ライブラリが自動的にこのAPIキーを読み込むようになります。

これで、PythonからGPT-5 APIを呼び出す準備は完了です。

基本的なテキスト生成(コード例)

PythonでGPT-5 APIを使い、最も基本的なテキスト生成(チャット応答)を行うコードです。

OpenAI() クラスをインスタンス化し、chat.completions.create() メソッドを呼び出します。

Python

from openai import OpenAI

# 環境変数 OPENAI_API_KEY からキーが自動で読み込まれます

try:

client = OpenAI()

completion = client.chat.completions.create(

model="gpt-5-mini", # gpt-5, gpt-5-mini, gpt-5-nano から選択

messages=[

{"role": "system", "content": "あなたはプロの翻訳家です。"},

{"role": "user", "content": "「Artificial Intelligence」を自然な日本語に翻訳してください。"}

]

)

# choices[0].message.content にAIの回答テキストが入っています

response_text = completion.choices[0].message.content

print(f"AIの回答: {response_text}")

# (参考) 消費したトークン数なども取得できます

usage = completion.usage

print(f"使用トークン数: {usage.total_tokens}")

except Exception as e:

print(f"APIリクエスト中にエラーが発生しました: {e}")

このスクリプトを実行すると、gpt-5-mini モデルが「人工知能」といった翻訳結果を返します。

model パラメータを変更するだけで、異なるGPT-5モデルの性能を簡単に試すことができます。

会話履歴(コンテキスト)を引き継ぐ方法

チャットボットのように、過去のやり取りを踏まえた回答をさせるには、messages 配列に会話の履歴(コンテキスト)を追加していきます。

APIはステートレス(状態を持たない)ため、APIを呼び出すたびに、それまでの会話履歴をすべて送信する必要があります。

Python

from openai import OpenAI

client = OpenAI()

# 会話履歴を保持するリスト

messages = [

{"role": "system", "content": "あなたは親切なアシスタントです。"}

]

try:

# 1回目のやり取り

user_input_1 = "GPT-5 APIの主な特徴を1つ教えて。"

messages.append({"role": "user", "content": user_input_1})

completion1 = client.chat.completions.create(

model="gpt-5-mini",

messages=messages

)

response1 = completion1.choices[0].message.content

print(f"User: {user_input_1}")

print(f"AI: {response1}")

# AIの回答を履歴に追加

messages.append({"role": "assistant", "content": response1})

# 2回目のやり取り (前の会話を踏まえる)

user_input_2 = "それについて、もう少し詳しく説明して。" # 「それ」が前の回答を指す

messages.append({"role": "user", "content": user_input_2})

completion2 = client.chat.completions.create(

model="gpt-5-mini",

messages=messages # 履歴全体を送信

)

response2 = completion2.choices[0].message.content

print(f"User: {user_input_2}")

print(f"AI: {response2}")

except Exception as e:

print(f"エラーが発生しました: {e}")

このように messages リストを管理し、user と assistant のやり取りを交互に追加していくことで、GPT-5 APIは文脈を理解した自然な会話を継続できます。

Tools(Web検索)を使う(コード例)

GPT-5 APIの強力な機能である「Tools」をPythonから使うコード例です。

ここでは、web_search ツールが利用可能であると仮定して、最新の情報をAPIに検索させる方法を示します。

(注:web_search は仮のツール名です。公式の機能名を確認してください。)

Python

from openai import OpenAI

client = OpenAI()

try:

# web_search ツールを使うための定義(仮)

tools = [

{

"type": "web_search"

}

]

messages = [

{"role": "user", "content": "今日の主要な経済ニュースを3つ要約して。"}

]

print("GPT-5 APIにWeb検索をリクエストします...")

completion = client.chat.completions.create(

model="gpt-5", # Web検索などの高度なタスクは gpt-5 が適任

messages=messages,

tools=tools,

tool_choice="auto" # AIにツールの使用を自動で判断させる

)

response_message = completion.choices[0].message

# AIがツールを使わずに(知識で)回答した場合

if not response_message.tool_calls:

print("AIの回答 (Web検索なし):")

print(response_message.content)

# AIがWeb検索ツールを使った場合 (内部で自動実行されると想定)

# Assistant API のように Tool Call が返ってくるのではなく、

# 検索結果を反映した最終回答が content に入ると期待される

else:

# (もしTool Callが返ってきた場合は、その結果を再度APIに送る処理が必要)

print("AIの回答 (Web検索結果を含む):")

print(response_message.content)

# GPT-5では、Tool利用がよりシームレスになり、

# tool_choice="auto" にしておけば、AIが内部で検索を実行し、

# 最終的な回答(content)のみを返す可能性が高い

# 確実なのは、以下のように最終回答を表示すること

print("\n--- 最終的なAIの回答 ---")

print(completion.choices[0].message.content)

except Exception as e:

print(f"エラーが発生しました: {e}")

GPT-5 APIの tools 機能は、開発者が複雑な処理を実装することなく、AIに高度なタスク(Web検索、ファイル検索、関数実行)を委任できる強力なインターフェースです。

【コード例】Node.jsでGPT-5 APIを使う方法

Node.js (JavaScript/TypeScript) は、Webアプリケーションやサーバーサイド開発で人気のプラットフォームです。openai npmパッケージを使ってGPT-5 APIを操作する方法を解説します。

環境準備から基本的なテキスト生成、Toolsの利用まで、具体的なコード例を見ていきましょう。

- Node.js環境の準備(ライブラリインストール)

- 基本的なテキスト生成(コード例)

- Tools(Web検索)を使う(コード例)

これらの例を基に、Node.jsプロジェクトにGPT-5 APIのパワーを取り入れましょう。

Node.js環境の準備(ライブラリインストール)

まず、Node.jsプロジェクトでOpenAIの公式SDK(npmパッケージ)を使えるようにします。

Node.jsのバージョンは18以上が推奨されます。

プロジェクトのルートディレクトリで、ターミナルを開き、以下のnpmコマンドを実行して openai パッケージをインストールします。

npm install --save openai

または、yarnを使用している場合は以下を実行します。

yarn add openai

次に、APIキーを環境変数に設定します。

(この手順は「セットアップ手順」で解説した通りです)

Mac/Linuxの場合:

export OPENAI_API_KEY=’sk-あなたのAPIキー’

Windowsの場合:

setx OPENAI_API_KEY “sk-あなたのAPIキー”

ターミナルを再起動するか、dotenv パッケージなどを使って環境変数を読み込むと、Node.jsスクリプトがAPIキーを自動的に認識します。

基本的なテキスト生成(コード例)

Node.js (ES Modules形式) でGPT-5 APIを呼び出し、テキストを生成する基本的なコードです。

OpenAI クラスをインポートし、chat.completions.create() メソッドを await で呼び出します。

JavaScript

// main.mjs (ES Module 形式)

import OpenAI from 'openai';

// 環境変数 OPENAI_API_KEY からキーが自動で読み込まれます

const client = new OpenAI();

async function main() {

try {

const completion = await client.chat.completions.create({

model: "gpt-5-mini", // gpt-5, gpt-5-mini, gpt-5-nano から選択

messages: [

{ role: "system", content: "あなたはプロの校正者です。" },

{ role: "user", content: "以下の文章をビジネスメール用に修正してください:明日の会議、よろしく。" }

],

});

// choices[0].message.content にAIの回答テキストが入っています

const responseText = completion.choices[0].message.content;

console.log("AIの回答:");

console.log(responseText);

// (参考) 消費したトークン数

const usage = completion.usage;

console.log(`\n使用トークン数: ${usage.total_tokens}`);

} catch (e) {

console.error("APIリクエスト中にエラーが発生しました:", e);

}

}

main();

このスクリプトを実行(node main.mjs)すると、gpt-5-mini が入力されたラフな文章を丁寧なビジネスメールの文面に修正して出力します。

Tools(Web検索)を使う(コード例)

Node.jsからGPT-5 APIの「Tools」機能(web_search ツールを仮定)を利用するコード例です。

Pythonの例と同様に、tools パラメータを指定して、AIに最新の情報を検索させます。

(注:web_search は仮のツール名です。公式の機能名を確認してください。)

JavaScript

// search.mjs (ES Module 形式)

import OpenAI from 'openai';

const client = new OpenAI();

async function searchWithGPT5() {

try {

// web_search ツールを使うための定義(仮)

const tools = [

{

"type": "web_search"

}

];

const messages = [

{ role: "user", content: "2025年秋に発売が噂される最新スマートフォンについて教えて。" }

];

console.log("GPT-5 APIにWeb検索をリクエストします...");

const completion = await client.chat.completions.create({

model: "gpt-5", // 高度なタスクには gpt-5

messages: messages,

tools: tools,

tool_choice: "auto" // AIにツールの使用を自動で判断させる

});

const responseMessage = completion.choices[0].message;

// GPT-5では、Tool利用がシームレスに統合され、

// 検索結果を反映した最終回答が content に入ると期待される

console.log("\n--- 最終的なAIの回答 ---");

console.log(responseMessage.content);

} catch (e) {

console.error("エラーが発生しました:", e);

}

}

searchWithGPT5();

このコードは、GPT-5 APIに最新の(内部知識にはない)スマートフォンの情報をWeb検索させ、その結果を要約して回答させようとするものです。

Node.js (Expressなど) サーバーと組み合わせることで、リアルタイム情報を提供するWebサービスを簡単に構築できます。

GPT-5 APIの実践的なユースケース3選

GPT-5 APIの強力な能力は、多岐にわたる分野での活用が期待されます。

ここでは、参考情報で特に言及されている「コーディング」「データ分析」「コンテンツ作成」の精度向上を踏まえ、3つの実践的なユースケースを紹介します。

- ユースケース1:高度なコード生成・デバッグ

- ユースケース2:高品質なコンテンツ(記事・レポート)作成

- ユースケース3:複雑なデータ分析とインサイト抽出

これらの例は、GPT-5 APIがビジネスや開発の現場でどのように役立つかを示しています。

ユースケース1:高度なコード生成・デバッグ

GPT-5 APIは、コーディング精度が大幅に向上しており、開発者支援ツールとしての活用が非常に有効です。

従来のモデルがスニペット(コード断片)の生成を得意としていたのに対し、GPT-5は「長考(Thinking)」モードにより、より複雑なタスクに対応できます。

例えば、tools に file_search(コードベース全体を検索対象とする)や web_search(最新ライブラリの仕様を検索)を組み合わせることができます。

具体的な活用例:

- リファクタリング支援:「このクラス(ファイルID: X)は責務が大きすぎる。単一責任の原則に基づいてリファクタリングするコード案を提示して」といった指示。

- 自動デバッグ:スタックトレース(エラーログ)と関連するソースコードを入力し、「このエラーの原因を特定し、修正案(diff形式)を生成して」と指示。

- 新規機能の計画と実装:「PythonのFastAPIを使い、JWT認証(ログイン・新規登録)機能のエンドポイントを実装する計画と、完全なコードを生成して」といった、計画性を要するタスク。

GPT-5 APIをIDE(統合開発環境)のプラグインや、CI/CDパイプラインに組み込むことで、開発の生産性を劇的に向上させることが可能です。

ユースケース2:高品質なコンテンツ(記事・レポート)作成

GPT-5 APIは、簡単な質問への即時応答と、複雑な質問への長考(推論)を両立できます。この「長考」モードは、高品質な長文コンテンツの作成に最適です。

reasoning_effort="high"(仮)や verbosity="high"(仮)といったパラメータを指定し、web_search ツールを組み合わせることで、専門的かつ最新の情報に基づいた詳細な記事やレポートを自動生成できます。

具体的な活用例:

- 専門分野のホワイトペーパー作成:「最新のサイバーセキュリティ動向(Web検索を利用)に基づき、中小企業向けのランサムウェア対策に関するホワイトペーパー(約3000文字)を作成して」

- SEO記事の自動生成:キーワード、競合記事の傾向、ペルソナ(想定読者)情報を渡し、「このキーワードで検索上位を狙うためのSEO記事の構成案と本文を生成して」

- ニュースレターの要約と執筆:web_search ツールで特定の業界の最新ニュースを収集させ、「収集したニュースを要約し、今週の業界動向としてメルマガの原稿を作成して」

GPT-5 APIは、単なる文章作成(Writing)を超え、調査と推論(Reasoning)に基づいた、信頼性の高いコンテンツオーサリング(Authoring)を実現します。

ユースケース3:複雑なデータ分析とインサイト抽出

GPT-5 APIは、データ分析の精度が大幅に向上しており、専門家レベルのインサイト抽出が可能です。

API経由でファイル(CSV, JSON, Excelなど)をアップロード(または参照)させ、自然言語でデータ分析を指示するユースケースが強力です。

(注:ファイルアップロードと分析の具体的なAPI仕様は公式ドキュメントを確認してください。)

gpt-5(標準モデル)の「長考」モードは、統計的な分析や、データ間の複雑な相関関係を見抜くのに適しています。

具体的な活用例:

- 売上データの分析:「添付した売上データ(CSV)を分析し、月別の売上推移を特定してください。また、最も売上に貢献している商品カテゴリとその要因を推測して」

- 顧客アンケートのテキストマイニング:「このアンケートのフリーテキスト回答(JSON)を分析し、顧客が感じている不満点のトップ3を、具体的なコメント例と共に抽出して」

- 市場トレンドの予測:web_search ツールと組み合わせ、「過去5年間の市場データ(ファイル)と、最新のWeb情報(Web検索)を基に、来四半期の市場トレンドを予測し、その根拠を説明して」

データサイエンティストやアナリストが行っていた作業の一部をGPT-5 APIが担うことで、データドリブンな意思決定を迅速化できます。

GPT-5 APIのパフォーマンス最適化とベストプラクティス

GPT-5 APIを実サービスに組み込む際は、応答速度やコスト、安定性を考慮した最適化が重要です。

ここでは、APIのパフォーマンスを引き出し、効率的に活用するためのベストプラクティスを解説します。

- ストリーミングを利用して体感速度を上げる方法

- Reasoning effortと応答速度の関係

- API活用のためのベストプラクティス

これらのテクニックを導入し、ユーザー体験を向上させましょう。

ストリーミングを利用して体感速度を上げる方法

GPT-5が「長考」モードで高品質な長文を生成する際、すべてのテキストが生成完了するまで待つと、ユーザーは長い待ち時間を感じてしまいます。この問題を解決するのが「ストリーミング」です。

APIリクエスト時に stream=True (Python) または stream: true (Node.js) を指定すると、APIは回答を一度に返すのではなく、生成されたトークン(単語や文字)を逐次的に送信してきます。

これにより、ChatGPTのWebインターフェースのように、回答がリアルタイムでタイプされていくようなUIを実現でき、ユーザーの体感速度を劇的に改善できます。

Pythonでのストリーミングコード例:

Python

from openai import OpenAI

client = OpenAI()

try:

stream = client.chat.completions.create(

model="gpt-5-mini",

messages=[{"role": "user", "content": "GPT-5について詳しく教えて"}],

stream=True, # ストリーミングを有効化

)

print("AIの回答 (ストリーミング):")

for chunk in stream:

# chunk.choices[0].delta.content に断片的なテキストが入る

if chunk.choices[0].delta.content:

print(chunk.choices[0].delta.content, end="", flush=True)

print() # 最後に改行

except Exception as e:

print(f"エラーが発生しました: {e}")

Node.jsでのストリーミングコード例:

JavaScript

import OpenAI from 'openai';

const client = new OpenAI();

async function streamResponse() {

try {

const stream = await client.chat.completions.create({

model: "gpt-5-mini",

messages: [{ role: "user", content: "GPT-5について詳しく教えて" }],

stream: true, // ストリーミングを有効化

});

console.log("AIの回答 (ストリーミング):");

for await (const chunk of stream) {

// chunk.choices[0]?.delta?.content に断片的なテキストが入る

process.stdout.write(chunk.choices[0]?.delta?.content || "");

}

console.log(); // 最後に改行

} catch (e) {

console.error("エラーが発生しました:", e);

}

}

streamResponse();

特にチャットボットや記事生成など、テキスト量が多いユースケースではストリーミングは必須のテクニックです。

Reasoning effortと応答速度の関係

GPT-5 APIのパフォーマンスを考える上で、reasoning_effort(推論の労力)パラメータ(仮)の理解が重要です。

reasoning_effort="low"(または fast モード)を指定すると、GPT-5 APIは即時応答を試み、応答速度(レイテンシ)は非常に速くなります。これは、単純なQAやテキスト分類など、速度が重視されるタスクに適しています。

一方、reasoning_effort="high"(または thinking モード)を指定すると、APIは「長考」に入り、応答までの時間が長くなります。しかし、その分、コーディングやデータ分析、複雑な推論タスクにおける回答の「質」が大幅に向上します。

gpt-5-mini や gpt-5-nano モデルを使うことは、常時 low の reasoning_effort で動作させることに近いですが、gpt-5(標準モデル)で low を指定すると、「高い基礎能力を持つモデルを高速に使う」という選択が可能になります。

開発者は、タスクの性質(速度重視か、品質重視か)に応じて、モデル(gpt-5, mini, nano)の選択と、reasoning_effort パラメータ(auto, low, high)の指定を戦略的に使い分ける必要があります。

API活用のためのベストプラクティス

GPT-5 APIを安定して効率的に活用するために、以下のベストプラクティスを推奨します。

- エラーハンドリングとリトライ処理の実装:APIはネットワークの問題やサーバー側の高負荷(503 Service Unavailable など)で一時的に失敗することがあります。SDKが提供するリトライ機構(Exponential Backoff)を利用するか、自前で try-except (Python) や try-catch (Node.js) を実装し、一時的なエラーの場合は時間を置いて再試行するようにします。

- APIキーの安全な管理:APIキーは絶対にコード内にハードコード(直書き)しないでください。必ず環境変数(OPENAI_API_KEY)や、AWS Secret Manager、HashiCorp Vaultなどのシークレット管理ツールを使用して安全に管理します。

- コストの監視:OpenAIのダッシュボードでAPIの使用状況と料金を定期的に監視します。意図しない大量のリクエストが発生していないか、コスト効率の悪いモデル(gpt-5 の高推論モード)を多用していないかを確認し、必要に応じて利用制限(Spending Limits)を設定します。

- プロンプトエンジニアリング:GPT-5は賢くなりましたが、指示が曖昧では望む結果は得られません。system メッセージでAIの役割を明確に定義し、user メッセージでは具体的かつ明確な指示(CoT: Chain of Thoughtプロンプティングなど)を与えることが、精度と効率を高める鍵となります。

GPT-5 API利用時の注意点とトラブルシューティング

GPT-5 APIは強力ですが、利用時にはいくつかの注意点や、直面しうる一般的な問題があります。

ここでは、パラメータの変更点や、よくあるエラーとその解決策、利用制限について解説します。

- temperature パラメータが非推奨になった?

- よくあるエラーと解決策

- APIの利用制限(レートリミット)について

これらの点を事前に把握し、問題発生時に迅速に対処できるようにしましょう。

temperature パラメータが非推奨になった?

GPT-5 APIの登場により、従来の主要なパラメータであった temperature(出力のランダム性を制御、0に近いほど決定的、高いほど創造的)の役割が変わる可能性があります。

temperature が非推奨になった、あるいは廃止された可能性もゼロではありません。

なぜなら、GPT-5では「推論の質」を制御する reasoning_effort(仮)や、「詳細度」を制御する verbosity(仮)といった、より具体的で高度な制御パラメータが重視されるようになるためです。

例えば、reasoning_effort="high" を指定した場合、AIは創造性(高い temperature)よりも論理的な一貫性を優先するため、temperature の影響が小さくなるか、無視される可能性があります。

もし temperature が引き続き利用可能であっても、reasoning_effort や verbosity との相互作用を理解した上で調整する必要があります。

例えば、reasoning_effort="low"(高速モード)で temperature を高く設定すると、高速だが非論理的で創造的な回答が得られるかもしれません。

GPT-5 APIを利用する際は、公式ドキュメントで temperature パラメータの扱い(現役か、非推奨か、あるいは reasoning_effort と併用不可か)を必ず確認してください。

よくあるエラーと解決策

GPT-5 APIを利用する際によく遭遇する可能性のあるエラー(HTTPステータスコード)と、その主な原因・解決策をまとめます。

- 401 Unauthorized原因: APIキーが間違っている、または設定されていない。解決策: OpenAIダッシュボードでAPIキーを再発行し、環境変数 OPENAI_API_KEY に正しく設定されているか(スペルミス、sk- の欠落など)を確認します。

- 429 Rate Limit Exceeded原因: 短時間にAPIを呼び出しすぎ、利用制限(レートリミット)に達した。解決策: 「APIの利用制限」セクションを参照し、リクエストの間隔を空ける(Exponential Backoffなどのリトライ処理)、またはOpenAIに使用枠の拡大を申請します。

- 400 Bad Request原因: リクエスト(JSON)の形式が間違っている。解決策: messages 配列の形式(role と content が揃っているか)、指定したモデル名(gpt-5-mini など)のスペルミス、不正なパラメータ(廃止されたパラメータなど)を指定していないかを確認します。

- 500 Internal Server Error / 503 Service Unavailable原因: OpenAIサーバー側の一時的な障害や高負荷。解決策: これは開発者側では解決できません。数秒〜数分待ってから、リトライ処理(Exponential Backoff)を実行します。OpenAIのステータスページで障害情報を確認するのも有効です。

APIの利用制限(レートリミット)について

OpenAI APIには、サービスの安定性を保つため、アカウントごとに利用制限(レートリミット)が設定されています。

レートリミットには主に2種類あります。

- RPM (Requests Per Minute):1分間に送信できるリクエスト(API呼び出し)の回数制限。

- TPM (Tokens Per Minute):1分間に処理できるトークン(入力と出力の合計)の総量制限。

例えば、「RPM: 60, TPM: 600,000」といった制限が設定されます。

gpt-5(標準モデル)は gpt-5-mini よりもTPMの制限が厳しく設定される可能性があります。

この制限を超えてリクエストを送信すると、429 Rate Limit Exceeded エラーが返されます。

対策:

通常は、SDKに組み込まれた自動リトライ機能が、レートリミットを検知して適切に待機してくれます。

大量のバッチ処理を行う場合は、意図的にリクエスト間に sleep(待機時間)を入れるか、レートリミットの上限緩和をOpenAIのサポートに申請する必要があります。

アカウントの利用実績(Tier)が上がると、このレートリミットは自動的に緩和されていきます。

レートリミットの管理に関するベストプラクティスについては、OpenAIの公式ガイドで詳しく解説されています。 合わせてご覧ください。 https://help.openai.com/en/articles/6891753-what-are-the-best-practices-for-managing-my-rate-limits-in-the-api

GPT-5 APIに関するよくある質問(FAQ)

最後に、GPT-5 APIに関して開発者や利用者が抱きやすい質問と、それに対する回答をまとめます。

- GPT-4 APIからの移行は簡単ですか?

- GPT-5 APIのレスポンス精度はどうですか?

これらのFAQが、GPT-5 API導入の疑問解消に役立てば幸いです。

GPT-4 APIからの移行は簡単ですか?

はい、基本的な移行は非常に簡単です。

GPT-5 APIは、GPT-4 APIやGPT-4o APIと同様に「Chat Completions API」のインターフェースを使用しています。openai SDK(Python, Node.js)のバージョンが最新(v1.x以降)であれば、基本的なコード構造は同じです。

移行の主な作業は、client.chat.completions.create メソッド呼び出し時の model パラメータを、"gpt-4o" や "gpt-4-turbo" から "gpt-5" や "gpt-5-mini" に変更することです。

例 (Python):

変更前: model=”gpt-4o”

変更後: model=”gpt-5″

ただし、GPT-5の能力を最大限に引き出すためには、いくつかの追加対応が推奨されます。

- 新パラメータへの対応:reasoning_effort や verbosity といった新しいパラメータ(仮)が導入された場合、これらを適切に設定することで、GPT-5の「思考モード」を制御できます。

- Toolsの利用:従来の function_calling だけでなく、web_search や file_search などの新しい tools が提供されている場合、それらを利用するようにプロンプトやコードを修正します。

- temperature の見直し:temperature パラメータの役割が変わった可能性があるため(非推奨など)、その影響を確認する必要があります。

既存のGPT-4ベースのアプリケーションは、モデル名を変えるだけですぐにGPT-5で動作し始めますが、上記の新機能に対応することで、さらなるパフォーマンス向上が期待できます。

GPT-5 APIのレスポンス精度はどうですか?

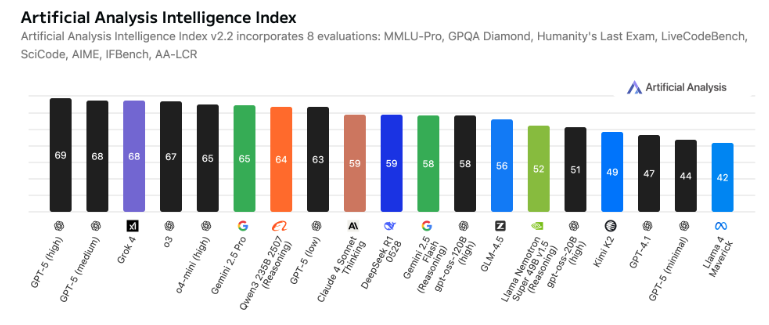

GPT-5 APIのレスポンス精度は、旧モデル(GPT-4oなど)と比較して、特に専門分野において劇的に向上しています。

参考情報によれば、GPT-5は以下の分野で強みを発揮します。

- コーディング:複雑なアルゴリズムの実装、コードベース全体を考慮したデバッグ、リファクタリングの提案など、高度な開発タスクの精度が向上しています。

- 数学・論理推論:抽象的な数学の問題や、多段階の論理的推論(Chain of Thought)が必要なタスクで、より正確な回答を導き出します。

- データ分析:提供されたデータ(CSVなど)からインサイトを抽出し、統計的に妥当な結論を導き出す能力が強化されています。

また、GPT-5は「思考時間の自動切替」機能を持っています。簡単な質問(例:「東京の首都は?」)には、gpt-5-nano のように高速かつ正確に応答します。

一方で、上記のような複雑な質問には、APIが自動で「長考(Thinking)」モードに切り替わり、時間をかけて高精度な回答を生成します。

このため、開発者は「速度」と「精度」のトレードオフに悩む必要が少なくなり、あらゆるタスクにおいて、旧モデルを上回る高品質なレスポンスを期待できます。

GPT-5の性能に関する詳細なベンチマーク分析については、こちらのレポートも参考になります。 合わせてご覧ください。 https://artificialanalysis.ai/articles/gpt-5-benchmarks-and-analysis

あなたの脳はサボってる?ChatGPTで「賢くなる人」と「思考停止する人」の決定的違い

ChatGPTを毎日使っているあなた、その使い方で本当に「賢く」なっていますか?実は、使い方を間違えると、私たちの脳はどんどん“怠け者”になってしまうかもしれません。マサチューセッツ工科大学(MIT)の衝撃的な研究がそれを裏付けています。

しかし、ご安心ください。東京大学などのトップ研究機関では、ChatGPTを「最強の思考ツール」として使いこなし、能力を向上させる方法が実践されています。この記事では、「思考停止する人」と「賢くなる人」の分かれ道を、最新の研究結果と具体的なテクニックを交えながら、どこよりも分かりやすく解説します。

【警告】ChatGPTはあなたの「脳をサボらせる」かもしれない

「ChatGPTに任せれば、頭を使わなくて済む」——。もしそう思っていたら、少し危険なサインです。MITの研究によると、ChatGPTを使って文章を作った人は、自力で考えた人に比べて脳の活動が半分以下に低下することがわかりました。

これは、脳が考えることをAIに丸投げしてしまう「思考の外部委託」が起きている証拠です。この状態が続くと、次のようなリスクが考えられます。

- 深く考える力が衰える: AIの答えを鵜呑みにし、「本当にそうかな?」と疑う力が鈍る。

- 記憶が定着しなくなる: 楽して得た情報は、脳に残りづらい。

- アイデアが湧かなくなる: 脳が「省エネモード」に慣れてしまい、自ら発想する力が弱まる。

便利なツールに頼るうち、気づかぬ間に、本来持っていたはずの「考える力」が失われていく可能性があるのです。

引用元:

MITの研究者たちは、大規模言語モデル(LLM)が人間の認知プロセスに与える影響について調査しました。その結果、LLM支援のライティングタスクでは、人間の脳内の認知活動が大幅に低下することが示されました。(Shmidman, A., Sciacca, B., et al. “Does the use of large language models affect human cognition?” 2024年)

【実践】AIを「脳のジム」に変える東大式の使い方

では、「賢くなる人」はChatGPTをどう使っているのでしょうか?答えはシンプルです。彼らはAIを「答えを出す機械」ではなく、「思考を鍛えるパートナー」として利用しています。ここでは、誰でも今日から真似できる3つの「賢い」使い方をご紹介します。

使い方①:最強の「壁打ち相手」にする

自分の考えを深めるには、反論や別の視点が不可欠です。そこで、ChatGPTをあえて「反対意見を言うパートナー」に設定しましょう。

魔法のプロンプト例:

「(あなたの意見や企画)について、あなたが優秀なコンサルタントだったら、どんな弱点を指摘しますか?最も鋭い反論を3つ挙げてください。」これにより、一人では気づけなかった思考の穴を発見し、より強固な論理を組み立てる力が鍛えられます。

使い方②:あえて「無知な生徒」として教える

自分が本当にテーマを理解しているか試したければ、誰かに説明してみるのが一番です。ChatGPTを「何も知らない生徒役」にして、あなたが先生になってみましょう。

魔法のプロンプト例:

「今から『(あなたが学びたいテーマ)』について説明します。あなたは専門知識のない高校生だと思って、私の説明で少しでも分かりにくい部分があったら、遠慮なく質問してください。」AIからの素朴な質問に答えることで、自分の理解度の甘い部分が明確になり、知識が驚くほど整理されます。

使い方③:アイデアを無限に生み出す「触媒」にする

ゼロから「面白いアイデアを出して」と頼むのは、思考停止への第一歩です。そうではなく、自分のアイデアの“種”をAIに投げかけ、化学反応を起こさせるのです。

魔法のプロンプト例:

「『(テーマ)』について考えています。キーワードは『A』『B』『C』です。これらの要素を組み合わせて、今までにない斬新な企画の切り口を5つ提案してください。」AIが提案した意外な組み合わせをヒントに、最終的なアイデアに磨きをかけるのはあなた自身です。これにより、発想力が刺激され、創造性が大きく向上します。

まとめ

企業は労働力不足や業務効率化の課題を抱える中で、生成AIの活用がDX推進や業務改善の切り札として注目されています。

しかし、実際には「どこから手を付ければいいかわからない」「社内にAIリテラシーを持つ人材がいない」といった理由で、導入のハードルが高いと感じる企業も少なくありません。

そこでおすすめしたいのが、Taskhub です。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「何をどう使えばいいのかわからない」という初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプログラミングや高度なAI知識がなくても、すぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最速の生成AI活用”を体験し、御社のDXを一気に加速させましょう。