「Google Gemini 3 Flashって、前のモデルと何が違うの?」「速いのはいいけど、ビジネスの実務で本当に使える精度なの?」

こういった疑問や不安を感じている方も多いのではないでしょうか。

本記事では、Googleの最新AIモデル「Google Gemini 3 Flash」の基本スペックから料金、他モデルとの比較、そして具体的な活用シーンまで徹底解説しました。

上場企業を中心に生成AI導入を支援している弊社が、現場の知見をもとに最新情報をお伝えします。

この記事を読めば、Gemini 3 Flashを自社に導入すべきかどうかが明確になるはずです。

ぜひ最後までご覧ください。

Google Gemini 3 Flashの基本概要|爆速・低コストな最新AIモデル

Google Gemini 3 Flashを理解するために、まずは以下の3つの基本ポイントを押さえましょう。

- 圧倒的なレスポンス速度

- 実務に耐えうる高い知能

- 開発や運用に優しい低コスト

これらの要素が組み合わさることで、これまでのAIモデルでは難しかったリアルタイム処理が可能になります。

それでは、1つずつ順に解説します。

Gemini 3 Flashは「速さ」と「賢さ」を両立した軽量モデル

Google Gemini 3 Flashは、Googleが提供するAIモデルの中でも、特に処理速度とコスト効率を重視して設計された最新の軽量モデルです。

従来の軽量モデルは、速度を優先するあまり複雑な論理的思考や長文理解において精度が落ちる傾向にありました。

しかし、本モデルはアーキテクチャの抜本的な改善により、瞬時の応答性を維持しながらも、高度な推論能力を両立させています。

2025年現在のAI市場において、OpenAIのGPT-5シリーズなどと並び、最も注目されるモデルの一つとなりました。

こちらはGoogle公式によるGemini 3 Flashの発表内容について解説した記事です。 合わせてご覧ください。 https://blog.google/products/gemini/gemini-3-flash/

特に大量のリクエストを短時間で処理する必要があるカスタマーサポートや、リアルタイムのデータ解析においてその真価を発揮します。

「Flash」の名が示す通り、光速に近いスピードでユーザーの指示を理解し、的確な回答を生成することが可能です。

また、最新の蒸留技術を用いることで、モデルサイズをコンパクトに保ちつつ、学習データの質を極限まで高めている点も大きな特徴です。

比較対象として挙げたOpenAIの最新モデル「GPT-5.2」の機能やリリース情報については、こちらの記事で詳しく解説しています。 合わせてご覧ください。

最新の提供状況と日本での利用開始時期

Google Gemini 3 Flashは、2025年12月17日より日本国内でも本格的な提供が開始されました。

すでにGoogle AI StudioやVertex AIといったプラットフォームを通じて、開発者や企業向けにAPIが公開されており、即座に導入が可能です。

日本語への最適化もこれまで以上に進んでおり、日本の商習慣や独特の言い回しを正確に捉えることが可能になっています。

一般ユーザー向けのGeminiアプリにおいても、優先的にこのモデルが割り当てられる設定が登場しており、体感速度の向上が報告されています。

グローバルでのリリースからほとんどタイムラグなく日本でも利用できるようになったため、国内企業でも導入の動きが加速しています。

特にエンタープライズ領域では、データの国内保存や日本語サポートの充実が追い風となり、多くの採用事例が生まれています。

現在はすでに主要なGoogleワークスペース機能に統合されており、日常業務の中で自然にこの高速AIを利用できる環境が整っています。

初めての人でも分かるGemini 3 Flashの重要キーワード

Google Gemini 3 Flashを使いこなす上で、避けて通れない3つの重要キーワードがあります。

一つ目は「マルチモーダル」です。これはテキストだけでなく、画像、動画、音声を一度に読み取って理解する能力を指します。

二つ目は「コンテキストウィンドウ」で、一度にどれだけ大量の情報を読み込めるかというキャパシティのことです。

三つ目は「低レイテンシ」で、指示を出してから回答が返ってくるまでの遅延が極めて少ないことを意味します。

これらのキーワードは、業務効率化を検討する際に非常に重要な指標となります。

例えば、数時間の会議動画を読み込ませて数秒で要約を作成する、といった作業はこれらの技術の結晶と言えるでしょう。

これまでのAIでは数分かかっていた処理が、数秒単位に短縮されることで、業務の流れを止めることなくAIを活用できます。

初心者の方は、まずは「とにかく速くて、色々な種類のデータを扱える便利なAI」と覚えておけば間違いありません。

この基本性能の高さが、企業のデジタルトランスフォーメーションを強力に後押しする原動力となっています。

Gemini 3 FlashとPro・Nanoの違いを比較|どれを選ぶべき?

Google Gemini 3 Flashを導入する際、他のモデルとの使い分けに迷うケースが少なくありません。

- 推論能力を極めた「Pro」

- デバイス上で動く「Nano」

- バランス型の「Flash」

それぞれのモデルには明確な役割分担があり、用途に合わせて最適なものを選ぶことがコスト削減と精度向上の鍵となります。

ここでは、具体的な違いと判断基準を見ていきましょう。

【比較表】スペック・応答速度・得意領域の違い

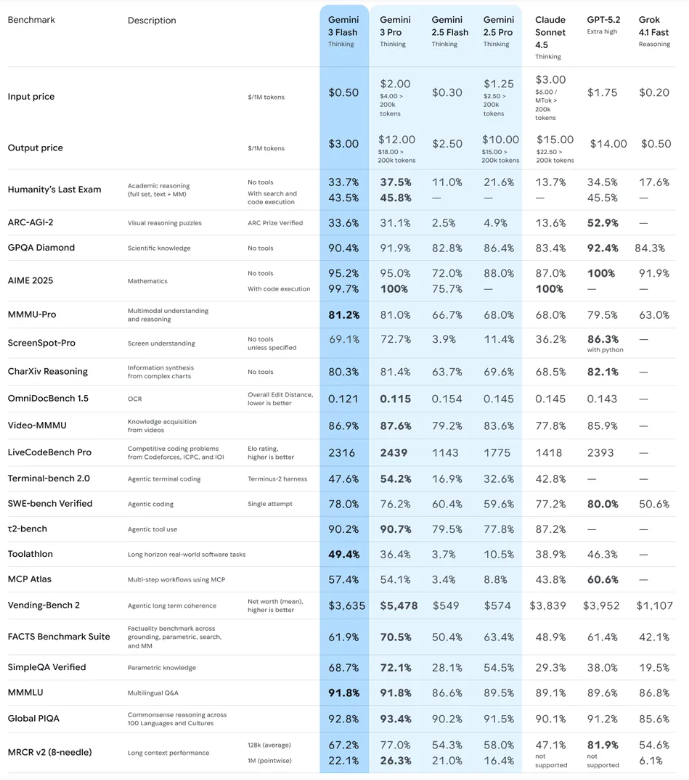

各モデルの主な違いを整理すると、まず応答速度においてGoogle Gemini 3 Flashが圧倒的に優位に立っています。

Proモデルは非常に高い推論能力を持ち、複雑な数学的解法や高度なクリエイティブ作成に適していますが、応答には数秒の時間を要します。

一方でFlashは、標準的なタスクであればミリ秒単位でのレスポンスを返し、ユーザーとの対話がスムーズに進みます。

Nanoモデルはスマートフォンのようなエッジデバイス内で動作するため、インターネット接続がない環境でのプライバシー重視の処理に向いています。

API利用料に関しては、FlashがProの数分の一程度のコストで利用できるため、大量のデータを処理する際の経済合理性が非常に高いです。

入力可能なトークン数、つまり一度に読み込める情報の長さについても、FlashはProと同等以上の広大なウィンドウを持っています。

これにより、コストを抑えながら長大なドキュメントを解析するという、かつては高額だった処理が低価格で実現可能となりました。

開発環境におけるスループット、すなわち単位時間あたりの処理量も、Flashが最も高く設定されています。

ビジネスの現場では、この「速さ」と「安さ」の組み合わせが、スケーラビリティを確保する上で決定的な差となります。

こちらはGemini 3 Flashを含む各AIモデルの最新ランキングについて解説した記事です。 合わせてご覧ください。 https://lmarena.ai/

高精度なPro、デバイス動作のNano、コスパのFlashという使い分け

モデルの選択肢が増えたことで、私たちは「適材適所」のAI運用が求められるようになりました。

Google Gemini 3 Flashが最も輝くのは、スピードが重要視されるフロントエンドの業務や、反復的な定型作業です。

例えば、チャットボットの応答や、SNSの投稿案の大量作成、ニュース記事の要約などがこれに該当します。

一方で、企業の経営戦略の策定や、高度なプログラムのバグ修正といった深い思考が必要な場面では、依然としてProモデルが推奨されます。

Nanoモデルは、スマートフォン上での自動返信文の提案や、機密性の高いメモの整理など、クローズドな環境での利用に特化しています。

Flashはこれらの中間に位置しながら、性能的にはProに迫る実力を持ちつつ、運用面ではNanoに近い軽快さを備えています。

そのため、現在のエンタープライズAI導入の主流は、メインの処理をFlashで行い、複雑な判断のみをProにエスカレーションするハイブリッド型です。

このように、各モデルの特性を理解して組み合わせることで、投資対効果を最大化することが可能になります。

AIを「道具」として捉えるなら、Flashは毎日使う万能なナイフ、Proは特別な時に使う精密なメスのような存在です。

モデル選びで迷った時の判断基準フローチャート

もし、どのモデルを使うべきか迷った場合は、まず「回答までの待ち時間を許容できるか」を自問してみてください。

ユーザーが画面の前で待機するようなサービスなら、迷わずGoogle Gemini 3 Flashを選択すべきです。

次に「処理するデータの量はどれくらいか」を検討します。

毎日数万件のデータを処理する必要があるなら、コストの観点からFlash一択になるでしょう。

一方で、1回の回答の質がビジネスの成否を分けるような重要な場面、例えば専門的な契約書のリーガルチェックなどはProが適しています。

また、外部サーバーにデータを一切送りたくない、ローカル環境のみで完結させたいという特殊な要件がある場合はNanoを検討します。

多くのビジネスシーンにおいては、Flashの精度で十分事足りることが多く、まずはFlashでプロトタイプを作成するのが定石です。

Flashで試してみて、どうしても精度が足りない部分だけをProに切り替えるというアプローチが、最も効率的な開発手法と言えます。

このように、速度・コスト・精度の3軸で優先順位をつけることが、モデル選びの失敗を防ぐ近道となります。

Google Gemini 3 Flashを使うメリット|圧倒的なスピードと処理能力

Google Gemini 3 Flashを導入する最大のメリットは、業務の「停滞」をなくせる点にあります。

- 即時応答によるユーザー体験の向上

- マルチモーダル対応によるデータ活用

- 長文読み込みによる情報集約の効率化

これらのメリットは、単なる作業の効率化に留まらず、新しいビジネスモデルの創出にも寄与します。

具体的な4つのメリットを詳しく解説します。

Intelligence in a Flash:リアルタイム処理を可能にする応答速度

Google Gemini 3 Flashの最大の強みは、その名の通り「Flash(閃光)」のような応答速度です。

従来のAIでは、プロンプトを入力してから回答が始まるまでに数秒の「間」があり、これが対話のテンポを損なう要因でした。

しかし、本モデルはこの遅延を極限まで削ぎ落とし、人間と会話しているのと変わらないリアルタイム性を実現しています。

これにより、カスタマーサポートのライブチャットにおいて、顧客を待たせることなく適切な回答を提示することが可能になりました。

この速度は、単に気持ちが良いというだけでなく、システム全体のパフォーマンス向上に直結します。

例えば、AIを組み込んだアプリケーションにおいて、バックエンドでの処理時間が短縮されれば、サーバーのリソース消費を抑えられます。

また、複数のAIエージェントを連携させて複雑なタスクをこなす場合、個々のエージェントが高速であれば全体の完了時間も劇的に早まります。

「待機時間」というサンクコストを排除できることは、スピード感が求められる現代のビジネスにおいて計り知れない価値を持ちます。

ユーザーがストレスを感じることなくAIの恩恵を享受できる環境は、サービスの継続利用率にも大きく貢献するでしょう。

こちらはGemini 3 Flashの速度と品質に関する第三者機関の分析データについて解説した記事です。 合わせてご覧ください。 https://artificialanalysis.ai/models/gemini-3-flash-reasoning

テキスト・画像・動画・音声を一括で理解するマルチモーダル性能

Google Gemini 3 Flashは、テキスト以外のデータもネイティブに処理できる高度なマルチモーダル性能を備えています。

画像を見てその内容を説明したり、動画の中から特定のシーンを探し出したりする作業が、驚くほどスムーズに行えます。

これまでのAIでは、画像を一旦別のモデルで言語化してから処理するといった手間が必要でしたが、Flashはその必要がありません。

音声ファイルを直接読み込ませて、発話者の感情まで考慮した文字起こしや要約を行うことも可能です。

この性能により、活用の幅はテキストベースの業務を超えて、クリエイティブや製造現場まで広がっています。

例えば、店舗の棚の画像を送って在庫状況を瞬時に判定させたり、マニュアル動画から必要な操作手順を抽出させたりできます。

複数のメディア形式が混在する情報を一元的に扱えるため、情報の「翻訳」プロセスで発生していた情報の欠落がありません。

異なる種類のデータを横断して分析することで、これまでは見落としていた洞察を得ることも可能になります。

マルチモーダルこそがGeminiシリーズの真骨頂であり、Flashはそのパワーを最も手軽に引き出せるモデルなのです。

膨大なデータを一度に処理できる長いコンテキストウィンドウ

Google Gemini 3 Flashが持つ広いコンテキストウィンドウは、膨大な情報の「海」を一度に渡りきる能力を提供します。

数十万トークン、あるいはそれ以上の情報を一度に読み込めるため、数百ページの技術文書や数時間分のソースコードを一括で解析できます。

情報を分割して読み込ませる必要がないため、文脈の取り違えが起こりにくく、全体像を捉えた正確な回答が得られます。

これは、特定の情報を探す「検索」の次元を超えて、情報同士の「関連性」を理解するステージに達していることを意味します。

例えば、大規模なシステムの全ソースコードを読み込ませ、特定のバグがどこに影響を及ぼすかを瞬時に特定させることが可能です。

また、過去数年分の顧客対応ログを一括で分析し、製品改善のための共通課題を見つけ出すといった使い方も現実的です。

長い情報を扱えることは、AIに与える「文脈(コンテキスト)」がより豊かになることを意味し、結果として回答の精度も向上します。

Flashはこの長大な情報を、軽量モデルとは思えない速度で処理し切るため、リサーチ業務のスピードを何倍にも引き上げます。

ビッグデータを「知恵」に変えるためのツールとして、このコンテキストウィンドウの広さは最強の武器となるでしょう。

開発者にとっての魅力:低コストで安定したスループット

開発者やシステム担当者にとって、Google Gemini 3 Flashは極めて導入ハードルの低いモデルです。

最大の魅力は、その圧倒的なコストパフォーマンスにあります。

高性能なモデルを運用する場合、トークン単価が高いために予算の制約で機能を制限せざるを得ない場面が多くありました。

しかし、Flashならその心配はほとんどなく、潤沢なトークンを惜しみなく使った高度なアプリケーションを構築できます。

また、APIのスループットが安定しており、大量のリクエストが集中してもレスポンスが極端に低下しにくい設計になっています。

Google Cloudの強固なインフラ上で動作するため、可用性が高く、エンタープライズ用途でのSLA(サービス品質保証)にも応えられます。

SDK(ソフトウェア開発キット)も充実しており、既存のシステムへの組み込みが容易である点も見逃せません。

テストやプロトタイピングの段階からFlashを使うことで、開発サイクルを高速化し、本番環境への移行もスムーズに行えます。

予算を抑えつつ、ユーザーには最高の体験を提供したいという開発者の理想を、Flashは現実のものにしてくれます。

Gemini 3 Flashはどこで使える?主な利用方法と環境

Google Gemini 3 Flashは、ユーザーのスキルや目的に合わせて様々な環境で利用可能です。

- Webブラウザやアプリでの直接利用

- 開発ツールを使った自由なカスタマイズ

- クラウドプラットフォーム経由の堅牢な導入

自分や自社に最適な入り口を見つけることで、導入の成功率は格段に高まります。

ここでは3つの主要な利用環境について説明します。

一般ユーザー向け:GeminiアプリやGoogle検索での利用

プログラミングの知識がない一般のビジネスパーソンでも、Google Gemini 3 Flashの恩恵をすぐに受けることができます。

最も簡単な方法は、ブラウザやスマートフォンアプリで提供されている「Gemini」を利用することです。

現在、多くの標準的なやり取りにはFlashモデルが適用されており、日常的なメール作成やスケジュール調整に活用できます。

Google検索の「AIによる概要(SGE)」機能にも、この高速なエンジンが組み込まれており、検索結果を待つ時間が短縮されています。

さらに、GoogleドキュメントやGmail、Googleスプレッドシートといったワークスペース製品内での統合も進んでいます。

サイドパネルからAIを呼び出し、執筆中の文書の要約や推敲を依頼する際、Flashの速度が作業のリズムを妨げません。

特別な設定をすることなく、普段使っているツールの中に「世界最高クラスのAI」が入り込んでいるのがGeminiの強みです。

個人での利用はもちろん、チーム内での情報共有や簡単なブレインストーミングの相手としても、Flashは非常に優秀です。

まずは無料版、あるいはPlusプランなどを通じて、その驚異的なレスポンス速度を体感してみることから始めましょう。

開発者向け:Google AI Studioでのプロトタイプ作成

AIを活用した新しいサービスを開発したいなら、Google AI Studioが最適な遊び場となります。

Google AI Studioは、Google Gemini 3 Flashなどの最新モデルをブラウザ上で手軽にテストできる開発者向けツールです。

複雑なコードを書かなくても、プロンプトを入力してパラメータを調整するだけで、AIの挙動を即座に確認できます。

作成したプロンプトは、そのままAPIキーを発行して自分のアプリケーションに組み込むことが可能です。

AI Studioの利点は、Flashモデルを「無料枠」の範囲内でかなり自由に試せる点にあります。

APIの呼び出し制限も緩やかで、開発初期の試行錯誤をコストを気にせず行えるのは大きなメリットです。

また、前述したマルチモーダル機能を試すためのインターフェースも整っており、画像のアップロードや動画の解析も数クリックで試せます。

ここで最適なプロンプトの構成(システム指示やFew-shotなど)を固めることで、本番実装時の手戻りを最小限に抑えられます。

「まずは動くものを作ってみたい」という開発者にとって、これほど強力で使い勝手の良い環境は他にありません。

こちらはGemini 3 Flashを活用したアプリケーション開発について解説した記事です。 合わせてご覧ください。 https://blog.google/technology/developers/build-with-gemini-3-flash/

企業・法人向け:Vertex AIやGemini APIを通じたシステム導入

本格的にビジネスプロセスへ組み込む場合、企業はGoogle Cloudの「Vertex AI」プラットフォームを選択することが一般的です。

Vertex AI経由でGoogle Gemini 3 Flashを利用することで、エンタープライズレベルのセキュリティと管理機能を手に入れられます。

入力したデータがAIの学習に流用されないことが保証されているため、機密情報を扱う業務でも安心して導入できます。

また、APIの利用状況を詳細にモニタリングしたり、予算管理を行ったりするためのツールも完備されています。

法人向けの利用では、特定のドキュメントや社内データベースと連携させる「RAG(検索拡張生成)」の構築が主な用途となります。

Flashは、このRAGにおける「検索結果の要約」や「データの分類」といった中核的な処理において、最高のコストパフォーマンスを発揮します。

既存の社内システムや顧客向けアプリにAPIで連携させることで、AIを意識させないシームレスな体験を提供可能です。

さらに、大規模な運用においては、APIのクォータ(割当量)の引き上げや専用のサポートなど、法人ならではの優遇措置も受けられます。

信頼性と拡張性を重視するなら、Vertex AIを通じた導入が最も確実で安全な選択肢となります。

こちらは企業向けGemini 3 Flashの導入メリットについて解説した記事です。 合わせてご覧ください。 https://cloud.google.com/blog/products/ai-machine-learning/gemini-3-flash-for-enterprises/

業務効率化に効く!Gemini 3 Flashの具体的な活用シーン7選

Google Gemini 3 Flashのポテンシャルを最大限に引き出すための、実戦的な活用例を紹介します。

- カスタマー対応の自動化

- ドキュメント解析の高速化

- データ構造化による分析準備

- RAGの精度向上

- エンジニアの作業補助

- メディア資産のタグ付け

- 自律的なAIエージェントの構築

Geminiを活用した具体的な業務効率化の事例や、明日から使えるプロンプト集については、こちらの記事で詳しく紹介しています。 合わせてご覧ください。

これらの事例をヒントに、自社のどの業務にFlashを当てはめるべきか検討してみてください。

1. カスタマーサポートの一次返信・FAQの自動生成

カスタマーサポートの現場では、スピードが顧客満足度に直結します。

Google Gemini 3 Flashを導入すれば、顧客からの問い合わせメールやチャットに対して、瞬時に下書きを作成できます。

過去の対応履歴やFAQをコンテキストとして与えることで、企業のトーン&マナーに沿った正確な回答案を生成可能です。

人間はAIが作った下書きを確認・修正して送信するだけで済むため、一件あたりの対応時間は劇的に短縮されます。

また、日々の問い合わせ内容を分析し、不足しているFAQ項目を自動で抽出・生成することも得意です。

顧客の感情を読み取って、怒っている顧客にはより丁寧な謝罪を、急いでいる顧客には簡潔な解決策を提示するような出し分けもできます。

これにより、スタッフの精神的負荷を軽減しつつ、サポートの質を均一化することが可能です。

Flashの低コスト性を活かせば、全件に対してAIによる一次フィルタリングを行っても、運用コストを低く抑えられます。

2. 大量ドキュメントや会議ログの高速要約・タスク抽出

毎日発生する大量の議事録や報告書に目を通すのは、多くのビジネスパーソンにとって大きな負担です。

Google Gemini 3 Flashにこれらのドキュメントを読み込ませれば、数秒で要点だけを抽出できます。

単なる要約だけでなく、「誰が、いつまでに、何をすべきか」というToDoリストを自動で作成させるのがおすすめです。

特に、長時間にわたるオンライン会議の録画データや音声ファイルをそのまま解析し、決定事項をまとめる作業で威力を発揮します。

Flashなら複数の資料をまたいで内容を比較し、共通点や矛盾点を指摘させるといった高度な使い方も可能です。

「このプロジェクトの進捗に関するリスクは何ですか?」といった問いに対し、膨大な資料から根拠を見つけて回答してくれます。

リサーチ担当者が何時間もかけて行っていた情報収集と整理が、AIとの数回のやり取りで完結するようになります。

この圧倒的な「時短」効果により、人間はよりクリエイティブな意思決定の仕事に集中できるようになります。

3. 契約書や請求書からの特定データ抽出・構造化

PDFや画像形式の書類から、必要な項目だけを抜き出してExcelやデータベースに転記する作業は、AIが最も得意とする領域です。

Google Gemini 3 Flashのマルチモーダル機能を活用すれば、スキャンされた請求書から「金額」「日付」「取引先名」を正確に抽出できます。

レイアウトがバラバラな複数の書類でも、AIが文脈を理解して適切な項目に分類してくれるため、従来のOCR(光学文字認識)よりも格段に精度が高まります。

抽出したデータは、JSONなどのシステムで扱いやすい形式で出力させることが可能です。

これにより、手入力によるミスを排除し、業務フローの完全自動化に大きく近づけます。

契約書に含まれる「有効期限」や「解約条項」などの特定のキーワードを抽出し、アラートを鳴らすといった管理業務にも応用できます。

大量のバックオフィス業務を抱える企業にとって、Flashは強力なデジタル労働力として機能します。

4. RAG(検索拡張生成)における前処理とデータ分類

社内知識をAIに活用させるRAG(Retrieval-Augmented Generation)において、Flashは縁の下の力持ちとして活躍します。

RAGの精度を上げるためには、元となるデータをAIが検索しやすいように整理(クリーニング)する工程が欠かせません。

Google Gemini 3 Flashを使えば、大量のドキュメントに適切なメタデータやタグを付与し、情報を小分け(チャンク化)する作業を高速で行えます。

また、ユーザーの質問をAIが理解しやすい形に書き換えたり、質問の意図を分類して適切なデータベースへ誘導したりする「ルーター」の役割も担えます。

RAGシステム全体の応答速度は、この前処理の速さに左右されるため、Flashの低レイテンシがシステム全体の体験価値を高めます。

高度な推論をProで行う前の「仕分け」をFlashに任せることで、全体のコストを最適化しつつ、精度の高い回答を実現できます。

5. コードレビューの補助と軽量なバグ修正

エンジニアの生産性向上においても、Google Gemini 3 Flashは欠かせない存在になりつつあります。

作成したコードを貼り付けて「レビューして」と依頼すれば、修正すべき箇所やセキュリティ上のリスクを即座に指摘してくれます。

特に、ユニットテストの自動生成や、コードのドキュメント(コメント)作成といった手間のかかる作業をFlashに任せるのが効果的です。

複雑なロジックの構築は人間やProモデルの役割ですが、既存コードの軽微なバグ修正やリファクタリングにはFlashで十分対応可能です。

IDE(統合開発環境)にFlashを組み込むことで、コーディングの手を止めることなくAIのアドバイスを受けられます。

長いコードベースをコンテキストとして保持できるため、ファイル間の依存関係を考慮した的確なアドバイスが得られるのもGeminiならではの強みです。

6. 大量の画像・動画コンテンツの内容解析とタグ付け

メディア系企業やEコマース事業において、画像や動画の管理は非常に手間のかかる作業です。

Google Gemini 3 Flashに商品画像やPR動画を読み込ませることで、映っているものやシーンの特徴を自動で言語化できます。

「赤い服を着て笑っている女性」「公園でピクニックをしている風景」といった詳細なタグを自動付与すれば、検索性が劇的に向上します。

また、動画の中から不適切なコンテンツが含まれていないかを確認するモデレーション業務の自動化にも役立ちます。

1時間以上の動画であっても、Flashなら数分で全内容をスキャンし、タイムスタンプ付きのインデックスを作成してくれます。

これまで人間が目視で行っていた膨大なチェック作業をAIに代替させることで、コンテンツ制作のリードタイムを大幅に短縮できます。

7. 特定タスクを繰り返す「AIエージェント」としての活用

最近のトレンドである「AIエージェント」の構築において、Google Gemini 3 Flashは最適なエンジンとなります。

AIエージェントとは、目標を与えると自ら計画を立て、必要なツールを使いこなしてタスクを完了させる自律型AIのことです。

エージェントが思考と実行を繰り返すループ構造では、一回一回の推論コストと速度が全体のパフォーマンスを左右します。

Flashの「速さ」と「安さ」は、試行錯誤を何度も繰り返すエージェントにとって理想的な特性です。

例えば、「Webで最新の競合他社情報をリサーチし、比較表を作成してメールで送る」という一連の動作を、Flashが司令塔となって実行します。

失敗してもすぐに別の方法を試すことができるため、実務で使えるレベルの自律性が確保しやすくなります。

単なる「チャット相手」から、実務をこなす「デジタル社員」へと、FlashがAIの役割を進化させます。

Google Gemini 3 Flashの料金体系|コストを抑えて運用するポイント

Google Gemini 3 Flashは「低コスト」を売りにしていますが、具体的な料金体系と賢い節約術を知ることで、さらに効率的に運用できます。

- トークン課金の仕組みを理解する

- 思考レベルの設定でバランスを取る

- 実際のコストシミュレーションを行う

無駄な出費を抑えつつ、最大限の効果を得るためのポイントを解説します。

API利用料の仕組み(入力・出力トークンごとの課金)

Google Gemini 3 FlashのAPI料金は、基本的に「入力したデータの量(入力トークン)」と「生成されたデータの量(出力トークン)」に基づいて計算されます。

2025年現在、FlashモデルはProモデルに比べて、入力・出力ともに大幅に安価な価格設定が維持されています。

特筆すべきは、大量のコンテキストを読み込ませる際の「入力コスト」の低さです。

長いドキュメントを何度も参照するようなシステムでも、Flashなら運用コストを最小限に抑えられます。

また、Google Cloudの最新の料金体系では、一定量までの利用が無料になる「無料枠」や、長期利用による割引なども提供されています。

料金は「100万トークンあたり数十円から数百円程度」のオーダーであり、個人開発者から大企業まで納得感のある価格となっています。

注意点として、画像や動画などのマルチモーダルデータは、テキストよりも多くのトークンを消費する傾向にあります。

データの形式や解像度によってコストが変わるため、事前にどの程度のトークンを消費するかを計測しておくことが重要です。

品質とコストを調整する「thinking_level」の設定

2025年12月の最新アップデートにより、Geminiシリーズには回答の「思考の深さ」を調整できるパラメータが導入されました。

Google Gemini 3 Flashにおいても、この設定を活用することで、タスクに応じたコスト最適化が可能です。

簡単な挨拶や定型文の生成には「最小限の思考」を設定し、論理的なパズルやコードの解析には「深い思考」を選択します。

思考レベルを上げるとレスポンス時間はわずかに増えますが、その分、精度の高い回答が得られます。

API経由で利用する場合、リクエストごとにこのレベルを指定できるため、一つのシステム内で柔軟な使い分けが可能です。

「このプロンプトは簡単だから一番安い設定で」「これは重要だから少しコストをかけても丁寧に」といった制御ができます。

これにより、すべてのリクエストを最高設定で処理する場合に比べ、全体で20〜30%のコスト削減に成功している事例もあります。

Flashモデルの持つポテンシャルを、予算に合わせて自由にカスタマイズできるのがこの機能の魅力です。

こちらはGemini APIの思考パラメータと設定レベルの詳細について解説した記事です。 合わせてご覧ください。 https://ai.google.dev/gemini-api/docs/thinking

導入前に知っておきたい利用料金のシミュレーション例

導入後の「予算オーバー」を防ぐために、具体的な利用シーンでのコストシミュレーションを行っておきましょう。

例えば、1日100件のカスタマー問い合わせに対応し、1件あたり平均2,000トークンの入出力が発生するとします。

この場合、1ヶ月(30日)の総トークン数は約600万トークンとなりますが、Flashモデルなら月額数百円から数千円程度で収まる計算です。

これがProモデルであれば、数倍から十倍以上のコストがかかる可能性があるため、Flashの経済性は圧倒的です。

また、RAGシステムで10,000ページの社内文書をインデックス化する際の一時的なコストも、Flashなら非常に安価です。

運用開始後の「月額ランニングコスト」と、導入時の「初期データ処理コスト」を分けて考えることがポイントです。

Google Cloudのコンソールにはコスト見積もりツールが用意されているため、想定されるリクエスト数を入力して試算してみることをお勧めします。

予想以上の安さに驚き、より積極的なAI活用へと踏み出せるはずです。

法人利用でも安心?セキュリティとデータの取り扱い

企業がGoogle Gemini 3 Flashを導入する上で、最も懸念されるのが「情報の安全性」です。

- 学習に使われない設定の確認

- APIと標準アプリの規約の違い

- ガイドラインの策定

Googleはエンタープライズ向けの堅牢な保護策を提供しており、適切な設定を行えば機密情報を扱う業務でも利用可能です。

入力したデータが学習に使われないための設定

多くの企業が懸念する「入力データがAIの学習に利用され、外部に漏洩する」リスクについて、Googleは明確な回答を出しています。

Vertex AIやGemini APIの企業向けプランを通じて利用する場合、ユーザーが入力したプロンプトや出力結果が、Googleのモデル学習に使用されることはありません。

これは契約上の明文規定として保証されており、高いコンプライアンス基準を求める金融機関や医療機関での導入が進んでいる理由でもあります。

一方で、個人向けの無料版Geminiアプリを利用する場合、デフォルトでは改善のためにデータが利用される設定になっていることがあります。

法人として利用する際は、必ずGoogle Cloudプロジェクトを作成し、適切なAPIキーやサービスアカウントを通じて利用するように徹底しましょう。

このように、利用する「入り口」を正しく選択することが、企業の知的財産を守るための第一歩となります。

管理画面から「データの利用設定」をオフにできる機能も備わっており、二重三重の保護策が講じられています。

Gemini APIとGoogle Workspaceでのデータ保護の違い

Google Gemini 3 Flashを利用する環境によって、適用されるデータ保護のルールが若干異なる点には注意が必要です。

Google Workspace(Gemini for Workspace)を利用している場合、ドキュメントやメールの内容はエンタープライズ級の保護下に置かれます。

これらはGoogle Cloudのプライバシー規定に準拠しており、組織外にデータが漏れることはありません。

APIを自社アプリに組み込む場合は、そのアプリ自体のセキュリティ設計も重要になります。

また、2025年時点では「ChatSense」のような、よりセキュリティに特化した法人向けAIチャットツールの導入も一般的です。

こうしたツールを介してFlashモデルを利用することで、ユーザー管理やログ監視、機密情報のフィルタリングといった付加価値が得られます。

APIを直接叩くのが難しい非エンジニア主体の部署では、こうした安全なラップ済みサービスを利用するのが賢明です。

いずれの場合も、Googleが提供する「エンタープライズグレード」の保護がベースにあるため、従来のクラウドサービスと同等以上の安心感があります。

企業が策定しておくべき「AI利用ガイドライン」の要点

技術的な保護策に加えて、社内での「AI利用ガイドライン」を定めておくことが、運用の安全性を高める上で不可欠です。

ガイドラインには、まず「入力してはいけない情報の定義」を明確に記載します。

例えば、顧客の個人番号や未発表の経営戦略、パスワードなどは、どんなに安全なAIであっても入力しないのが基本です。

次に「AIの回答をそのまま公開しない」というルールを徹底します。

AIは稀に、事実に基づかないもっともらしい嘘(ハルシネーション)をつくことがあります。

Google Gemini 3 Flashは非常に高精度ですが、最終的なファクトチェックは必ず人間が行うというフローを確立してください。

また、AIによって生成されたコンテンツが他者の著作権を侵害していないか、権利関係のチェック体制も必要です。

ガイドラインは一度作って終わりではなく、AIの進化や法整備に合わせて定期的にアップデートしていくことが求められます。

技術への理解と適切なルールが両輪となって初めて、AIは真に安全なツールとなります。

生成AIを企業で導入する際のリスク管理や具体的なセキュリティ対策については、こちらの記事で徹底解説しています。 合わせてご覧ください。

Gemini 3 Flashの性能を引き出すプロンプト作成のコツ

Google Gemini 3 Flashは軽量モデルであるため、指示の出し方(プロンプト)次第でその精度が大きく変わります。

- 前提条件を明確に伝える

- 複雑な指示はステップに分ける

- 出力形式を厳密に指定する

これらのコツを押さえることで、Proモデルに匹敵する、あるいはそれ以上の成果を引き出すことが可能になります。

Geminiの性能を最大限に引き出すための、AIへの指示(プロンプト)の基本的な作り方や日本語の具体例はこちらの記事にまとめています。 合わせてご覧ください。

軽量モデルでも精度を落とさない「前提条件」の伝え方

Google Gemini 3 Flashに指示を出す際は、まず「あなたは誰で、何のためにこの作業をするのか」という役割(ペルソナ)を明確にしましょう。

「あなたは熟練のカスタマーサポート担当者です」「あなたは10年の経験を持つPythonエンジニアです」といった一文を加えるだけで、回答の質が劇的に向上します。

次に、背景情報を詳しく伝えます。何についての資料なのか、誰が読むのか、どんな目的で使われるのかをAIに理解させることが重要です。

また、出力の「トーン&マナー」を指定することも忘れないでください。

「丁寧な敬語で」「親しみやすい口調で」「専門用語を避けて」といった具体的な指示が、Flashの柔軟性を引き出します。

軽量モデルは、指示が曖昧だと無難で短い回答に逃げる傾向がありますが、外枠をしっかり固めてあげることで、その枠内で最大限の能力を発揮します。

プロンプトの冒頭に「以下の条件を厳守してください」と記述し、箇条書きでルールを提示するのが最も効果的です。

複雑な指示はステップごとに分割して与える

一度に複数のタスクをこなさせようとすると、Google Gemini 3 Flashは一部の指示を見落としたり、処理が雑になったりすることがあります。

これを防ぐためには、「Chain of Thought(思考の連鎖)」と呼ばれる手法が有効です。

「まず、この文章から主要な論点を3つ抽出してください。次に、それぞれの論点に対して反論を考えてください。最後に、それらをまとめて結論を出してください」

というように、作業を論理的なステップに分けて指示を出します。

AIに「ステップバイステップで考えてください」と一言添えるだけでも、推論の精度が向上することが知られています。

複雑なプログラミングやデータ分析を依頼する場合は、いきなり完成品を求めるのではなく、中間成果物を確認しながら進めるのがコツです。

ステップを分けることで、どこでAIが間違えたのかを特定しやすくなり、修正も容易になります。

Flashの速さを活かして、細かいステップで何度もやり取りを繰り返す方が、一度に巨大な指示を出すよりも結果的に早く、質の高い成果が得られます。

出力形式を指定して後続のシステム処理をスムーズにする

Google Gemini 3 Flashの回答を他のツールやシステムで利用する場合、出力の「形」をコントロールすることが極めて重要です。

「JSON形式で出力して」「表形式にまとめて」「マークダウン記法で書いて」といった指示を具体的に行います。

特にAPI連携を行う場合は、項目のキー名(例:”customer_id”, “priority”)まで指定することで、プログラム側でのパース(解析)が容易になります。

余計な解説文を省きたい場合は、「説明は不要です。出力結果のみを表示してください」と付け加えるのが鉄則です。

また、回答の選択肢を「YesまたはNoで答えてください」のように限定することで、曖昧さを排除できます。

Flashは指示に従う忠実さ(ステアラビリティ)が高いため、形式を細かく指定すればするほど、期待通りの「データ」として機能する回答を返してくれます。

このようにAIを「思考するエンジン」だけでなく「データ変換の職人」として扱うことが、高度な自動化を実現する秘訣です。

Google Gemini 3 Flashに関するよくある質問(FAQ)

最後に、Google Gemini 3 Flashの導入を検討されている方から寄せられる、よくある質問にお答えします。

無料で使う方法はありますか?

はい、いくつかの方法で無料で利用することが可能です。

最も身近なのは、Googleが提供する一般ユーザー向けの「Gemini」アプリやWebサイトを利用することです。

標準的な設定ではFlashモデルが採用されており、基本的なチャット機能や情報検索を無料で楽しめます。

開発者の方であれば、Google AI Studioを利用することで、一定のクォータ(制限)内であればAPI経由での利用も無料で行えます。

また、Google Cloudの新規登録時に付与される無料クレジットを活用して、Vertex AI上でFlashを試すことも可能です。

日本語での利用精度は実務レベルですか?

結論から申し上げますと、十分に実務レベルに達しています。

Google Gemini 3 Flashは、膨大な日本語データセットで学習されており、自然な文章作成や複雑な文脈の理解が可能です。

特に、ビジネス文書の敬語表現や、日本固有の慣習に関連する質問に対しても、違和感のない回答を生成します。

もちろん、極めて専門的な法務や医療の判断には慎重な検証が必要ですが、一般的な事務作業や企画立案、要約、翻訳などの用途では、すでに多くの日本企業がメインモデルとして採用しています。

2025年の最新アップデートにより、日本語独特のニュアンスを汲み取る能力はさらに向上しています。

以前のモデル(2.5 Flash等)からの移行は簡単ですか?

はい、移行は非常にスムーズに行えるよう設計されています。

Google Gemini 1.5 Flashなどの旧モデルを使用していた場合、APIの呼び出し先(エンドポイント)のモデル名を「gemini-3-flash」に変更するだけで、基本的な動作はそのまま維持されます。

多くの場合、旧モデルよりも回答の精度が上がり、処理速度も向上するため、移行によるメリットを即座に享受できます。

ただし、モデルの個性が微妙に異なるため、プロンプトの微調整が必要になる場合もあります。

まずはAI Studioなどで挙動を確認し、既存のテストケースをパスするかをチェックしてから、本番環境を切り替えるのが安全な手順です。

本記事が、Google Gemini 3 Flashの導入を検討されている皆様の参考になれば幸いです。

生成AIの進化は非常に早いため、まずは実際に触ってみて、そのスピードと可能性を体感してみてください。

この記事のプロンプトをさらに活用する方法や、自社に最適なAI導入プランについて相談したい方は、ぜひお問い合わせください。

こちらはGemini APIの最新の更新履歴や変更点について解説した記事です。 合わせてご覧ください。 https://ai.google.dev/gemini-api/docs/changelog

AIのスピードがもたらす落とし穴?速すぎる回答が「直感」を鈍らせる可能性

Google Gemini 3 Flashの最大の魅力はその「速さ」ですが、実はAIの回答が速すぎることが、人間の意思決定の質を下げてしまう可能性があることをご存知でしょうか。スタンフォード大学の研究によると、人間はAIからのレスポンスが速すぎると、その内容を十分に検証せずに受け入れてしまう「自動化バイアス」に陥りやすいことが示唆されています。

便利だからこそ、私たちは速さに流されず、AIが出した結論に対して一歩立ち止まって考える習慣を持つ必要があります。Gemini 3 Flashを単なる時短ツールとして使うのか、それとも思考を加速させる触媒として使うのか。その使い分けが、これからのビジネスパーソンに求められる真のAIリテラシーと言えるでしょう。

引用元:

スタンフォード大学の人間中心AI研究所(HAI)は、AIの応答速度がユーザーの信頼度と批判的思考に与える影響について調査を行いました。その結果、即時の応答はユーザーの作業効率を高める一方で、誤情報に対する見落とし率を上昇させる傾向があることが指摘されています。(Stanford HAI, “The Speed-Accuracy Tradeoff in Human-AI Collaboration”, 2024年)

まとめ

企業は労働力不足や業務効率化の課題を抱える中で、生成AIの活用がDX推進や業務改善の切り札として注目されています。

しかし、実際には「どこから手を付ければいいかわからない」「社内にAIリテラシーを持つ人材がいない」といった理由で、導入のハードルが高いと感じる企業も少なくありません。

そこでおすすめしたいのが、Taskhub です。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「何をどう使えばいいのかわからない」という初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプログラミングや高度なAI知識がなくても、すぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最速の生成AI活用”を体験し、御社のDXを一気に加速させましょう。

「Google Gemini 3 Flashって、前のモデルと何が違うの?」「速いのはいいけど、ビジネスの実務で本当に使える精度なの?」

こういった疑問や不安を感じている方も多いのではないでしょうか。

本記事では、Googleの最新AIモデル「Google Gemini 3 Flash」の基本スペックから料金、他モデルとの比較、および具体的な活用シーンまで徹底解説しました。

上場企業を中心に生成AI導入を支援している弊社が、現場の知見をもとに最新情報をお伝えしました。

この記事を読んだことで、Gemini 3 Flashを自社に導入すべきかどうかが明確になったはずです。

ぜひTaskhubとあわせて、最新AIの導入をご検討ください。