ChatGPTを業務や日常生活で活用する人が増える一方で、セキュリティ面での不安を感じている方も多いのではないでしょうか。

「会社で使いたいけれど、情報漏洩のリスクがないか心配」

「入力したデータが勝手に学習されてしまうのではないか」

このような悩みを抱えている方もいるはずです。実際に、不適切な利用によって機密情報が流出してしまった事例も世界中で報告されており、正しい知識を持たずに利用することは危険を伴います。

本記事では、リリース済みの最新モデル「ChatGPT 5.2」の情報も含め、ChatGPTの現在のセキュリティ事情や具体的なリスク、そして絶対にやってはいけないNG行動について詳しく解説します。

上場企業向けに生成AIの導入支援を行っている弊社が、安全にツールを活用するための具体的な設定方法や対策まで網羅しました。

この記事を読めば、リスクを回避しながらChatGPTを最大限に活用できるようになるはずです。ぜひ最後までご覧ください。

そもそもChatGPTのセキュリティは安全なのか?

ここからは、ChatGPTの基本的なセキュリティ構造や、OpenAI社がどのような対策を講じているのかについて解説します。

- OpenAI社のセキュリティ基準と取り組み

- 学習に使われる仕組みとリスク

- 無料版と有料版での安全性の違い

これらの基礎知識を押さえておくことで、ツールに対する漠然とした不安を解消し、適切な距離感で利用できるようになります。

それでは、OpenAI社の取り組みから順に見ていきましょう。

OpenAI社のセキュリティ基準と安全性への取り組み

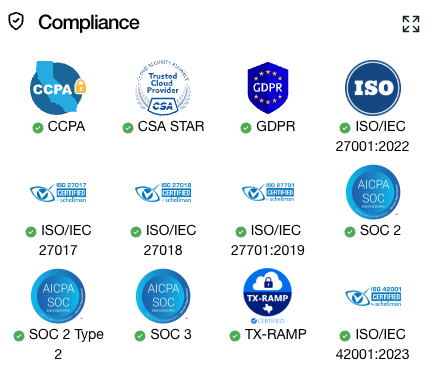

ChatGPTを開発・提供しているOpenAI社は、ユーザーのデータを保護するために世界水準の厳格なセキュリティ対策を実施しています。企業の信頼性を担保するための国際的な認証であるSOC2への準拠をはじめ、データの暗号化やアクセス制御など、徹底した管理体制が敷かれています。

OpenAI社のセキュリティコンプライアンスや準拠している規格については、公式のトラストポータルで詳細が公開されています。信頼性の根拠として合わせてご確認ください。 https://trust.openai.com/

特に最新モデル「GPT-5.2」においては、安全性へのアプローチがさらに強化されました。「出力中心の安全性」という新しい概念が導入され、ユーザーが意図的に不正な指示を出す「プロンプトインジェクション」への耐性が飛躍的に向上しています。

本文で触れた最新モデルであるGPT-5.2の機能や詳細、前モデルとの具体的な違いについてはこちらの記事で詳しく解説しています。 合わせてご覧ください。

これにより、AIが有害な情報を生成したり、システム内部の情報を漏らしたりするリスクが従来よりも低減されました。また、外部のセキュリティ専門家によるレッドチーム演習(模擬攻撃)を繰り返し実施し、脆弱性の発見と修正を継続的に行っています。

このように、OpenAI社側では高度なセキュリティ対策が講じられていますが、クラウドサービスである以上、リスクがゼロになることはありません。私たちユーザー側も、システムが安全であることを過信せず、正しい利用方法を理解しておく必要があります。

入力したデータが「AIの学習に使われる」仕組みとリスク

ChatGPTを利用する上で最も理解しておくべき点は、私たちがチャット画面に入力したデータが、AIの再学習に利用される可能性があるという仕組みです。

OpenAIの初期設定では、サービスの改善やモデルの精度向上を目的として、ユーザーとの会話データを活用することが明記されています。つまり、あなたが何気なく入力した会社の内部情報やプライベートな相談内容が、将来的にAIの知識の一部となり、全く関係のない第三者への回答として出力されてしまうリスクがあるのです。

特に注意が必要なのは、無料版や個人向けの有料プラン(Plus)をデフォルト設定のままで利用している場合です。この状態では、入力データは基本的にOpenAIのサーバーに保存され、学習データとして扱われる可能性があります。

学習データに関する仕様や、エンタープライズ向けプライバシーポリシーについては公式情報をご確認ください。どのようなデータが保護されるか詳細に記されています。 https://openai.com/enterprise-privacy

ただし、この仕組みはユーザー側で制御することが可能です。設定画面から学習を拒否する「オプトアウト」の手続きを行うことで、自分のデータがAIの進化に使われるのを防ぐことができます。この設定を行わない限り、入力した情報は「世界中に公開される可能性がある」という意識を持つことが重要です。

無料版と有料版(Plus・Team・Enterprise)での安全性の違い

ChatGPTには複数のプランが用意されており、それぞれセキュリティレベルやデータの取り扱い方針が異なります。特に企業で利用する場合は、この違いを明確に理解してプランを選定する必要があります。

まず、個人向けの無料プランおよび有料の「Plus」プランでは、先ほど解説したように、デフォルトでは入力データが学習に利用されます。ユーザー自身で設定を変更しない限り、機密性の高いやり取りを行うには適していません。一方で、2025年以降のモデル統合により、無料版でもGPT-5クラスのモデルが利用できるなど、機能面での差は縮まりつつあります。

企業・組織向けの「Team」プランや「Enterprise」プランでは、セキュリティ要件が大きく異なります。これらのプランでは、初期設定の段階で「入力データを学習に利用しない」という仕様になっています。

さらに、Enterpriseプランでは、より高度な管理機能やSSO(シングルサインオン)、ドメイン認証などが提供され、企業ポリシーに合わせた厳格な運用が可能です。また、API経由での利用においても、OpenAIは「APIを通じて送信されたデータは学習に使用しない」と明言しています。業務利用においては、これらの法人向けプランやAPIの活用を検討するのが基本となります。

組織でChatGPTを導入する際の具体的な手順や料金プラン、セキュリティ機能の違いをまとめた企業向け導入ガイドはこちらです。 合わせてご覧ください。

ChatGPT利用時に注意すべき3つの主なリスク

ここからは、ChatGPTを利用する際に具体的にどのようなトラブルが発生し得るのか、主要なリスクを3つに分けて解説します。

- 機密情報・個人情報の漏洩リスク

- ハルシネーションによる誤情報の拡散

- 著作権侵害や知的財産権に関わるリスク

これらのリスクを正しく認識することは、自分自身だけでなく、所属する組織を守ることにもつながります。

それぞれのリスクについて、詳細を見ていきましょう。

企業で安全に生成AIを活用するための社内ガイドラインの作り方や、具体的な項目を盛り込んだひな形については、こちらの記事で詳しく解説しています。 合わせてご覧ください。

機密情報・個人情報の漏洩リスク(入力データの二次利用)

ChatGPT利用における最大のリスクは、やはり情報の漏洩です。これはサイバー攻撃によって情報が盗まれるというよりも、ユーザー自身の不注意な入力によって引き起こされるケースがほとんどです。

前述の通り、AIに入力した情報はサーバーに送信され、場合によっては学習データとして蓄積されます。例えば、エンジニアが開発中のプログラムコードを修正させるためにChatGPTに入力したり、営業担当者が顧客とのメールの文面を推敲させるためにそのまま貼り付けたりする行為は非常に危険です。

過去には、実際に大手企業で社員が機密情報を入力してしまい、社外への持ち出しと同様の状態になった事例も発生しています。もしそのデータが学習され、競合他社がChatGPTを使った際に「〇〇社の新製品の仕様は?」という質問への回答として出力されてしまったら、取り返しがつきません。

実際にダークウェブ上でChatGPTのアカウント情報が取引されている実態も報告されています。漏洩リスクに関する調査レポートはこちらをご覧ください。 https://www.group-ib.com/blog/chatgpt-credentials-stealer/

チャット履歴をオフにする設定や、学習させない法人プランを使っていない限り、入力欄は「インターネット上の掲示板」と同じであると捉えるべきです。一度送信してしまったデータを取り消すことは極めて難しいため、入力前のチェックが何よりも重要になります。

ハルシネーション(もっともらしい嘘)による誤情報の拡散

セキュリティとは少し観点が異なりますが、情報の正確性という面でのリスクも無視できません。AIが事実とは異なる内容を、あたかも真実であるかのように生成する現象を「ハルシネーション(幻覚)」と呼びます。

こちらはAIのハルシネーションを防ぐプロンプトや、精度の高い回答を得るための具体的な対策について解説した記事です。 合わせてご覧ください。

GPT-5.2などの最新モデルでは、推論能力の向上によりハルシネーションの発生率は大幅に低下しました。しかし、それでも完全にゼロになったわけではありません。特に、専門的な知識が必要な分野や、直近に発生した出来事、マイナーな人物に関する情報などでは、依然として誤った回答を生成することがあります。

このリスクが深刻になるのは、生成された文章を人間がファクトチェックせずにそのまま外部へ発信してしまった場合です。誤った情報を公式サイトに掲載したり、取引先へのメールに記載したりすれば、企業の信用失墜や損害賠償問題に発展する可能性があります。

「AIが言っているから正しい」と鵜呑みにせず、必ず一次情報を確認するプロセスを組み込むことが、安全な運用の大前提です。特に数値データや法的根拠などが絡む場合は、入念な裏取りが必要です。

著作権侵害や知的財産権に関わる法的リスク

生成AIと著作権の問題は、現在進行形で議論が続いている複雑な領域です。ChatGPTが生成したコンテンツを利用することで、知らず知らずのうちに他者の著作権を侵害してしまうリスクが存在します。

AIはインターネット上の膨大なデータを学習していますが、その中には著作権で保護された文章やコードも含まれています。もしChatGPTが出力した文章が、既存の著作物と酷似していた場合、それをそのまま商用利用すると著作権侵害に問われる可能性があります。

また、逆のパターンとして、自社のコンテンツをAIに入力することで、その情報の権利関係が曖昧になるリスクもあります。例えば、自社独自のノウハウをAIに入力して新しいマニュアルを作成させた場合、その生成物の権利をどこまで主張できるかは法的にグレーな部分が残ります。

文化庁より「AIと著作権」に関する考え方が資料として公開されています。法的リスクを正しく理解するために一読することをおすすめします。 https://www.bunka.go.jp/seisaku/chosakuken/pdf/93903601_01.pdf

特に、小説の要約、歌詞の作成、既存のキャラクターに関連するコンテンツ生成などにおいては注意が必要です。業務で生成物を利用する場合は、類似性チェックツールを活用するなどして、他者の権利を侵害していないか確認するフローを設けることが推奨されます。

【具体例】ChatGPTに絶対に入力してはいけない情報リスト

ここからは、リスク管理の観点から、ChatGPTのプロンプト(入力欄)に絶対に入力してはいけない具体的な情報の種類を紹介します。

- 個人を特定できる情報

- 企業の未公開情報・機密データ

- 認証情報(ID・パスワード)

- 顧客リスト等の非公開データ

- 他者の権利に関わるコンテンツ

これらは、いかなる設定を行っていたとしても、入力すること自体を避けるべき情報です。

なぜこれらが危険なのか、具体例を交えて解説します。

個人を特定できる情報(氏名、住所、電話番号、マイナンバーなど)

個人情報の入力は、最も基本的かつ絶対に行ってはいけない行為の一つです。自分自身の情報はもちろんのこと、顧客、従業員、家族など、第三者の個人情報を入力することは厳禁です。

具体的には、氏名、住所、電話番号、メールアドレス、生年月日などが該当します。さらに、マイナンバー、クレジットカード番号、銀行口座情報、基礎年金番号などの重要かつセンシティブな情報は、絶対に入力してはいけません。

個人情報保護委員会からも、生成AIサービスの利用に関する注意喚起が出されています。個人情報の取り扱いについては、こちらの公的な注意喚起もご参照ください。 https://www.ppc.go.jp/news/press/2023/230602_houdou.html

例えば、「以下の顧客リストをテーブル形式に整理して」といって、実名や連絡先が含まれたデータを貼り付けるのは非常に危険です。万が一情報が流出した場合、プライバシー侵害で訴えられるだけでなく、企業の社会的信用も地に落ちてしまいます。

文章の添削やデータ整理を行いたい場合は、必ず個人情報を架空の名称(「A氏」「B社」など)やダミーデータに置き換える「マスキング処理」を行ってから入力する癖をつけましょう。

企業の未公開情報・機密データ・社外秘の会議録

会社の業務で知り得た未公開情報は、たとえ断片的なものであっても入力してはいけません。これは就業規則や秘密保持契約(NDA)違反になる可能性が高い行為です。

具体例としては、発表前の新製品の仕様や価格、開発中の特許技術の詳細、未公開の決算数値、M&Aや業務提携に関する情報などが挙げられます。また、「議事録の要約を作りたい」という理由で、社外秘の会議の録音データや文字起こしテキストをそのまま入力するケースも散見されますが、これもNGです。

会議の中では、他社の機密情報や経営層のオフレコ発言が含まれていることが多々あります。これらを外部サーバーに送信する行為は、情報管理担当者から見れば「情報の持ち出し」と同義です。

どうしてもAIで処理したい場合は、社内専用に構築された安全な環境(Azure OpenAI Serviceなど)を利用するか、重要な固有名詞や数値を全て伏せた状態で一般的な内容として処理させる必要があります。

ID・パスワード・APIキーなどの認証情報

システムへのアクセス権限に関わる情報の入力も、セキュリティ事故に直結するため絶対に避けてください。

WebサービスのログインIDやパスワードはもちろんのこと、AWSやGoogle Cloudなどのクラウドサービスに接続するためのAPIキー、シークレットキー、アクセストークンなどがこれに当たります。

プログラマーがコードのデバッグ(修正)を依頼する際に、うっかりコードの中にAPIキーや接続パスワードをハードコーディング(直書き)したまま貼り付けてしまうミスは意外と多く発生します。

もしそのチャット履歴が第三者に見られたり、学習データとして取り込まれたりした場合、システムへの不正アクセスを許してしまうことになります。コードをレビューさせる際は、必ず認証情報の部分を「******」や環境変数のような記述に書き換えてから入力するようにしましょう。

顧客リストや取引先に関する非公開データ

自社の情報だけでなく、取引先や顧客に関する情報の取り扱いにはさらに慎重になる必要があります。顧客リスト、取引履歴、契約書の内容、商談のメモなどは、企業にとって重要な資産であり、守るべき機密情報です。

「売上分析をしたいから」といって、顧客ごとの購入履歴や属性データをChatGPTに読み込ませるのは非常にリスキーです。特定の個人が識別できないような統計データであっても、データの組み合わせによっては特定が可能になる場合もあります。

また、取引先との契約書をレビューさせる際も、相手企業名や具体的な取引金額、独自の契約条項などは削除すべきです。取引先から預かっている秘密情報を、無断で第三者(この場合はOpenAI社)のサーバーにアップロードすることは、契約違反となる可能性が高いです。

データ分析を行いたい場合は、ChatGPTの「Advanced Data Analysis(旧Code Interpreter)」のような機能を使うにしても、機密データを含まない形に加工してからアップロードする必要があります。

他者のプライバシーや著作権・商標権に関わるコンテンツ

最後に、他者の権利を侵害する恐れのあるコンテンツの入力についても触れておきます。これは自分たちが被害者になるリスクではなく、加害者になるリスクを防ぐためです。

例えば、有名人のプライベートな情報や、公になっていないスキャンダルに関する情報を入力して、それに基づいた記事や物語を作成させる行為は、名誉毀損やプライバシー侵害に当たる可能性があります。

また、著作権で保護されている他社の有料記事の全文、書籍の内容、映画の脚本などをそのまま入力し、「これをリライトして」や「続きを書いて」と指示することも著作権侵害のリスクがあります。

特定のブランドロゴや商標を意図的に含んだ画像を生成させるようなプロンプトも避けるべきです。法令遵守(コンプライアンス)の観点からも、他者の権利を尊重し、フェアユースの範囲内で利用するよう心がけてください。

今すぐやるべき!ChatGPTの安全性を高める設定と対策

ここからは、ChatGPTをより安全に利用するために、ユーザー側で今すぐ実施できる設定や対策を紹介します。

- 学習させない「オプトアウト」の設定

- 履歴を残さない「一時的なチャット」

- アカウントを守る「多要素認証(MFA)」

- 拡張機能の安全性確認

これらの設定を行うだけで、セキュリティリスクを大幅に下げることができます。

まだ設定していない項目があれば、記事を読みながらすぐに設定することをおすすめします。

会話データを学習させない「オプトアウト(学習拒否)」の設定手順

自分の入力したデータをAIの学習に使われたくない場合、最も確実な方法は「オプトアウト」の設定を行うことです。これにより、OpenAIはあなたの会話データをモデルのトレーニングに使用しなくなります。

設定方法は非常に簡単です。ChatGPTの画面左下にあるアカウント名をクリックし、「設定(Settings)」を開きます。その中にある「データコントロール(Data Controls)」という項目を探してください。

ここに「モデルの改善(Improve the model for everyone)」というような項目があれば、そのスイッチをオフにします。これだけで、以降の会話データは学習対象から除外されます。

なお、法人契約(TeamやEnterprise)の場合はデフォルトでオフになっていますが、個人アカウント(無料・Plus)の場合はデフォルトでオンになっていることが多いため、必ず確認しておきましょう。一度設定すれば基本的には維持されますが、仕様変更などでリセットされる可能性もあるため、定期的なチェックを推奨します。

履歴を残さない「一時的なチャット(Temporary Chat)」の活用

特定の会話だけ履歴に残したくない、あるいは学習されたくないという場合には、「一時的なチャット(Temporary Chat)」機能が便利です。

この機能をオンにすると、そのチャットルームでのやり取りは履歴に保存されず、ブラウザを閉じたり一定時間が経過したりするとアクセスできなくなります。また、このモードでの会話は、学習データとしても利用されません。

少しセンシティブな内容を含む相談や、ログを残す必要のない単発の作業を行う場合に最適です。画面上部のモデル選択メニューや設定メニューから「一時的なチャット」を選択することで、すぐに利用を開始できます。

ただし、履歴が残らないということは、後から「あの時の回答をもう一度見たい」と思っても復元できないことを意味します。重要な成果物が生成された場合は、チャットを閉じる前に必ず別の場所にコピーして保存しておく必要があります。

アカウント乗っ取りを防ぐ「多要素認証(MFA)」の設定

ChatGPTのアカウント自体がハッキングされてしまっては、どんなにデータ管理をしていても意味がありません。アカウントのセキュリティを強化するために、多要素認証(MFA)を必ず設定しましょう。

多要素認証を設定すると、ログイン時にパスワードだけでなく、認証アプリ(Google Authenticatorなど)に表示されるワンタイムコードの入力が必要になります。これにより、万が一パスワードが流出したとしても、第三者による不正ログインを防ぐことができます。

設定は「設定(Settings)」>「一般(General)」または「セキュリティ(Security)」の項目から行えます。最近ではフィッシング攻撃なども増えているため、面倒がらずに設定しておくことが、自分の情報を守るための生命線となります。

特に、Plusプランなどでクレジットカード情報を登録している場合や、過去のチャット履歴に重要な情報が含まれている場合は、MFAの設定は必須と言えるでしょう。

ブラウザ拡張機能や連携プラグインの安全性確認

ChatGPTの機能を拡張するために、Chromeの拡張機能や、GPTsなどのプラグインを導入している方も多いと思います。しかし、これらがセキュリティホール(抜け穴)になるケースも少なくありません。

セキュリティ団体のOWASPは、大規模言語モデルアプリケーションにおける「トップ10のリスク」を公表しています。プラグイン等の脆弱性を理解するのに役立ちます。 https://owasp.org/www-project-top-10-for-large-language-model-applications/

悪意のある開発者が作った拡張機能をインストールしてしまうと、ブラウザ上のChatGPTの画面だけでなく、他のWebサイトでの入力情報まで盗み取られるリスクがあります。

拡張機能をインストールする際は、必ず公式ストアのレビュー数や評価を確認し、信頼できる開発元であるかをチェックしてください。「便利そうだから」といって、出所不明なツールをむやみに追加するのは危険です。

また、不要になった拡張機能はこまめに削除または無効化することも重要です。定期的にインストール済みのツールを見直し、怪しい挙動をしているものがないか確認する習慣をつけましょう。

企業・組織でChatGPTを安全に利用するためのポイント

ここからは、組織としてChatGPTを導入・運用する際に押さえておくべきポイントを解説します。

- 過去の漏洩事例から学ぶ

- 社内ガイドラインの策定

- 法人向けプランの導入検討

個人利用とは異なり、組織での利用は管理責任が伴います。

安全な運用体制を構築するために、以下の項目を確認してください。

過去の漏洩事例(サムスン電子など)から学ぶ教訓

企業が生成AIを導入する際、過去の失敗事例を知ることは非常に有益です。最も有名な事例の一つに、サムスン電子での情報漏洩があります。

同社では、ChatGPTの利用を解禁した直後、半導体部門のエンジニアがソースコードの修正や会議の議事録作成のために機密データを入力してしまう事故が複数回発生しました。これにより、同社は一時的に生成AIの利用を禁止する措置をとることになりました。

この事例から学べる教訓は、「悪意がなくても情報漏洩は起こる」ということです。社員は業務効率化のために良かれと思って使っていただけであり、決して情報を盗もうとしたわけではありません。

だからこそ、単に「気をつけて」と言うだけでなく、システム的な制御や明確なルール作りが必要なのです。「どのような情報は入力して良いのか」「どこまでなら許可されるのか」を具体的に示さなければ、同様の事故はどの企業でも起こり得ます。

社内ガイドライン・利用ルールの策定(禁止事項の明確化)

組織で安全にChatGPTを利用するためには、全社員が遵守すべきガイドラインの策定が不可欠です。

企業で安全に生成AIを活用するための社内ガイドラインの作り方や、具体的な項目を盛り込んだひな形については、こちらの記事で詳しく解説しています。 合わせてご覧ください。

ガイドラインには、以下の要素を盛り込むと良いでしょう。

- 利用可能なAIツールの指定: 会社として認めているツール以外(「シャドーIT」)の利用禁止。

- 入力データの制限: 個人情報、機密情報(顧客名、未発表製品など)の入力禁止。

- オプトアウトの義務化: 学習データとして利用されない設定の徹底。

- 出力物の確認義務: 生成された内容の正確性や著作権侵害の有無を人間が確認すること。

- 事故時の報告フロー: 万が一誤った操作をした場合の連絡先の明確化。

ルールを作る際は、禁止事項ばかりを並べるのではなく、「このように使えば安全で効果的」という推奨事例も併せて提示することで、社員の活用を促進できます。また、定期的な研修を行い、リテラシーを向上させる取り組みも重要です。

日本ディープラーニング協会(JDLA)が生成AIの利用ガイドラインを公開しています。社内ルールを策定する際の雛形として非常に参考になります。 https://www.jdla.org/document/

セキュリティが強化された「Teamプラン」「Enterpriseプラン」の導入検討

従業員数が多い場合や、より高度なセキュリティが必要な場合は、個人版のChatGPTではなく、法人向けの「Teamプラン」や「Enterpriseプラン」の導入を強く推奨します。

これらのプラン最大の特徴は、「入力データが学習に使用されないことが保証されている」点です。社員が個別に設定変更をする必要がなく、組織全体としてデータ保護の基盤を整えることができます。

また、管理者がユーザーのアクセス権限を一元管理できたり、利用ログを監査できたりする機能も備わっています。さらに、「ChatSense」のような法人向けのラッパーサービス(ChatGPTのAPIを利用した安全なチャットツール)を導入する企業も増えています。

コストはかかりますが、情報漏洩事故が起きた際の損害賠償やブランド毀損のリスクを考えれば、必要な投資と言えるでしょう。自社のセキュリティポリシーに合致したプラン選定を行ってください。

ChatGPTの安全性に関するよくある質問(FAQ)

最後に、ChatGPTの安全性に関してよく寄せられる質問とその回答をまとめました。

- スマホアプリ版の安全性

- 情報漏洩した時の対応

- サイバー攻撃への悪用リスク

これらの疑問を解消し、安心して利用できる状態を目指しましょう。

スマホアプリ版の安全性はWeb版と変わらない?

基本的に、iOSやAndroidで提供されている公式のChatGPTアプリの安全性は、Webブラウザ版と同等です。通信は暗号化されており、OpenAIの同じセキュリティ基準の下で運用されています。

ただし、スマホならではのリスクとして「画面の盗み見(ショルダーハッキング)」や「端末の紛失」があります。外出先や公共交通機関などで利用する際は、背後からの視線に注意が必要です。

また、アプリには「音声会話モード」などの独自機能もありますが、周囲に会話を聞かれるリスクも考慮しなければなりません。公衆の場での利用には、Web版以上に物理的なセキュリティへの配慮が必要です。もちろん、アプリ版でもオプトアウト設定やMFA設定は有効ですので、必ず設定しておきましょう。

入力した情報が漏洩した可能性がある場合どうすればいい?

万が一、機密情報を誤って入力してしまったことに気づいた場合は、直ちに対処が必要です。

まず、個人アカウントで履歴が残る設定にしていた場合、そのチャット自体を削除してください。ただし、すでに送信されたデータが学習データとして取り込まれるプロセスに入っている可能性は否定できません。

企業で利用している場合は、速やかにセキュリティ担当部署や上長へ報告してください。「怒られるのが怖い」と隠蔽することが最悪の結果を招きます。何を入力したか、いつ送信したかを正確に伝えることで、企業側としてのリスク評価や対策が可能になります。

また、OpenAIのサポート窓口へ削除依頼(User Content Opt Out Requestなど)を出すことも検討できますが、即時削除が保証されるわけではないため、やはり「予防」が最善の策です。

ウイルス作成やフィッシングメールに使われる危険性は?

「ChatGPTが悪意のあるハッカーに使われるのではないか」という懸念もあります。実際、リリース初期には、ウイルスコードの作成や巧妙なフィッシングメールの文面作成に悪用される事例が報告されました。

しかし、OpenAIも対策を進めており、現在のGPT-5や最新のGPT-5.2では、有害な目的での利用を拒否するガードレール機能が強力に働いています。「ウイルスを作って」と指示しても、「そのようなリクエストにはお答えできません」と拒否されるようになっています。

とはいえ、攻撃者も「脱獄(ジェイルブレイク)」と呼ばれる特殊なプロンプトを使って制限を回避しようと試みています。いたちごっこの状態ではありますが、AI自体の防御力は日々向上しています。私たちユーザーとしては、AIが悪用されるリスクを理解しつつ、自分自身もAIを利用した詐欺などに騙されないよう警戒心を持つことが大切です。

【警告】あなたの会社は「情報漏洩」予備軍?ChatGPTで組織を危険に晒すNG行動

ChatGPTを業務でなんとなく使っているあなた、その使い方は会社の命運を揺るがす「時限爆弾」かもしれません。実は、何気ないコピー&ペーストが、企業の最重要機密を世界中にばら撒く行為になり得ることをご存知でしょうか。実際に、世界的な大企業であるサムスン電子では、社内のエンジニアがソースコードや会議の議事録をChatGPTに入力してしまい、機密情報が流出するという痛ましい事故が起きています。この記事では、あなたの組織が知らず知らずのうちに陥っているかもしれない「セキュリティの落とし穴」と、それを回避して安全にAIを活用するための鉄則を、最新の事例と設定方法を交えて徹底解説します。

「便利だから」では済まされない!入力データが「全世界の知識」になる恐怖

もしあなたが、初期設定のままのChatGPTに「この契約書をチェックして」「来期の未発表製品のPR文を書いて」と入力していたら、それは赤信号です。OpenAIの仕様上、デフォルト設定(特に無料版やPlus版)では、ユーザーとの会話データはAIの再学習に利用される可能性があります。

これはつまり、あなたが入力した社外秘の情報が、巡り巡って競合他社の社員が使うChatGPTの回答として出力されてしまうリスクがあることを意味します。

特に以下の3つは、絶対に入力してはいけない「漏洩情報のトップ3」です。

- 個人を特定できる情報:顧客リストやマイナンバーなど、一度流出すれば法的責任を問われます。

- 未公開の機密データ:新製品のスペックやM&A情報など、企業の競争力を左右する情報です。

- システム認証情報:APIキーやパスワードなどは、悪用されればシステム全体が乗っ取られます。

セキュリティ意識の低い利用は、会社の門を全開にして泥棒を招き入れているのと同じことです。

引用元:

サムスン電子では、ChatGPTの導入直後に半導体部門の設備情報の流出など計3件の情報漏洩事故が発生しました。これを受け、同社は生成AIの利用を一時的に制限する措置を取りました。(Bloomberg, “Samsung Bans Staff’s AI Use After Spotting ChatGPT Leak” 2023年)

【実践】鉄壁の守りで攻める!セキュリティリスクをゼロにする最強の設定術

では、セキュリティ意識の高い「賢い組織」はどのようにChatGPTを運用しているのでしょうか?彼らはAIを「ただの便利ツール」ではなく、「安全な防弾ガラス越しに操作する兵器」として扱っています。ここでは、誰でもすぐに実践できる、情報漏洩を防ぐための具体的なテクニックを2つご紹介します。

対策①:データの蛇口を閉める「オプトアウト」設定

最も簡単かつ効果的なのは、データ学習を拒否する設定(オプトアウト)を行うことです。

設定の手順:

ChatGPTの設定画面から「データコントロール」を開き、「モデルの改善(Chat History & Training)」をオフにするだけです。

たったこれだけの操作で、あなたの会話内容はAIの学習データから除外されます。また、一時的な利用であれば「Temporary Chat」機能を使うのも有効です。このモードでは履歴が残らず、学習も行われないため、機密性の高い作業をする際の安全なサンドボックスとして機能します。

対策②:情報は「マスキング」してから渡す

どうしても実際のデータを使って分析や添削をさせたい場合は、固有情報を伏字にする「マスキング」を徹底しましょう。

賢いプロンプト例:

「以下の文章の[A社]と[B氏]に関する取引内容について、法的リスクを指摘してください。※固有名詞はダミーです」

このように、企業名や個人名、具体的な数値を「A社」「○○プロジェクト」のように置き換えてから入力することで、万が一データが学習されたとしても、意味のない情報として処理させることができます。これに加え、企業レベルでは「Enterpriseプラン」のような、入力データが学習されないことが保証された法人契約を結ぶことが、組織を守る最終防衛ラインとなります。

まとめ

生成AIの活用は企業の生産性を劇的に向上させる可能性を秘めていますが、一方で情報漏洩やセキュリティリスクへの不安から、導入に二の足を踏む企業も少なくありません。

「社員全員にセキュリティ設定を徹底させるのは難しい」「安全な環境構築にはコストと時間がかかる」といった課題が、DX推進の足かせになっているのが現状です。

そこでおすすめしたいのが、Taskhub です。

Taskhubは、企業が生成AIを安全かつ即座に業務利用できるように設計された、国内最大級の生成AI活用プラットフォームです。

Azure OpenAI Serviceを基盤としたセキュアな環境を採用しているため、入力したデータがAIの学習に利用されることは一切なく、機密情報を取り扱う業務でも安心して利用できます。

さらに、Taskhubなら「メール作成」「議事録要約」「契約書チェック」など、業務ごとに最適化された200種類以上のAIタスクがあらかじめアプリとして用意されています。

これにより、従業員は複雑なプロンプトやセキュリティ設定を意識することなく、直感的な操作で安全に成果を出すことができます。

また、導入企業には専任のAIコンサルタントによるガイドライン策定支援や活用サポートが付帯するため、セキュリティリテラシーに不安がある組織でもスムーズな運用開始が可能です。

まずは、Taskhubのセキュリティ仕様や具体的な活用シーンをまとめた【サービス詳細資料】を無料でダウンロードしてください。

Taskhubで“鉄壁のセキュリティ”と“最高の業務効率”を両立し、御社のビジネスを安全に加速させましょう。