「LTX-2を使えば映画のような動画が作れるらしいけど、導入が難しそう…」

「ロースペックなPCでも動かせるの?具体的な設定方法を知りたい。」

こういった悩みを持っている方もいるのではないでしょうか?

本記事では、最新のオープンソース動画生成AI「LTX-2」の導入手順から、ComfyUIを使った具体的なワークフロー、クオリティを高めるためのプロンプト術について解説しました。

動画生成AIの導入支援を行っている弊社が実際に検証したノウハウのみをご紹介します。

きっと役に立つと思いますので、ぜひ最後までご覧ください。

LTX-2(Lightricks)とは?次世代動画生成AIの特徴

ここからは、Lightricks社が開発した最新モデル「LTX-2」の概要と、なぜこれほど注目されているのかを3つのポイントで解説します。

- 音声と動画の同時生成能力

- 圧倒的な生成スピードと軽量性

- オープンソースによる自由度の高さ

LTX-2の特徴を正しく理解することで、自分の制作環境に最適な導入方法が判断できるようになります。

LTX-2の開発元であるLightricks Researchの公式サイトでは、モデルの概要やデモ映像が公開されています。技術的な背景に興味がある方は合わせてご確認ください。https://www.lightricks.com/career/researcher

それでは、1つずつ順に解説します。

従来の動画生成AIと比較したLTX-2の強み

LTX-2が従来の動画生成モデルと決定的に異なる点は、動画と音声を同時に生成できる「マルチモーダル能力」にあります。これまでの生成AIでは、映像を作った後に別のAIで効果音やBGMを生成・合成する手間が必要でしたが、LTX-2はその工程を一度に完結させることが可能です。また、ネイティブで4K解像度に対応しており、最大50fpsの滑らかな映像を出力できる点も大きな強みです。Runway Gen-3やSoraといったクローズドなモデルに匹敵するクオリティを、ローカル環境で実現できる点がクリエイターから支持されています。

比較に上がったSoraの最新モデルについては、こちらの記事で詳しく解説しております。合わせてご覧ください。

リアルタイム性と生成スピードの進化

動画生成AIの課題であった「生成時間の長さ」を大幅に短縮したのもLTX-2の特徴です。DiT(Diffusion Transformer)アーキテクチャを採用しつつ、モデル構造を効率化することで、推論速度が劇的に向上しました。例えば、適切なGPU環境があれば、数秒の動画を生成するのに数分待つ必要はなく、ほぼリアルタイムに近い感覚で試行錯誤が可能になります。これにより、プロンプトを少しずつ変えながら理想の映像を追求する「イテレーション」の回数を増やせるため、結果として成果物のクオリティアップにつながります。

LTX-Videoの技術的な詳細やアーキテクチャについては、公開されている論文(ArXiv)でより深く学ぶことができます。 https://arxiv.org/abs/2501.00103

商用利用は可能?ライセンス情報の解説

LTX-2の最大のアドバンテージは、Apache License 2.0という非常に自由度の高いライセンスで公開されている点です。これは、個人利用はもちろんのこと、商用利用も認められていることを意味します。企業のプロモーション動画や、YouTubeの収益化動画の素材として利用しても法的なリスクが低い(※生成されるコンテンツ自体の著作権侵害チェックは別途必要)ため、ビジネス用途での導入が加速しています。他の高性能モデルが月額課金のサブスクリプション形式であることが多い中、一度環境を構築すれば追加コストなしで使い続けられる点は経済的にも大きなメリットです。

LTX-2を動かすための推奨PCスペック

ここからは、LTX-2を快適に動作させるために必要なPCスペックについて解説します。

- GPUの選び方とVRAM容量

- メモリ不足への対処法

VRAM容量は動画生成の安定性に直結するため、導入前に必ず確認しておきたいポイントです。

それでは、1つずつ順に解説します。

快適に動作させるために必要なGPUとVRAM容量

LTX-2をローカル環境でフル活用するためには、NVIDIA製のGPUがほぼ必須となります。公式の推奨スペックやコミュニティでの検証結果によると、快適に動作させるためのVRAM(ビデオメモリ)容量は24GB以上が理想的です。具体的にはGeForce RTX 3090やRTX 4090などが該当します。これだけの容量があれば、1080p以上の高解像度生成や、長時間の動画生成でもエラー落ちすることなく安定して動作します。16GBクラスのGPU(RTX 4080など)でも動作はしますが、解像度や秒数に制限をかける工夫が必要になります。

VRAMが足りない場合の軽量化策(量子化モデル)

手持ちのPCがVRAM 8GBや12GB(RTX 3060や4070など)の場合でも、LTX-2を諦める必要はありません。「量子化(Quantization)」されたモデルを使用することで、VRAM使用量を大幅に削減可能です。例えば、標準のfp16(16ビット浮動小数点)モデルではなく、fp8(8ビット)やGGUF形式の軽量化モデルを利用することで、12GBのVRAMでも720p程度の動画生成が可能になります。ComfyUIの設定で --fp8_e4m3fn などの引数を追加するか、軽量化済みのチェックポイントファイルをダウンロードして使用することをおすすめします。

LTX-2をローカル環境(ComfyUI)に導入する手順

ここからは、実際にComfyUIを使ってLTX-2を導入する具体的なステップを紹介します。

- モデルファイルの準備

- カスタムノードのインストール

- ワークフローの読み込み

ComfyUIはノードベースで複雑に見えますが、手順通りに進めれば誰でも導入可能です。

それでは、1つずつ順に解説します。

必要なモデルファイル(Checkpoints)のダウンロードと配置

まずは、Hugging FaceなどのリポジトリからLTX-2のモデル本体をダウンロードします。通常は数GBから十数GBのサイズになるため、安定した回線で行ってください。ダウンロードすべきファイルは主にメインの .safetensors ファイルです。ダウンロードが完了したら、ComfyUIのインストールフォルダ内にある models/checkpoints フォルダ、または models/ltx_video などの指定フォルダに移動させます。フォルダ構成は使用するカスタムノードによって微妙に異なる場合があるため、ノードの説明書(Readme)を確認するのが確実です。

モデルファイルはHugging Faceの公式リポジトリからダウンロード可能です。こちらのページから「Files and versions」タブを開き、必要なファイルを入手してください。 https://huggingface.co/Lightricks/LTX-Video

ComfyUI Managerを使ったカスタムノードのインストール

ComfyUIを起動し、「ComfyUI Manager」を開きます。エラーを防ぐためにまずは「Update ComfyUI」で本体を最新にし、その後「Install Custom Nodes」メニューで検索バーに「LTX」または「LTXVideo」と入力して検索します。検索結果に出てくる「ComfyUI-LTXVideo」やそれに類する推奨ノードパックの「Install」ボタンをクリックし、インストール完了後にComfyUIを再起動します。これにより、LTX-2を動かすために必要な専用ノードがメニューに追加され、ワークフロー上で呼び出せるようになります。

ComfyUI Managerの導入がまだの方は、公式リポジトリからインストールしておきましょう。これがあるとノード管理が格段に楽になります。 https://github.com/ltdrdata/ComfyUI-Manager

【コピペOK】基本のワークフロー(JSON)の読み込み方

ノードを一から繋ぐのは大変なので、配布されているワークフロー用JSONファイルを利用するのが効率的です。LTX-2の公式リポジトリや、有志が公開しているComfyUI用ワークフロー(.jsonファイル)またはメタデータ付きのPNG画像をダウンロードします。ComfyUIの画面上にそのファイルをドラッグ&ドロップするだけで、必要なノードが自動的に配置され、線が繋がった状態になります。あとは「Load Checkpoint」ノードでモデルを選択し、音声も出力されるよう「Audio Save」ノードが正しく接続されているか確認すれば、準備は完了です。

公式の推奨ワークフロー(JSON)は、GitHubリポジトリ内の「examples」フォルダなどから入手できます。これを読み込むのが確実です。 https://github.com/Lightricks/ComfyUI-LTXVideo

エラーが出る場合のよくある原因と対処法

導入時によくあるエラーとして、「ノードが見つからない(赤く表示される)」というものがあります。これはManagerでのインストール忘れか、ComfyUI自体のバージョンが古いことが原因です。Managerの「Install Missing Custom Nodes」をクリックして不足分を補うか、ComfyUI本体を最新版にアップデートしてください。また、生成ボタンを押した直後にエラーが出る場合は、VRAM不足の可能性があります。その際は、解像度設定を低くするか、一度ComfyUIを再起動してGPUメモリをクリアにしてみてください。

クオリティを劇的に上げるLTX-2の推奨設定

ここからは、生成される動画の品質をワンランクアップさせるための設定値を3つ紹介します。

- サンプラーの選択

- FPSとステップ数の調整

- アップスケーリングの手法

デフォルト設定のままでも生成はできますが、ここの微調整で映像の説得力が大きく変わります。

それでは、1つずつ順に解説します。

画質と速度のバランスが良いサンプラー(Sampler)設定

LTX-2において、サンプラー(Sampler)とスケジューラー(Scheduler)の選択は映像の質感に大きく影響します。検証の結果、バランスが良いのは euler または dpmpp_2m_sde と karras の組み合わせです。これらは比較的少ないステップ数でも破綻の少ない映像を生成できます。もし映像がちらつく場合や、ノイズが乗る場合は、サンプラーを ddim に変更してみるのも手です。ただし、ddim は計算コストが高くなる傾向があるため、生成時間との兼ね合いを見ながら調整してください。

FPSとステップ数の最適な組み合わせ

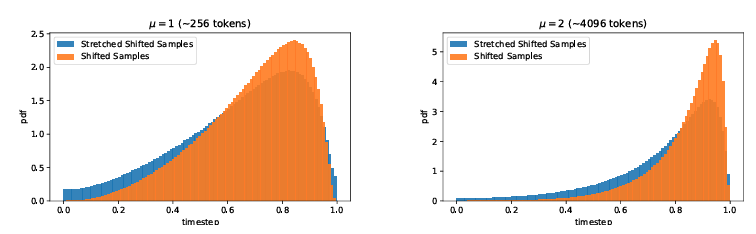

滑らかな動画にするためにはFPS(フレームレート)の設定が重要です。映画のような質感を求めるなら24fps、ヌルヌル動くリアルな映像なら50fpsや60fpsに設定します。ただし、FPSを上げると生成すべきフレーム数が増えるため、VRAM消費量が増大します。ステップ数(Steps)に関しては、通常モデルなら20〜30程度が目安です。ただし「Turbo」や「Distilled」等の高速モデルを使用する場合は、8〜10ステップでも十分高画質な生成が可能です。最初は「24fps / 25 steps」を基準にして調整を始めると良いでしょう。

4K高解像度化するためのアップスケーリング手順

LTX-2はネイティブ4Kに対応していますが、最初から4Kで生成するのはVRAMへの負荷が大きすぎます。おすすめの手順は、まず低解像度(例えば720pや1024×576など)で動画を生成し、構図や動きを確認することです。良い結果が得られたら、ComfyUI内の「Video Upscale」ノードや、外部ツールを使って4Kにアップスケーリングします。特にComfyUI内で使える「NNLatentUpscale」やControlNetのTile機能、あるいは別途「Topaz Video AI」などの専用ソフトを組み合わせることで、ディテールを損なわずに鮮明な4K動画仕上げることができます。

意図通りの動画を作るLTX-2プロンプトのコツ

ここからは、LTX-2で思い通りの映像を作るためのプロンプト作成テクニックを3つ紹介します。

- カメラワークの指定

- ネガティブプロンプトの活用

- AIによるプロンプト具体化

動画生成特有の指示出しをマスターすることで、ガチャ(運任せの生成)の確率を下げることができます。

それでは、1つずつ順に解説します。

動画の「動き」を正確に制御するカメラワークの指示語

静止画と違い、動画プロンプトでは「カメラがどう動くか」の指示が不可欠です。プロンプトの冒頭や文末に、以下のようなカメラ用語を追加してください。「Slow zoom in(ゆっくりズームイン)」「Pan right(右にパン)」「Drone shot tracking the subject(被写体を追尾するドローン撮影)」「Static camera(固定カメラ)」。これらを入れることで、AIは映像にどのような動きをつけるべきかを理解します。特にLTX-2は物理的な動きの理解度が高いため、指示を入れるだけで映像のダイナミズムが劇的に向上します。

被写体の破綻を防ぐネガティブプロンプトの記述

動画生成では、時間が経過するとともに顔が崩れたり、手足が増えたりする現象が起きがちです。これを防ぐためにネガティブプロンプトを活用します。一般的に有効なのは「morphing(変形), distortion(歪み), bad anatomy(崩れた解剖学), blurry(ぼやけ), shaky camera(手ブレ), text, watermark」などです。これらを常に入れておくことで、映像の安定性が増し、最後まで見やすい動画を生成できるようになります。ComfyUIのワークフローでは、専用のテキストボックスにこれらを入力して接続します。

ChatGPTを活用して指示を具体化するテクニック

自分の頭の中にあるイメージを英語のプロンプトに変換するのが難しい場合は、ChatGPT(GPT-5.2)を活用しましょう。最新のGPT-5.2は「思考制御の最適化」により、指示の意図を深く汲み取る能力が強化されています。例えば「〇〇なシーンの動画を作りたい。LTX-2用の英語プロンプトにして。カメラワークや照明の指示も含めて、具体的かつ描写的に書いて」と依頼します。GPT-5.2は文脈ズレが減少しているため、複雑なシーン設定でも的確な英語プロンプトを出力してくれます。これをコピペしてLTX-2に入力するのが最短ルートです。

ChatGPTで動画を生成する際のプロンプトはこちらの記事を参考にしてみてください。

LTX-2の実践的な応用テクニック

ここからは、基本的な生成に慣れた方向けの応用テクニックを3つ紹介します。

- Image to Videoの活用

- LoRAによる画風固定

- クラウド環境での試行

これらを使いこなすことで、実務レベルの映像制作が可能になります。

それでは、1つずつ順に解説します。

画像から動画を生成する(Image to Video)の設定

テキストから動画を作る(Text to Video)だけでなく、既存の画像を動かす(Image to Video)機能も強力です。MidjourneyやFluxなどで生成した高品質な画像を「Load Image」ノードで読み込み、LTX-2に入力として渡します。この際、プロンプトには画像の内容を説明しつつ、どう動いてほしいか(例:The girl smiles and turns her head)を記述します。開始フレームの画質が保証されるため、キャラクターの顔や衣装のデザインを固定したまま動画化したい場合に最適な手法です。

特定の画風やキャラを固定するLoRAの活用方法

LTX-2はオープンソースモデルであるため、世界中のクリエイターが作成したLoRA(追加学習データ)を利用できます。

LoRAとは

低ランク適応(LoRA)は、機械学習モデルを新しいコンテキストに適応させるために使用される手法です。モデル全体を変更するのではなく、元のモデルに軽量の部分を追加することで、大規模なモデルを特定の用途に適応させることができます。データサイエンティストは、まったく新しいモデルを構築する必要がなく、モデルの使用方法を迅速に拡張できます。

引用元:https://www.ibm.com/jp-ja/think/topics/lora

アニメ調、実写映画調、特定のカメラエフェクトなど、目的に合ったLoRAをダウンロードし、ComfyUIの「Load LoRA」ノードで適用します。強さ(Strength)を0.6〜0.8程度に調整して混ぜ合わせることで、ベースモデルの性能を維持しつつ、独自の雰囲気を持った映像を作り出すことができます。CivitaiなどのサイトでLTX-2対応のLoRAを探してみましょう。

クラウド環境(Fal.ai / Replicate)でLTX-2を試す方法

高性能なGPUを持っていない場合や、外出先で生成したい場合は、クラウドサービスの利用がおすすめです。Fal.aiやReplicateといったプラットフォームでは、LTX-2がすでにセットアップされており、API経由やWebブラウザ上で手軽に利用できます。1生成あたり数円〜数十円程度の従量課金になりますが、環境構築の手間が一切なく、最新のH100 GPUなどの爆速環境で生成できるメリットがあります。ローカル環境構築前のテストとして利用するのも賢い方法です。

fal.aiでは、ブラウザ上でパラメータを調整しながらLTX-Videoを試すことができます。環境構築前に試してみたい方におすすめです。 https://fal.ai/models/fal-ai/ltx-video

また、Replicateでも同様にデモ環境が公開されており、API経由での利用も可能です。 https://replicate.com/lightricks/ltx-video

LTX-2に関するよくある質問(FAQ)

最後に、LTX-2についてよく寄せられる質問に回答します。

- 言語対応について

- 他モデルとの違い

- Macでの動作

疑問を解消して、スムーズに動画生成を始めましょう。

それでは、1つずつ順に解説します。

日本語のプロンプトでも生成できますか?

基本的には英語でのプロンプト入力が推奨されます。LTX-2は主に英語のデータセットで学習されているため、日本語で指示を出すと意図が正確に伝わらなかったり、無視されたりすることがあります。もし英語が苦手な場合は、前述の通りChatGPTやDeepLなどの翻訳ツールを使って、日本語の指示を詳細な英語プロンプトに変換してから入力するのが確実です。簡単な単語であれば日本語でも反応することはありますが、クオリティを求めるなら英語一択です。

SoraやRunway Gen-3との違いは何ですか?

最大の違いは「オープンかクローズドか」です。SoraやRunway Gen-3は開発元が提供するWebサイト上でしか利用できず、詳細なパラメータ調整や外部ツールとの連携に制限があります。一方、LTX-2はモデル自体が公開されているため、自分のPC(ローカル環境)で無制限に生成でき、検閲なども基本的にはありません。また、ComfyUIを使って他のAIツールと複雑に連携させたり、独自のワークフローを構築したりできる拡張性の高さも、LTX-2ならではのメリットです。

Runway Gen-3については、こちらの記事で解説しております。合わせてご覧ください。

Mac(Apple Silicon)でも動作しますか?

M1、M2、M3チップなどを搭載したApple Silicon Macでも動作は可能です。ComfyUIはMacのGPUアクセラレーション(Metal/MPS)に対応しているため、適切なセットアップを行えば動きます。ただし、NVIDIA製のGPUを搭載したWindows PCに比べると、生成速度は数倍〜十倍近く遅くなる傾向があります。本格的に動画生成を行いたい場合は、WindowsのデスクトップPCを用意するか、MacからクラウドGPUサービスに接続して利用する方法を推奨します。

【警告】「動画生成AI=魔法の杖」と思っていませんか?クリエイターを淘汰する「思考停止」の罠

LTX-2のような高性能な動画生成AIが登場し、誰もが映画のような映像を作れる時代が到来しました。しかし、ここで一つ残酷な事実をお伝えしなければなりません。ハーバード・ビジネス・スクール等の研究グループが行った調査によると、AIの能力に過度に依存したクリエイターは、短期的には生産性が向上するものの、長期的には作品の「独自性」や「多様性」が著しく低下するリスクがあることが示唆されています。

ツールが高性能になればなるほど、私たちは「AIが出してきたそれっぽい映像」に満足してしまいがちです。これは脳が楽をしようとする「認知的節約」の一種であり、結果として、市場には似たり寄ったりの「平均点」のコンテンツが溢れかえることになります。「きれいな動画を作ること」自体には、もはや価値がなくなろうとしているのです。

引用元:

AIの導入による創造性への影響に関する実験では、AI支援を受けたグループは集合的に似通ったアイデアを出す傾向があり、コンテンツの均質化を招く可能性が指摘されています。(Doshi, A. R., & Hauser, O. “Generative AI enhances individual creativity but reduces the collective diversity of novel content”, 2023年)

【実践】AIを「下請け」ではなく「監督の右腕」にするプロの演出術

では、AI時代に生き残る「賢いクリエイター」はLTX-2をどう扱っているのでしょうか。彼らはAIを単なる生成機としてではなく、自分の演出意図を具現化するための「高度なシミュレーター」として利用しています。記事で紹介されていたComfyUIや詳細なパラメータ設定は、まさにそのための操縦桿です。

例えば、多くの人が「美しい女性が歩いている」といった単純なプロンプトで満足する中で、プロフェッショナルは「カメラワーク」と「ネガティブプロンプト」を駆使して、映像に意図を宿らせます。「Slow zoom in(ゆっくりズームイン)」や「Static camera(固定カメラ)」といった指示は、AIに対して「私の目はこう動く」と教える行為です。また、意図しない変形を防ぐためにネガティブプロンプトを徹底することは、偶然に頼らず、必然のクオリティを担保しようとする意志の表れです。

技術の壁を越えた先に待つ「自由」を手に入れる

LTX-2の真価は、オープンソースであり商用利用が可能(Apache License 2.0)である点にあります。これは、月額課金のサービスに依存する「消費者」から、自らの環境で資産を生み出す「生産者」へと進化できることを意味します。

確かに、記事にあるように環境構築やGPUの選定、英語プロンプトの作成といったハードルは存在します。しかし、それらを乗り越え、自分の手元に制御可能なAIスタジオを持つことは、プラットフォームの規約変更や値上げに怯えることなく、永続的に創作活動を続けるための最強の防衛策となります。エラーに対処し、試行錯誤(イテレーション)を繰り返すプロセスそのものが、AI時代における核心的なスキルセットとなるのです。

まとめ

企業は労働力不足や業務効率化の課題を抱える中で、生成AIの活用がDX推進や業務改善の切り札として注目されています。

しかし、実際には「どこから手を付ければいいかわからない」「社内にAIリテラシーを持つ人材がいない」「高性能なPC環境を用意できない」といった理由で、導入のハードルが高いと感じる企業も少なくありません。

そこでおすすめしたいのが、Taskhub です。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、高度な動画生成AIの活用はもちろん、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「何をどう使えばいいのかわからない」という初心者企業でも安心してスタートできます。

導入後すぐに効果を実感できる設計なので、複雑なプログラミングや高度なAI知識、高価なGPU環境がなくても、すぐに業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最速の生成AI活用”を体験し、御社のDXを一気に加速させましょう。