「ChatGPTを使うと電気代が上がるって本当?」

「AIの便利な機能の裏側で、どれくらいの電力が使われているんだろう?」

こういった悩みを持っている方もいるのではないでしょうか?

本記事では、ChatGPTが1回の質問で消費する電気代の目安から、その電力消費の仕組み、そして個人や企業が今日から実践できる具体的なコスト節約術までを詳しく解説します。

AIとエネルギー問題に関する最新の動向も踏まえて、専門家が分かりやすく説明しますので、ぜひ最後までご覧ください。

ChatGPTの電気代、一体どれくらい?

ChatGPTを個人で利用する際に、自宅の電気代が急激に上がることはありません。

しかし、そのサービスを提供しているデータセンターでは、私たちの想像を絶するほどの膨大な電力が消費されています。

ここでは、ChatGPTの利用がいかに大きなエネルギーを必要とするか、具体的なデータと共に見ていきましょう。

1回の質問で消費する電力の目安は?Google検索と比較

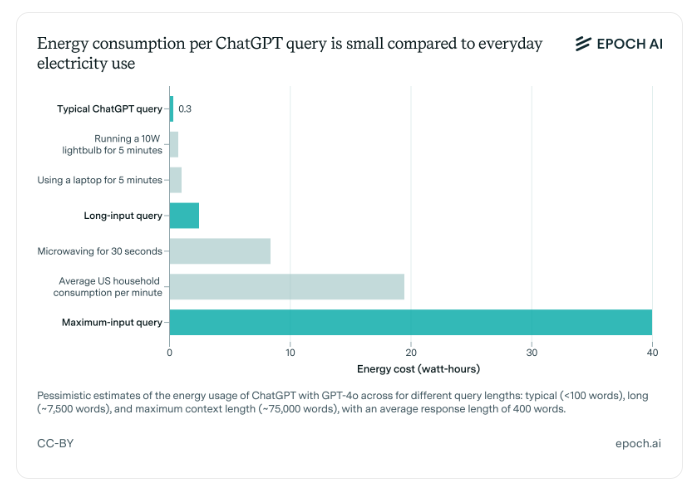

ChatGPTへの1回の質問(プロンプト)で消費される電力は、約2.9ワット時(Wh)に達するという試算があります。

これは、私たちが日常的に使うGoogle検索1回あたりの消費電力(約0.3Wh)と比較すると、およそ10倍ものエネルギーに相当します。

この大きな差は、ChatGPTが単に情報を検索するのではなく、入力された指示を理解し、複雑な計算を経て、人間のように自然な文章を「生成」するという、高度な処理を行っているために生じます。

データセンター全体では米国家庭数万世帯分に匹敵

ChatGPTを動かしている単一のデータセンターが消費する電力は、アメリカの一般家庭、数万世帯分の年間電力消費量に匹敵すると言われています。

AIモデルの性能向上と世界的な利用者数の増加に伴い、この電力消費量は今後も増え続けると予測されています。

私たちの生活を豊かにするAI技術は、地球規模のエネルギー消費という大きな課題と隣り合わせなのです。

なぜChatGPTは多くの電力を消費するのか?

ChatGPTが大量の電力を必要とする背景には、AIモデルの「学習」と「推論」という2つの重要なプロセスと、それを支える巨大なインフラの存在があります。

この仕組みを理解することで、AIと電力問題の関係性をより深く知ることができます。

AIの「学習」と「推論」で電力が消費される

AIが人間のように賢く振る舞うためには、インターネット上の膨大なテキストデータを読み込ませる「学習(トレーニング)」というプロセスが不可欠です。この学習段階では、AIは天文学的な回数の計算を繰り返し、莫大な電力を消費します。

そして、私たちがChatGPTに質問を投げかけると、AIは学習した知識を基に答えを導き出す「推論(インファレンス)」という処理を行います。

この推論プロセスでも、質問の意図を汲み取り、適切な単語を繋ぎ合わせて回答を生成するために、その都度多くの計算が行われ、電力が消費されていくのです。

高性能サーバーと冷却設備に莫大なコストがかかる

ChatGPTのような大規模言語モデル(LLM)の運用には、AIの計算処理に特化したGPU(Graphics Processing Unit)という半導体を搭載した、極めて高性能なサーバーが数万台規模で必要です。これらのサーバーは常にフル稼働状態で膨大な計算を行うため、大量の熱を発生させます。

サーバーが熱で故障したり性能が低下したりするのを防ぐには、データセンター全体を24時間365日、一定の低い温度に保つための強力な冷却設備が欠かせません。

この高性能サーバーの稼働電力と、発生した熱を冷ますための冷却システムの維持に、莫大な電力が使われているのです。

【個人でできる】ChatGPTの電気代を節約するプロンプト術7選

私たちが日々ChatGPTを使う際に、少し工夫するだけでAIの計算量を減らし、間接的に電力消費を抑えることができます。

これは、より効率的な指示(プロンプト)を送ることで実現可能です。

AI、特に大規模言語モデル(LLM)からに望んだ答えを出させるプロンプトエンジニアリングについては、こちらの記事をご覧ください。

ここでは、個人で簡単に実践できる7つのプロンプト術を紹介します。

①具体的かつ明確な指示を出す

AIへの指示は、曖昧な表現を避け、できるだけ具体的で明確にすることが重要です。

例えば、「面白い話」とお願いするよりも、「小学生が笑えるような、動物が主人公の短い物語を作成して」と具体的に指示する方が、AIは的を絞って回答を生成できるため、無駄な思考や計算を減らせます。

求める回答の条件を細かく指定することが、AIの省エネに繋がります。

②不要な言葉を省き、簡潔にする

プロンプトは、できるだけ簡潔に、要点を絞って記述しましょう。

丁寧すぎる前置きや、冗長な修飾語は、AIが指示の核心を理解する上でノイズとなり、余計な計算をさせてしまう原因になります。

「大変恐縮ですが、日本の首都について教えていただけますでしょうか?」と尋ねるよりも、「日本の首都は?」と端的に質問する方が、AIは迅速かつ効率的に回答できます。

シンプルさが、エネルギー効率を高める第一歩です。

③役割(例:編集者、プログラマー)を与える

ChatGPTに特定の専門家としての「役割」を与えることで、回答の精度が向上し、何度もやり取りを重ねる手間を省けます。

文章の校正を依頼するなら、「あなたはプロの編集者です。以下の文章の誤字脱字を修正し、より自然な表現にしてください」と指示します。

AIに特定の専門家としての役割を与える手法は「ロールプロンプティング」と呼ばれます。

こちらは、ロールプロンプティングを活用した「シュンスケ式プロンプト」ついて解説した記事です。合わせてご覧ください。

④出力形式(箇条書き、表など)を指定する

回答に求めるアウトプットの形式をあらかじめ指定することも、AIの計算量を減らす上で非常に有効です。

複数の選択肢を比較したい場合、「製品Aと製品Bのメリット・デメリットを、表形式でまとめてください」と指示すれば、AIは情報を整理しやすくなり、冗長な文章の生成を避けられます。

箇条書きや番号付きリストなど、目的に応じた形式指定が省エネにつながります。

⑤関連する質問は一度にまとめる

いくつかの関連する質問がある場合は、一つずつ聞くのではなく、一度のプロンプトにまとめてしまいましょう。

「日本の首都は?」と質問し、その答えを見てから「その都市の人口は?」と再度質問するよりも、「日本の首都の名前と、その都市の人口を教えてください」と一度に尋ねる方が、AIは文脈を維持したまま効率的に処理を行えます。

対話の回数を減らすことが、トータルの消費電力を抑えることに繋がります。

⑥単純なタスクにはより軽量なモデルを使う

文章の要約やメールの下書き、簡単なアイデア出しといった比較的単純なタスクであれば、必ずしも最高性能のモデルを使う必要はありません。

より軽量で処理速度の速いモデル(例えば無料プランで利用できるモデル)を選択することで、消費電力を大きく削減できます。

タスクの難易度に応じて適切なツールを使い分ける意識が、賢いAI利用のポイントです。

⑦API利用でモデルを最適化する

開発者や企業は、APIを利用して、より専門的なタスクにAIを組み込むことができます。

その際、タスクの目的に合わせて最適なAIモデルを選択することが重要です。

例えば、OpenAIが提供するAPIでは、最高性能の「gpt-5」から、低コストな「gpt-5-mini」、最速の「gpt-5-nano」まで、複数のモデルが用意されています。

単純な応答でよければ軽量なモデルを選ぶことで、コストとエネルギー消費を大幅に抑えることが可能です。

【企業向け】API利用におけるコスト(電気代)削減戦略

企業がビジネスでChatGPTのAPIを利用する際、その利用料金はサーバーの電気代を含む運用コストに直結します。

APIの利用方法を最適化することは、直接的なコスト削減だけでなく、企業の環境負荷低減にも繋がります。

ここでは、企業が実践すべきAPIのコスト削減戦略を3つ紹介します。

タスクに応じた適切なモデルを選定する

社内システムの全てのタスクに、最高性能で最も高価なモデルを利用するのは非効率です。

顧客からの定型的な問い合わせに自動応答するチャットボットには、低コストで高速な「gpt-5-mini」を。

市場分析や複雑なレポート作成など、高度な推論能力が求められる業務には高性能な「gpt-5」を、というように、タスクの要件に応じてモデルを使い分けることがコスト管理の基本です。

トークン数の上限を設定して無駄をなくす

APIの料金は、入力と出力のテキスト量である「トークン数」に基づいて課金されます。

意図せずAIが長文を生成してしまうと、コストが想定を大幅に超える可能性があります。

これを防ぐため、APIを呼び出す際に、生成するテキストの上限(max_tokens)を必ず設定しましょう。

短い回答で十分な場合は上限を低く設定することで、無駄なトークン生成を未然に防ぎ、コストを確実にコントロールできます。

キャッシュを活用してAPI呼び出しを減らす

ユーザーから頻繁に寄せられる同じ質問に対し、毎回APIを呼び出して回答を生成するのは非効率です。

一度APIで生成した回答をデータベースに「キャッシュ」として保存しておき、同じ質問が来た際にはキャッシュから応答を返す仕組みを導入しましょう。

これにより、APIの呼び出し回数そのものを劇的に減らすことができ、API利用料とそれに伴う電力消費を大幅に削減できます。

ChatGPTの電気代が環境に与える影響

ChatGPTをはじめとする生成AIの普及は、私たちの社会に大きな変革をもたらす一方、その膨大な電力消費が地球環境に与える負荷も深刻な問題となっています。

ここでは、二酸化炭素排出と水資源の消費という2つの側面から、その影響を考えます。

AIの電力消費による二酸化炭素排出量の問題

AIデータセンターで消費される電力の多くは、未だに化石燃料に由来する電力が含まれています。

そのため、電力消費量の増加は、そのまま地球温暖化の原因となる二酸化炭素(CO2)排出量の増加に直結します。

ある研究によれば、大規模なAIモデルを一回学習させるだけで、数百トンのCO2が排出されると試算されています。

これは、一般的なガソリン車が地球を何十周も走行する際の排出量に匹敵します。

AIの利用が世界中で拡大するにつれ、そのカーボンフットプリント(CO2排出量)は増大し、気候変動を加速させる一因となることが懸念されています。

データセンターでの水資源の大量消費

データセンターでは、サーバーから発生する膨大な熱を冷却するために、想像以上の量の水が使われています。

特に冷却塔を用いたシステムでは、水を蒸発させる際の気化熱を利用してサーバーを冷やすため、多くの水が消費されます。

AIの計算が複雑になるほどサーバーの発熱量は増え、それに伴い冷却に必要な水の量も増加します。

世界的に水不足が深刻化する地域もある中で、AIデータセンターが貴重な水資源を大量に消費することは、地域社会や生態系に影響を与える可能性があり、持続可能性の観点から大きな課題となっています。

AIと電力問題の未来|持続可能なAIに向けた取り組み

AIがもたらす電力消費の増大という大きな課題に対し、世界中の研究者や企業が、より持続可能なAI技術の実現に向けた取り組みを加速させています。

技術革新とエネルギー戦略の両面から、AIと環境が共存する未来を目指す動きが活発化しています。

よりエネルギー効率の高いAIモデル・ハードウェアの開発

AIのアルゴリズム自体を見直し、より少ない計算量で同等の性能を発揮する、エネルギー効率の高いモデルの開発が進んでいます。

例えば、計算の大部分を省略する「スパースモデリング」や、より小さなモデルでタスクをこなすSLM(小規模言語モデル)といった技術が注目されています。

同時に、AIの計算に特化した、省電力性能の高い専用半導体(AIチップ)の開発も活発です。

これらの新しいハードウェアは、従来のGPUと比較して、電力1ワットあたりの計算性能を飛躍的に向上させることが期待されています。

データセンターへの再生可能エネルギー導入の動き

GoogleやMicrosoft、Amazonといった巨大IT企業は、自社のデータセンターで使用する電力を、太陽光や風力といった再生可能エネルギーで100%賄うことを目標に掲げ、巨額の投資を行っています。

再生可能エネルギーが豊富な地域にデータセンターを建設したり、自社で大規模な太陽光発電所や風力発電所を開発したりする取り組みが世界中で進んでいます。

AIの計算に必要な電力をクリーンなエネルギーで供給することで、AIの成長とカーボンニュートラルを両立させることが、今後の大きな潮流となります。

ChatGPTの電気代に関するよくある質問

ChatGPTの電気代やエネルギー消費について、多くの人が抱く素朴な疑問にお答えします。

ChatGPTへの質問は無料なのに、なぜ電気代を気にする必要があるのですか?

個人ユーザーがChatGPTを使っても、自宅の電気料金を直接請求されることはありません。

しかし、その無料サービスの裏側では、運営会社であるOpenAIがデータセンターの莫大な電気代を含む運用コストを負担しています。

社会全体でAIの利用が拡大すれば、それだけ総電力消費量が増え、環境への負荷も増大します。

持続可能な形でAI技術の恩恵を受け続けるためには、私たち一人ひとりがエネルギー問題を意識し、より賢く、効率的な使い方を心がけることが大切です。

有料版(GPT-4など)の方が電気代は高いですか?

はい、その傾向があります。有料版で利用できるGPT-4のような高性能モデルは、無料版のモデルに比べて構造が複雑で、より多くの計算能力を必要とします。

そのため、同じタスクを処理する場合でも、高性能モデルの方がより多くの電力を消費します。

ただし、複雑な指示に対しては、高性能モデルの方が少ないやり取りで的確な答えを出せるため、結果的に総計算量が少なく済む場合もあります。

タスクの難易度に応じてモデルを使い分けるのが最も効率的です。

利用する時間帯によって消費電力は変わりますか?

ユーザー個人の一回の質問における消費電力が、時間帯によって大きく変わることはありません。AIサーバーは24時間365日、常に稼働しているためです。

しかし、世界中の多くの人が同時にアクセスするピークタイムには、データセンター全体の負荷が高まり、全体の電力消費量は増加します。

電力需給が逼迫する時間帯の利用を少し控えるなど、社会全体のエネルギー効率を考える視点も、これからのAI時代には求められるかもしれません。

AIの便利さの裏側、あなたの知らない「環境コスト」とは

あなたがChatGPTに送る一つの質問。その裏側で、地球環境にどれほどの負荷がかかっているか考えたことはありますか?便利なAI技術の影で、私たちの想像を超えるエネルギーと資源が消費されているという事実を、国際エネルギー機関(IEA)などの報告が明らかにしています。この記事では、AIが地球に与える環境コストの現実と、未来に向けた技術の進むべき道筋を解説します。

【衝撃の事実】AIが地球から奪うもの

「AIは魔法の箱ではない」——。その稼働の裏には、物理的な巨大インフラと、それに伴う環境負荷が存在します。私たちがAIの恩恵を受けるほど、地球の資源は静かに消費されていくのです。この問題は、主に2つの側面から深刻化しています。

一つ目は、膨大な電力消費に伴う「二酸化炭素排出」です。AIデータセンターの電力需要は急増しており、2026年には世界のデータセンター全体の電力消費量が日本の総電力消費量を上回る可能性も指摘されています。この電力の多くが化石燃料に依存している限り、AIの利用拡大は地球温暖化を加速させることに直結します。

二つ目は、サーバー冷却に伴う「水資源の大量消費」です。高性能なサーバーは膨大な熱を発するため、その冷却に大量の水が使われます。ある試算では、AIが10〜50の質問に答えるだけで、500mlの水を消費するとも言われています。世界的な水不足が懸念される中で、AI技術の発展が貴重な水資源を枯渇させるリスクをはらんでいるのです。

引用元:

国際エネルギー機関(IEA)の報告によると、データセンター、AI、暗号通貨による世界の電力消費量は、2026年までに倍増する可能性があるとされています。特にAIによる電力需要は、今後数年間で少なくとも10倍に増加すると予測されています。(IEA, “Electricity 2024”, 2024年)

AIと地球が共存する未来への挑戦

この深刻な課題に対し、世界中の企業や研究機関が解決策を模索しています。それは、AIの成長を止めることではなく、「持続可能なAI」へと進化させることです。

取り組みの柱は二つあります。一つは、「AIモデルとハードウェアの省エラネ化」です。より少ない計算量で高い性能を発揮する効率的なアルゴリズムや、電力効率を劇的に向上させるAI専用半導体の開発が急速に進んでいます。

もう一つの柱が、「再生可能エネルギーへの転換」です。大手IT企業は、データセンターの電力を100%再生可能エネルギーで賄うことを目標に掲げ、太陽光や風力発電への巨額の投資を行っています。クリーンなエネルギーでAIを動かすことが、技術発展と環境保全を両立させる鍵となります。

私たちは、AIの利便性を享受するだけでなく、その裏側にある環境コストにも目を向け、より賢い利用法を選択していく必要があるのです。

まとめ

企業は業務効率化やDX推進の切り札として生成AIの活用に注目していますが、その一方で、API利用料金などの運用コストや、本記事で解説されたような環境負荷への配慮も新たな課題となりつつあります。

しかし、実際には「どのAIモデルを選べばコスト効率が良いのか分からない」「APIの利用料をどう管理すればいいのか」といった理由で、本格的な導入に踏み切れない企業も少なくありません。

そこでおすすめしたいのが、Taskhubです。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

たとえば、メール作成や議事録作成、画像からの文字起こし、さらにレポート自動生成など、さまざまな業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「何をどう使えばいいのかわからない」という初心者企業でも安心してスタートできます。

APIの複雑なコスト管理やモデル選定に悩む必要がなく、導入後すぐに効果を実感できる設計なので、専門知識がなくても、すぐに業務効率化とコストの最適化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“最も賢い生成AI活用”を体験し、御社のDXを一気に加速させましょう。