「ChatGPTは便利だけど、個人情報を入力しても大丈夫?」

「会社の機密情報を扱わせたいけど、情報漏洩のリスクが怖い…。」

ChatGPTの利用が広がる一方で、このような個人情報保護やセキュリティに関する不安を感じている方も多いのではないでしょうか。

本記事では、ChatGPTで個人情報が漏洩する仕組みやリスク、国内外の実際のインシデント事例を解説します。

さらに、今すぐ個人でできる安全対策から、企業が導入する際に確認すべきポイントまで、具体的で実践的な10の方法を網羅的にご紹介します。

生成AIのセキュリティに関する専門的な知見を基に解説しますので、ぜひ最後までご覧になり、安全にChatGPTを活用してください。

なぜ危険?ChatGPTで個人情報が漏洩する仕組みとリスク

ChatGPTを安全に利用するためには、まずどのような危険性があるのかを正しく理解することが重要です。

ここでは、個人情報が漏洩する主な仕組みと、それに伴うリスクを3つの観点から解説します。

- 入力した情報がAIの学習データとして使われる

- 過去のやり取りから個人情報が特定される可能性

- 知らないうちに個人情報保護法に抵触するケースも

これらの仕組みとリスクを把握し、適切な対策を講じる第一歩としましょう。

入力した情報がAIの学習データとして使われる

デフォルト設定のままChatGPTを利用すると、入力したテキストデータがOpenAIのAIモデルの学習データとして利用される可能性があります。

これには、質問の内容、指示した文章、提供した背景情報などが全て含まれます。

もし、この入力データの中に氏名、住所、電話番号、メールアドレス、あるいは企業の機密情報などが含まれていた場合、それらの情報が意図せずAIの「知識」の一部となってしまうのです。

学習データとして取り込まれた情報が、将来的に他のユーザーへの回答生成に利用されないと公式には言及されていますが、一度OpenAIのサーバーに渡った情報がどのように管理されるのか、100%の安全が保証されているわけではありません。

このリスクを避けるためには、後述する学習をオフにする「オプトアウト」設定が不可欠です。

過去のやり取りから個人情報が特定される可能性

ChatGPTには、会話の文脈を理解するために過去のやり取りを記憶するチャット履歴機能があります。

この機能は非常に便利ですが、一つの会話スレッド内で断片的な情報を繰り返し入力していると、それらを組み合わせることで個人が特定されてしまうリスクがあります。

例えば、ある質問で「〇〇株式会社の佐藤です」と名乗り、別の質問で「弊社の主力製品である△△のマーケティングについて相談です」と入力した場合、チャ-ット履歴には「〇〇株式会社の佐藤」と「製品△△」が関連付けられて保存されます。

もしアカウントへの不正アクセスなどが発生した場合、攻撃者はこれらのチャット履歴を閲覧し、個人や企業の内部情報を容易に推測できてしまいます。

長期にわたる会話では、自分でも気づかないうちに多くの情報を与えてしまっている可能性があるため、注意が必要です。

知らないうちに個人情報保護法に抵触するケースも

安易な気持ちで顧客情報を入力してしまうことのないよう、法的なリスクについても正しく認識しておくことが極めて重要です。

業務でChatGPTを利用する際、特に注意が必要なのが個人情報保護法との関連です。

例えば、顧客リストや従業員名簿といった第三者の個人情報をChatGPTに入力する行為は、本人の同意なく個人データを第三者(この場合はOpenAI)に提供したと見なされ、個人情報保護法に抵触する可能性があります。

これは、たとえ業務効率化が目的であったとしても、法律違反となり罰則の対象となる重大な問題です。

OpenAIはアメリカの企業であり、日本の法律の管轄外にあると考えるかもしれませんが、個人情報を取り扱う日本の事業者は、提供先が国内外を問わず、日本の法律を遵守する義務があります。

こちらは個人情報保護委員会による、生成AIサービス利用に関する公式の注意喚起です。合わせてご覧ください。 https://www.ppc.go.jp/news/careful_information/230602_AI_utilize_alert

【実例】実際にあったChatGPTからの情報漏洩事例

ChatGPTの個人情報保護リスクは、理論上の話だけではありません。

実際に国内外で情報漏洩が疑われるインシデントが発生し、大きな問題となりました。

具体的な事例を知ることで、リスクをより現実的なものとして捉え、対策の重要性を再認識することができます。

国内外で起きた具体的なインシデント

最もよく知られている事例の一つが、韓国の大手電機メーカーで発生したインシデントです。

同社の従業員が、業務効率化のために社内の機密情報であるソースコードや会議の議事録をChatGPTに入力してしまったことが発覚しました。

これにより、まだ公開されていない製品情報や社内の意思決定プロセスといった機密情報が、OpenAIのサーバーに送信されてしまいました。

この事件をきっかけに、同社はChatGPTをはじめとする生成AIサービスの社内利用を原則禁止する厳しい措置を取りました。

また、OpenAI自身も、他のユーザーのチャット履歴のタイトル部分が、別のアクティブユーザーに一時的に表示されてしまうというバグがあったことを認めています。

これは、他人の会話の内容を意図せず覗き見できてしまう状態であり、個人情報漏洩に直結する深刻な問題でした。

こちらはOpenAIが公式に発表した、チャット履歴のタイトルが漏洩したインシデントに関する報告です。合わせてご覧ください。 https://openai.com/index/march-20-chatgpt-outage/

事例から学ぶ、情報漏洩の主な原因

これらの事例から見えてくる情報漏洩の主な原因は、大きく分けて2つあります。

一つ目は、「利用者のリテラシー不足」です。

ChatGPTの仕組みやリスクを十分に理解しないまま、便利さだけを優先して機密情報や個人情報を入力してしまうケースです。

先述の韓国企業の事例は、まさにこの典型と言えるでしょう。

従業員一人ひとりが正しい知識を持つことの重要性が浮き彫りになりました。

二つ目は、「システムの脆弱性やバグ」です。

これはOpenAI側の問題であり、ユーザーがどれだけ注意していても完全に防ぐことは困難です。

チャット履歴が他人に表示されてしまったインシデントは、プラットフォーム側のセキュリティ対策がいかに重要かを示しています。

ユーザーとしては、サービス提供元のセキュリティ体制や過去のインシデント対応についても注視し、信頼できるサービスを選択することが求められます。

今すぐできる!ChatGPTの個人情報保護10の安全対策

ChatGPTに潜むリスクを理解した上で、次は具体的な対策を講じることが重要です。

ここでは、個人ユーザーから法人利用まで、誰でも今すぐ実践できる10の安全対策を具体的かつ分かりやすく解説します。

対策1:個人情報・機密情報は入力しない【最重要】

最も基本的かつ最も重要な対策は、個人情報や機密情報を一切入力しないことです。

氏名、住所、電話番号、メールアドレス、クレジットカード番号、マイナンバー、そして企業の内部情報や顧客データなどをChatGPTに尋ねる文章に含めないように徹底してください。

質問を作成する際は、個人や企業が特定できる固有名詞を「Aさん」「B社」「製品X」のように仮名に置き換えたり、数値を「約100万円」のように丸めたりする工夫が有効です。

このルールを自分自身と組織全体で遵守するだけで、情報漏洩リスクの大半は回避できます。

どんなに便利な機能であっても、この大原則を決して忘れないようにしましょう。

対策2:学習をオフ(オプトアウト)にする設定方法

入力したデータがAIの学習に使われることを防ぐ「オプトアウト」設定は、必ず行っておきましょう。

この設定を有効にすると、あなたの会話はAIモデルのトレーニングから除外されます。設定方法は簡単です。

- ChatGPTにログインし、画面左下のアカウント名をクリックします。

- 「設定(Settings)」を選択し、「データコントロール(Data controls)」の項目を開きます。

- 「チャット履歴とトレーニング(Chat history & training)」のトグルスイッチをオフにすれば設定は完了です。

ただし、この設定をオフにすると会話の履歴が保存されなくなるため、過去のやり取りを見返すことができなくなる点には注意が必要です。

こちらはOpenAIが公式に解説している、チャット履歴と学習データを管理する新しい方法についての記事です。合わせてご覧ください。 https://openai.com/index/new-ways-to-manage-your-data-in-chatgpt/

対策3:API連携なら学習データとして利用されない

自社のアプリケーションやサービスにChatGPTの機能を組み込みたい場合、API(Application Programming Interface)を経由して利用する方法があります。

OpenAIは公式に、APIを通じて送受信されるデータは、AIモデルの学習には一切利用しないと明言しています。

これは、サービス提供者が顧客データを扱うことを想定したプライバシー保護措置です。

そのため、ウェブブラウザ版のChatGPTで情報を入力するのではなく、API連携を前提としたシステムを構築することで、より安全にAIの機能を活用できます。

開発の知識が必要になりますが、特に法人で機密情報を扱いつつ業務効率化を図りたい場合には、極めて有効な選択肢となります。

こちらはOpenAIのAPIにおけるデータ利用ポリシーについて解説した公式ガイドです。合わせてご覧ください。 https://platform.openai.com/docs/guides/your-data

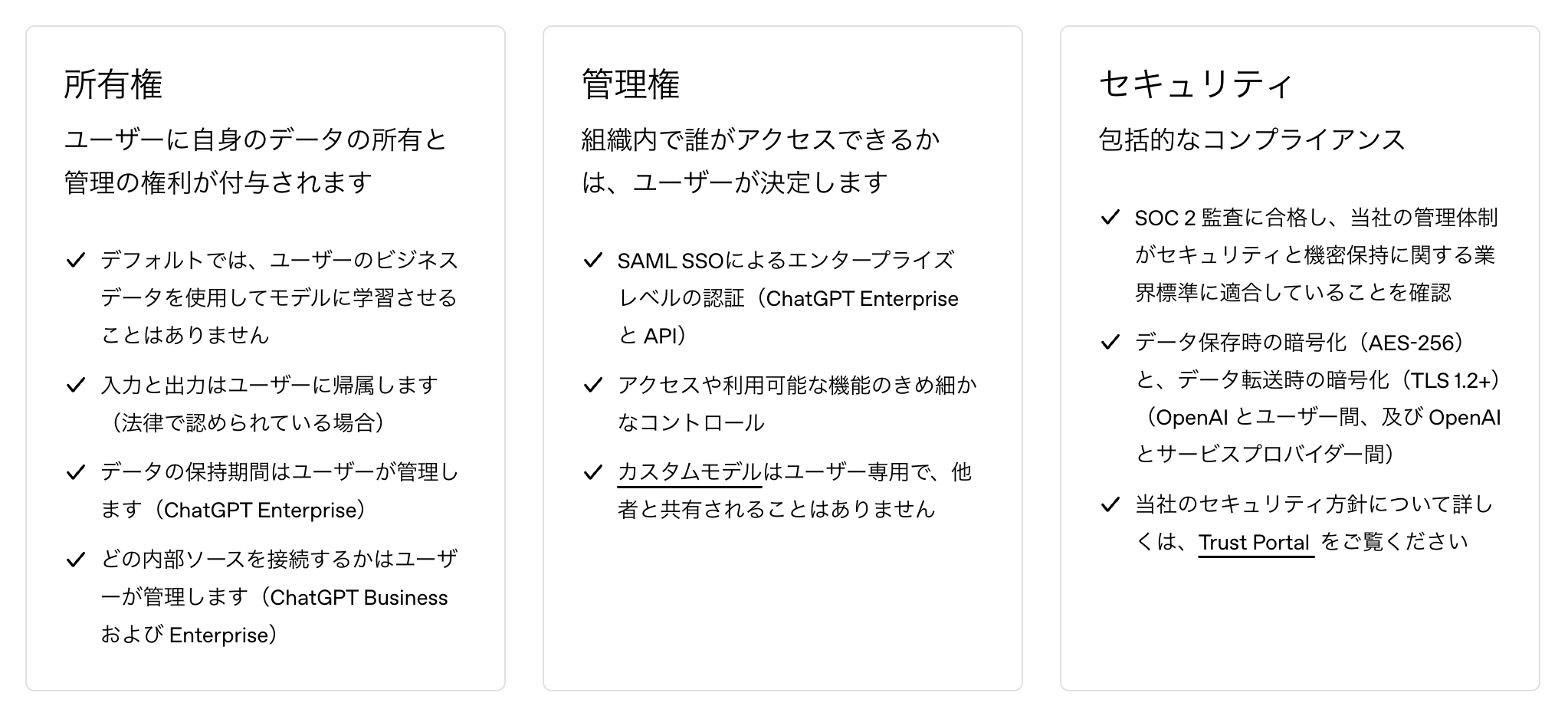

対策4:法人向けプラン(ChatGPT Enterprise)を契約する

企業全体でChatGPTを安全に利用したい場合、法人向けに提供されている「ChatGPT Enterprise」プランの契約が推奨されます。

このプランは、個人向けプランとは異なり、入力したデータがAIの学習に利用されないことが契約上保証されています。

さらに、管理者向けのダッシュボード機能や、シングルサインオン(SSO)といった高度なセキュリティ機能が提供され、組織内での利用状況を管理し、不正アクセスを防ぐことが可能です。

個人向けプランと比較してコストはかかりますが、企業が情報漏洩インシデントによって被る損害(信用の失墜、賠償責任など)を考えれば、導入を検討する価値は十分にあると言えるでしょう。

こちらは法人向けプランであるChatGPT Enterpriseのプライバシー保護について解説した公式ページです。合わせてご覧ください。 https://openai.com/enterprise-privacy/

対策5:入力したデータを削除する(チャット履歴・アカウント)

過去のチャット履歴に、うっかり個人情報や機密情報を含めてしまった場合は、速やかに削除しましょう。

ChatGPTの画面左側のサイドバーに表示されているチャット履歴一覧から、該当する会話にカーソルを合わせると表示されるゴミ箱アイコンをクリックすることで、個別のチャット履歴を削除できます。

また、全てのデータを完全に消去したい場合は、アカウント自体の削除も可能です。

「設定(Settings)」から「データコントロール(Data controls)」に進み、「アカウントを削除(Delete account)」を選択することで手続きを行えます。

ただし、アカウントを削除すると元に戻すことはできないため、慎重に判断してください。

対策6:二段階認証で不正アクセスを防ぐ

ChatGPTのアカウント自体のセキュリティを強化することも、情報漏洩対策として非常に重要です。

万が一、パスワードが第三者に知られてしまった場合でも、不正にログインされるのを防ぐ仕組みが「二段階認証」です。

二段階認証を設定すると、ログイン時にパスワードに加えて、スマートフォンアプリなどで生成される一度きりの確認コードの入力が必須となります。

これにより、本人以外のアカウントへのアクセスを効果的にブロックできます。

設定は、「設定(Settings)」の「アカウント(Account)」セクションにある「二段階認証(Two-factor authentication)」から行うことができます。

まだ設定していない場合は、今すぐ有効にすることをお勧めします。

対策7:社内の利用ガイドラインを策定・周知する

企業としてChatGPTを導入する場合、従業員が安全に利用するための明確なルール、すなわち「利用ガイドライン」を策定し、全社的に周知徹底することが不可欠です。

ガイドラインには、以下のような項目を盛り込むべきです。

- 入力してはいけない情報(個人情報、顧客情報、機密情報など)の具体的な定義

- 業務で利用する際の申請・承認プロセス

- 学習オフ(オプトアウト)設定の義務化

- 情報漏洩が疑われるインシデント発生時の報告手順

これらのルールを定めるだけでなく、なぜそれが必要なのか、リスクについても含めて定期的に研修を行うことで、従業員一人ひとりのセキュリティ意識を高めることが重要です。

生成AIの社内ガイドライン策定の具体的なポイントやひな形については、こちらの記事で詳しく解説しています。合わせてご覧ください。対策8:プロンプトを工夫し個人情報を含めない

個人情報を直接入力する代わりに、抽象化した表現やダミーデータを使いましょう。

ChatGPTへの指示文である「プロンプト」の書き方を工夫することも、有効な対策の一つです。

例えば、顧客への謝罪メールを作成したい場合に、実際の顧客名や商品名を書くのではなく、「[顧客名]様」「[商品名]」のように、後で自分で置き換えるための目印(プレースホルダー)を使ってプロンプトを作成します。

こうすることで、ChatGPTには個人情報を含まない形で意図を伝え、必要な文章のテンプレートを生成させることができます。

少しの手間で安全性は格段に向上するため、ぜひ習慣づけてください。

対策9:定期的にチャット履歴を見直す

意図せず個人情報を入力してしまっている可能性に気づくために、定期的に自分のチャット履歴を見返す習慣をつけましょう。

特に、長期間にわたって一つのテーマで会話を続けているスレッドは、無意識のうちに多くの情報を与えてしまっている可能性があります。

月に一度など、タイミングを決めて過去のやり取りを確認し、少しでも懸念のある情報が含まれている会話があれば、速やかに削除するようにしてください。

自分自身の利用状況を客観的に振り返ることで、どのような場面で情報を入力しがちかという傾向を把握し、今後の利用方法の改善にも繋がります。

対策10:セキュリティが高い他の法人向けAIも検討する

特に法人利用を前提とする場合、セキュリティ機能を強化したサービスを比較検討することも重要です。

ChatGPTは非常に優れたツールですが、世の中には他にも様々な生成AIサービスが存在します。

例えば、マイクロソフトが提供する「Azure OpenAI Service」は、Azureの堅牢なセキュリティ基盤上でChatGPTと同じモデルを利用できるサービスです。

入力データが学習に使われないことはもちろん、閉域網接続などの高度なセキュリティ要件にも対応可能です。

自社のセキュリティポリシーや扱う情報の機密性レベルに応じて、ChatGPTだけに固執せず、最適なツールを選択するという視点も持っておきましょう。

【法人向け】企業でChatGPTを安全に利用するためのポイント

企業でChatGPTを導入する際の流れや、具体的な活用事例についてはこちらの記事で網羅的に解説しています。合わせてご覧ください。企業が組織としてChatGPTを活用する際には、個人の利用とは異なる視点での対策が求められます。

業務効率化という大きなメリットを享受しつつ、情報漏洩という致命的なリスクをいかに管理するかが鍵となります。

業務効率化と情報漏洩リスクのバランスの取り方

ChatGPTの導入によって得られる生産性の向上は計り知れませんが、それと情報漏洩リスクは常にトレードオフの関係にあります。

このバランスを適切に取るためには、まず「どのような業務に」「どのレベルの情報を使って」ChatGPTを利用するのかを明確に定義することが重要です。

例えば、公開情報に基づく市場調査やアイデアの壁打ちといったリスクの低い業務から利用を開始し、徐々に対象を広げていくのが現実的です。

顧客情報や開発中の製品情報など、機密性の高い情報を取り扱う業務への適用は、前述のChatGPT EnterpriseやAPI利用など、セキュリティが担保された環境が整うまでは見送るべきでしょう。

リスクレベルに応じた利用範囲の明確化が、安全な活用の第一歩です。

全従業員に周知すべきセキュリティ教育

全従業員を対象とした、定期的かつ実践的なセキュリティ教育が不可欠です。

どれだけ優れたシステムやルールを導入しても、それを使う従業員のセキュリティ意識が低ければ意味がありません。

研修では、単に「個人情報を入力してはいけない」と禁止事項を伝えるだけでなく、なぜ危険なのか、過去にどのようなインシデントがあったのかといった背景知識から、安全なプロンプトの書き方といった具体的なスキルまでを網羅的に教えるべきです。

特に、ChatGPTの利用頻度が高い部署や、機密情報に触れる機会の多い従業員に対しては、より専門的な内容の教育を実施することも効果的です。

セキュリティは、全社で取り組むべき文化であるという意識を醸成することが重要です。

導入前に確認すべきセキュリティ対策リスト

これから本格的にChatGPTの全社導入を検討する企業は、以下のチェックリストを用いて自社の準備状況を確認することをお勧めします。

- 社内利用ガイドラインは策定され、周知されているか?

- 入力が禁止される情報の種類は具体的に定義されているか?

- 利用申請や承認のプロセスは明確か?

- 従業員向けのセキュリティ教育計画は立てられているか?

- ChatGPT EnterpriseやAPI利用など、安全な利用環境の導入は検討されているか?

- インシデント発生時の報告・対応体制は整備されているか?

これらの項目を一つずつ確認し、対策を講じることで、導入後に発生しうるトラブルを未然に防ぎ、安全なAI活用の基盤を築くことができます。

OpenAIの公式見解は?プライバシーポリシーを分かりやすく解説

こちらは本セクションで解説する、OpenAIの公式プライバシーポリシー全文です。合わせてご覧ください。 https://openai.com/policies/row-privacy-policy/

ChatGPTを安全に利用するためには、提供元であるOpenAIがユーザーのデータをどのように扱っているのか、その公式なルール(プライバシーポリシー)を理解しておくことが欠かせません。

ここでは、その要点を分かりやすく解説します。

OpenAIが収集する情報の種類と利用目的

OpenAIは、アカウント作成時に入力する氏名や連絡先といった「アカウント情報」、そしてユーザーが入力するプロンプトやアップロードしたファイルなどの「コンテンツ」の情報を収集しています。

これらの情報は、サービスの提供、維持、改善、そして新しいモデルの開発のために利用されるとされています。

特に「コンテンツ」については、前述の通り、ユーザーがオプトアウト設定をしない限り、AIの学習データとして利用される可能性があることが明記されています。

データは第三者に提供されることがあるのか?

プライバシーポリシーによれば、OpenAIはユーザーの同意がある場合、法律によって要求される場合、あるいはサービス提供に必要な業務委託先など、限定的な状況下で情報を第三者に提供することがあると記載されています。

これには、クラウドインフラを提供するベンダー(例: Microsoft Azure)などが含まれます。

ただし、これらの業務委託先も、OpenAIと同様の厳しい守秘義務契約を結んでいるとされています。

一方で、ユーザーのデータを広告目的で販売したり、共有したりすることはないと明言しています。

この点は、他の多くの無料ウェブサービスとは異なる重要なポイントです。

データの保存期間とユーザーができること

OpenAIは、法律上の要請やサービスの提供に必要な期間、ユーザーのデータを保持します。

ユーザーは、自身のデータに対していくつかの権利を持っています。

具体的には、自分のデータにアクセスしたり、修正したり、あるいはアカウントごと削除したりする権利です。

チャット履歴の個別の削除や、学習への利用を停止するオプトアウト設定も、ユーザーに与えられたデータコントロールの権利の一環です。

自分のデータがどのように扱われるかを完全にコントロールできるわけではありませんが、どのような権利が与えられているのかを理解し、必要に応じて適切に行使することが重要です。

国のガイドラインは?個人情報保護委員会の注意喚起

ChatGPTをはじめとする生成AIの急速な普及を受け、日本の個人情報保護を所管する国の機関である「個人情報保護委員会」も、事業者や利用者に対して注意喚起を行っています。

法的な観点からも、正しい理解が求められます。

事業者が守るべき法的要件

個人情報保護委員会は、生成AIサービスを利用する事業者に対し、日本の個人情報保護法を遵守するよう求めています。

特に、個人情報をプロンプトとして入力する行為は、本人の同意なく第三者(OpenAI)に個人データを提供することに該当する可能性があると指摘しています。

事業者がAIを利用して個人情報を取り扱う際は、利用目的を特定し、本人に通知または公表しなければなりません。

また、AIサービス提供者の安全管理措置などを事前に確認することも重要です。

「海外のサービスだから日本の法律は関係ない」という考えは通用しないことを、事業者は強く認識する必要があります。

利用者が注意すべきポイント

個人利用者の場合でも、他人の個人情報を本人の同意なく入力することは避けるべきです。

例えば、友人に関する情報を入力して文章を作成させるといった行為も、プライバシー侵害のリスクを伴います。

また、AIの生成物にも注意が必要です。

ChatGPTが生成した回答の中に、意図せず第三者の個人情報が含まれてしまう可能性もゼロではありません。

生成された文章を公開、利用する際には、個人情報が含まれていないかを確認するリテラシーが求められます。

国の機関も、AIの特性を理解し、慎重な利用を呼びかけているのです。

ChatGPTの個人情報保護に関するよくある質問

最後に、ChatGPTの個人情報保護に関して、多くの人が抱く疑問についてQ&A形式で回答します。

入力した情報が、他のユーザーへの回答に使われることはある?

OpenAIは、あるユーザーが入力した情報を、直接そのままの形で他のユーザーへの回答として生成することはないとしています。

ただし、オプトアウト設定をしていない場合、入力された情報はAIモデルの「学習」に使われます。

これにより、AIが一般的な知識やパターンを学習し、その結果として、間接的に他のユーザーへの回答の質が向上する、という形で影響を与える可能性はあります。

特定の個人情報がそのまま出力されることは考えにくいですが、リスクを完全にゼロにするためには、やはり個人情報を入力しないこと、そしてオ-プトアウト設定をすることが基本となります。

無料版と有料版でセキュリティレベルは違う?

セキュリティの基本的な考え方は、無料版(ChatGPT)と有料版(ChatGPT Plusなど)で大きくは変わりません。

どちらのプランでも、ユーザーはオプトアウト設定を行うことができ、APIは学習に利用されません。

ただし、先述した法人向けの「ChatGPT Enterprise」は、これら個人向けプランとは明確に一線を画し、データが学習に利用されないことの契約上の保証や、高度な管理機能など、より高いレベルのセキュリティとガバナンスが提供されます。

個人で利用する上でのセキュリティレベルに大きな差はありませんが、企業として利用するならEnterpriseプランが最も安全な選択肢です。

自分の情報が漏洩していないか確認する方法は?

残念ながら、自分の情報がChatGPTを通じて漏洩したかどうかを、ユーザー自身が直接的かつ確実に確認する簡単な方法はありません。

OpenAIが大規模な情報漏洩インシデントを検知した場合は、公式な発表や影響を受けたユーザーへの通知が行われる可能性があります。

そのため、ユーザーができることは、OpenAIからの公式情報や、信頼できるセキュリティ関連のニュースを定期的にチェックすることです。

また、自分のチャット履歴を定期的に見直し、機密情報が含まれていないかを確認する習慣をつけることが、間接的ながら有効な自己防衛策となります。

会社でChatGPTの利用が禁止されている場合はどうすればいい?

会社のルールでChatGPTの利用が禁止されている場合は、その指示に必ず従ってください。

個人の判断で業務に利用することは、就業規則違反となり、懲戒処分の対象となる可能性があります。

情報漏洩が発生した場合、会社に多大な損害を与えるだけでなく、あなた自身の責任も問われかねません。

もし、業務上どうしても利用したい理由がある場合は、まず上司や情報システム部門に相談しましょう。

どのような業務で、どのような目的で使いたいのか、そして情報漏洩リスクにどう配慮するのかを具体的に説明し、会社として安全な利用方法(例えば、法人プランの契約やガイドラインの策定)を検討してもらうよう働きかけるのが正しい手順です。

あなたのChatGPT利用は危険かも?情報漏洩を招く「NGな使い方」と「安全な使い方」

ChatGPTを業務で利用する際、「この情報の入力は安全だろうか?」と一瞬でもためらった経験はありませんか。その直感は正しいかもしれません。実は、多くの人が気づかないうちに、会社の機密情報や個人情報を危険に晒す使い方をしています。

例えば、韓国の大手電機メーカーでは、従業員が機密情報を入力したことで、大規模な情報漏洩インシデントに発展しました。便利なツールの裏には、個人情報保護法に抵触するリスクや、意図せず情報がAIの学習データに利用される危険性が潜んでいるのです。

しかし、これはChatGPTが危険だということではありません。問題なのは、リスクを知らずに利用してしまうことです。この記事では、情報漏洩の具体的な事例から、今すぐできるセキュリティ対策、そして企業が安全に活用するための具体的なステップまで、専門的な知見を交えて網羅的に解説します。

引用元:

生成AIの利用に関する国内外のインシデント調査では、従業員のリテラシー不足が情報漏洩の主な原因であることが報告されています。特に、社内の機密情報やソースコードをChatGPTに入力した結果、企業の知的財産が外部サーバーに送信された事例は、多くの企業に警鐘を鳴らしました。(企業における生成AI活用と情報セキュリティに関する調査報告書 2024年)

まとめ

ChatGPTの業務活用による生産性向上は魅力的ですが、多くの企業が情報漏洩リスクや個人情報保護法への抵触を懸念し、導入に踏み出せないでいます。

従業員のリテラシー教育や利用ガイドラインの策定、セキュリティ対策など、クリアすべき課題は少なくありません。

そこでおすすめしたいのが、Taskhubです。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

議事録の自動作成や契約書のリーガルチェック、市場調査レポートの生成など、様々な業務をアプリ感覚で選択するだけで、誰でも簡単にAIの力を引き出せます。

最も重要な点は、Microsoft Azure OpenAI Serviceを基盤としているため、入力したデータがAIの学習に利用されることはなく、セキュリティが万全であることです。情報漏洩の心配をせずに、企業の機密情報も安全に取り扱うことができます。

さらに、専門のAIコンサルタントが導入から活用までを徹底的にサポートするため、社内にAIの専門家がいなくても、安心して導入を進められます。

複雑な設定や専門知識は一切不要で、導入後すぐに業務効率化と生産性向上を実感できるのがTaskhubの強みです。

まずは、Taskhubの具体的な活用事例や機能がわかる【サービス概要資料】を無料でダウンロードしてみてください。

Taskhubで、セキュリティを気にすることなく、安全で最速の生成AI活用を始めましょう。