「RAGシステムを構築したけれど、回答の精度がいまいち上がらない」

「そもそも、何をもって精度が良いと言えるのか、評価基準がわからない」

RAG(検索拡張生成)の開発において、このような壁にぶつかっているエンジニアやPMの方は多いのではないでしょうか。

生成された回答をただ眺めるだけの感覚的な評価では、システムの改善サイクルを適切に回すことはできません。

精度の高いRAGを実運用に乗せるためには、客観的な指標に基づいた定量的な評価が不可欠です。

本記事では、RAGの精度の測り方である「評価指標(メトリクス)」の解説から、Ragasなどの主要ツール、評価結果に基づいた具体的な改善策までを網羅的に解説しました。

数多くの生成AI導入支援を行ってきた弊社の知見をもとに、実務で使えるノウハウを凝縮しています。

RAGの品質を定量的に可視化し、プロダクトの価値を最大化させるために、ぜひ最後までご覧ください。

そもそもなぜRAGの精度評価は難しいのか?

通常のソフトウェアテストや、正解が一つに定まる分類タスクとは異なり、RAGの評価は一筋縄ではいきません。

多くの開発者が「なんとなく」の評価で止まってしまう背景には、RAG特有の構造的な複雑さと、自然言語処理ならではの曖昧さが存在します。

ここでは、なぜRAGの評価がこれほどまでに難しいとされるのか、その根本的な理由を2つの観点から紐解いていきます。

この難しさを理解することが、適切な評価設計の第一歩となります。

検索(Retrieval)と生成(Generation)の複合プロセスであるため

RAGはその名の通り、外部データベースからの「検索」と、LLMによる「生成」という2つの異なるプロセスが連動して動作するシステムです。

そのため、最終的な回答が間違っていた場合、その原因がどこにあるのかを特定するのが困難になりがちです。

例えば、回答がユーザーの意図とずれていたとします。

その原因は、検索システムが適切なドキュメントを見つけられなかったこと(検索の失敗)にあるのかもしれません。

あるいは、検索自体は適切な情報を持ってこれていたのに、LLMがその情報を正しく読み込めず、誤った解釈をしてしまったこと(生成の失敗)にあるのかもしれません。

このように、RAGは複数のコンポーネントが依存し合っているため、単に出力結果を見るだけでは問題の切り分けができません。

検索精度と生成精度の両方を個別に、かつ統合的に評価しなければならない点が、従来のチャットボット評価よりも難易度を高めている大きな要因です。

評価を行う際は、この二重構造を常に意識する必要があります。

RAGシステムの基盤となるLLM(大規模言語モデル)の定義や、ChatGPTとの違い、代表的なモデルについては、こちらの記事で基礎から解説しています。

正解が一つではない「自然言語生成」特有の評価課題

従来の機械学習モデルであれば、予測値と正解ラベルが一致しているかどうかで精度を容易に算出できました。

しかし、RAGが生成する回答は自然言語であり、表現の自由度が極めて高いという特徴があります。

例えば、「RAGのメリットは?」という質問に対して、用意していた正解データが「外部知識を活用できる点」だったとします。

これに対し、システムが「社内データを参照して回答できること」と答えた場合、表現は異なりますが、意味的にはどちらも正解と言えます。

このように、文言が完全に一致しなくても意味が通じていれば正解とするような、「意味的な評価」が求められます。

また、回答のトーンや詳細度、要約の粒度など、ユーザーの好みやコンテキストによって「良し悪し」が変わる要素も多分に含まれます。

完全一致(Exact Match)のような単純な指標が通用せず、人間の感覚に近い高度な判断基準を設けなければならない点が、RAG評価の設計を難しく、そして悩ましいものにしています。

RAG評価で見るべき重要な「評価指標(メトリクス)」

RAGの評価を成功させるためには、何を測定するかという「物差し」を定義することが重要です。

漠然と「良い回答」を目指すのではなく、回答の質を構成する要素を分解し、それぞれの指標でスコア化します。

一般的にRAGの評価では、検索の質と生成の質を測るために、以下の5つの主要な指標が用いられます。

これらは「RAG Triad(RAGの三位一体)」と呼ばれる概念をベースに拡張されたもので、多くの評価フレームワークで採用されている標準的な指標です。

この概念の基礎となった研究論文では、検索と生成を統合的に評価するフレームワークの詳細が語られています。 https://arxiv.org/abs/2309.15217

【生成の評価】回答の忠実性(Faithfulness)

忠実性(Faithfulness)とは、生成された回答が、検索して取得した「コンテキスト(文脈情報)」にどれだけ忠実に基づいているかを測る指標です。

この指標は、RAGにおける最大のリスクである「ハルシネーション(もっともらしい嘘)」を検知するために極めて重要です。

もしLLMが、検索したドキュメントには書かれていない情報を勝手に付け加えて回答した場合、忠実性のスコアは下がります。

RAGの目的は、学習済みデータではなく、与えられた外部データに基づいて回答することにあるため、このスコアが高いことは必須条件と言えます。

具体的には、回答に含まれる主張の一つひとつが、コンテキスト内の情報によって裏付けられるかを確認します。

忠実性が低い場合は、LLMがコンテキストを無視しているか、事前学習の知識を優先してしまっている可能性があります。

RAGにおける最大のリスクである「ハルシネーション(もっともらしい嘘)」を防ぐためのプロンプトテクニックについては、以下の記事で詳細に解説しています。

【生成の評価】回答の関連性(Answer Relevance)

回答の関連性(Answer Relevance)は、生成された回答が、ユーザーの「質問(クエリ)」に対して適切に答えているかを測る指標です。

いくらコンテキストに忠実で正確な内容であっても、ユーザーが聞きたいこととずれていては意味がありません。

例えば、「A商品の価格は?」という質問に対し、「A商品は非常に高性能で人気があります」と答えた場合、情報は正しいかもしれませんが、質問への回答としては不適切です。

この場合、関連性のスコアは低くなります。

この指標は、回答が冗長すぎたり、質問の意図を取り違えていたりしないかを確認するのに役立ちます。

関連性を高めることで、ユーザーにとって満足度の高い、対話として成立するRAGシステムを実現できます。

【検索の評価】文脈の適合率(Context Precision)

文脈の適合率(Context Precision)は、検索システムが取得してきたドキュメントの中に、質問に関連する情報がどれだけ高いランクで含まれているかを測る指標です。

検索結果の上位に正解となる情報が含まれているほど、スコアは高くなります。

RAGでは、LLMに入力できるトークン数(文字数)に限りがあるため、検索結果のすべてをLLMに渡せるわけではありません。

通常は検索スコアの高い上位数件(Top-K)を渡しますが、その中に無関係なノイズが多く混ざっていると、LLMが混乱し、誤った回答を生成する原因になります。

適合率が高いということは、検索システムが必要な情報をピンポイントで拾い上げ、ノイズを排除できていることを意味します。

リランキング(再順位付け)の精度を確認する際にも重要な指標となります。

【検索の評価】文脈の再現率(Context Recall)

文脈の再現率(Context Recall)は、回答を生成するために必要な情報が、検索されたドキュメントの中に「漏れなく」含まれているかを測る指標です。

適合率が「ノイズの少なさ」を見るのに対し、再現率は「情報の網羅性」を見ます。

例えば、質問に答えるために3つの事実が必要な場合、検索結果にそのうちの1つしか含まれていなければ、LLMは完全な回答を作ることができません。

この場合、再現率のスコアは低くなります。

再現率が低い場合は、検索キーワードの選定が悪いか、ドキュメントのチャンク分割(文章の区切り方)が不適切で、必要な情報がヒットしていない可能性があります。

特に複雑な質問や、複数のドキュメントを横断して推論が必要な質問において、非常に重要な指標となります。

その他の指標(毒性、応答速度、コストなど)

回答の正確さ以外にも、実運用においては無視できない指標がいくつか存在します。

これらはユーザー体験(UX)やビジネスの継続性に直結する要素です。

まず「毒性(Toxicity)」や「安全性」です。

差別的な発言、暴力的な表現、個人情報の漏洩などが含まれていないかをチェックします。

企業で利用するRAGにおいて、コンプライアンス違反となる回答は致命的です。

次に「応答速度(Latency)」です。

いくら精度が高くても、回答までに1分もかかるようではユーザーは離脱してしまいます。

検索にかかる時間と生成にかかる時間を計測し、許容範囲内に収める必要があります。

最後に「コスト」です。

高性能なLLMや複雑な検索ロジックを使えば精度は上がりますが、API利用料やサーバリソースがかさみます。

精度とコストのバランス(コスパ)を監視し、ROIが見合う運用を目指す必要があります。

RAGの精度を評価する主な2つのアプローチ

前述の指標を測定するために、大きく分けて2つの評価アプローチが存在します。

開発フェーズや目的に応じて、これらを使い分けるか、あるいは組み合わせることが推奨されます。

「システムのどの部分を改善したいのか」という目的意識を持ち、適切なアプローチを選択することで、効率的にRAGの品質を高めることができます。

ここでは、それぞれの特徴とメリットについて解説します。

検索と生成を個別に測る「コンポーネント評価」

コンポーネント評価は、RAGシステムを「検索器(Retriever)」と「生成器(Generator)」の2つに分解し、それぞれを独立して評価する手法です。

システム内部の挙動を詳細に分析できるため、デバッグやチューニングの段階で特に有効です。

検索器の評価では、特定のクエリに対して、期待するドキュメントが正しくヒットするかどうかを確認します。

ここでは、一般的な検索システムの評価指標であるHit RateやMRR(Mean Reciprocal Rank)などが用いられます。

生成器の評価では、正しいコンテキストを与えられた状態で、LLMが期待通りの回答を出力できるかを確認します。

このアプローチの最大のメリットは、問題の切り分けが容易な点です。

「回答が間違っている原因は、検索キーワードの設定ミスなのか、それともプロンプトの指示不足なのか」を特定しやすいため、具体的な改善アクションに直結します。

最終的な回答品質を測る「エンドツーエンド(E2E)評価」

エンドツーエンド評価は、ユーザーが入力した質問に対し、システムが出力した最終的な回答の品質を直接評価する手法です。

中間のプロセス(検索やプロンプト処理)はブラックボックスとして扱い、あくまでユーザー目線での「良し悪し」を判定します。

実際の利用シーンに最も近い形での評価となるため、リリース前の受け入れテストや、運用中のモニタリングに適しています。

ここでは、前述した「回答の関連性」や、ユーザーからのフィードバック(Good/Badボタンなど)が主要な指標となります。

E2E評価のメリットは、システム全体の総合力を測れる点です。

たとえ検索精度が多少低くても、LLMの推論能力でカバーできている場合など、トータルでの実用性を判断できます。

コンポーネント評価で個々の機能を磨き上げつつ、E2E評価で最終的なユーザー体験を保証するという両輪の体制が理想的です。

RAG評価を行うための具体的な手法

指標とアプローチが決まったら、次は「誰が」「どのように」採点を行うかという実行手段を決めなければなりません。

これまでは人間が一つひとつ確認するのが当たり前でしたが、LLMの進化により、評価プロセス自体も自動化が進んでいます。

コスト、速度、精度のバランスを考慮し、自社のプロジェクトに最適な手法を選択しましょう。

ここでは主要な3つの手法について解説します。

正確だがコストがかかる「人手による評価」

最も確実で、信頼性が高いのはやはり人間による評価です。

開発者やドメインエキスパート(業務知識を持つ専門家)が、実際の回答を目視で確認し、正誤判定やスコアリングを行います。

特に、ニュアンスが重要な質問や、高度な専門知識を要する分野、あるいは倫理的な判断が求められるケースでは、AIによる自動評価では見落としが発生する可能性があります。

このような「絶対に間違えられない」領域においては、人手によるチェックが依然として最終防衛ラインとなります。

しかし、この手法は時間とコストが膨大にかかるという欠点があります。

数千件のテストデータをすべて人間が見ることは現実的ではありません。

そのため、開発初期の小規模なテストや、自動評価の結果をサンプリングチェックする用途に限定して行われることが一般的です。

LLM自身に判定させる「自動評価(LLM-as-a-Judge)」

現在、RAG評価の主流となりつつあるのが、高性能なLLMを審査員役(Judge)として利用する「LLM-as-a-Judge」という手法です。

GPT-5などの高度な推論能力を持つモデルに、「質問」「コンテキスト」「回答」を与え、そこから忠実性や関連性をスコアリングさせます。

最新のモデルは、論理的思考能力が飛躍的に向上しているため、人間と比較しても遜色のない精度で評価を行えるようになってきました。

2025年8月にリリースされたGPT-5のようなモデルは、o1シリーズ等の「推論(Reasoning)」能力を統合しており、質問の難易度に応じて思考時間を調整するため、複雑なRAGの評価においても高い信頼性を発揮します。

この手法の最大のメリットは、高速かつ低コストに大量の評価を回せる点です。

プロンプトやパラメータを変更するたびに全件テストを行う回帰テスト(リグレッションテスト)も、自動評価であれば容易に実現できます。

LLMを評価者として用いる手法の妥当性については、MT-Benchなどを用いた研究で、人間の評価と高い一致率を示すことが検証されています。 https://arxiv.org/abs/2306.05685

評価用テストデータ(Golden Dataset)の効率的な作り方

評価を行うためには、模範解答となる「評価用データセット(Golden Dataset)」が必要です。

「質問」と「理想的な回答(Ground Truth)」のペアを数百件程度用意するのが理想ですが、これをゼロから作るのは大変な労力です。

効率的な作成方法として、ここでもLLMを活用することができます。

社内ドキュメントをLLMに読み込ませ、「このドキュメントに基づいて、ユーザーがしそうな質問と、その回答を作成してください」と指示することで、擬似的なQ&Aペアを大量に生成できます。

もちろん、生成されたデータにはノイズが含まれる可能性があるため、最終的には人間が目視でチェックし、修正を加える必要があります。

しかし、ゼロから考えるよりは遥かに効率的です。

また、実際の運用ログからユーザーの質問を抽出し、それをテストデータに加えていくことで、より実態に即したデータセットへと育てていくことができます。

Microsoftのデータサイエンスチームも、実運用に向けた「Golden Dataset」構築のプロセスにおいて、同様のアプローチの有効性を解説しています。 https://medium.com/data-science-at-microsoft/the-path-to-a-golden-dataset-or-how-to-evaluate-your-rag-045e23d1f13f

RAG評価・改善に役立つおすすめツール・フレームワーク

RAGの評価を一から実装するのは骨が折れますが、幸いなことに、現在は優れた評価用ライブラリやフレームワークが多数公開されています。

これらを活用することで、標準的な指標の計測をすぐに始めることができます。

それぞれのツールには強みや特徴があります。

開発環境や評価したいポイントに合わせて、最適なツールを選定しましょう。

Ragas(ラガス):RAG評価のデファクトスタンダード

Ragasは、RAG評価に特化したオープンソースのフレームワークであり、現在最も広く使われているツールの一つです。

前述した「忠実性」「関連性」「適合率」「再現率」などの主要な指標があらかじめ定義されており、数行のコードを書くだけで自動評価を実行できます。

Ragasの特徴は、LLM-as-a-Judgeの仕組みを標準採用している点です。

OpenAIのAPIなどをバックエンドに設定することで、各指標のスコアを自動算出します。

また、LangChainやLlamaIndexといった主要なRAG構築ライブラリとも親和性が高く、既存のシステムに組み込みやすいのも魅力です。

合成データの生成機能も備えており、ドキュメントから評価用データセットを作る作業もサポートしてくれます。

迷ったらまずはRagasを試してみるのが、現在の定石と言えるでしょう。

具体的な導入方法やコードの記述例については、公式ドキュメントを参照するとスムーズに実装を開始できます。 https://docs.ragas.io/en/stable/

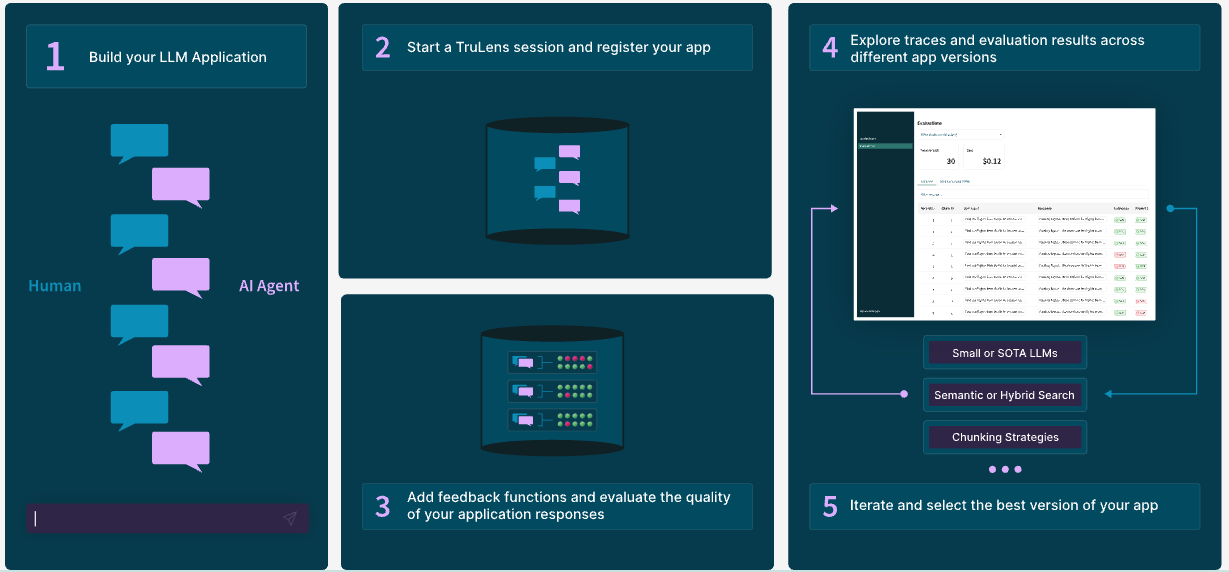

TruLens:実験管理と評価の可視化に強いツール

TruLensは、RAGアプリの実験管理と評価の可視化に重点を置いたツールです。

「Feedback Functions」と呼ばれる仕組みを使って評価基準を定義し、各実行ごとのスコアを記録します。

最大の特徴は、ダッシュボード機能(TruLens Eval)が充実していることです。

プロンプトやモデルの設定を変えた際、スコアがどのように変化したかをグラフで視覚的に比較できます。

これにより、パラメータ調整の効果測定が非常にやりやすくなります。

また、コストやトークン数の追跡機能もあり、精度だけでなく運用の経済合理性をチェックするのにも役立ちます。

試行錯誤を繰り返す開発フェーズにおいて、強力なパートナーとなるツールです。

実験管理の具体的な画面イメージや設定方法は、公式サイトで詳しく紹介されています。 https://www.trulens.org/

LangSmith:開発から評価・監視まで統合管理できるプラットフォーム

LangSmithは、LangChainの開発元が提供している統合プラットフォームです。

RAGの実行ログ(トレース)を詳細に記録し、どのステップでどのような入出力が行われたかを可視化できます。

評価機能も強力で、作成したデータセットに対して一括テストを実行し、その結果を管理画面上で確認できます。

エラーが発生した際のデバッグが容易であり、複雑なチェーン(処理の流れ)を持つRAGシステムの開発には特に適しています。

開発環境だけでなく、本番環境のモニタリングにも利用できるため、DevOps(開発と運用の連携)をスムーズにするための基盤として導入する企業が増えています。

DeepEval:単体テストのように使える評価フレームワーク

DeepEvalは、ソフトウェア開発における「単体テスト(Unit Test)」の感覚でRAGの評価を行えるフレームワークです。

Pytestなどのテストランナーと統合することができ、CI/CDパイプラインの中にRAGの評価を組み込むことが容易です。

「回答の中に〇〇という単語が含まれているか」「回答の文字数は適切か」といったシンプルなアサーションから、LLMを使った意味的な評価まで幅広く対応しています。

エンジニアにとって馴染み深いワークフローで品質管理を行える点が評価されています。

ARES:少ない教師データで高精度な評価を実現

ARES(Automated RAG Evaluation System)は、スタンフォード大学などの研究者によって提案された新しい評価システムです。

少ない評価データから、統計的な手法を用いて高精度な信頼区間を推定することに焦点を当てています。

通常、高精度な評価器を作るには大量のラベル付きデータが必要ですが、ARESは合成データと少数の人手評価データを組み合わせることで、効率的に評価モデルを構築します。

コストを抑えつつ、科学的に信頼性の高い評価を行いたい場合に注目すべき技術です。

ARESのアーキテクチャや統計的な信頼区間推定の仕組みについては、こちらの論文で詳細に解説されています。 https://arxiv.org/abs/2311.09476

評価結果が悪かった場合の精度改善チェックリスト

評価はあくまでスタート地点です。

スコアが悪かった場合、どこをどう直せばいいのか。

ここでは、評価結果に基づいた具体的な改善アクションを、検索と生成の2つの側面に分けて整理しました。

検索精度が低い場合(GraphRAG、ハイブリッド検索など)

「文脈の適合率」や「再現率」が低い場合、必要な情報がLLMに届いていません。

以下の対策を検討してください。

まず「チャンクサイズの調整」です。

文章を区切る単位が大きすぎるとノイズが混ざり、小さすぎると文脈が分断されます。

適切なサイズを見直しましょう。

次に「ハイブリッド検索」の導入です。

ベクトル検索(意味検索)だけでは、専門用語や型番などの完全一致検索に弱い場合があります。

従来のキーワード検索を組み合わせることで、取りこぼしを防げます。

また、「リランキング(再順位付け)」も有効です。

検索で広めに取得した候補(例えば50件)に対して、より高精度なモデルで順位を付け直し、上位(例えば5件)だけをLLMに渡すことで、適合率を劇的に改善できる場合があります。また、複雑な相関関係を含む質問には、ナレッジグラフを活用した「GraphRAG」の導入も2025年の主流な解決策です。

生成精度が低い場合(プロンプト改善、モデル変更など)

検索結果には正解が含まれているのに、「忠実性」や「関連性」が低い場合、LLMの処理に問題があります。

以下の対策を検討してください。

最も手軽で効果的なのは「プロンプトエンジニアリング」です。

「以下のコンテキストのみを使用して回答してください」「わからない場合は『わからない』と答えてください」といった制約を明確に指示することで、ハルシネーションを抑制できます。

それでも改善しない場合は、「モデルの変更」を視野に入れます。

GPT-5やo1シリーズ(推論モデル)のような、高度な思考プロセスを持つモデルに切り替えることで、複雑な指示を理解し、正確な回答を生成できるようになる可能性があります。

また、特定のドメイン知識が必要な場合は、ファインチューニングを検討することも一つの手ですが、まずはプロンプトとRAGの構成で改善できないか粘り強く検証することをおすすめします。

プロンプトエンジニアリングの基本や、業務で使える具体的なプロンプト例については、こちらの記事で詳しく解説しています。

RAGの評価に関してよくある質問

最後に、RAGの評価に取り組む際によくある疑問と、その回答をまとめました。

RAG評価は開発のどのフェーズから始めるべきですか?

結論から言うと、PoC(概念実証)の段階から始めるべきです。

多くのプロジェクトが、評価を後回しにした結果、本番直前になって「期待した精度が出ない」と慌てることになります。

初期段階で少数の「ゴールデンデータセット(理想的なQ&A集)」を作成し、ベースラインとなるスコアを把握しておくことで、その後の改善が順調に進んでいるか迷子にならずに済みます。

生成AIを企業で活用するための全体像や、導入におけるメリット・注意点について深く知りたい方は、こちらの記事もご参照ください。

日本語のRAG評価に特化したツールはありますか?

RagasやTruLensなどの主要ツールは、基本的に多言語対応しており、プロンプトを日本語で記述すれば問題なく動作します。

ただし、内部で評価に使用するLLMが日本語に強いかどうかは重要です。

評価用のモデル(Judgeモデル)には、日本語処理能力が高いGPT-4oやGPT-5などを指定することで、日本語のニュアンスを含んだ正確な評価が可能になります。

ツール自体が日本語特化である必要はなく、設定とモデル選びが鍵となります。

なお、日本語環境におけるRAGの評価に関しては、LINEヤフー株式会社などの研究チームが包括的な調査報告(サーベイ)を公開しており、国内の技術動向を把握する上で非常に参考になります。 https://arxiv.org/abs/2405.07437

あなたのRAGは「勘」で運用されていませんか?「使われないAI」と「進化するAI」の決定的違い

RAGシステムを導入したものの、社内での利用率が伸び悩んでいる。そんな悩みを抱えていませんか?実は、使われないRAGの共通点は、精度の評価をエンジニアや担当者の「感覚」に頼ってしまっていることにあります。評価基準が曖昧なままでは、ユーザーは一度でも誤った回答(ハルシネーション)に遭遇すると、「このAIは使えない」と判断し、二度と戻ってきません。一方で、成果を出し続ける組織は、AIの回答を数値化し、科学的に品質を管理しています。この記事では、感覚運用から脱却し、信頼されるAIを育てるための重要な視点を解説します。

【警告】「ユーザーからのフィードバック待ち」は最も危険な運用です

「変な回答があったら教えてください」というスタンスで運用していませんか?これは非常に危険なサインです。マッキンゼー等の調査・分析からも示唆されるように、ユーザーは不満があっても報告せず、黙って利用をやめる傾向があります。

クレームが来ないから順調だと思っていたら、実は誰も使っていなかった、という事態に陥りかねません。この状態が続くと、以下のリスクが発生します。

- システムのブラックボックス化: どこが悪いのか特定できず、改善の手立てがなくなる。

- 投資対効果の不明確化: 精度の向上が可視化できず、予算確保が難しくなる。

- AI不信の定着: 社員の中に「AIは嘘をつくもの」という認識が広まり、DX全体が停滞する。

便利なツールを入れるだけでなく、「正しく機能しているか」を監視する仕組みこそが、AI活用の成否を分けるのです。

【実践】AIの信頼性を高める「数値化」の習慣

では、「進化するAI」を持つ組織は何をしているのでしょうか?彼らは、記事中で解説されているような客観的な指標を用いて、定期健康診断のようにAIをチェックしています。

まず意識すべきは、AIの回答を「雰囲気」で見ないことです。「なんとなく良い」ではなく、「関連性スコアが0.8から0.9に向上した」といった定量的な会話をチーム内で定着させましょう。

また、完璧を目指さないことも重要です。最初から100点の回答を求めるのではなく、評価スコアをベンチマークとし、週次や月次で「前のバージョンより良くなっているか」を確認するサイクルを回すのです。この継続的な改善プロセス自体が、ユーザーへの信頼の証となります。

引用元:

RAGシステムの評価においては、検索と生成の質を個別に測定することの重要性が多くの研究で示されています。特に「RAGAS」のようなフレームワークの基礎となる研究では、人間の評価と高い相関を持つ自動評価指標の有効性が実証されており、効率的なパイプライン構築に不可欠とされています。(Es, S., James, J., et al. “RAGAS: Automated Evaluation of Retrieval Augmented Generation” 2023)

まとめ

RAGの精度向上には、多角的な評価指標の理解や、専門的な評価ツールの導入、そして継続的な改善サイクルが不可欠です。

しかし、現実には「評価環境を構築するエンジニアリソースがない」「どの指標を重視すべきか判断できない」といった課題により、実用レベルの精度まで引き上げられない企業も少なくありません。

そこでおすすめしたいのが、Taskhub です。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

RAGの構築においても、高度な技術検証を経たエンジンを採用しており、メール作成や議事録作成、社内ドキュメント検索など、業務に必要な機能を「アプリ」として選ぶだけで、誰でも高精度なAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、情報漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「精度の評価やチューニングの仕方がわからない」という企業でも、プロの知見を借りながら安心して運用をスタートできます。

複雑なプログラミングや評価指標の専門知識を習得しなくても、最初から最適化された状態で業務効率化が図れる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“迷わない生成AI活用”を体験し、御社のDXを一気に加速させましょう。