「Runway Gen-3 Alphaを使ってみたいけど、料金や使い方がよくわからない…」

「SoraやLumaなど、他の動画生成AIと比べて何が違うの?」

こういった疑問を持っている方もいるのではないでしょうか?

本記事では、Runwayの革新的なモデル「Gen-3 Alpha」の特徴から、具体的な料金プラン、他社ツールとの比較、そして思い通りの動画を生成するためのプロンプトのコツまでを徹底解説します。

上場企業をメインに生成AIコンサルティング事業を展開している弊社が、実際にプロの現場で活用されているノウハウを基に情報をまとめました。

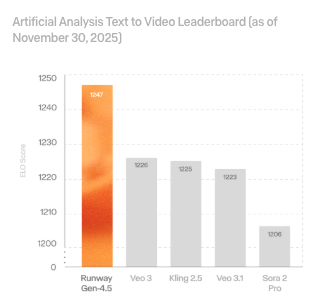

2025年12月にリリースされた最新モデル「Gen-4.5」の情報も踏まえつつ、Gen-3 Alphaの活用法を詳しく解説しますので、ぜひ最後までご覧ください。

こちらはRunway社が発表した最新フラッグシップモデル「Gen-4.5」の公式リリース情報です。 合わせてご覧ください。 https://runwayml.com/research/introducing-runway-gen-4.5

Runway Gen-3 Alpha(ジェンスリーアルファ)とは?

Runway Gen-3 Alpha(Runway Gen-3)は、映像制作AIのパイオニアであるRunway社が開発した、高精度な動画生成AIモデルです。

従来のモデルと比較して、映像のリアリティ、動きの自然さ、そしてユーザーの指示に対する忠実度が飛躍的に向上しています。

2025年現在、さらに新しい「Gen-4」シリーズや最上位の「Gen-4.5」も登場していますが、Gen-3 Alphaは品質と消費クレジットのバランスが良く、依然として多くのクリエイターに支持されるスタンダードなモデルとして位置づけられています。

ここでは、その特徴を詳しく見ていきましょう。

Gen-4シリーズにおけるキャラクターの一貫性やスタイル転送機能については、こちらで詳しく解説されています。 合わせてご覧ください。 https://runwayml.com/research/introducing-runway-gen-4

Gen-2から劇的に進化した動画生成AIの特徴

Gen-3 Alphaは、前世代のGen-2と比較して、以下の点で劇的な進化を遂げています。

- 圧倒的なフォトリアル品質: 実写と見分けがつかないほどの高精細な映像を生成可能です。肌の質感や光の反射などが大幅に改善されました。

- 時間的一貫性の向上: 動画の最初から最後まで、キャラクターの顔や服装、背景が崩れることなく維持されます。

- 複雑な動きの表現: 従来苦手としていた「走る」「食べる」といった複雑な動作も、破綻することなく滑らかに生成できます。

特に、プロンプト(指示文)への理解度が深まったことで、以前は何度も生成し直さなければならなかったシーンでも、一発で意図に近い映像が出力されるようになりました。

なぜ「世界シミュレータ(General World Models)」と呼ばれるのか

Runway Gen-3 Alphaは、単なる動画生成ツールではなく「General World Models(世界シミュレータ)」を目指して開発されています。

これは、AIが現実世界の物理法則や物体の相互作用を理解し、それを映像として再現することを意味します。

例えば、「ガラスのコップが床に落ちて割れる」というシーンを生成する場合、Gen-3 Alphaは単に割れた絵を描くのではなく、重力、衝突、破片の飛散といった物理現象をシミュレーションするように映像を構築します。

この「世界を理解する力」こそが、他の動画生成AIとは一線を画すGen-3 Alphaの最大の特徴です。

Gen-3 Alphaの技術アーキテクチャや物理シミュレーション能力については、こちらの公式研究発表も参照してください。 合わせてご覧ください。 https://runwayml.com/research/introducing-gen-3-alpha

Runway Gen-3 Alphaの料金プランと商用利用

Runway Gen-3 Alphaを利用するには、基本的にクレジットを消費するシステムになっています。

ここでは、気になる料金プランと、ビジネスで利用する場合のルールについて解説します。

無料で使える?クレジットシステムの仕組みと消費量

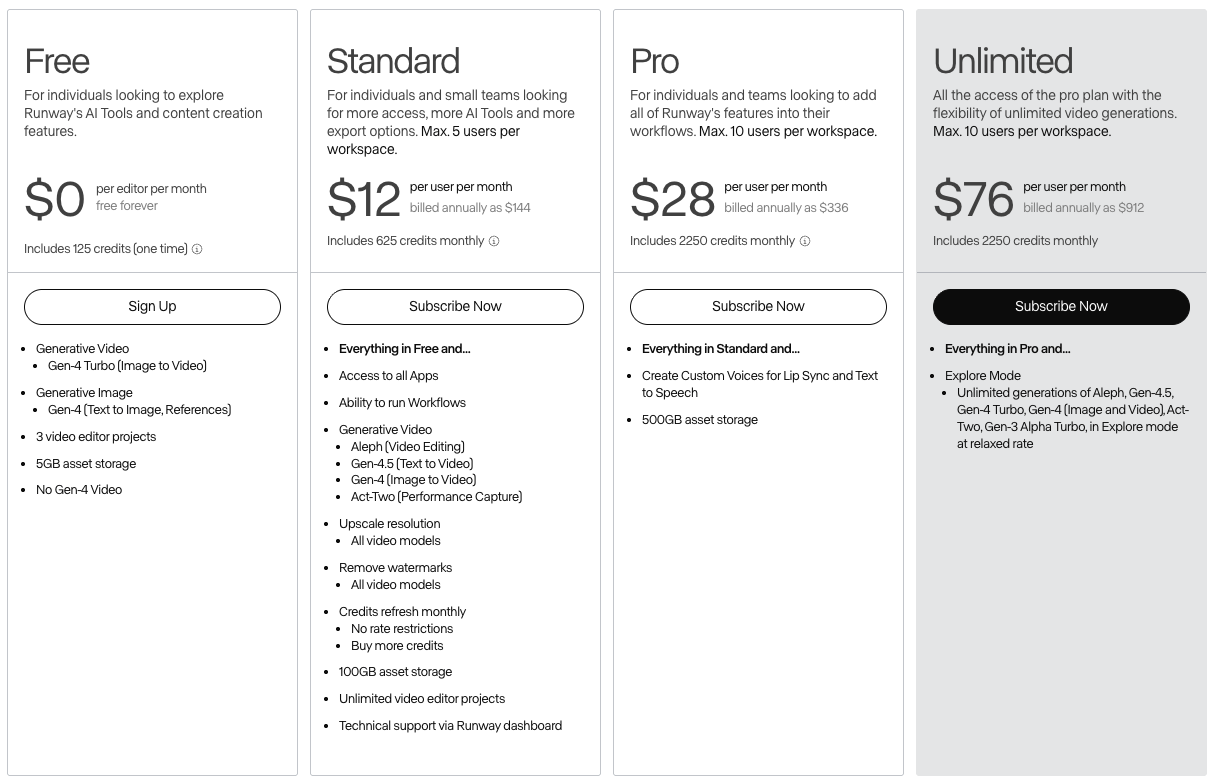

Runwayには無料プラン(Free Forever)が存在します。

アカウント作成時に125クレジットが付与されますが、これは1回限りの付与であり、毎月リセットされるわけではありません。

Gen-3 Alphaなどの高性能モデルは消費クレジットが多く、無料分のクレジットでは数回(数秒~十数秒程度)の生成で使い切ってしまいます。また、無料プランで生成した動画にはRunwayの透かし(ウォーターマーク)が入ります。

本格的に利用するには、有料プランへの加入が推奨されます。

Standard・Unlimitedプランの価格比較表

主な有料プランである「Standard」と「Unlimited」の比較は以下の通りです。

(※2025年12月時点の情報を基に作成)

| 特徴 | Standard Plan | Unlimited Plan |

| 月額料金 | $15/月 (年払いで$12/月) | $95/月 (年払いで$76/月) |

| 毎月のクレジット | 625クレジット | 2,250クレジット |

| 生成制限 | クレジット上限まで | 無制限 (Explore Mode利用時) |

| 透かし | なし | なし |

| 解像度アップスケール | 可能 | 可能 |

Standardプランは、個人のクリエイターや、月に数本の動画を作りたい方に最適です。

一方、Unlimitedプランには「Explore Mode」という機能があり、これを使うとクレジットを消費せずに(生成速度は少し落ちますが)無制限に動画を生成できます。試行錯誤を繰り返したい方にはUnlimitedが圧倒的におすすめです。

※最新のGen-4.5を利用する場合、消費クレジット数が異なる場合があるため、ダッシュボードで確認しましょう。

最新のクレジット単価やプランごとの詳細仕様は、公式サイトの料金ページで確認できます。 合わせてご覧ください。 https://runwayml.com/pricing

商用利用(商用ライセンス)のルールと注意点

Runwayの利用規約において、有料プラン(Standard以上)契約者が生成したコンテンツは、商用利用が可能です。

YouTubeの収益化動画、広告クリエイティブ、クライアントワークなどに問題なく使用できます。

ただし、無料プランで生成した動画については、商用利用権が含まれていない場合があるため注意が必要です。ビジネス目的で使用する場合は、必ずStandardプラン以上にアップグレードしましょう。

商用利用に関する権利帰属や許諾範囲についての正確な情報は、こちらの公式ヘルプセンターをご参照ください。 合わせてご覧ください。 https://help.runwayml.com/hc/en-us/articles/18927776141715-Usage-rights

Runway Gen-3 Alphaの始め方・使い方

ここからは、実際にRunway Gen-3 Alphaを使って動画を生成する手順を解説します。

操作は非常にシンプルで、ブラウザ上で完結します。

アカウント作成からログインまでの手順

- Runway公式サイトにアクセス: 「RunwayML」で検索し、公式サイトへ移動します。

- サインアップ: 右上の「Sign Up」または「Get Started」をクリックします。

- アカウント連携: Googleアカウント、Apple ID、またはメールアドレスで登録を行います。

- プラン選択: 最初は「Free」プランで開始し、必要に応じてダッシュボードからアップグレードします。

これで準備は完了です。

Text to Video(文字から動画生成)の操作画面と手順

言葉だけで動画を作る「Text to Video」の手順は以下の通りです。

- ダッシュボード左側のメニューから「Generative Video」を選択し、「Gen-3 Alpha」をクリックします。

- 画面下部のテキストボックスに、作りたい映像の内容(プロンプト)を英語で入力します。

- 必要に応じて設定(シード値固定や解像度など)を調整します。

- 「Generate」ボタンをクリックします。

数十秒から1分程度待つと、AIが動画を生成してくれます。

Image to Video(画像から動画生成)の操作画面と手順

手持ちの画像を動かしたい場合は「Image to Video」を使用します。

- Text to Videoと同じ画面で、「Image」タブを選択するか、画像をドラッグ&ドロップでアップロードします。

- アップロードした画像が「First Frame(最初のフレーム)」として設定されます。

- テキストプロンプト欄に、その画像をどう動かしたいか(例:波を動かす、人物を振り返らせる等)を入力します。

- 「Generate」をクリックします。

画像を指定することで、キャラクターの容姿や背景の雰囲気を固定したまま動画化できるため、一貫性のある映像作品を作るのに最適です。

生成した動画の保存・ダウンロード方法

生成された動画は、Runway上の「Assets」フォルダに自動保存されます。

ダウンロードするには、動画のプレビュー画面を開き、右上にあるダウンロードアイコン(矢印マーク)をクリックするだけです。MP4形式でパソコンに保存されます。

思い通りの動画を作る!Gen-3 Alphaのプロンプトのコツ

Gen-3 Alphaの性能を最大限に引き出すには、プロンプトの書き方が重要です。

ここでは、プロが実践している具体的な指示出しのテクニックを紹介します。

物理挙動の記述やネガティブプロンプトの仕様など、公式のプロンプトガイドも非常に参考になります。 合わせてご覧ください。 https://help.runwayml.com/hc/en-us/articles/30586818553107-Gen-3-Alpha-Prompting-Guide

【コピペOK】動画生成プロンプトの基本構成テンプレート

良いプロンプトは、要素が構造化されています。以下のテンプレートを参考にしてみてください。

[カメラワーク] + [被写体の説明] + [アクション/動き] + [環境/背景] + [ライティング/スタイル]

具体例:

“Low angle zoom in shot of a cybernetic samurai drawing a glowing katana, standing in a rainy neon-lit Tokyo street at night, cinematic lighting, hyper-realistic, 4k.”

(ローアングルでズームイン、光る刀を抜くサイバー侍、雨の降る夜のネオン街の東京、映画のような照明、超写実的、4k)

このように、「カメラの動き」を冒頭に持ってくると、AIが構図を理解しやすくなります。

カメラワーク(Zoom/Pan)を制御する具体的な指示

Gen-3 Alphaはカメラワークの指示に敏感ですが、現在は編集画面の「Camera Control」機能で設定するのも有効です。プロンプトで指定する場合は、以下の単語を使い分けましょう。

- Zoom in / Zoom out: 被写体に寄る、引く。

- Pan left / Pan right: カメラを左右に振る。

- Tilt up / Tilt down: カメラを見上げる、見下ろす。

- Tracking shot: 被写体を追いかけて移動する。

- Drone shot / Aerial view: 空撮のような視点。

- FPV (First Person View): 一人称視点。疾走感を出すのに有効です。

特に「Slow pan」や「Rapid zoom」のように速度を表す形容詞を加えると、より意図通りの演出が可能になります。

数値設定による精密なカメラワーク制御の方法については、こちらの記事で詳しく解説されています。 合わせてご覧ください。 https://help.runwayml.com/hc/en-us/articles/34926468947347-Creating-with-Camera-Control-on-Gen-3-Alpha-Turbo

物理挙動やライティングを指定してリアリティを高める方法

映像のクオリティを一段階上げるには、光と物理現象を指定します。

- ライティング:

Golden hour(夕暮れ)、Cinematic lighting(映画風)、Volumetric lighting(光の筋が見える表現)、Soft studio lighting(柔らかい照明)。 - 物理挙動:

Fluid motion(流体のような動き)、Hair blowing in the wind(風になびく髪)、Water reflection(水面の反射)。

これらを組み合わせることで、AI特有ののっぺりした映像を防ぎ、リッチな質感を与えることができます。

Runway Gen-3 Alphaと他社動画生成AIの比較

動画生成AI界隈は群雄割拠です。ここでは競合となる主要サービスとGen-3 Alphaを比較します。

OpenAI「Sora」との違いと現状の優位性

OpenAIの「Sora」は圧倒的な品質で話題になりましたが、2025年時点でも一般公開の範囲や利用コストに制限がある場合があります。

- Sora: 物理シミュレーション能力は最強クラスだが、アクセス権が必要な場合が多い。

- Runway Gen-3 Alpha: 誰でもすぐに登録して利用可能。商用利用のフローも確立されている。

「今すぐビジネスで使える」という点において、Runwayには大きな優位性があります。

OpenAIが開発した大規模言語モデル(LLM)であるChatGPTと、その競合であるClaude 3の機能比較はこちらの記事で解説しています。 合わせてご覧ください。

Luma AI「Dream Machine」との画質・生成速度の比較

Luma AIの「Dream Machine」は、生成速度の速さと無料枠の使いやすさで人気です。

- Dream Machine: 生成スピードが非常に速い。動きがダイナミック。

- Runway Gen-3 Alpha: 生成時間はやや長めだが、画質の密度や細かいコントロール機能(カメラワーク設定など)で勝る。

質より量を重視するならLuma、クオリティとコントロールを重視するならRunwayという使い分けが一般的です。

Kling AIとの比較

中国発の「Kling AI」は、動画の尺の長さ(最大2分など)や、人間の大きな動きの再現性に定評があります。

- Kling AI: 長尺動画や、人物の激しいアクションに強い。

- Runway Gen-3 Alpha: 映像美、テクスチャの質感、アーティスティックな表現に強い。

Runwayは、MV(ミュージックビデオ)やCMのような「映像美」を求めるシーンで選ばれる傾向があります。

Runway Gen-3 Alphaに関するよくある質問(FAQ)

最後に、Runway Gen-3 Alphaを使い始める際によくある質問をまとめました。

日本語のプロンプトでも生成できる?

日本語のプロンプトを入力しても生成自体は可能ですが、精度が著しく低下する可能性があります。

Runwayは英語のデータセットを中心に学習しているため、英語でプロンプトを入力することを強く推奨します。

DeepLやChatGPTを使って、日本語の指示を英語に翻訳してから入力するのが最も確実な方法です。

ChatGPTを日本語で使う際の注意点や、精度を上げるためのコツを詳しく解説しています。 合わせてご覧ください。

スマホアプリ版でGen-3 Alphaは使える?

はい、RunwayにはiOS版のモバイルアプリがあり、スマホからも動画生成が可能です。

(※Android版の状況は公式サイトをご確認ください)

ただし、PC版のブラウザに比べて一部の細かい設定機能が制限される場合があるため、本格的な制作にはPC版の使用をおすすめします。

生成にどれくらいの時間がかかる?

サーバーの混雑状況やプランにもよりますが、5秒~10秒の動画を生成するのに、概ね45秒~90秒程度かかります。

Unlimitedプランの「Explore Mode(低速モード)」を使用している場合は、さらに時間がかかることがありますが、バックグラウンドで処理が進むため、別の作業をしながら待つことができます。

【警告】思考停止でGen-3 Alphaを使うと「量産型クリエイター」に陥る

Runway Gen-3 Alphaのような高性能な動画生成AIが登場したことで、誰もがハイクオリティな映像を作れる時代が到来しました。しかし、これはクリエイターにとって諸刃の剣です。「AIに任せればいい」と安易に考えていると、あなたの制作物はその他大勢の「AI量産品」と見分けがつかなくなり、クリエイターとしての価値を失ってしまうリスクがあります。

特に危険なのは、AIが出力した映像をそのまま採用し、なぜその映像が良いのか、あるいは悪いのかを言語化できない状態です。この「思考の外部委託」が進むと、次のような弊害が生まれます。

- 演出意図が消える:AIのランダム性に依存し、作品に必然性がなくなる。

- 修正能力が育たない:プロンプトと結果の因果関係を理解していないため、クライアントの要望に応じた微調整ができない。

- 観察眼が鈍る:物理現象や光の動きをAI任せにすることで、現実世界の美しさを捉える力が弱まる。

便利なツールに依存しすぎると、本来クリエイターが持つべき「世界を切り取る感性」が退化してしまう可能性があるのです。

引用元:

Runway社は、Gen-3 Alphaを単なる映像生成ツールではなく、現実世界の物理法則や物体の相互作用をシミュレーションする「General World Models(世界シミュレータ)」として開発しています。この技術は、ユーザーが物理的な世界をより深く理解し、表現するための基盤となることを目指しています。(Runway Research, “General World Models: The Next Step in AI Video Generation”, 2024)

【実践】AIを「撮影現場」として指揮するプロの思考法

では、生き残るクリエイターはGen-3 Alphaをどう捉えているのでしょうか?彼らはAIを「自動販売機」ではなく、「忠実な撮影スタッフ」や「バーチャルなロケ地」として扱っています。

Gen-3 Alphaは、カメラワーク、ライティング、物理挙動に関する専門用語を高度に理解します。つまり、プロの現場で通用する使い方は、AIに対して監督として的確なディレクションを行うことです。

例えば、単に「侍が戦っている動画」と頼むのではなく、「ローアングルからパンアップで、雨に濡れた路面の反射を強調しつつ、逆光(バックライト)で侍のシルエットを浮かび上がらせる」といったように、映像の構成要素を分解して指示を出します。

このように、AIが持つ「物理シミュレーション能力」を、自身の「演出力」で制御することこそが、プロフェッショナルなAI活用の鍵となります。AIはあくまでエンジンであり、ハンドルを握るのはあなた自身の言語化能力と想像力なのです。

まとめ

企業はDX推進やクリエイティブの質的向上を求められる中で、動画生成AIのような最先端技術の活用が急務となっています。

しかし、実際には「Runwayのような海外ツールは英語や支払いのハードルが高い」「どのAIツールが自社に最適かわからない」といった理由で、導入に二の足を踏む企業も少なくありません。

そこでおすすめしたいのが、Taskhubです。

Taskhubは日本初のアプリ型インターフェースを採用し、200種類以上の実用的なAIタスクをパッケージ化した生成AI活用プラットフォームです。

動画生成や画像生成といったクリエイティブな業務はもちろん、メール作成、議事録作成、データ分析など、あらゆる業務を「アプリ」として選ぶだけで、誰でも直感的にAIを活用できます。

しかも、Azure OpenAI Serviceを基盤にしているため、データセキュリティが万全で、企業情報の漏えいの心配もありません。

さらに、AIコンサルタントによる手厚い導入サポートがあるため、「最新のAIツールを使いこなせるか不安」という企業でも安心してスタートできます。

導入後すぐに業務効率化とクリエイティブの質の向上を実感できる設計なので、複雑なプロンプト学習や英語の壁に悩まされることなく、すぐに成果を出せる点が大きな魅力です。

まずは、Taskhubの活用事例や機能を詳しくまとめた【サービス概要資料】を無料でダウンロードしてください。

Taskhubで“安心・簡単な生成AI活用”を体験し、御社のビジネスを次世代へと加速させましょう。